Resolver un sudoku en el trayecto del metro o en una pausa para el café puede parecer un pasatiempo trivial, pero para la inteligencia artificial es mucho más que un simple juego. Un grupo de investigadores ha recurrido a este rompecabezas numérico no solo para medir la habilidad lógica de los modelos de lenguaje más avanzados, sino para poner a prueba algo mucho más importante: su capacidad para explicar lo que hacen y por qué lo hacen.

En un estudio reciente, un equipo de científicos de la Universidad de Colorado Boulder utilizó más de 2.000 sudokus para evaluar a distintos sistemas de inteligencia artificial. Lo que encontraron fue sorprendente: algunos modelos eran capaces de completar correctamente el puzzle, pero casi ninguno podía explicar con claridad los pasos que había seguido para llegar a la solución. Esta diferencia entre hacer y explicar plantea una cuestión crítica en el desarrollo de herramientas confiables basadas en IA, sobre todo cuando estas se destinan a tareas sensibles como diagnósticos médicos, asesoría financiera o toma de decisiones legales.

Sudokus para estudiar la lógica de las máquinas

Los sudokus elegidos para este experimento no eran los clásicos de nueve por nueve casillas, sino una versión más sencilla de seis por seis. Esta variante permite mantener cierta complejidad lógica sin exigir habilidades matemáticas avanzadas. Según el paper original, “Sudoku proporciona un entorno controlado para estudiar las capacidades de los modelos de lenguaje en la resolución de problemas por pasos”, una afirmación que resalta la utilidad de estos juegos como banco de pruebas.

Los investigadores diseñaron un conjunto de 2.293 sudokus de dificultad variable, asegurando que cada uno tuviera una solución única y bien definida. La generación de estos rompecabezas se realizó con un sistema lógico formal conocido como Z3, que garantizaba que cada puzzle fuera resoluble y que no admitiera múltiples respuestas válidas.

Este diseño cuidadoso permite aislar los errores de la IA sin ambigüedades. Si el modelo se equivoca, se sabe con certeza que no hay más de una solución ni margen para interpretaciones. Así, se obtiene una medición clara de qué tan bien el sistema comprende las reglas del juego.

Lo hacen… pero no saben explicar cómo

De todos los modelos evaluados, solo el modelo "o1-preview" de OpenAI —una versión avanzada lanzada en 2023— fue capaz de resolver correctamente alrededor del 65 % de los sudokus. En contraste, los modelos de código abierto como Llama o Mistral apenas alcanzaron cifras simbólicas, muy por debajo del 1 % de éxito completo. Pero incluso el modelo más preciso falló rotundamente al intentar justificar sus respuestas.

Cuando se le pidió que explicara sus soluciones, el rendimiento de la IA se desplomó. Solo un 5 % de las explicaciones proporcionadas por o1-preview fueron valoradas como justificadas por evaluadores humanos. En términos de claridad, apenas un 7,5 % recibió una valoración positiva, y la capacidad educativa de las respuestas fue aún peor: solo un 2,5 % fue considerada útil para aprender estrategias de resolución.

Los autores del estudio lo resumen con una frase clara: “si bien estas herramientas muestran potencial […] todavía enfrentan desafíos importantes a la hora de exponer los pasos de razonamiento de manera fiel y comprensible”. Esta brecha entre resultado y razonamiento revela una de las principales limitaciones actuales de los modelos de lenguaje: pueden imitar soluciones correctas, pero no saben contar cómo llegaron a ellas.

La diferencia entre acertar y razonar

Uno de los aspectos más interesantes de este estudio es que no se centró exclusivamente en si las IAs aciertan, sino en su capacidad para desarrollar una narrativa coherente de su proceso. El objetivo no era solo ver si podían poner el número correcto en una casilla, sino entender por qué eligieron ese número, con base en qué deducciones y reglas.

Esta exigencia pone de manifiesto la diferencia entre un resultado correcto por azar o imitación, y un proceso de pensamiento lógico. En palabras del artículo científico: “los buenos razonadores deberían poder exponer claramente sus procesos deductivos”. Y eso es precisamente lo que falta.

Una IA que propone una solución válida pero no puede explicarla no es confiable en contextos críticos. En ámbitos como la salud, el derecho o la contabilidad, no basta con que una máquina dé una respuesta correcta. Es necesario que pueda justificarse ante humanos, idealmente de forma clara, consistente y comprensible.

Un experimento riguroso y revelador

El equipo evaluador no se quedó en observaciones subjetivas. Recurrieron a un panel de expertos humanos que analizaron las respuestas de la IA en tres dimensiones: justificación, claridad y valor educativo. Para esto, se aplicó un sistema tipo Likert (Sí, Tal vez, No) en 20 sudokus seleccionados de distintos niveles de dificultad.

El análisis de concordancia entre evaluadores fue razonablemente bueno, con un valor de Kappa de 0,6 en justificación y valor educativo, y 0,4 en claridad. Esto confirma que las deficiencias observadas no eran anecdóticas, sino sistemáticas. La IA más avanzada lograba resolver rompecabezas complejos, pero sus explicaciones no pasaban el filtro humano, y en muchos casos eran confusas, incorrectas o directamente absurdas.

De hecho, según se detalla en los artículos de prensa que comentan el estudio, hubo respuestas en las que la IA mezclaba conceptos, afirmaba reglas que no existían o incluso respondía con partes de una predicción meteorológicacuando no sabía qué decir. Estos desvíos demuestran que, en ausencia de una lógica clara, los modelos pueden rellenar vacíos con cualquier tipo de contenido coherente en apariencia, pero sin relación con la tarea original.

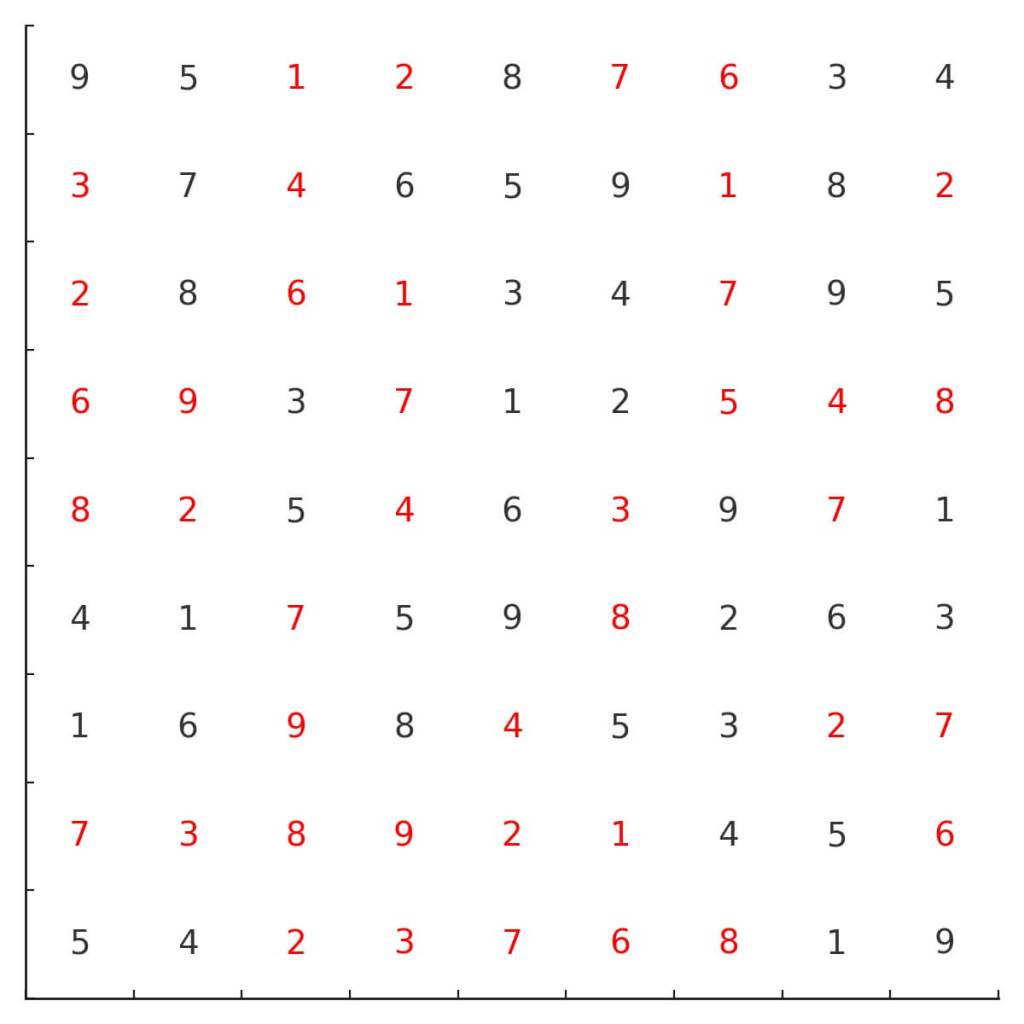

Tampoco sabe generarlos...

Lo cierto es que si le pides un sudoku con soluciones incluidas, te da algo que... bueno, puedes verlo tú mismo...

De los sudokus a decisiones que importan

Aunque pueda parecer anecdótico, el estudio no trata solo de juegos. Según los autores, la resolución de sudokus funciona como una representación a pequeña escala de problemas complejos en la vida real. Requiere reglas claras, razonamiento paso a paso y toma de decisiones informadas. Lo mismo que se espera de una IA que, por ejemplo, gestione impuestos, analice historiales médicos o emita recomendaciones legales.

El hecho de que los modelos aún fallen en explicar con claridad cómo llegan a sus respuestas plantea dudas sobre su papel en tareas más sensibles. De ahí el interés creciente en sistemas llamados “neurosimbólicos”, que combinan el lenguaje natural de los LLM con estructuras lógicas formales.

Estos enfoques híbridos podrían, según el estudio, aprovechar lo mejor de ambos mundos: la capacidad de generar respuestas comprensibles y el rigor formal de los sistemas lógicos tradicionales. Como explican los autores, “esperamos que los modelos puedan interpretar esas explicaciones de forma accesible para el usuario no especializado y con niveles de detalle adecuados”.

¿Y ahora qué?

La investigación deja claro que los modelos actuales tienen aún mucho camino por recorrer en materia de razonamiento estructurado. Aunque el desempeño de los sistemas propietarios como o1-preview es superior al de los modelos abiertos, ninguno alcanza el nivel de fiabilidad explicativa que se requeriría en aplicaciones de alto impacto.

Para avanzar en esta línea, los autores proponen integrar los modelos de lenguaje con herramientas formales como los SMT solvers o asistentes de prueba matemática. Estas herramientas ya permiten razonamientos extremadamente precisos, aunque poco amigables para el lector común. Si los modelos actuales logran hacer de puente entre esa lógica compleja y el lenguaje natural, podrían convertirse en verdaderas herramientas colaborativas para la toma de decisiones humanas.

Mientras tanto, lo aprendido con los sudokus ofrece una valiosa advertencia: una respuesta correcta no es suficiente si no viene acompañada de una buena explicación. Y en ese punto, la inteligencia artificial aún tiene mucho por mejorar.

Referencias

- Anirudh Maiya, Razan Alghamdi, Maria Leonor Pacheco, Ashutosh Trivedi, Fabio Somenzi. Explaining Puzzle Solutions in Natural Language: An Exploratory Study on 6×6 Sudoku. Findings of the Association for Computational Linguistics. 2025. https://doi.org/10.18653/v1/2025.findings-acl.273.