Imagina la siguiente situación. Te encuentras en un restaurante moderno. Un local donde el servicio lo realiza un robot que se encarga de llevar la comida hasta tu mesa. Al principio todo funciona perfectamente, pero la cena se complica cuando el plato principal se retrasa demasiado. Después de consultar lo ocurrido con un empleado humano, descubres que el robot está quieto en la cocina con tu plato ya frío. ¿Qué ha ocurrido? Existen muchas posibles respuestas a esta pregunta: tal vez el robot se quedó sin batería, tal vez un cocinero se puso en su camino y no le dejó pasar, o quizás la puerta de la cocina se cerró sola. Sin embargo, encontrar la respuesta adecuada no es una tarea trivial debido a la complejidad subyacente al comportamiento del propio robot.

La Inteligencia Artificial eXplicable (XAI) y los Robots Autónomos eXplicables (XAR) son dos ramas de la explicabilidad que tratan de poner fin a esta problemática. Tanto XAI como XAR buscan hacer entendibles las decisiones tomadas por sistemas autónomos. Y es que no es suficiente con que un robot funcione, sino que resulta fundamental saber cómo lo hace. Esta necesidad adquiere todavía mayor relevancia cuando el robot opera en entornos críticos (robótica industrial, conducción autónoma, medicina…) y en entornos de Interacción Humano-Robot (HRI), en los cuales el humano y el robot interactúan de forma constante.

¿Qué es una explicación?

La explicabilidad se enfrenta, en primer lugar, a un concepto abstracto: la explicación. ¿Qué significa explicar algo? El ser humano no necesita plantearse esta pregunta porque las explicaciones son parte de su comportamiento y del razonamiento. Sin embargo, trasladar este concepto a una máquina autónoma exige un análisis más detallado de su significado. A lo largo de la literatura se han propuesto diferentes definiciones para el concepto de explicación. El eje central de todas estas definiciones es la entendibilidad, ya que una explicación necesita imperativamente ser entendible por el receptor de la misma, es decir, debe mejorar su comprensión. Se puede concluir también que el proceso de explicación consiste en una comunicación entre el emisor de la explicación y el receptor de la misma y que, por lo tanto, la explicación en sí se corresponde con la información intercambiada durante dicha comunicación.

Aplicando este análisis al ámbito de los robots autónomos, se podría definir una explicación como “información proporcionada al usuario y entendible por el mismo que mejora la comprensión acerca del comportamiento del sistema”. La siguiente pregunta que puede surgir es sobre qué información se intercambia durante la comunicación. Una explicación puede adoptar diferentes formas: puede ser una imagen o una gráfica, puede ser lenguaje verbal (ya sea escrito o hablado) o incluso puede consistir en valores numéricos como, por ejemplo, probabilidades de éxito. Tanto el formato en el que se proporciona la explicación como la complejidad de la misma dependen del usuario final que recibirá la explicación.

El problema del usuario objetivo

Tal y como se ha dicho anteriormente, el objetivo principal de la explicabilidad es la comprensión acerca del comportamiento del sistema. Sin embargo, esta característica está estrechamente ligada al usuario receptor de la explicación. De esta forma, para que la explicabilidad cumpla su propósito, es fundamental que el usuario objetivo de la explicación sea capaz de entenderla. Una misma explicación puede ser entendida por un usuario experto en robótica, y a la vez resultar incomprensible para un anciano o un niño. Por esta razón, la explicación debe adaptar su formato y su complejidad al perfil del usuario que va a recibirla, es lo que se conoce como nivel de detalle o granularidad de la explicación.

Una de las propuestas más populares para enfrentar esta problemática consiste en dividir a los posibles usuarios objetivo en diferentes grupos según su nivel de conocimiento. Una vez realizada esta categorización, la explicación es adaptada al grupo de conocimiento correspondiente. Sin embargo, la granularidad representa uno de los retos más complejos de la explicabilidad y resulta necesario tener en cuenta algunas consideraciones. En primer lugar, se ha demostrado que usuarios de un mismo grupo pueden demandar explicaciones con granularidad distinta. En segundo lugar, la granularidad requerida puede cambiar para un mismo usuario en función del tiempo de exposición de dicho usuario al sistema, es decir, el usuario puede usar el sistema con frecuencia y aumentar su conocimiento del mismo (reduciendo la granularidad de la explicación) o reducir la frecuencia de uso (aumentando la granularidad necesaria).

¿Cómo se genera una explicación?

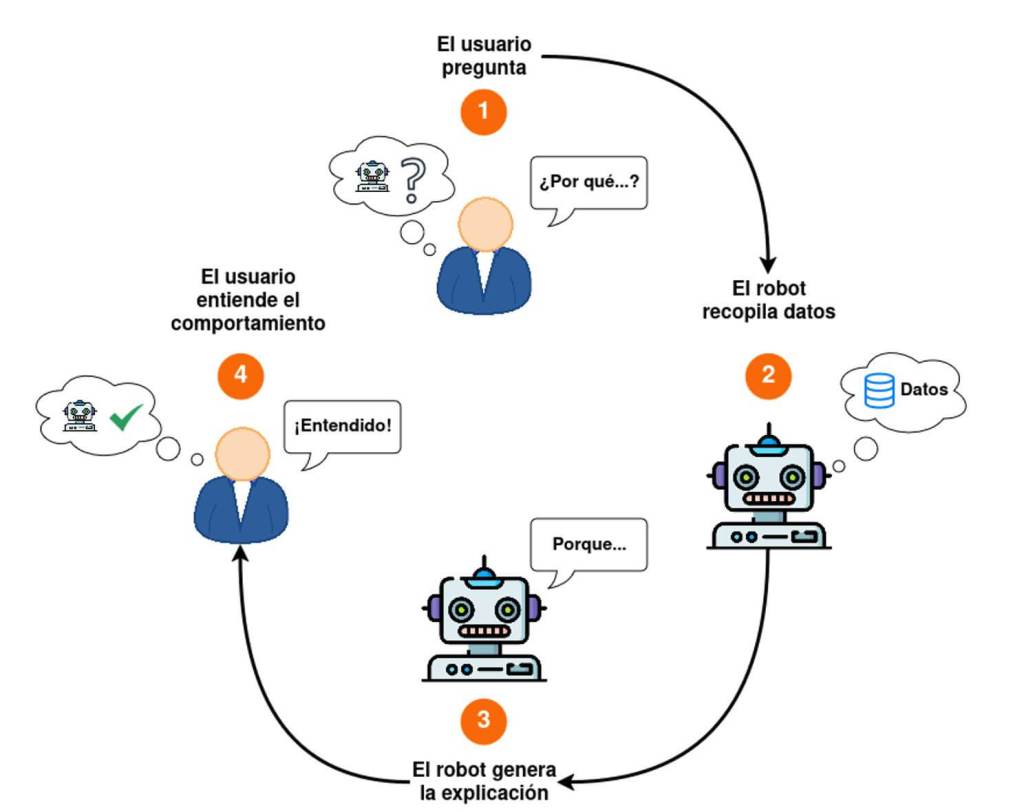

El proceso de generar una explicación puede dividirse en tres etapas. La primera de ellas consiste en la recolección de los datos más relevantes para generar la explicación. La segunda etapa se basa en la interpretación de estos datos y la inferencia de la información adicional que sea necesaria. Por último, es necesaria la comunicación de la explicación obtenida al usuario objetivo.

Existen diferentes métodos para interpretar los datos e inferir la información que compondrá la explicación: métodos basados en el cálculo de probabilidades, en el análisis del conocimiento a través de ontologías, en la generación de mapas de calor o en el análisis de datos internos del sistema, entre otros. Este último tipo de métodos se presenta como una opción prometedora para la explicabilidad de robots autónomos. Este tipo de sistemas está compuesto por sensores y actuadores que permiten captar el entorno y reaccionar en consecuencia. Dichos componentes, al igual que los múltiples subsistemas software que integra el robot, generan datos y guardan esos datos en registros o logs. El análisis de los registros del robot ha obtenido resultados prometedores a la hora de generar explicaciones para esclarecer el comportamiento del sistema.

Una posible aproximación es la integración de modelos de lenguaje grande (LLM) dentro del proceso de explicación. Los LLMs proporcionan capacidades de interpretación e inferencia, además de ser capaces de generar texto en lenguaje natural, lo cual se adapta a la perfección a los requisitos que se buscan en un sistema de generación de explicaciones.

Por otro lado, existe una clara tendencia a la hora de llevar a cabo la comunicación de la explicación generada, la cual consiste en un intercambio de pregunta-respuesta entre el usuario objetivo y el sistema autónomo explicable. En esta aproximación, el usuario plantea una pregunta y el sistema genera una explicación para contestar a la pregunta recibida, proporcionando así la explicación a modo de respuesta.

Beneficios de la explicabilidad: confianza y seguridad

La explicabilidad se está convirtiendo en una necesidad para la robótica autónoma. En entornos HRI favorece el desarrollo de confianza entre el humano y el robot, lo cual es fundamental para el correcto desarrollo de la operación. Para un usuario humano resulta muy difícil confiar en un sistema cuyas decisiones no puede entender, por lo que ofrecer explicaciones claras se convierte en un requisito crucial. Además, la explicabilidad es una herramienta valiosa para detectar y mitigar sesgos, en especial en modelos de inteligencia artificial dedicados a la clasificación e identificación de objetos.

La explicabilidad también guarda una notable relación con la ciberseguridad, ya que permite la trazabilidad y comprensión de los eventos que han desencadenado la ejecución de un comportamiento concreto. Esta característica resulta de especial interés a la hora de realizar un análisis de lo ocurrido tras un accidente o un ciberataque. Conviene recordar que un fallo de funcionamiento o un ataque dirigido a un robot que interactúa con humanos no solo puede ocasionar pérdidas materiales, sino que también puede implicar riesgos directos para la seguridad de las personas.

Referencias

- D. Sobrín-Hidalgo, Higueras, Á. Manuel Guerrero-Higueras, F. Javier Rodríguez-Lera & V. Matellán-Olivera. (2025). Definiendo el concepto de explicación: propuesta de una taxonomía para explicabilidad en robótica. En Actas de las X Jornadas Nacionales de Investigación en Ciberseguridad (pp. 50-57). Universidad de Zaragoza.

- D. Sobrín-Hidalgo, Á. Manuel Guerrero-Higueras and V. Matellán-Olivera, Generating Explanations for Autonomous Robots: A Systematic Review, in IEEE Access, vol. 13, pp. 20413-20426, 2025, doi: 10.1109/ACCESS.2025.3535097

- D. Sobrín-Hidalgo, M. Ángel González-Santamarta, Á. Manuel Guerrero-Higueras, F. Javier Rodríguez-Lera, & V. Matellán-Olivera. (2024). Explaining autonomy: Enhancing human-robot interaction through explanation generation with large language models. arXiv preprint arXiv:2402.04206.

David Sobrín Hidalgo

Doctor en Informática

Miguel Ángel González Santamarta

Doctor en Informática

Francisco Javier Rodriguez Lera

Doctor en Informática

Ángel Manuel Guerrero Higueras

Doctor en Informática

Vicente Matellán Olivera

Doctor en Informática