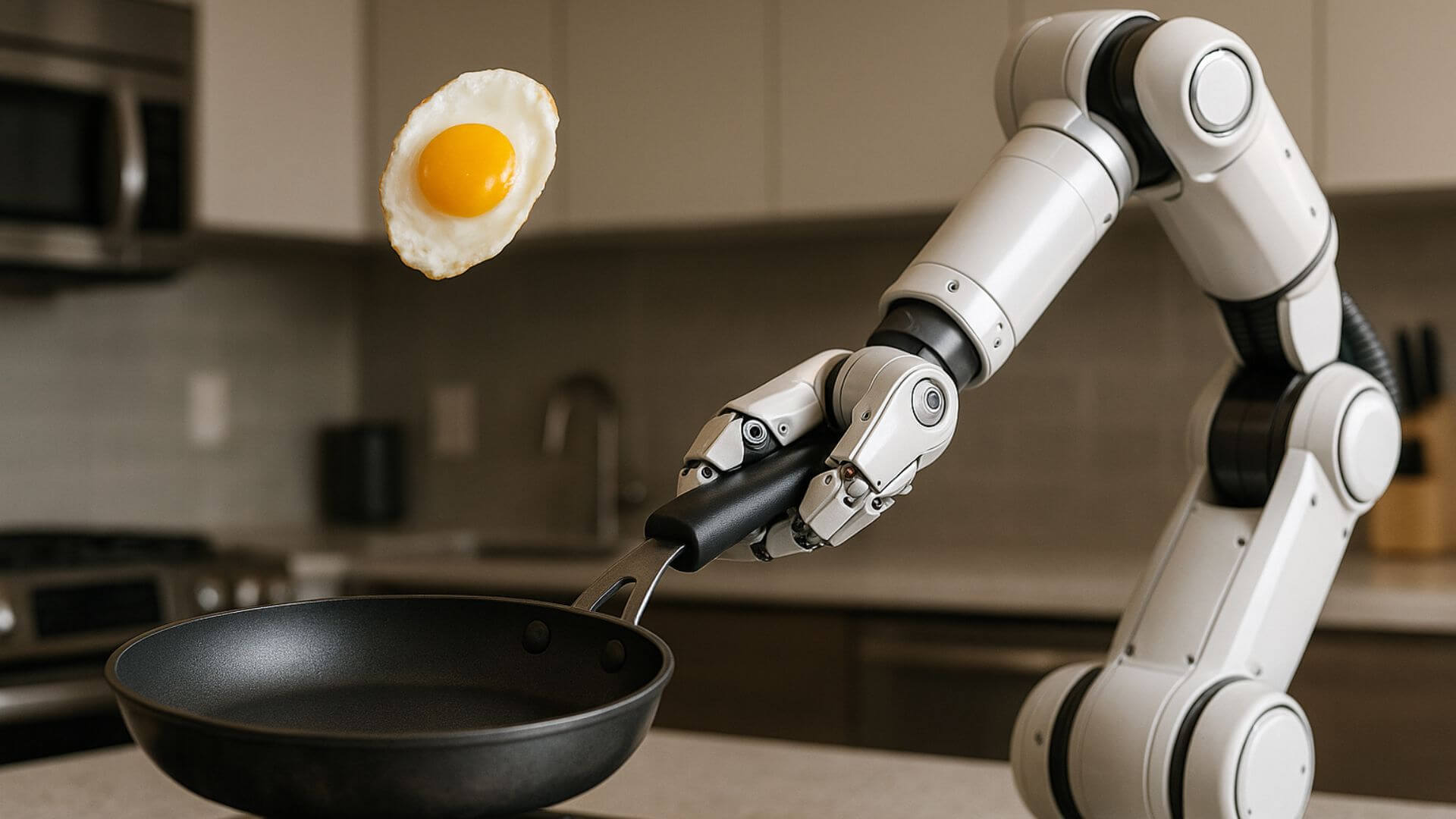

Los robots siempre han despertado fascinación por su capacidad de ejecutar tareas repetitivas con precisión. Pero fuera de las fábricas, su desempeño es más torpe de lo que solemos pensar: la mayoría no sabe adaptarse a situaciones imprevistas. Si la cámara se mueve, si cambia el entorno o si el objeto no está justo donde debería, se bloquean. En contraste, una persona que cocina puede usar la misma sartén para freír, revolver o voltear un huevo sin pensarlo demasiado. La diferencia está en que los humanos aprendemos mirando y practicando, no siguiendo instrucciones rígidas.

Ese principio inspiró a un grupo de investigadores de la Universidad de Illinois Urbana-Champaign, en colaboración con Columbia University. En su trabajo muestran que un robot logró voltear un huevo en una sartén, clavar un clavo o equilibrar una botella de vino simplemente tras observar videos de personas realizando esas tareas. No hubo necesidad de programar cada movimiento ni de controlarlo con un joystick. Como escriben los autores en el artículo: “Nuestro marco permite la transferencia directa de datos de juego humano en políticas robóticas desplegables” .

Cómo funciona la idea de “herramienta como interfaz”

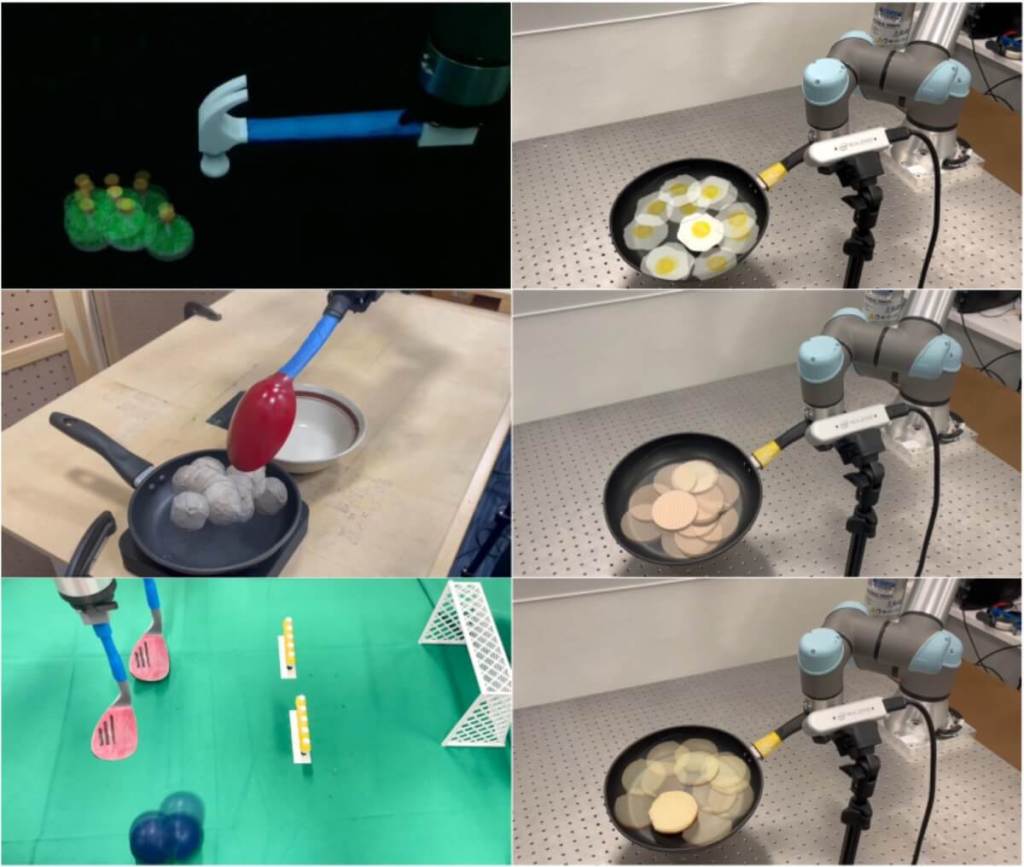

El equipo llama a su enfoque Tool-as-Interface, porque pone el énfasis en la herramienta que se usa (una sartén, un martillo, una cuchara) y no en la mano humana que la manipula. La clave está en que el robot no intenta copiar los gestos de la persona, sino que aprende la trayectoria y orientación del objeto. De esta forma, no importa si el brazo humano y el brazo del robot son diferentes, porque ambos comparten la herramienta como punto común.

Para entrenar al robot basta con grabar la acción desde dos cámaras. Esos dos ángulos permiten reconstruir en 3D la escena usando un modelo de visión llamado MASt3R. Luego, otra técnica llamada 3D Gaussian splatting genera vistas adicionales del mismo momento, de modo que el robot pueda “ver” la tarea desde distintos ángulos. Así, incluso si la cámara se mueve durante la ejecución, el sistema conserva estabilidad. No hacen falta sensores costosos ni entornos controlados.

El paso decisivo: borrar al humano del video

Un detalle fundamental es que los algoritmos eliminan la mano humana del material grabado. Con ayuda del modelo Grounded-SAM, se segmenta y enmascara todo lo que corresponde al cuerpo humano. Lo que queda en el video es únicamente la herramienta interactuando con los objetos. Así el robot aprende observando qué hace la sartén, el martillo o la cuchara, y no cómo se mueven los dedos de la persona.

Esto resuelve lo que los autores llaman la “brecha de encarnación”: el hecho de que los humanos y los robots tienen morfologías muy distintas. Como explican en el artículo, “abstraer las acciones al marco de la herramienta reduce la dependencia morfológica, permitiendo que las políticas se generalicen entre encarnaciones”. En la práctica significa que el mismo conjunto de datos sirve para entrenar brazos robóticos de seis o siete grados de libertad, sin necesidad de repetir todo el proceso.

Pruebas con clavos, albóndigas y huevos

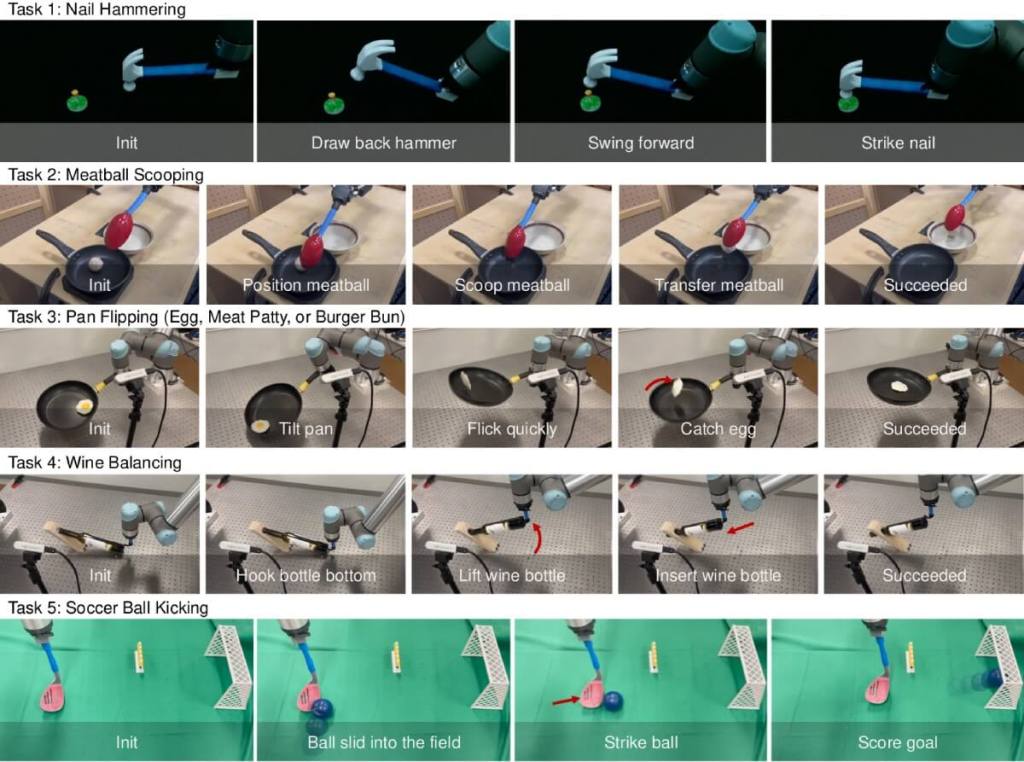

Los experimentos incluyeron cinco tareas que exigen velocidad, precisión o adaptabilidad. Entre ellas: martillar un clavo de plástico, sacar una albóndiga de una sartén con una cuchara, voltear un huevo en el aire usando una sartén, equilibrar una botella de vino en un soporte inestable y patear una pelota con un palo de golf robótico.

Lo notable es que muchas de esas acciones son imposibles de capturar con los métodos clásicos de teleoperación, porque son demasiado rápidas o impredecibles. En la prueba de la sartén, por ejemplo, el robot fue capaz de voltear un huevo en apenas 1,5 segundos. En la de las albóndigas, siguió actuando correctamente incluso cuando un humano añadía más bolas al sartén en pleno proceso. El sistema no se desconcertó, simplemente se adaptó.

Resultados frente a los métodos tradicionales

Los investigadores compararon su enfoque con otros sistemas como la teleoperación con joysticks especializados o el uso de pinzas manuales impresas en 3D. La diferencia fue enorme: la tasa de éxito aumentó un 71% respecto a las políticas entrenadas con teleoperación y el tiempo de recolección de datos se redujo un 77% . Además, la técnica demostró robustez incluso cuando la cámara temblaba o cuando se movía la base del robot.

En cifras más concretas, en la tarea de clavar un clavo, los métodos clásicos fracasaron en los 13 intentos, mientras que con Tool-as-Interface el robot acertó las 13 veces. En el volcado de un huevo, los sistemas previos ni siquiera podían completarlo, mientras que el nuevo marco logró los 12 intentos exitosos. Es un salto cualitativo en la manera de entrenar robots.

Más allá del laboratorio: ¿qué significa esto?

El equipo resalta que este avance abre la puerta a entrenar robots con videos caseros, grabados con teléfonos móviles. Hoy existen más de 7 mil millones de cámaras de este tipo en el mundo, lo que convierte cada cocina, taller o almacén en un posible escenario de aprendizaje. Si los algoritmos se perfeccionan, un robot podría aprender a cortar verduras, a usar un destornillador o a doblar ropa viendo clips grabados por cualquier persona.

En palabras de los autores: “Nuestro enfoque elimina la necesidad de diseñar, imprimir o fabricar hardware adicional durante la recolección de datos, garantizando una solución rentable e inclusiva” . Esta accesibilidad es lo que diferencia a Tool-as-Interface de otros métodos más caros y exclusivos.

Limitaciones y retos futuros

El sistema todavía tiene puntos débiles. Para empezar, asume que la herramienta está firmemente sujeta al extremo del brazo robótico, algo que en la vida real no siempre ocurre. También depende de un modelo de estimación de poses que puede cometer errores, y los ángulos de cámara sintéticos generados a veces pierden realismo. Otro desafío es que de momento solo funciona bien con herramientas rígidas; faltaría ampliar el método a objetos flexibles o blandos.

Los propios investigadores reconocen que “mejorar la fiabilidad del sistema de percepción mediante algoritmos de estimación de pose más robustos es una dirección prometedora para el futuro”. Asimismo, planean explorar representaciones que permitan trabajar con utensilios deformables, como esponjas o pinzas blandas.

Un cambio de paradigma en la robótica

Aunque quede trabajo por delante, lo que muestra este estudio es un cambio de enfoque en la forma en que los robots pueden aprender. Ya no se trata de programar línea por línea ni de usar interfaces costosas, sino de aprovechar la manera natural en que los humanos interactúan con su entorno. Es un modelo inspirado en cómo los niños observan y luego imitan.

Como destacó Haonan Chen, autor principal, “nuestro enfoque se inspiró en la forma en que los niños aprenden, que es observando a los adultos”. Si un niño puede ver cómo se voltea un huevo y luego intentarlo por sí mismo, un robot también puede hacerlo. Y eso abre la posibilidad de máquinas mucho más versátiles, capaces de desenvolverse en escenarios reales con la misma naturalidad que las personas.

Referencias

- Haonan Chen, Cheng Zhu, Yunzhu Li, Katherine Driggs-Campbell. Tool-as-Interface: Learning Robot Policies from Human Tool Usage through Imitation Learning. arXiv (2025). DOI: 10.48550/arxiv.2504.04612.