El argumento de Runaround, un relato de ciencia ficción publicado en 1942 por el escritor y bioquímico, Isaac Asimov, se está convirtiendo en una realidad. Asimov, establecía 3 leyes básicas con las que los robots tenían que ser diseñados para evitar que se rebelasen contra sus creadores, los humanos. Señalaba que en caso de que alguna de estas tres normas se incumpliese, el robot se apagaría inmediatamente.

- Un robot no hará daño a un ser humano ni, por inacción, permitirá que un ser humano sufra daño.

- Un robot debe obedecer las órdenes dadas por los seres humanos, excepto si estas órdenes entrasen en conflicto con la primera Ley.

- Un robot debe proteger su propia existencia en la medida en que esta protección no entre en conflicto con la primera o la segunda Ley.

Siguiendo la senda de las tres leyes básicas de Asimov, la Comisión de Asuntos Jurídicos del Parlamento Europeo se ha puesto manos a la obra y ha presentado un informe, en el que se establecen una serie de propuestas para regular el avance de la robótica.

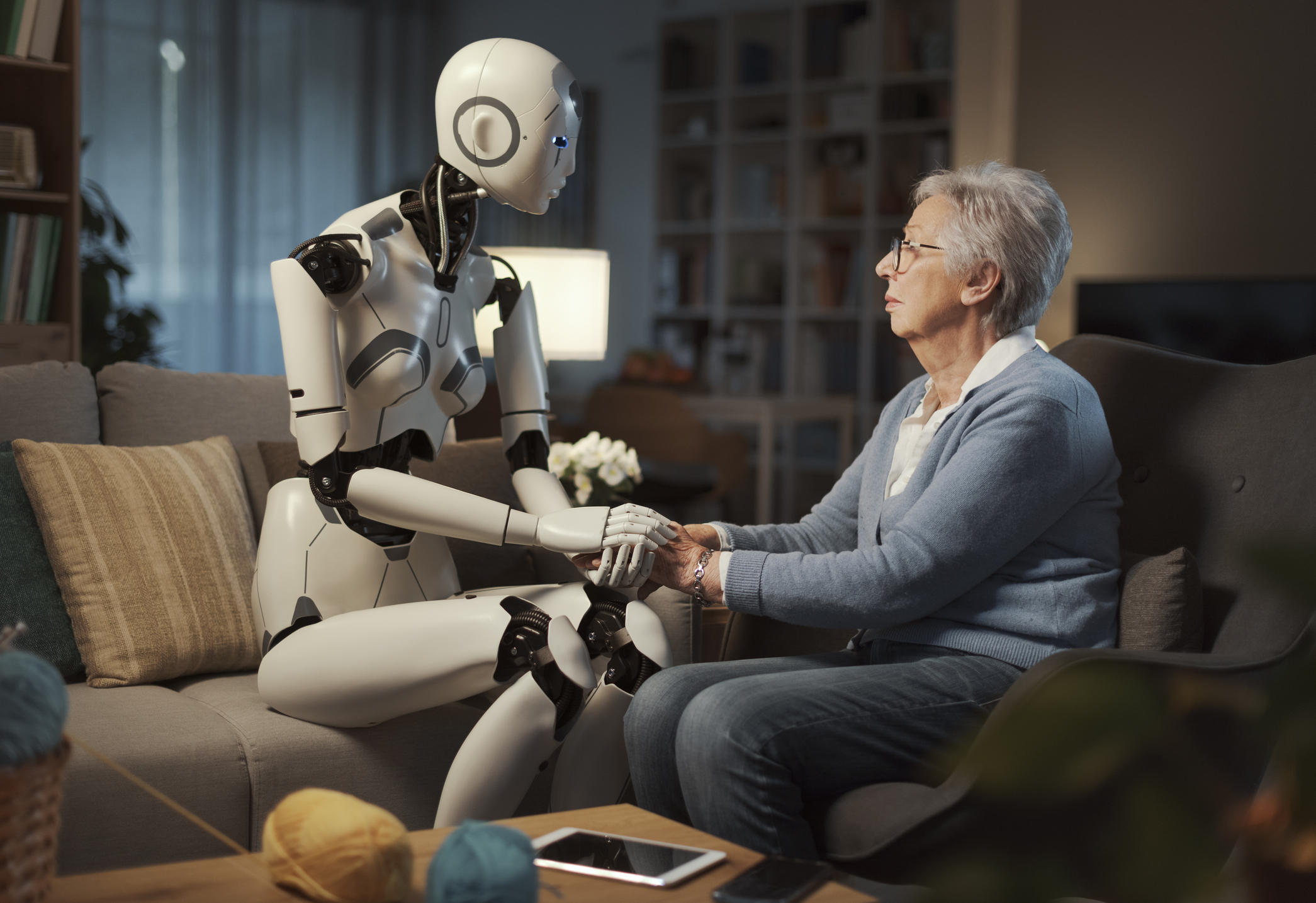

El desarrollo, a pasos agigantados, de la inteligencia artificial y de la robótica, es un hecho y como tal hay que adaptarse a esta nueva realidad y establecer unas normas éticas que normalicen su utilización.

Sin duda, todo esto podría parecer todavía una quimera, pero hablamos de un mundo en el que ya existen coches que no necesitan conductor, y en el cual hay una preocupación latente de que en un futuro el trabajo de las maquinas pudiese reemplazar al de los humanos. Ante este hecho han saltado las alarmas y se está estudiando la posibilidad de implantar un renta básica universal.

Las cuestiones que se plantean en este informe son fundamentales. Una de las más significativas, es la de considerar a ciertos robots como personas electrónicas y como tal tendrían derechos y obligaciones. También se advierte a los dueños de tecnología robótica que deben de usarla con prudencia, evitando que provoquen cualquier tipo de daño a los seres humanos. Para ello piden la creación de una agencia europea, dedica especialmente a regular la inteligencia artificial. Otro de los puntos más llamativos: especifica que los robots han de estar dotados de un botón de la muerte, que permita desactivarlos en caso de emergencia.

El informe incluso plantea la posibilidad de que los robots puedan superar la capacidad de los humanos en unas pocas décadas. Aquí entraría el concepto de singularidad tecnológica, del que se escuchó hablar en 1993 en una conferencia de la NASA, en la que el matemático Vernor Vinge afirmaba algo tan alarmante como que: "De aquí a treinta años, tendremos los medios tecnológicos para crear inteligencia superhumana. Poco después, la era humana habrá acabado."

Aún habrá que esperar unos años para ver si una afirmación tan catastrófica podría llegar a convertirse en realidad, y si realmente "la máquina ultra inteligente" como la denominaba el matemático, será muy superior a la mente humana.

Aplicación Práctica de las Leyes de Asimov en la Inteligencia Artificial Actual

Las tres leyes de Asimov son conocidas por su presencia en la literatura de ciencia ficción, pero también han influenciado la forma en que se diseñan y construyen los robots y sistemas de inteligencia artificial en la actualidad. Muchos ingenieros y diseñadores de IA consideran las leyes de Asimov como pautas éticas básicas, aunque estas no son implementadas literalmente en la programación.

Un ejemplo concreto de la aplicación de la primera ley es el diseño de los vehículos autónomos. Estos coches se programan para minimizar el daño a los seres humanos. Esto se refiere no sólo a los ocupantes del coche, sino también a los peatones y otros conductores en la carretera. En situaciones de emergencia, los vehículos autónomos están diseñados para tomar decisiones que reduzcan la probabilidad de lesiones humanas, incluso si eso significa dañar el propio vehículo.

Respecto a la segunda ley, los asistentes de voz, como Alexa o Siri, son un buen ejemplo de cómo los robots cumplen las órdenes de los humanos, a menos que esas órdenes entren en conflicto con una programación previa. En este caso, la "primera ley" es una programación que prohíbe el uso ilegal o inapropiado de estos asistentes.

En cuanto a la tercera ley, los sistemas de inteligencia artificial están diseñados para proteger su propia existencia de ciertas formas, como con las actualizaciones automáticas y las protecciones contra los virus informáticos. Sin embargo, su "autodefensa" siempre está subordinada a las necesidades y la seguridad de los humanos.

Aunque las leyes de Asimov pueden parecer un código ético sencillo, su aplicación en el mundo real es compleja y sujeta a interpretaciones. Además, los avances en la inteligencia artificial y la robótica están planteando nuevas cuestiones éticas que las leyes de Asimov no llegaron a considerar. Por lo tanto, aunque son un punto de partida útil, también se necesitan nuevas regulaciones y principios éticos para guiar el desarrollo futuro de estas tecnologías.

Propuestas éticas alternativas en la robótica e inteligencia artificial

Mientras las tres leyes de Asimov proporcionan un marco conceptual sencillo y atractivo, en realidad existen numerosas propuestas éticas alternativas en el campo de la robótica e inteligencia artificial. Estas buscan abordar la complejidad de la ética en la era de la inteligencia artificial.

Por ejemplo, la organización internacional de profesionales técnicos, IEEE, propuso en 2017 el documento "Ethically Aligned Design". Este documento es un conjunto de directrices destinadas a priorizar los valores humanos en el diseño de la inteligencia artificial y la robótica autónoma. Los principios del documento son más detallados que las tres leyes de Asimov e incluyen temas como los derechos humanos, la transparencia en los algoritmos y la promoción del bienestar humano.

Por otro lado, la Asociación para la promoción de la inteligencia artificial (AAAI) también ha propuesto principios éticos para la inteligencia artificial. Estos principios abogan por la inclusión de valores éticos y profesionales en el diseño y uso de la inteligencia artificial, destacando la importancia de la transparencia, la privacidad y la rendición de cuentas.

Además, cabe mencionar el trabajo realizado por la "Partnership on AI", una organización fundada por grandes empresas tecnológicas como Amazon, Google, Facebook, IBM y Microsoft. Esta organización se propone guiar la adopción de la inteligencia artificial de manera que beneficie a la humanidad, y ha propuesto principios que se centran en la seguridad, la equidad y la transparencia, así como en la necesidad de que la IA esté al servicio de un amplio rango de intereses humanos.

Estas propuestas ofrecen un enfoque más moderno y sofisticado para manejar la ética de la robótica y la inteligencia artificial. Aunque las leyes de Asimov siguen siendo un referente en este campo, su simplicidad puede no ser suficiente para abordar las complejas cuestiones éticas que surgen con el avance de estas tecnologías. Es importante que, al igual que ocurre en la Comisión de Asuntos Jurídicos del Parlamento Europeo, se sigan realizando esfuerzos para desarrollar y perfeccionar los marcos éticos que regulan el uso de la inteligencia artificial y la robótica.

Más información en Masqueapple.com