En un escenario donde los auriculares inalámbricos se han consolidado como el accesorio indispensable de millones de usuarios, la competencia por dominar el mercado nunca ha sido tan intensa.

Este final de mes de septiembre, Apple ha decidido reforzar su posición en el segmento premium mediante un importante recorte de precio en sus AirPods 3ª Gen. Un movimiento que los hace mucho más más atractivos frente a competidores directos como Samsung, Sony o incluso OnePlus.

Actualmente es difícil encontrar estos auriculares por debajo de los 139€ en varias tiendas como Pixmania, Miravia o Amazon. Sin embargo, Apple apuesta por PcComponentes para hundirlos bestialmente sin superar la barrera de los 100€, situándolos en 99,99 euros.

Cuentan con un sistema de ecualización adaptativa que ajusta automáticamente las frecuencias bajas y medias en tiempo real, en función de la forma de la oreja del usuario. También incorporan audio espacial con seguimiento dinámico de la cabeza, lo que crea una experiencia envolvente tanto en música como en películas o series compatibles con Dolby Atmos.

En el apartado de autonomía, ofrecen hasta 6 horas de reproducción continua con una sola carga, que se extienden hasta 30 horas en total gracias al estuche de carga MagSafe o Lightning. Además, cuentan con resistencia al agua y al sudor con certificación IPX4. E integran Bluetooth 5.0 y el chip Apple H1, que permite emparejamiento instantáneo.

Xiaomi sigue apostando por mantener rebajados sus Buds 5

Mientras Apple intensifica su ofensiva, Xiaomi no se queda de brazos cruzados. La marca continúa apostando fuerte por mantener a un precio super competitivo sus Xiaomi Buds 5, situándolos en 54,69 euros. Una alternativa más económico, y que habitualmente suele estar por encima de los 63€ en Amazon, PcComponentes o Fnac.

Los Xiaomi Buds 5 llegan equipados con True Wireless (TWS) de diseño semi in-ear, diseñados para ofrecer una experiencia auditiva de alta fidelidad gracias a la certificación Hi-Res. Además de soporte para audio lossless y ecualización personalizada mediante Harman Audio EFX. Incorporan Bluetooth 5.4 con un alcance de 10 metros. Permitiendo también conexión dual de dispositivos y emparejamiento instantáneo mediante Google Fast Pair.

Cada auricular pesa apenas 4,2 g e integra una batería de 35 mAh, mientras que el estuche de 480 mAh amplía la autonomía hasta 30 horas de uso. Todo ello se complementa con compatibilidad con la app Xiaomi Earbud para un control total de funciones y personalización.

*En calidad de Afiliado, Muy Interesante obtiene ingresos por las compras adscritas a algunos enlaces de afiliación que cumplen los requisitos aplicables.

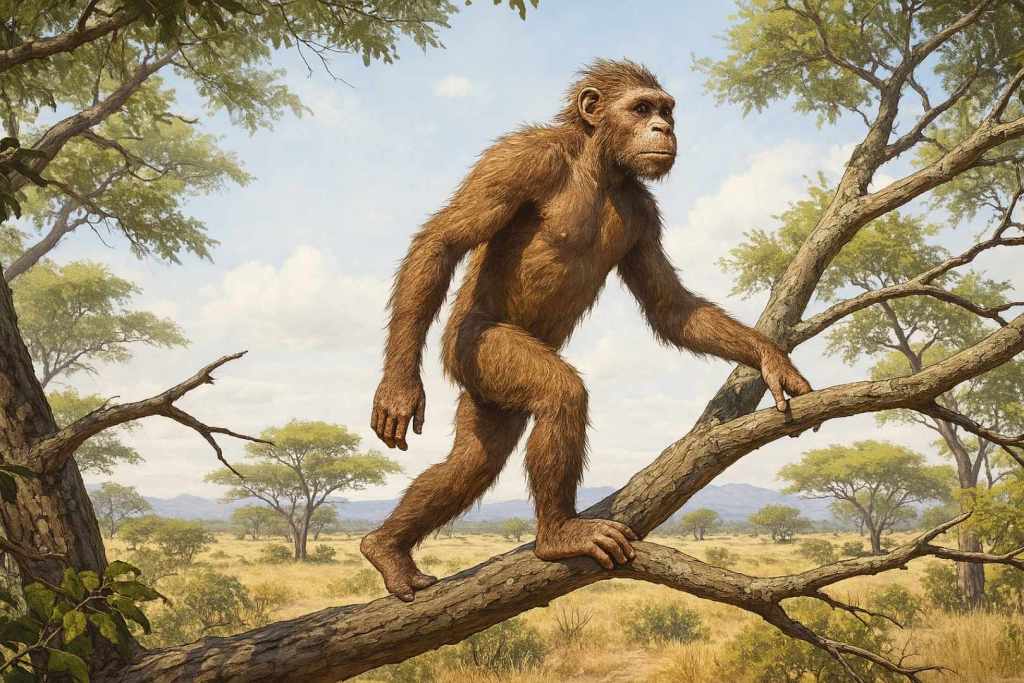

Durante décadas, la escena fundacional del ser humano ha sido retratada de forma casi cinematográfica: un homínido de aspecto primitivo descendiendo con torpeza de un árbol, posando sus pies sobre la hierba reseca de la sabana africana, y echando a andar en vertical como quien se aventura en territorio desconocido. Esta imagen, grabada a fuego en documentales, libros de texto y museos, ha moldeado nuestra comprensión del origen del bipedismo. Sin embargo, una nueva investigación está desafiando de forma radical esa narrativa. ¿Y si, en lugar de caminar por necesidad al tocar el suelo, nuestros ancestros desarrollaron la marcha erguida precisamente entre ramas y troncos, como una adaptación arbórea y no terrestre?

En un rincón poco explorado del oeste de Tanzania, donde el paisaje alterna entre pastizales secos y árboles dispersos que apenas proyectan sombra, un grupo de chimpancés ha sorprendido a la ciencia. Este lugar, conocido como el valle de Issa, no se asemeja en nada a los típicos escenarios selváticos que solemos asociar con nuestros parientes más cercanos. Aquí no hay selvas exuberantes ni un dosel frondoso que los cobije. Sin embargo, contra todo pronóstico, estos primates no han abandonado las alturas.

A pesar del calor abrasador del suelo y la aparente escasez de cobertura vegetal, los investigadores del Instituto Max Planck han documentado un comportamiento inesperado: los chimpancés prefieren seguir en los árboles, incluso cuando el sentido común indicaría lo contrario.

Adaptarse sin descender: la paradoja del chimpancé

En lugar de adaptarse al suelo, como cabría esperar en un entorno tan abierto, los chimpancés del valle de Issa han duplicado su apuesta por la vida en las alturas. A lo largo de meses de trabajo de campo, los científicos siguieron cuidadosamente sus movimientos y rutinas alimenticias, registrando con detalle más de 300 momentos distintos en los que estos primates escogían las copas de los árboles como escenario para sus comidas. Lo interesante no fue solo lo que consumían, sino también cómo se desplazaban, se posicionaban y seleccionaban ciertas especies vegetales, revelando patrones de conducta sorprendentemente complejos y especializados para un hábitat tan poco arbóreo.

Los resultados, publicados recientemente, muestran que los chimpancés pasaban tanto tiempo en los árboles como sus primos que habitan bosques cerrados. Pero no solo eso: además, adoptaban comportamientos llamativos, como moverse de manera suspendida bajo las ramas o caminar erguidos mientras se sujetaban a ramitas laterales.

Lo que observaron los científicos no fue una caminata al estilo humano sobre la tierra firme, sino algo mucho más revelador. Muchos de estos chimpancés utilizaban sus brazos y piernas en complejas maniobras de equilibrio mientras se desplazaban entre ramas delgadas, aquellas que suelen colgar en los extremos y que ofrecen los frutos más valiosos. Este tipo de movimientos —que implican colgarse, balancearse y apoyarse parcialmente en dos patas— resulta fundamental para comprender cómo ciertos patrones de locomoción evolucionaron. En lugar de pisar suelo firme, estas criaturas perfeccionan su agilidad aérea, desafiando la lógica que asocia el bipedismo exclusivamente con la vida terrestre.

Una estrategia de supervivencia... y quizás de evolución

¿Qué sentido tiene mantenerse en las alturas cuando el paisaje invita a bajar? La clave está en lo que se come. En el valle de Issa, donde la escasez es la norma y la vegetación no abunda, cada árbol que produce alimento se convierte en un recurso crucial. Pero no hablamos de frutas jugosas al alcance de la mano. Muy al contrario: los chimpancés de esta región deben conformarse a menudo con lo que haya, y eso implica enfrentarse a frutos duros, semillas ocultas en cápsulas coriáceas o incluso pequeñas estructuras vegetales parasitarias que requieren mucha paciencia y habilidad para ser recolectadas. Permanecer en los árboles no es una elección caprichosa, sino una estrategia de supervivencia bien calculada.

Cuanto más complicado resulta acceder al alimento, más prolongada es la permanencia de los chimpancés en un mismo árbol. Y a medida que aumenta el esfuerzo necesario para recolectarlo, también crece la exigencia física: deben avanzar con cuidado entre ramas delgadas y poco firmes, ajustando cada movimiento a un entorno que cambia constantemente bajo sus pies. Este escenario propicia una mayor cantidad de desplazamientos en suspensión y, lo más interesante, fomenta el uso de posturas erguidas sostenidas por el apoyo simultáneo de las manos. Sin proponérselo, estos primates parecen estar ensayando una forma de moverse que, con el paso de millones de años, acabaría marcando un punto de inflexión en la evolución de nuestra propia especie.

Reescribiendo el origen del bipedismo

Durante mucho tiempo, la teoría dominante sobre el origen del bipedismo sugería que nuestros ancestros comenzaron a caminar erguidos cuando el paisaje boscoso dio paso a llanuras abiertas, y desplazarse de árbol en árbol exigía recorrer largas distancias a pie. Sin embargo, los hallazgos recientes introducen una variación crucial en esta hipótesis: es posible que la marcha sobre dos piernas no se gestara en el suelo, sino entre las ramas. En lugar de surgir como una respuesta a la vida terrestre, esta forma de locomoción podría haberse desarrollado primero como una ventaja evolutiva en los árboles, facilitando el movimiento en un entorno complejo y tridimensional mucho antes de convertirse en una herramienta útil para atravesar la sabana.

No obstante, eso no excluye el papel del paisaje. El valle de Issa representa un entorno intermedio, muy similar al que habitaron los primeros homínidos hace millones de años: una combinación única de sabana y bosque disperso. En este tipo de terreno, moverse entre árboles es costoso y arriesgado, lo que habría favorecido estrategias más eficientes, como permanecer más tiempo en un solo árbol y adaptarse a sus ramas delgadas… incluso desplazándose en posición erguida, con ayuda de los brazos.

El valor del estudio, tal y como avanzamos en este otro artículo, no solo reside en su planteamiento teórico. También proporciona un modelo viviente que ilustra cómo pudo haber sido la vida de nuestros ancestros. Observar a los chimpancés de Issa es, en cierto modo, mirar hacia atrás en el tiempo. Aunque los registros fósiles del tránsito entre el Mioceno y el Plioceno son escasos, su comportamiento ofrece pistas valiosas. Nos permite imaginar cómo un primate de gran tamaño, aún ligado a los árboles y dependiente de frutos, pudo adaptarse gradualmente a un entorno cambiante sin abandonar del todo la vida arbórea.

La propia arquitectura de los árboles juega un papel clave. Los que más frecuentan los chimpancés presentan copas abiertas y ramas delgadas, lo que les obliga a estirarse y adoptar posturas verticales para alcanzar el alimento. Este tipo de entorno fomenta movimientos con el torso erguido, como la suspensión o el desplazamiento apoyado en las manos. A largo plazo, estas conductas podrían haber moldeado el cuerpo hacia formas más aptas para caminar sobre dos piernas.

Una historia aún por completar

Por ahora, las observaciones se limitan a la estación seca. Queda por ver si estos comportamientos se mantienen cuando llegan las lluvias y cambia la distribución de alimentos. También será clave contrastar con otros grupos de chimpancés en entornos parecidos. Aun así, los datos apuntan en una dirección clara: la idea de que el bipedismo pudo originarse en los árboles ya no parece tan improbable.

La vieja idea de que el bipedismo surgió simplemente al abandonar los árboles se queda corta ante estos nuevos indicios. Es posible que caminar erguidos no naciera del impulso de avanzar por la sabana, sino del esfuerzo por permanecer entre las ramas el mayor tiempo posible, buscando alimento con precisión y equilibrio. Si es así, cada vez que un chimpancé se balancea en lo alto, podríamos estar presenciando un vestigio silencioso de cómo comenzó nuestro propio camino sobre dos piernas.

Durante años, un campo sin aparente importancia en el sur de Austria escondió uno de los secretos mejor guardados del Neolítico. Bajo una capa de tierra cultivada, invisibles a simple vista, yacían enterradas las huellas de una civilización que transformó para siempre la forma en la que los humanos habitaron el continente europeo. Ahora, un equipo de arqueólogos ha destapado tres enormes estructuras circulares que no solo desafían lo que creíamos saber sobre la prehistoria europea, sino que podrían representar uno de los centros rituales más antiguos jamás descubiertos en Europa Central.

Un hallazgo monumental en Rechnitz

El pequeño municipio de Rechnitz, en la región de Burgenland, cerca de la frontera con Hungría, ha sido el escenario de uno de los descubrimientos arqueológicos más impactantes de los últimos años. Dentro del marco del Masterplan Archäologie del gobierno de Burgenland, y en preparación para la construcción de un parque arqueológico y un poblado neolítico de exhibición, se llevaron a cabo excavaciones que revelaron tres grandes Kreisgrabenanlagen —es decir, recintos circulares rodeados por fosos y terraplenes— que datan de entre 4850 y 4500 a.C., lo que los convierte en más antiguos que Stonehenge o las pirámides de Giza.

Las estructuras tienen un diámetro de más de 100 metros y fueron identificadas por primera vez mediante estudios geomagnéticos y fotografías aéreas entre 2011 y 2017. Pero solo recientemente, con excavaciones sobre el terreno, han podido estudiarse de forma directa y confirmarse como monumentos prehistóricos construidos por comunidades agrícolas del Neolítico Medio. A diferencia de otros hallazgos aislados, lo verdaderamente extraordinario de Rechnitz es la concentración de tres recintos monumentales en un mismo lugar, lo que sugiere que esta zona funcionó como un centro ceremonial, económico y posiblemente astronómico de gran relevancia.

Un centro neurálgico del Neolítico

Los trabajos arqueológicos, dirigidos por Archaeologie Burgenland y en colaboración con la Universidad de Viena y la empresa especializada PANNARCH, han sacado a la luz no solo los recintos circulares, sino también restos de viviendas, postes estructurales y cerámicas que confirman la existencia de asentamientos humanos tanto del Neolítico temprano como del medio. Esto indica que el área estuvo habitada de forma continua durante varios siglos, coincidiendo con el momento en que las primeras sociedades agrícolas comenzaron a organizarse en comunidades sedentarias.

Este proceso, conocido como la Revolución Neolítica, supuso un punto de inflexión en la historia humana: el abandono del nomadismo y la adopción de la agricultura y la ganadería como base del sustento. En ese contexto, las estructuras monumentales de Rechnitz aparecen como símbolos físicos de un nuevo orden social, en el que el espacio común, las ceremonias y quizás también la observación astronómica adquirieron un valor central.

Lo más fascinante es que estas estructuras no eran fortalezas ni simples delimitaciones del terreno. La complejidad de sus accesos, la planificación geométrica y su alineación potencial con fenómenos solares como los solsticios —algo observado en otros recintos similares como el Círculo de Goseck en Alemania— apuntan a una función ritual o simbólica profundamente arraigada en las creencias de estas comunidades.

Una ventana abierta a la Edad de Piedra

Los arqueólogos que trabajan en Rechnitz han descrito este lugar como una verdadera “ventana a la Edad de Piedra”, una metáfora que cobra sentido cuando se considera la magnitud del hallazgo. Las estructuras descubiertas son de tal escala y sofisticación que suponen un reto directo al relato lineal del desarrollo cultural europeo, donde muchas veces se otorga un papel principal a las civilizaciones del Mediterráneo oriental o Mesopotamia.

Este rincón del sudeste austriaco demuestra que ya desde hace más de 6.500 años, las sociedades centroeuropeas eran capaces de coordinar grandes proyectos de ingeniería comunal, con implicaciones espirituales, sociales y científicas. A ello se suma la presencia de instrumentos cerámicos, pozos, y muestras de sedimentos agrícolas, cuya investigación permitirá comprender cómo evolucionaron los suelos y las prácticas agrícolas a lo largo del milenio.

Las muestras recogidas serán sometidas a análisis bioarqueológicos y geológicos en Viena, con el objetivo de reconstruir el entorno natural y las dinámicas agrícolas de estos primeros pobladores. Los resultados podrían ofrecer datos sin precedentes sobre la transición ecológica del Neolítico y su impacto en el paisaje actual de Burgenland.

El futuro parque arqueológico de Rechnitz

El hallazgo no solo tiene un valor científico: también está llamado a convertirse en un nuevo motor de turismo cultural en la región. El gobierno de Burgenland ya ha anunciado la creación de un centro de visitantes junto con un poblado neolítico recreado, donde los visitantes podrán experimentar la vida del 5º milenio a.C. y aprender sobre las técnicas, herramientas y modos de vida de los primeros agricultores del continente.

Este enfoque no solo busca atraer a estudiosos y turistas curiosos, sino también fomentar la educación histórica y medioambiental, en una era donde las raíces de nuestra relación con la tierra y la organización social cobran una nueva relevancia. El centro servirá como punto de partida para rutas temáticas, actividades escolares y eventos de divulgación, haciendo accesible al gran público una parte del pasado que, hasta ahora, permanecía enterrada y olvidada.

En definitiva, Rechnitz se perfila como uno de los yacimientos prehistóricos más prometedores de Europa, no solo por su antigüedad, sino por su capacidad para cambiar nuestra percepción de la historia y demostrar que hace más de seis mil años, en el corazón de Europa, los seres humanos ya estaban dejando huellas monumentales de su paso por el mundo.

Las nuevas Smart TV incorporan resolución 4K, mayor nivel de brillo y tecnología HDR para ofrecer imágenes más nítidas y realistas. Su gran pantalla y la fluidez en cada movimiento convierten ver fútbol en una experiencia totalmente inmersiva.

Hisense sorprende de nuevo al mercado con una rebaja inesperada en su Smart TV 58A6K de 58” LED 4K. Una estrategia con la que refuerza su posición frente a la competencia y ofrece a los usuarios una de sus televisiones más completas a un precio más accesible.

Con un precio habitual superior a los 480€ en tiendas como Amazon, Miravia o Pixmania, la Smart TV 4K de 58 pulgadas de Hisense se encuentra en PcComponentes por solo 299 euros. Se trata de su precio mínimo histórico y una de las mejores ofertas actuales en televisores.

Ofrece una experiencia visual de primer nivel gracias a su panel 4K Ultra HD con tecnología Direct Full Array, que asegura negros uniformes y gran nitidez en cada escena. Con HDR10+, Pixel Tuning e inteligencia artificial, la TV potencia los colores y la profundidad de imagen, ideal para disfrutar de películas, series o videojuegos.

En el apartado sonoro, combina DTS Virtual:X y Dolby Audio para un audio envolvente con diálogos claros y graves potentes. Además, integra Game Mode PLUS con baja latencia (ALLM) y VRR, pensado para gaming competitivo. Su sistema VIDAA U6 permite acceso fluido a apps como Netflix o Disney+, mientras que la conectividad avanzada con HDMI, USB y Bluetooth garantiza máxima versatilidad.

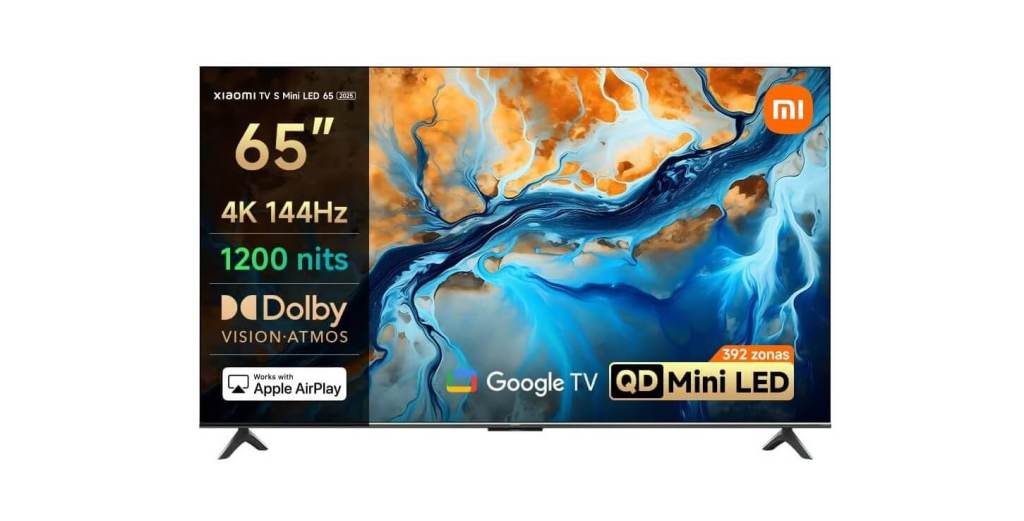

Xiaomi sacude el mercado con un recorte imbatible en su Smart TV S Mini 2025 de 65"

Xiaomi no se queda atrás y responde en el mercado europeo al rebajar su Smart TV S 2025 de 65 pulgadas hasta los 599 euros en MediaMarkt. Una oportunidad destacada si tenemos en cuenta que su precio habitual ronda los 744 € en tiendas como Pixmania, Amazon o PcComponentes, consolidándose como una de las mejores alternativas en televisores 4K.

Revoluciona la experiencia audiovisual con tecnología Mini LED de 308 zonas de atenuación, 1200 nits de brillo y resolución 4K UHD para un contraste nítido y colores vivos. Su tasa de refresco de 144 Hz con MEMC a 120 Hz elimina el desenfoque en escenas rápidas. Mientras que la certificación FreeSync Premium y VRR la hacen perfecta para videojuegos competitivos. Todo ello en un diseño unibody metálico con biseles ultrafinos.

Además, incorpora altavoces con 4 drivers compatibles con Dolby Atmos, Dolby Vision IQ e IMAX Enhanced. Su procesador Quad Cortex A73 con 3 GB de RAM y 32 GB de memoria interna asegura fluidez con Google TV y Chromecast integrado. Junto a conectividad avanzada con HDMI 2.1, USB 3.0, Wi-Fi 6 y Bluetooth 5.2.

*En calidad de Afiliado, Muy Interesante obtiene ingresos por las compras adscritas a algunos enlaces de afiliación que cumplen los requisitos aplicables.

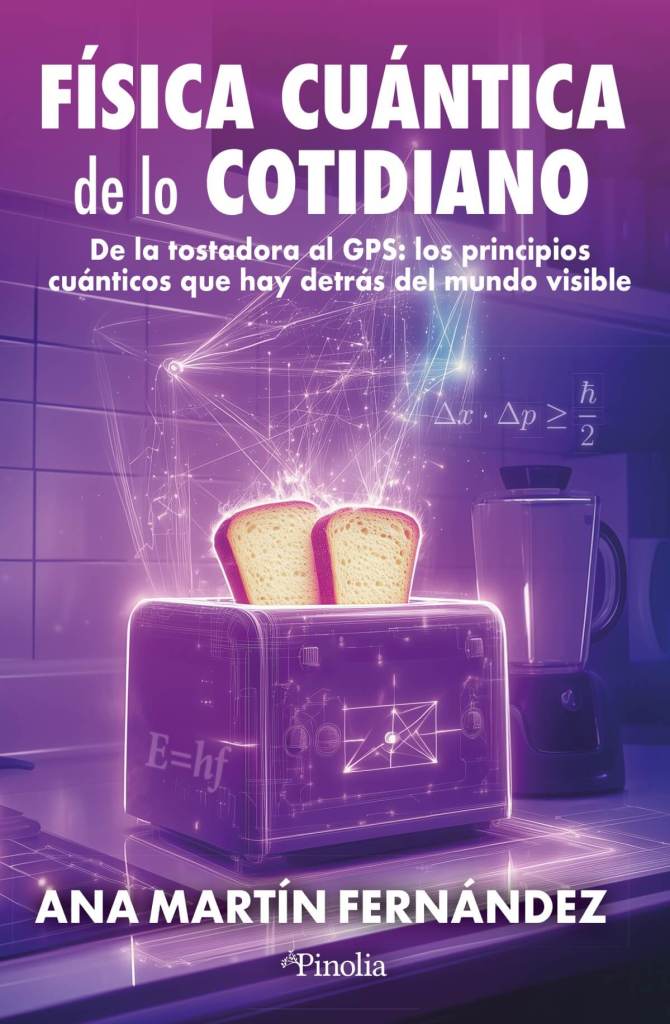

En un tiempo en que la frontera entre ciencia y espiritualidad suele trazarse con mano dura, la pregunta que plantea el libro de Aubrey Houdeshell es provocadora: ¿y si la antigua intuición pitagórica de que el universo “suena” encontrara hoy eco en los datos de la NASA y en los cálculos de astrofísicos? La respuesta, como veremos, está en las vibraciones que laten en las estrellas, los planetas y hasta en la propia Tierra. Cuando se abre “Guía práctica de astrología” (Hestia 2025), de Houdeshell, lo primero que atrapa es la idea central: los planetas no son solo cuerpos celestes, sino notas vivas en una partitura cósmica.

La obra propone mirar la carta natal como un mapa sonoro, donde cada astro —del Sol a Lilith— aporta un timbre único a nuestra identidad. La propuesta conecta directamente con un concepto milenario, la musica universalis, y con un campo científico muy vivo: la sismología solar y estelar.

Más allá de la teoría, el libro se despliega como una guía práctica: cada capítulo combina contexto histórico, símbolos, ejercicios introspectivos y piezas musicales que acompañan la exploración de cada astro. El lector no solo se aproxima al trasfondo filosófico de la musica universalis, sino que también encuentra propuestas concretas para conectar con esa dimensión sonora del cosmos en su vida diaria.

Pitágoras y Kepler: cuando el cielo se pensaba como partitura

La idea de que los cuerpos celestes producen una música inaudible se remonta a la Grecia clásica. Para los pitagóricos, las proporciones que regían los intervalos musicales eran las mismas que gobernaban las órbitas. La música era, en su visión, el lenguaje secreto del cosmos. Platón heredó este planteamiento en su Timeo, y siglos más tarde Boecio lo reformuló en la Edad Media como una “música del mundo” paralela a la música humana y a la instrumental.

Johannes Kepler, en pleno siglo XVII, quiso poner números a esa intuición. En Harmonices Mundi calculó las relaciones entre las órbitas planetarias como si fueran intervalos musicales. No buscaba una melodía audible, sino un orden matemático capaz de reflejar la mente divina. En cierto modo, inauguró la transición de la musica universalis mística a la ciencia empírica.

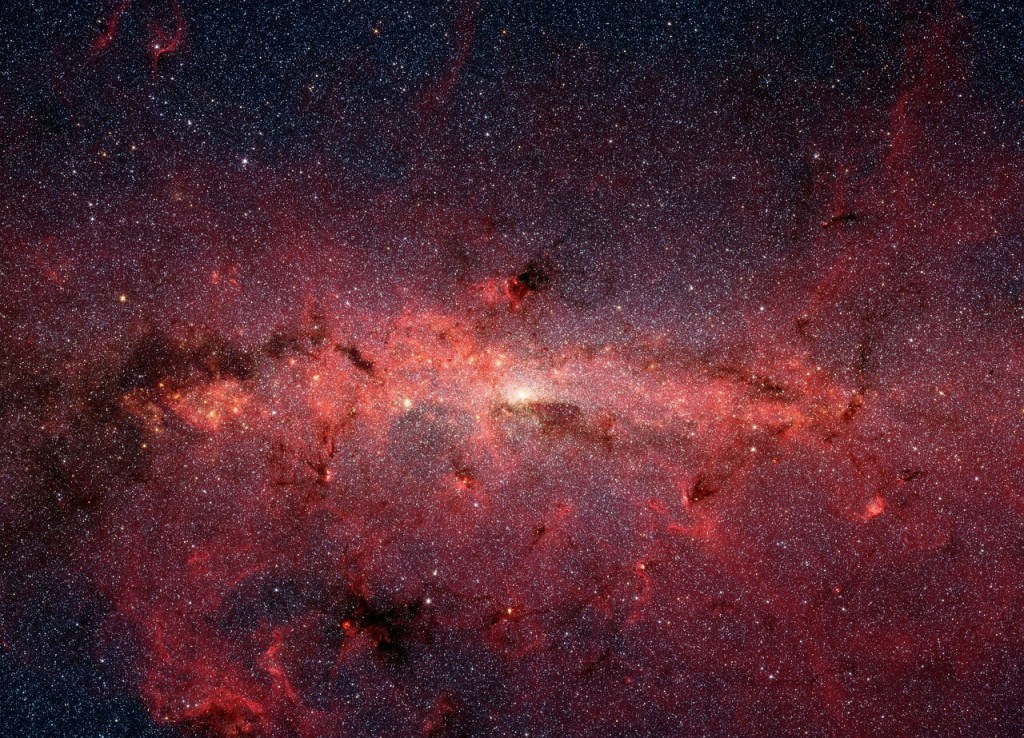

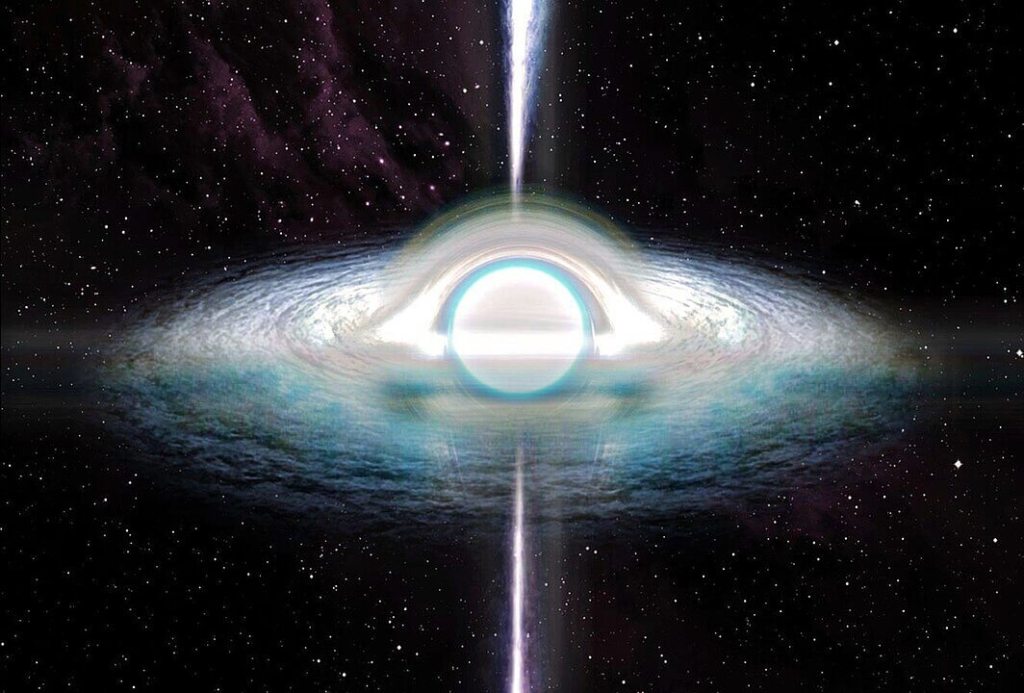

El Sol canta con ondas que no oímos. Hoy sabemos que la idea de Kepler no era descabellada. El Sol, por ejemplo, vibra de forma constante. En su interior se producen ondas de presión que rebotan como si fueran ecos dentro de un gigantesco instrumento. Esas vibraciones —captadas por satélites como SOHO— no pueden oírse en el vacío, pero los científicos las transforman en sonido. El resultado son “notas” graves y continuas, producto de miles de modos acústicos simultáneos.

La helioseismología, disciplina que estudia estos temblores, ha permitido medir la estructura interna del Sol, calcular la profundidad de sus capas y seguir la dinámica de su rotación. En palabras simples: escuchar al Sol ofrece pistas de su esqueleto invisible. Lo que para Pitágoras era intuición hoy se convierte en una herramienta de diagnóstico astrofísico.

Estrellas que vibran como gigantescos instrumentos

El salto siguiente fue aplicar estas técnicas a otras estrellas. Con el telescopio espacial Kepler, los astrónomos comenzaron a detectar lo que llaman “starquakes”: temblores que hacen vibrar a los astros enteros. Cada patrón de vibración revela edad, masa y composición. La asterosismología se ha convertido en una de las ramas más fértiles de la astrofísica moderna.

Gracias a ella sabemos, por ejemplo, que algunas estrellas gigantes rojas laten con ritmos tan lentos que su “nota” equivaldría a una vibración por cada varios días. Aunque inaudibles para nosotros, esas frecuencias pueden transformarse en sonidos digitales. Escuchar las estrellas no es poesía: es ciencia de precisión.

Saturno y sus anillos: un diapasón cósmico

La música no viene solo de las estrellas. En Saturno, las oscilaciones internas del planeta generan ondas que se transmiten a sus anillos. Al analizarlas, los investigadores descubrieron que los anillos funcionan como un gigantesco diapasón que vibra al ritmo de su interior.

Esto abrió un nuevo campo, la “sismología de anillos”, que permite estudiar la estructura profunda de un planeta gaseoso a partir de su entorno inmediato.

De nuevo, una intuición antigua encuentra confirmación moderna: los planetas también tienen su voz, aunque para captarla sea necesario traducir vibraciones invisibles a gráficos y sonidos.

Un sistema planetario con cadencia musical

Si Pitágoras hubiera vivido hoy, seguramente se habría fascinado con el hallazgo del sistema TOI-178. Allí, seis exoplanetas orbitan en una cadena de resonancias que recuerdan a una partitura. Cada periodo orbital se relaciona con el siguiente mediante proporciones precisas, como las de las notas de una escala.

Los astrónomos transformaron esas órbitas en una secuencia musical, y el resultado es sorprendentemente armónico. No es música en sentido estricto, pero sí una metáfora poderosa de cómo la dinámica gravitatoria puede organizarse en patrones rítmicos. El eco de la musica universalis vuelve, esta vez con datos medidos por telescopios espaciales.

La Tierra también canta. No hace falta salir del planeta para encontrar vibraciones naturales. Entre la superficie y la ionosfera se forma una cavidad que resuena como una campana. Los rayos que caen en cualquier parte del mundo excitan esta cavidad y generan frecuencias muy bajas, en torno a 7,8 Hz y sus armónicos. Son las llamadas resonancias Schumann.

Estos latidos electromagnéticos rodean constantemente a la Tierra. Aunque imperceptibles para el oído, constituyen una especie de “nota base” de nuestro planeta. Algunos investigadores exploran su posible influencia en procesos biológicos, aunque la evidencia es todavía preliminar. Lo cierto es que, una vez más, la idea de que los cuerpos celestes vibran encuentra respaldo en fenómenos medibles.

De la ciencia a la experiencia personal

La ciencia ha logrado convertir vibraciones en datos y datos en sonido. La NASA ofrece grabaciones de las oscilaciones solares, de los campos de plasma detectados por las sondas Voyager o de los “sismos” estelares. Escucharlas no es solo un ejercicio de divulgación: es una invitación a percibir el cosmos de otra manera.

Aquí es donde la propuesta de “Guía práctica de astrología” cobra sentido. El libro no pretende explicar astrofísica, sino ofrecer un puente entre esa realidad vibrante y la vida cotidiana. A través de prácticas introspectivas y listas musicales, invita a experimentar a cada planeta como un arquetipo sonoro. En lugar de elegir entre ciencia y astrología, plantea un diálogo: usar la resonancia como metáfora para comprendernos mejor.

Descubriendo más sobre Guía práctica de astrología, de Aubrey Houdeshell

El libro de Aubrey Houdeshell, ilustrado por Rose Ides, se presenta como una herramienta moderna para redescubrir la carta natal. En lugar de centrarse únicamente en signos zodiacales, explora el papel de los planetas como voces que configuran nuestra experiencia. Cada capítulo dedica espacio a su contexto histórico, símbolos, correspondencias y, sobre todo, ejercicios prácticos y piezas musicales asociadas.

La obra bebe de la tradición pitagórica de la música de las esferas, pero la traduce a un lenguaje accesible. El lector encuentra propuestas para conectar con el Sol como fuente de vitalidad, con la Luna como reflejo de la intuición, o con Saturno como disciplina interior. Más que un manual técnico, es una invitación a escuchar la sinfonía personal que cada carta natal encierra.

Houdeshell, astróloga y lectora de tarot con experiencia en Astrología Evolutiva, busca ofrecer herramientas de transformación y empoderamiento. Rose Ides, con su estilo gráfico singular y místico, aporta un complemento visual que convierte la guía en un objeto atractivo. El resultado es un libro que dialoga con la tradición, la ciencia y la espiritualidad contemporánea.

La intuición pitagórica de que el cosmos es música no quedó enterrada en la filosofía antigua. Hoy, la helioseismología, la asterosismología, los estudios sobre Saturno y las resonancias de la Tierra muestran que el universo vibra de formas medibles. Convertir esas vibraciones en sonido es un gesto simbólico y científico a la vez: escuchar el eco de las estrellas nos recuerda que habitamos en una sinfonía mayor.

Y en esa intersección entre ciencia y espiritualidad, libros como Guía práctica de astrología ofrecen un mapa personal para interpretar esa música cósmica en la vida diaria.

Si quieres saber más, no te pierdas en exclusiva este extracto del libro.

Referencias

- Houdeshell, A., & Ides, R. (2025). Guía práctica de astrología. Editorial Hestia.

- Christensen-Dalsgaard, J. (2002). Helioseismology. Reviews of Modern Physics, 74 (4), 1073–1129. doi: 10.1103/RevModPhys.74.1073

- Chaplin, W. J., & Miglio, A. (2013). Asteroseismology of solar-type and red-giant stars. Annual Review of Astronomy and Astrophysics, 51, 353–392.

- Fuller, J. (2014). Saturn ring seismology: Evidence for stable stratification in the deep interior of Saturn. Nature, 510(7506), 7506. doi: https://doi.org/10.1016/j.icarus.2014.08.006

- Leleu, A., Alibert, Y., Hara, N. C., et al. (2021). Six transiting planets and a chain of Laplace resonances in TOI-178. Astronomy & Astrophysics, 649, A26.

- Nickolaenko, A. P., & Hayakawa, M. (2014). Schumann Resonance for Tyros: Essentials of Global Electromagnetic Resonance in the Earth-Ionosphere Cavity. Springer.

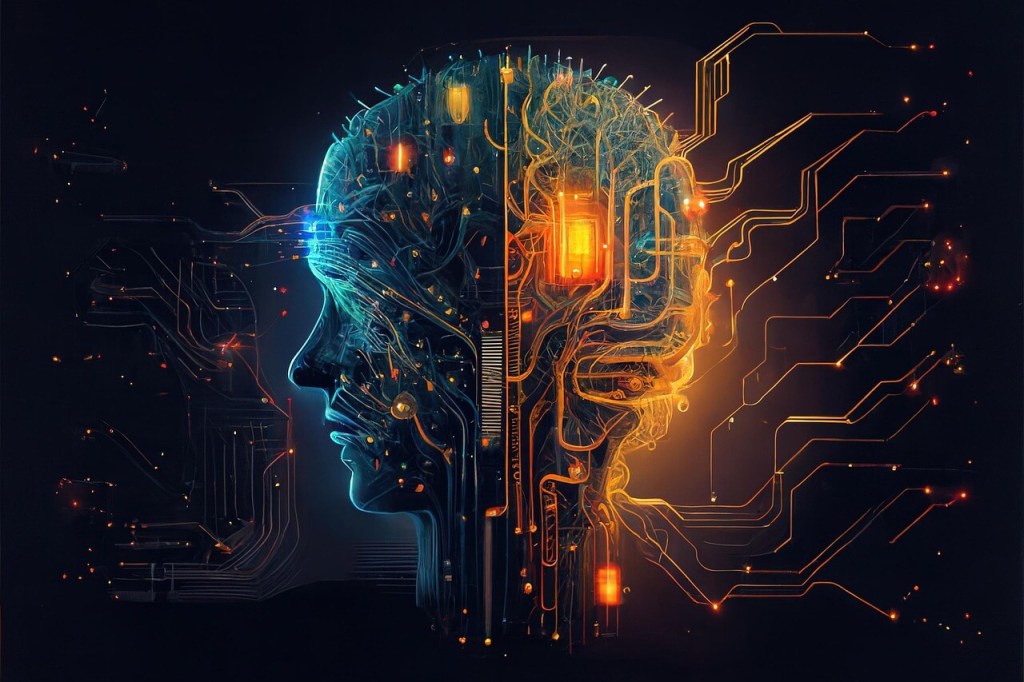

Desde hace más de dos milenios, la humanidad ha buscado escuchar la música secreta del cosmos. Pitágoras fue el primero en hablar de la musica universalis: la idea de que los planetas, al moverse en sus órbitas, generan sonidos que conforman una armonía perfecta, inaudible para nuestros oídos pero perceptible para el alma. Esa metáfora, que unía matemáticas, música y filosofía, marcó profundamente el pensamiento occidental y dio lugar a una tradición que inspiró a filósofos, astrónomos y artistas.

A lo largo de los siglos, este concepto se transformó en un puente entre ciencia y espiritualidad. Johannes Kepler, en el siglo XVII, intentó medir las proporciones orbitales como si fueran intervalos musicales, convencido de que la estructura matemática del universo era también una sinfonía divina. Hoy, la física moderna ofrece un eco sorprendente de esa antigua intuición: la helioseismología y la asterosismología han demostrado que estrellas y planetas vibran, y que esas oscilaciones pueden traducirse en frecuencias, casi como si fueran notas cósmicas.

El sonido, la religión y la astrología han estado siempre entrelazados. Desde desde los cánticos gregorianos hasta la música sufí de Marruecos, las culturas han entendido que la vibración conecta lo humano con lo divino. Incluso la teoría de cuerdas, uno de los pilares de la física contemporánea, describe el universo como hecho de diminutas cuerdas que vibran en distintas frecuencias. La metáfora musical nunca ha dejado de acompañar a nuestra búsqueda de sentido.

Hoy, cuando el lenguaje científico y el espiritual parecen hablar dialectos diferentes, algunos autores intentan devolver a la música de las esferas su lugar como puente entre mundos. La astrología, en particular, la retoma como metáfora central: los planetas como arquetipos, cada uno con su tono y energía, componiendo juntos la sinfonía de nuestra existencia.

En esa tradición se inscribe Guía práctica de astrología, un libro de Aubrey Houdeshell, con ilustraciones de Rose Ides, que convierte la carta natal en una partitura viva y propone ejercicios, música y reflexiones para experimentar las energías planetarias en lo cotidiano. A continuación, lo dejamos en exclusiva con un extracto de Guía práctica de astrología, publicado por la editorial Hestia.

Guía práctica de astrología, escrito por Aubrey Houdeshell

Guía práctica de astrología es un compendio astrológico que se sumerge en los cuerpos celestes que componen nuestras cartas natales —y que, por tanto, conforman lo que somos— y honra los diferentes arquetipos, temas y viajes de cada planeta. Cada uno de estos cuerpos astrales desempeña un papel igualmente importante, aunque distinto, en nuestras vidas. Los hilos únicos tejidos por cada planeta se funden en una orquesta cósmica para formar el complejo tejido de la experiencia humana.

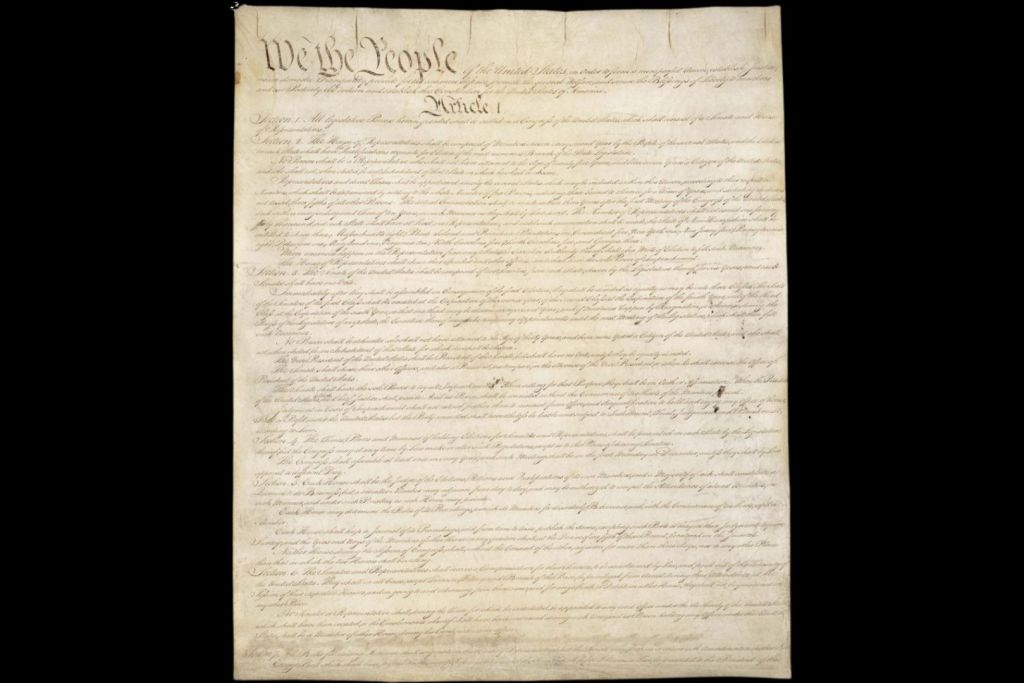

Este libro es una oda al concepto filosófico de musica universalis, articulado por primera vez en la antigua Grecia por Pitágoras. Creía que, puesto que los objetos en movimiento producen sonido, los cuerpos planetarios en órbita también debían generar sus propios sonidos o, en este caso, música. Mediante su estudio de la distancia entre los planetas —que encontró concordante con los intervalos de la música— creyó que los sonidos individuales de cada cuerpo se combinarían armoniosamente: formando una música de las esferas. Esta teoría es la menos conocida —pero a menudo considerada la más sublime— de todos los conceptos pitagóricos. Y aunque pueda parecer muy alejada de nuestra comprensión actual de los cuerpos astrológicos, la musica universalis habla en última instancia de la armónica tropical o astrología tropical. También conocida como astrología occidental, es la versión de la astrología que más se practica hoy en día en Estados Unidos y Europa.

En la época en que expuso por primera vez la teoría de una musica universalis, se creía que solo el propio Pitágoras podía oír la música etérea de las esferas celestes. Sin embargo, según Manly P. Hall en su obra Las enseñanzas secretas de todos los tiempos, en realidad fueron los caldeos, una antigua cultura de habla aramea de los siglos ix y x, los primeros «en concebir que los cuerpos celestes se unían en un canto cósmico mientras se movían majestuosamente por el cielo». También se hace referencia a esta hermosa teoría —a veces abiertamente, a veces de forma más sutil— en muchas enseñanzas, escritos y obras de arte diferentes a lo largo de los siglos. Por ejemplo, Job, el protagonista bíblico del primero de los Libros Poéticos del Antiguo Testamento, describe célebremente un momento de la mañana en que las «estrellas» —la forma en que los antiguos se referían a los planetas en aquella época— cantaban juntas.

La musica universalis tiene sus raíces en la idea de Pitágoras de que el Universo entero es un monocordio colosal que se extiende desde lo más alto de los cielos hasta la Tierra, un interesante paralelismo con el Árbol de la Vida cabalístico, un método para trazar la estructura de la Divinidad que se encuentra en el misticismo judío. Pitágoras dividió el Universo en su propia escala diatónica, reflejando la convención musical de dividir una escala en siete partes, que se alineaban perfectamente con los entonces conocidos siete planetas. Las partes de la escala se asignaron según la masa y la velocidad de cada uno de los planetas. Al vagar por el espacio a sus velocidades individuales, se creía que las esferas creaban su propio tono único en el éter.

Pitágoras también postuló que existía una relación fundamental entre cada uno de los cuerpos celestes y las siete vocales sagradas, que también se correspondían con los siete cielos sagrados, una creencia muy extendida entre los antiguos griegos. El primer cielo cantaba el sonido de alfa o A; el segundo era épsilon o E; el tercero era eta, H; el cuarto era iota, I; el quinto era ómicron, O; el sexto era ípsilon, Y, y el séptimo y último cielo era omega o Ω. «Cuando estos siete cielos cantan juntos, producen una armonía perfecta, que asciende como una alabanza eterna al trono del Creador», escribe Hall. Se creía que los numerosos nombres de Dios se formaban a partir de innumerables combinaciones de las siete esferas planetarias.

De hecho, el sonido, la música, la religión y la espiritualidad tienen una relación profundamente entrelazada. El sonido, por ejemplo, desempeña un papel importante en muchos grupos religiosos y culturales. Un ejemplo es la famosa sílaba semilla del Om en el hinduismo. En esa tradición, se considera la más sagrada de todas las entonaciones, el sonido primordial de la creación que contiene la esencia de todo el Universo. Por tanto, representa el sonido de toda la existencia. En la filosofía budista, las sílabas semilla se utilizan para centrar la mente e invocar distintas cualidades espirituales mediante la meditación. También se cree que los siete chakras o centros de energía del cuerpo —¡de nuevo vemos ese número sagrado y una correlación con cada planeta!— se activan según sonidos específicos. Por último, podemos encontrar la práctica de utilizar el sonido para unirse con lo Divino mediante el nada yoga, con nada que significa «sonido» o «vibración» y yoga que significa «integración » o «unión». Esta forma de yoga sugiere que el sonido es la fuerza creativa fundamental del Universo, y que mediante el uso del sonido podemos unirnos con la conciencia Divina de la creación. Recuerda también que en la Biblia cristiana, Dios habla a las cosas para que existan.

Cuando nos fijamos en los grupos religiosos o espirituales, a menudo se considera que la música es un ritual que promueve la ascensión y la unión con la divinidad. A lo largo de la mayor parte de la historia de la humanidad, los textos religiosos se han cantado, en lugar de escribirse. Un gran ejemplo de ello son los grupos sufíes de Marruecos, que tienen cantores místicos especiales y un conjunto de letanías algo enclaustrado conocido como dhikr. Abd al-Qadir, uno de los más influyentes de estos cantores místicos, «desarrolló la concepción de los siete grados dentro del corazón humano y luego propuso siete dhikrs diferentes para corresponder a las necesidades y requisitos espirituales de cada nivel», según describe Earle H. Waugh en Memory, Music, and Religion: Morocco’s Mystical Chanters. Una vez más, ese número especial, el 7, hace su aparición.

Los cantos gregorianos de la Iglesia católica romana también ejemplifican este vínculo esencial entre música y espiritualidad. Estos cantos, una forma de música litúrgica desarrollada en la época medieval y bautizada con el nombre del papa Gregorio I (también conocido como Gregorio el Grande), se transmitían oralmente de generación en generación dentro de las instituciones monásticas y religiosas. Los cantos no se escribieron hasta mucho más tarde, en un esfuerzo por preservar su integridad. Para los católicos, los cantos gregorianos realzan la atmósfera espiritual de la misa. Gracias a su estructura monofónica —lo que significa que constan de una sola línea melódica—, su naturaleza profundamente meditativa inspira la oración, la contemplación, la introspección y la adoración a Dios.

Podemos ver otros ejemplos de música mística en prácticas como el kirtan gurbani, la música devocional del sijismo, los cantos taoístas, los bhajans del hinduismo, las entonaciones específicas realizadas en rituales como la Cruz cabalística y el honkyoku, que son piezas musicales interpretadas por monjes zen errantes japoneses conocidos como komuso. La espiritualidad y la música siempre se han inspirado e influido mutuamente. En el misticismo judío, los cabalistas creen que lo que hacemos aquí en la Tierra afecta a lo que ocurre en el mundo de lo Divino y viceversa, y han descrito esta correspondencia como la resonancia entre dos violines.

El Árbol de la Vida cabalístico representa la estructura tanto de la Divinidad como del Universo. Funciona como un mapa y una potente herramienta para la ascensión espiritual y la conexión con la divinidad. El Árbol de la Vida consta de diez esferas interconectadas, conocidas como sefirot, cada una de las cuales representa diferentes aspectos de la naturaleza y los atributos de Dios. Se cree que la energía Divina emana del Ein Sof —un lugar de infinitud que existe antes de la manifestación— a través de las sefirot, descendiendo en cascada por el Árbol de la Vida en una serie de emanaciones Divinas. Este proceso se compara a menudo con la vibración de las notas musicales, actuando cada sefira como un conducto para la energía y la conciencia Divinas.

La música también es una poderosa herramienta espiritual en la práctica cabalística. Los cabalistas emplean cánticos, cantos e instrumentos musicales para sintonizar con las energías de las sefirot y acercarse a la Divinidad. Entonar los diversos nombres de Dios es una práctica integral de la Cábala, como el ritual cabalístico de la Cruz de autoconsagración, que se emplea antes y después de los rituales y se cree que purifica el espíritu y alinea al practicante con la energía de la Divinidad. Ciertas melodías o patrones musicales se asocian a sefirot específicas y potencian la conexión del practicante con sus atributos correspondientes y le ayudan en su deseo de traspasar el umbral y unirse a la Divinidad. El Zohar, texto cabalístico fundacional, habla a menudo metafóricamente de la armonía de la sinfonía Divina, describiendo la música celestial creada por las sefirot y el canto de alabanzas de los ángeles a Dios. Como exploraremos, existe una correlación directa entre los cuerpos celestes y las esferas místicas del Árbol de la Vida.

Es interesante que la centralidad de la vibración y el sonido se extienda a los campos científicos de vanguardia de la física cuántica y teórica. Por supuesto, la música está fundamentalmente enraizada en la física del sonido. Los científicos estudian las propiedades de las ondas sonoras, como la frecuencia, la amplitud y la longitud de onda, para comprender cómo se producen las notas musicales y cómo las percibe el oído humano. La acústica es otra rama de la física que se ocupa específicamente del estudio del sonido y su comportamiento. Pero en la teoría de cuerdas, como explica el físico teórico y autor de varios libros sobre el tema Dr. Michio Kaku, las partículas subatómicas como los quarks y los neutrinos están formadas por diminutas cuerdas que vibran. Las distintas formas en que vibran estas cuerdas determinan qué tipo de partículas son. Las partículas son las que componen todo el Universo. «No son más que notas musicales en una diminuta goma elástica», afirma. «La física son las armonías, las armonías de las cuerdas que vibran». Las matemáticas y la música comparten un vínculo fundamental, como ya hemos visto a través de los conceptos de Pitágoras. Los intervalos, las octavas, las escalas y las armonías se rigen por proporciones. Las matemáticas desempeñan un papel fundamental en la composición de la música y, por tanto, también están vinculadas a la teoría musical. Obsérvese también que quienes destacan o tienen una afinidad natural por la música son también, a menudo, magníficos matemáticos, debido al vínculo inextricable entre ambos campos.

Así pues, encontramos a lo largo de la historia que la musica universalis representa la intersección de las matemáticas, la ciencia, la astrología, la espiritualidad y la religión. La música, en su esencia, no es más que la mezcla de diferentes sonidos para crear un todo nuevo, más complejo y bello. Estos sonidos, en su esencia, no son más que el producto de vibraciones. Pitágoras estableció la conexión entre los distintos tipos de vibraciones —y, por tanto, de sonidos— que produce cada cuerpo planetario según sus proporciones únicas u órbitas. Al fin y al cabo, fue el propio Pitágoras quien descubrió que el tono de una nota musical se corresponde directamente con la longitud de la cuerda que la produce. Las interrelaciones de estas melodías astrales se entrelazan para componer su propia música, que se cree que afecta directamente a la calidad de la vida en el plano físico aquí en la Tierra.

En el siglo xvi, el eminente astrónomo Johannes Kepler amplió este concepto intentando encontrar las medidas reales de la orquesta celeste. Especialmente fascinado por los armónicos, trató de explorar cómo se relacionaban estas armonías con el movimiento físico de los planetas. Quería vincular las órbitas individuales a las consonancias y disonancias musicales, mediante patrones y correspondencias tangibles entre las proporciones musicales y las posiciones planetarias. En su libro Harmonices Mundi (La armonía del mundo), publicado en 1619, Kepler exploró la idea de la musica universalis con gran detalle. Propuso que las relaciones entre los periodos orbitales de los planetas estaban relacionadas con intervalos musicales, lo que sugería una armonía divina en el cosmos. Al final, sin embargo, Kepler llegó a la conclusión de que la armonía de las esferas no era música que pudiera oírse, aunque sí un lenguaje que el alma sentía y comprendía de forma innata.

La astrología afirma lo mismo.

Al igual que la musica universalis y las prácticas espirituales musicales trascienden fronteras y culturas, la práctica de la astrología está muy extendida y es persistente. Sus raíces se remontan a miles de años. Los primeros indicios de ella proceden de la antigua Mesopotamia, en torno al tercer milenio a. C. Los babilonios fueron de los primeros en desarrollar un enfoque sistemático de la astrología, registrando observaciones celestes y creando el zodiaco basado en las doce constelaciones a lo largo de la eclíptica, la trayectoria lineal que sigue el Sol a través del cielo. También encontramos pruebas de prácticas astrológicas en el antiguo Egipto, China y la India, así como en las antiguas Grecia y Roma, de donde procede la práctica de la astrología helenística.

Durante la época medieval, se produjo un resurgimiento de la astrología. Entre los siglos v y xv, la astrología estuvo estrechamente vinculada a las creencias religiosas y a menudo se consideró una ciencia divina. Los astrólogos seguían los acontecimientos celestes y las posiciones planetarias como mensajes de la divinidad, y el estudio de los cielos se consideraba una forma de conocer el plan de Dios. Muchos de los textos de la época grecorromana fueron traducidos por eruditos durante la Edad de Oro islámica y luego constituyeron recursos para los astrólogos de la Europa medieval. Durante esta época, también asistimos a la aparición de la astrología médica.

En última instancia, experimentamos la astrología a través de los planetas y la música de las esferas. Como todos navegamos por las influencias celestes de los mismos planetas, todos nos enfrentamos a los mismos arquetipos. Los signos zodiacales —donde residen los planetas dentro de nuestras cartas natales individuales— solo influyen en las notas y partituras que cada planeta ha decidido encarnar por el momento. Gracias sobre todo a la influencia del signo ascendente, que determina la forma en que se dispone la partitura musical de los planetas para cada individuo, existen innumerables formas de interpretar la sinfonía única de una persona. No hay dos interpretaciones musicales iguales, aunque estén compuestas por los mismos elementos: los planetas.

La intención de este libro es venerar a cada planeta y sus maravillas únicas, permitiendo que cada una de sus melodías arquetípicas individuales se despliegue en su totalidad, al tiempo que se ilustra el papel que desempeñan en la obra magna cósmica. Comprender los temas y las funciones de cada planeta en nuestra vida nos permite entender la compleja experiencia de ser humano. Aprendiendo los tonos y frecuencias en los que vibra nuestra composición astrológica personal, podemos empezar a reconstruir nuestra propia resonancia orbital, nuestra propia musica universalis.

En mi propia práctica espiritual y astrológica, creo en tomar los conceptos abstractos y nebulosos del mundo esotérico y aplicarlos a mi vida de forma práctica y tangible. El conocimiento y la espiritualidad son elementos cruciales de la existencia humana que deberían estar al alcance de cualquiera que desee enriquecerse. Espero contribuir a facilitar tanto la accesibilidad como la aplicación práctica de la astrología, un tema que ha fascinado e influido en un número increíble de personas, culturas y sectas a lo largo del tiempo.

Los capítulos de este libro profundizarán en los arquetipos astrológicos y los temas respectivos de cada planeta, incluyendo su contexto histórico y sus símbolos. Cada capítulo incluirá también una sección sobre las asociaciones de cada planeta (días de la semana, colores, flora y fauna, etc.) y un pequeño tutorial para trabajar con el planeta: un poco de magia astrológica, por así decirlo. Los capítulos concluirán con algunos ejercicios e interrogantes reflexivos o creativos, además de ofrecer varias piezas musicales, para dotar a este libro de su propia musica universalis. Espero que dediques tiempo a escucharlas cuando explores los distintos planetas y sus energías para aprovechar el poder sagrado del sonido en tu propio viaje. Si escuchas y te comprometes realmente con la música incluida en este libro, podrás cultivar una experiencia tangible y directa de la naturaleza de cada planeta y del libro en su conjunto. No hay nada más esencial para comprender la astrología y cómo se manifiesta en nuestras vidas individuales que las experiencias de primera mano. A medida que avances por la lista de reproducción del libro, observa dónde sientes la música en tu cuerpo. ¿Cómo te hace sentir? ¿Hay determinadas canciones que te gusten más? Quizá ese planeta desempeñe o pueda desempeñar un papel importante en tu viaje.

Espero sinceramente que, al familiarizarte con el timbre único de cada planeta, puedas comprender mejor la canción compuesta de forma única que representa tu alma individual.

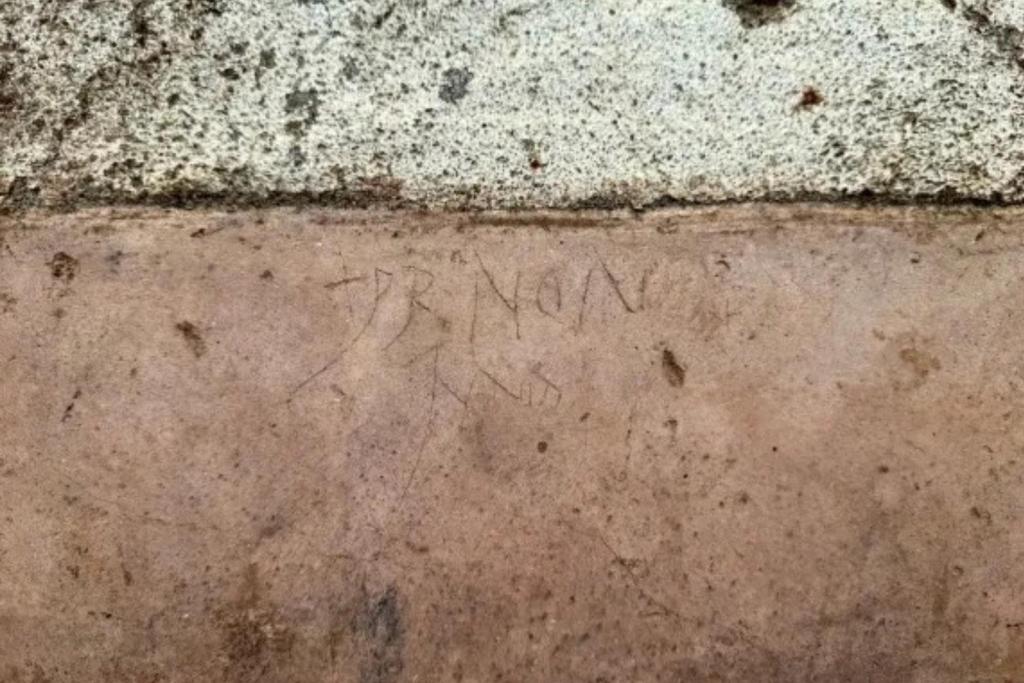

Los arqueólogos del Parque Arqueológico de Pompeya han descubierto algo tan mundano como profundamente revelador: un banco. Pero no cualquier banco. Se trata de una panca de espera de hace dos milenios, situada frente a la entrada principal de la icónica Villa dei Misteri (Villa de los Misterios), una de las residencias más célebres de la antigua ciudad romana. Este hallazgo, aparentemente humilde, abre una ventana insospechada al funcionamiento cotidiano de la sociedad romana y a las jerarquías sociales que estructuraban su vida diaria.

La Villa de los Misterios, famosa por sus enigmáticos frescos dionisíacos, fue redescubierta en el siglo XX, y desde entonces ha sido objeto de fascinación. Pero ahora, gracias a las excavaciones más recientes —activadas tras la demolición de construcciones ilegales en la zona— se han desvelado elementos inéditos del complejo residencial, incluido su acceso monumental y, justo enfrente, una estructura de cocciopesto que funcionaba como banco de espera.

Este banco no estaba pensado para el descanso de caminantes o turistas, sino para quienes acudían con la esperanza de ser recibidos por el dueño de la casa. En el mundo romano, ese encuentro no era una cuestión menor: implicaba posicionarse dentro de una red de dependencia política, económica y social. Lo que hoy llamaríamos “hacer lobby”, entonces era parte de un ritual cotidiano, conocido como salutatio, mediante el cual los ciudadanos de clase inferior acudían a la domus de un personaje influyente para pedir favores, recomendaciones o ayudas.

Una fila de hace 2.000 años

La escena es fácil de imaginar: al amanecer, hombres de distintos orígenes sociales se agrupaban frente a la puerta de la villa, esperando su turno para presentar una solicitud al dominus. Algunos eran clientes, otros simplemente jornaleros, mendigos o viajeros. A veces eran atendidos, otras no. La decisión era del patrón, que podía no presentarse o alegar cualquier motivo para no recibir a nadie ese día. Y mientras tanto, la espera. Larga, incierta, a la intemperie.

Es en este contexto donde adquiere pleno sentido la existencia de esta panca, excavada en la vía pública, justo frente al portón arqueado que marcaba la entrada principal a la Villa de los Misterios. Un elemento funcional, pero también cargado de simbolismo: cuanto más gente se sentaba fuera esperando, mayor era el prestigio del propietario. La fila era un espectáculo de poder.

El banco no estaba solo. En el muro que lo acompañaba han aparecido inscripciones hechas probablemente con carbón o algún objeto punzante. Entre ellas, una fecha (aunque sin año) y lo que parece ser un nombre. Vestigios de aburrimiento, de espera, de humanidad. Una especie de “aquí estuve” de otro tiempo. El equivalente romano de los garabatos en las paredes del metro o los baños públicos actuales, que nos recuerdan que la impaciencia y la necesidad de dejar huella no son fenómenos modernos.

Lo que no se ve desde los frescos

La Villa dei Misteri, construida en las afueras de Pompeya, no sufrió graves daños durante la erupción del Vesubio en el año 79 d.C. Su conservación excepcional ha permitido disfrutar de espacios únicos, como las salas decoradas con frescos del llamado segundo estilo pompeyano. Sin embargo, el banco de espera hallado recientemente nos muestra el otro lado de esta arquitectura de élite: el lugar desde donde la mayoría jamás pasaría al interior.

Es fácil dejarse deslumbrar por las pinturas que adornaban los espacios internos, pero resulta más complejo detenerse a pensar en quienes jamás accedieron a ellos. Este banco representa a esa otra Pompeya invisible: la que no dejó mansiones, sino trazos anónimos en los muros exteriores.

Además del banco, los recientes trabajos arqueológicos han revelado un sistema hidráulico con cisterna, nuevos ambientes decorados y, quizás lo más prometedor, restos aún por excavar del llamado quartiere servile, es decir, los espacios destinados al servicio y a los esclavos. La arqueología se acerca así a una visión más completa y menos idealizada de la vida en la villa romana: no solo sus lujos, sino también sus tensiones sociales y laborales.

Este descubrimiento ha sido posible gracias a un proyecto de recuperación que va mucho más allá de la investigación histórica. Durante años, edificaciones ilegales —incluso una estructura dedicada a la restauración— se erigieron sobre o junto a los restos de la Villa dei Misteri, dificultando no solo la investigación arqueológica, sino también la correcta conservación y fruición del sitio.

Gracias a un acuerdo entre el Parque Arqueológico de Pompeya y la Fiscalía de Torre Annunziata, dichas construcciones han sido demolidas y la zona ha vuelto a ser accesible. El proyecto tiene un doble objetivo: continuar con la excavación científica de la villa y colaborar con la justicia en la documentación de los daños provocados por actividades ilícitas, incluyendo excavaciones clandestinas.

Este modelo de “arqueología circular”, como lo denomina el parque, busca integrar conservación, legalidad, investigación y acceso público. Porque excavar Pompeya hoy no es solo una cuestión de interés científico, sino también una herramienta de protección del patrimonio ante amenazas modernas.

Pompeya, entre el turismo y la historia social

Que este hallazgo se haya producido en la Villa de los Misterios no es casual. Esta domus, célebre por sus pinturas de iniciación dionisíaca, ha sido durante décadas una de las más visitadas de Pompeya. Pero el banco descubierto nos lleva a un terreno menos conocido: el de la espera, el anonimato, el sistema de clientelismo que organizaba la sociedad romana.

La arqueología de lo cotidiano, de lo marginal, está cobrando cada vez más fuerza. Y Pompeya, con su excepcional nivel de conservación, se ha convertido en el mejor laboratorio para explorar esas otras narrativas que complementan —y a veces contradicen— la visión tradicional del mundo clásico.

Con este banco, podemos imaginar a quienes llegaban desde Boscoreale, la ciudad vecina, caminando por la Via Superior, sin saber si ese día tendrían suerte o no. Podemos verlos sentados, cansados, quizás desanimados, quizás esperanzados. Y podemos leer en esos graffiti no solo palabras, sino emociones.

Lo que viene: más excavaciones, más preguntas

Los trabajos arqueológicos continúan. El objetivo es llegar al fondo del complejo y revelar las partes aún ocultas, en especial aquellas vinculadas al servicio doméstico. Y mientras tanto, el Parque Arqueológico de Pompeya ha abierto una convocatoria de patrocinio para atraer financiación privada que permita proseguir con el proyecto.

Pompeya sigue hablando. Ya no solo a través de sus grandes frescos o de sus estructuras imponentes, sino también con gestos mínimos: una panca de espera, un nombre garabateado en la pared, una historia que, dos mil años después, aún resuena.

La historia comienza en un campo recién arado en la campiña de Dorset, al suroeste de Inglaterra. Un lugar aparentemente anodino, sin monumentos conocidos, sin yacimientos señalados y, según los mapas históricos, alejado de las grandes vías romanas que vertebraban la provincia de Britannia. Sin embargo, fue allí donde Martin Williams —un detectorista amateur con apenas cuatro años de experiencia— tropezó con lo que en un principio creyó que era un juguete infantil de metal.

Lo curioso es que no era una suposición descabellada: en la misma zona había encontrado recientemente coches de juguete de mediados del siglo XX. Pero lo que acababa de sacar de la tierra no era ni mucho menos un objeto moderno. A simple vista, parecía una chapita sin valor. Tenía una bisagra en la parte trasera y un diseño tan sencillo que no invitaba al entusiasmo. Williams, sin pensárselo dos veces, lo arrojó a su bolsa de restos metálicos, la misma en la que terminan clavos oxidados, grapas y otros descartes sin aparente interés.

No fue hasta que llegó a casa y limpió con cuidado aquella pieza que el brillo del bronce y los detalles grabados en la superficie revelaron una realidad muy distinta. Lo que tenía entre manos era un broche romano de entre 1.800 y 2.000 años de antigüedad. Un objeto que, probablemente, fue usado para sujetar una capa o una túnica en los siglos en que Roma dominaba las islas británicas. Un fragmento olvidado del pasado que, por poco, termina entre la basura.

Un diseño poco común para una región periférica

Lo que hace especialmente interesante este broche no es solo su datación, sino su rareza. En la región de Dorset no se suelen encontrar objetos de este tipo. Aunque el sur de Inglaterra vivió una romanización intensa tras la conquista iniciada en el año 43 d.C., los tipos de broches más comunes allí eran más toscos y funcionales. El hallado por Williams posee detalles ornamentales que lo acercan más a modelos utilizados en zonas más romanizadas, como la Galia o la propia Roma.

Esta diferencia en el estilo plantea interrogantes sobre su origen. ¿Fue traído por un viajero desde tierras lejanas? ¿Perteneció a un ciudadano romano acomodado que se desplazó hasta esta zona más remota del imperio? ¿O quizá se trataba de un objeto de lujo adquirido a través del comercio o el pillaje? A falta de respuestas definitivas, lo que está claro es que este broche arroja nueva luz sobre la diversidad de influencias culturales que podían encontrarse incluso en regiones aparentemente marginales del Imperio Romano.

La hipótesis más sugerente es que podría haber sido propiedad de un individuo en tránsito, tal vez un militar, un funcionario o incluso un comerciante que se desplazaba entre distintas villas romanas o centros de culto. De hecho, en las cercanías del campo donde fue hallado se sospecha que pudo existir una pequeña iglesia medieval erigida sobre un asentamiento más antiguo, lo que refuerza la idea de un uso continuado del territorio desde la Antigüedad.

Una afición que conecta con la Historia

Lo extraordinario del caso es que este tipo de descubrimientos ya no son tan raros en Reino Unido, donde el detectorismo se ha convertido en una actividad en auge. Lejos de la imagen romántica del aventurero solitario, hoy existen comunidades enteras de detectoristas organizados, con formación en arqueología básica y protocolos de actuación bien definidos. Gracias a ellos, cada año se reportan más de mil hallazgos que entran en la categoría legal de "tesoro", una clasificación reservada para objetos antiguos que contengan metales preciosos o que superen los 300 años de antigüedad.

El broche hallado en Dorset no está hecho de oro ni plata, pero sí de bronce y, por su datación y rareza, podría ser considerado un objeto de interés histórico. De momento, se encuentra en proceso de evaluación por parte de los especialistas, que determinarán si debe ser adquirido por un museo o devuelto al descubridor.

Para Williams, que ya ha encontrado más de 30 cofres repletos de objetos antiguos en apenas cuatro años, lo más valioso del hallazgo no es su posible valor económico, sino la conexión con la historia que proporciona. En un país donde las capas del pasado se superponen unas sobre otras en casi cada metro cuadrado de tierra cultivada, cada descubrimiento, por pequeño que sea, ayuda a recomponer el puzzle de la historia británica.

Tesoros escondidos bajo nuestros pies

El caso del broche romano vuelve a poner sobre la mesa el enorme potencial arqueológico que permanece oculto en los campos británicos. No hablamos únicamente de grandes villas romanas o enterramientos monumentales, sino de objetos cotidianos, muchas veces modestos, que ofrecen una mirada directa al día a día de quienes habitaron estas tierras siglos atrás.

Entre los hallazgos más notables de los últimos años se encuentran tesoros como el conjunto de 2.584 monedas de plata de época normanda valorado en más de cinco millones de dólares, o los espectaculares cascos y espadas romanas descubiertos en Leicestershire. Estos descubrimientos, casi siempre realizados por aficionados, han contribuido de forma decisiva a ampliar el conocimiento histórico del país y a nutrir colecciones de museos como el British Museum.

La legislación británica, relativamente flexible en comparación con otros países europeos, fomenta esta colaboración entre particulares y arqueólogos. A cambio de seguir unas normas básicas y notificar los hallazgos, los detectoristas pueden incluso recibir compensaciones económicas cuando los objetos son adquiridos por instituciones públicas.

El objeto que casi se pierde para siempre

Lo más sorprendente de esta historia no es tanto el valor del broche como el hecho de que, de no haber sido por un golpe de suerte, habría acabado olvidado entre un montón de residuos metálicos. Una ironía cruel para un objeto que ha sobrevivido dos milenios bajo tierra.

Ese pequeño trozo de bronce, testigo de otra época, nos recuerda que el pasado está mucho más cerca de lo que pensamos. Puede dormir bajo nuestros pies, camuflado entre raíces y piedras, esperando a que alguien —con paciencia, suerte y una pizca de intuición— lo devuelva a la luz.

En la confluencia entre la biología, la arqueología y la historia cultural, un descubrimiento reciente ha situado a una especie de buitre en el centro de una investigación sin precedentes. El quebrantahuesos (Gypaetus barbatus) ha demostrado ser mucho más que un simple carroñero. Un equipo interdisciplinar de investigadores españoles ha documentado que, a lo largo de los siglos, estas aves han acumulado en sus nidos no solo los restos óseos propios de su dieta, sino también objetos fabricados por el ser humano. Así, los nidos del quebrantahuesos han demostrado ser verdaderas cápsulas del tiempo, auténticos museos naturales capaces de conservar piezas de valor arqueológico durante centenares de años.

El quebrantahuesos, una especie en riesgo

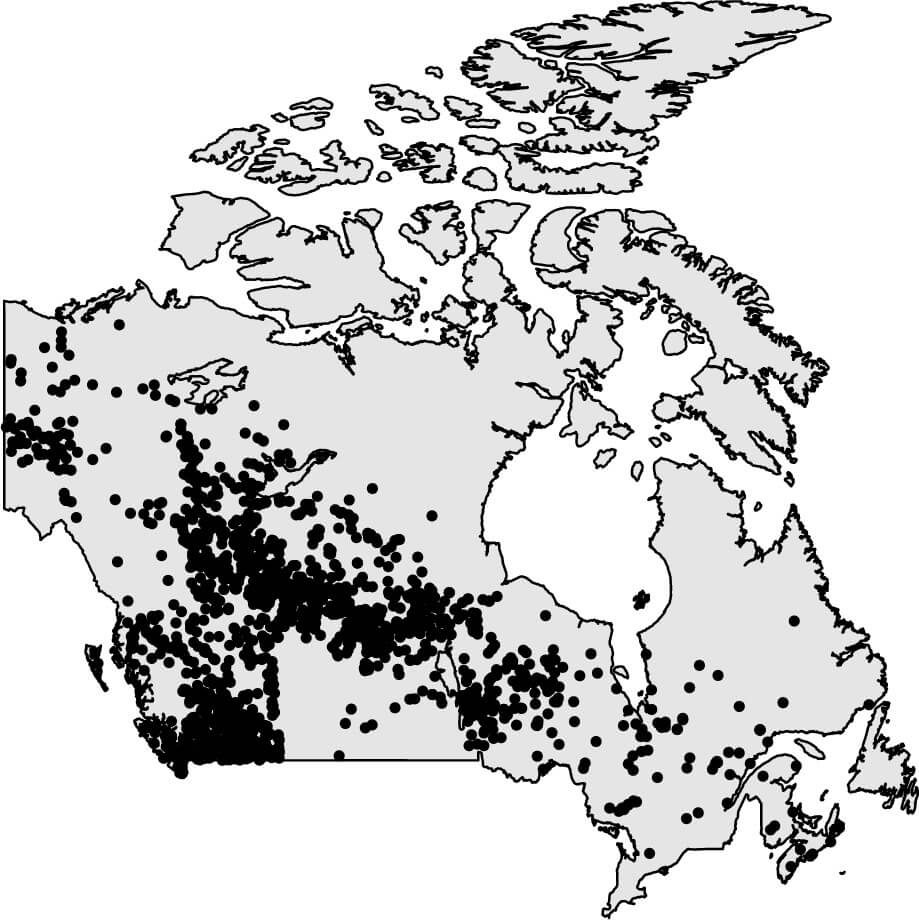

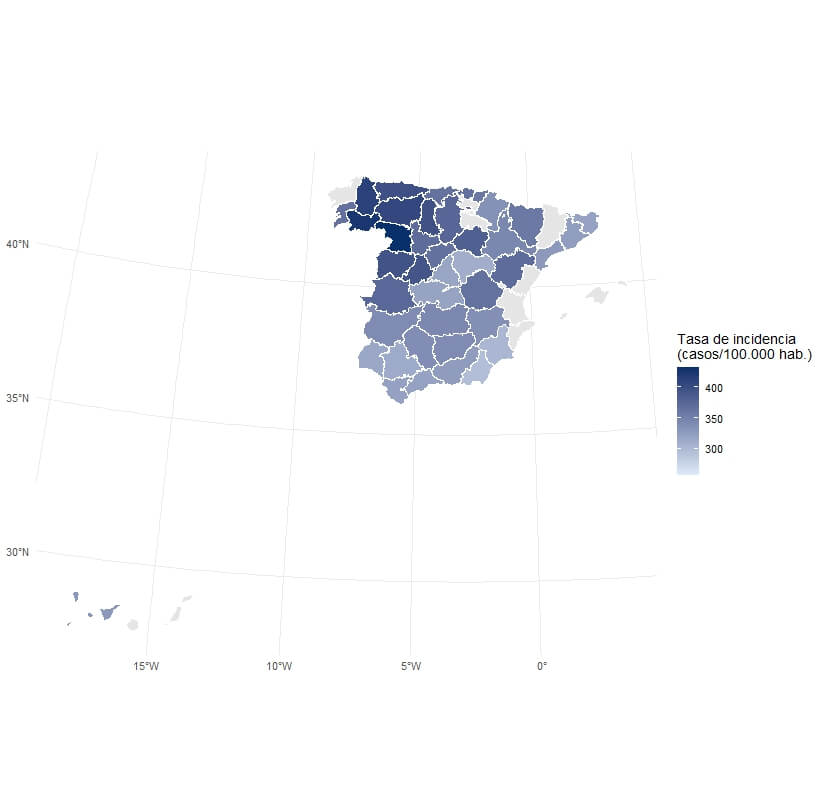

El quebrantahuesos es la especie de buitre más amenazada de Europa. Cuenta con apenas 309 parejas reproductoras censadas en 2025, de las cuales 144 se concentran en los Pirineos. Durante el siglo XIX, su distribución geográfica era mucho más amplia, pues su presencia se extendía por todas las cordilleras de la península ibérica.

La particular biología del quebrantahuesos, caracterizada por el anidamiento en las cuevas y oquedades de los acantilados, ha favorecido que sus nidos se conserven durante siglos. Allí, tanto los huesos acumulados para alimentar a las crías como los materiales utilizados en la construcción de los nidos han permanecido protegidos por las condiciones microclimáticas estables de baja humedad y temperatura moderada.

Este hábito ha transformado los nidos en depósitos excepcionales para los investigadores. De este modo, lo que parecía un simple refugio aviar se ha convertido en un archivo ecológico y cultural capaz de conectar pasado y presente.

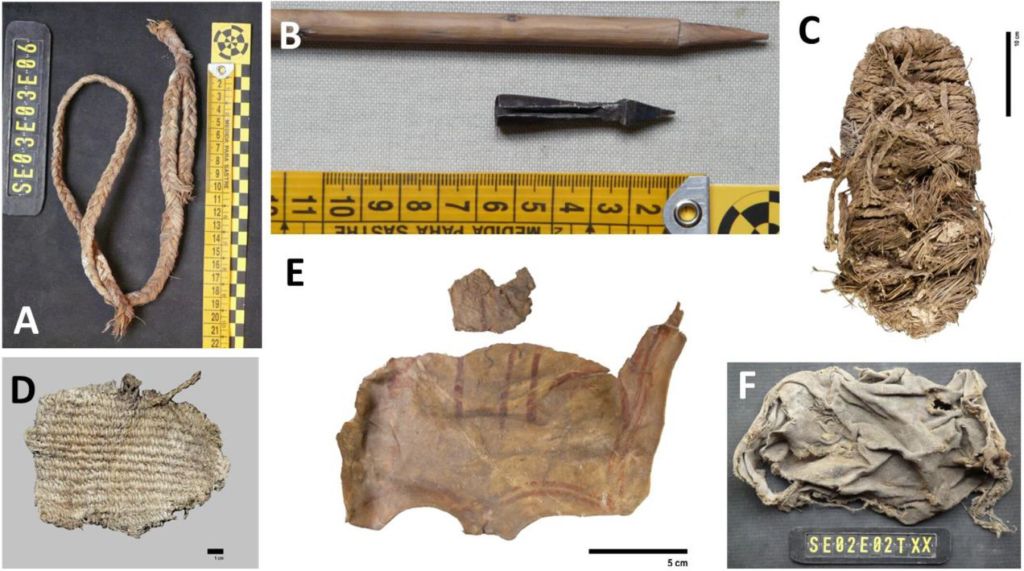

La investigación: un "museo" arqueológico en los nidos

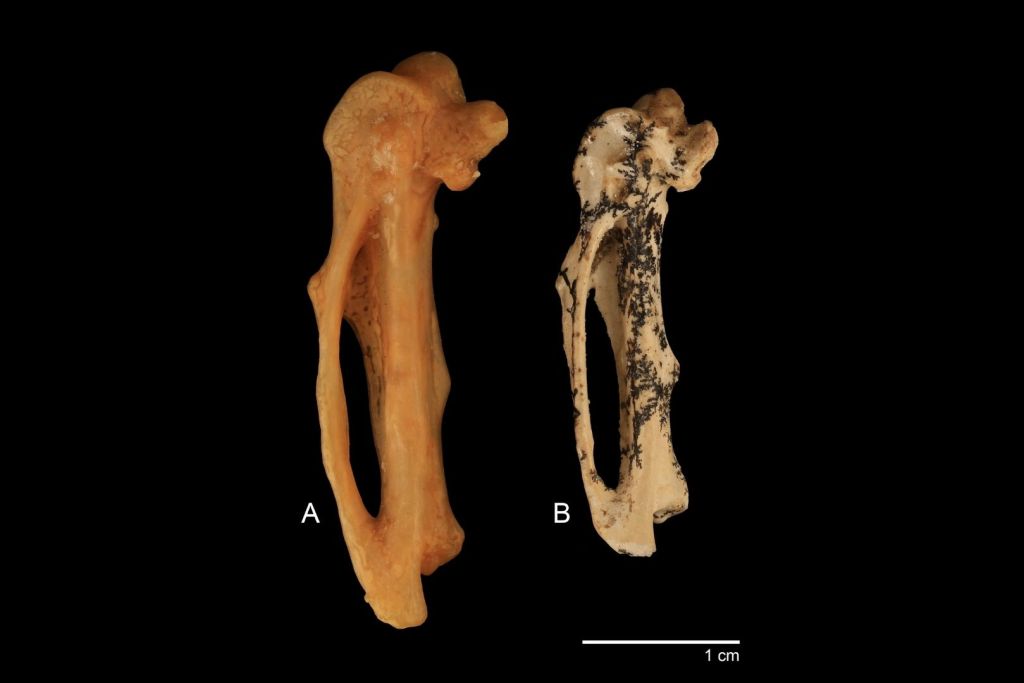

Entre 2008 y 2014, un equipo liderado por Antoni Margalida y Ana B. Marín-Arroyo examinó 12 nidos antiguos de quebrantahuesos en Andalucía y Castilla-La Mancha, dos regiones donde la especie se extinguió hace décadas. Aplicando métodos estratigráficos propios de la arqueología y el análisis de radiocarbono (C-14), los científicos recuperaron un total de 2483 restos. De ellos, 2117 correspondían a huesos de ungulados y otros animales, un reflejo directo de la dieta del ave, mientras que 226 piezas eran de origen humano, confeccionadas con esparto, cuero, fibras vegetales o tela.

El hallazgo de objetos manufacturados confirma que los quebrantahuesos también recogían y reutilizaban materiales fabricados por humanos, quizá para cubrir los nidos o reforzarlos. En algunos casos, las aves incluso incorporaron elementos militares, como una punta de ballesta hallada en uno de los nidos, que quizás se utilizó en sustitución de una rama.

Objetos medievales y modernos entre los restos

Entre los objetos más llamativos encontrados en los nidos, destacan las sandalias de esparto conocidas como agovías, similares a las alpargatas. El ejemplar de este calzado, de uso popular en la península ibérica durante la Edad Media, se ha datado en 674 ± 22 años antes del presente, es decir, hacia finales del siglo XIII. Otro fragmento de cuero ovino pintado con ocre se fechó en torno al mismo periodo, 651 ± 22 años antes del presente.

En contraste, otros restos eran mucho más recientes, como un fragmento de cestería datado en 151 ± 22 años antes del presente, lo que lo sitúa en el tránsito del siglo XVIII al XIX. Estas dataciones ponen de manifiesto que algunos nidos se utilizaron durante varios siglos. Por tanto, acumularon capas de materiales que hoy permiten reconstruir la historia tanto natural como humana de estas montañas.

Los nidos como museos naturales

El valor científico de este descubrimiento radica en que los nidos de quebrantahuesos funcionan como museos naturales, donde se preservan restos arqueológicos en condiciones excepcionales. Los objetos recuperados hasta el momento han aportado información relevante sobre la vida cotidiana, las técnicas artesanales y la economía de las comunidades rurales que habitaron las sierras del sur de España desde la Edad Media.

Del mismo modo, el análisis de los huesos de animales presentes en los nidos ha proporcionado nuevos datos sobre la fauna salvaje y doméstica que coexistía en estos entornos. Cabras, ovejas y otros ungulados aparecen representados de forma abundante, lo que permite rastrear cambios en la ganadería y en la caza a lo largo de los siglos.

Una nueva herramienta para la arqueología y la ecología

Los autores del estudio destacan que los quebrantahuesos deben considerarse agentes tafonómicos de gran relevancia, capaces de acumular huesos y objetos humanos de forma comparable a otros procesos naturales o culturales que generan depósitos arqueológicos. Esto abre nuevas vías de investigación, ya que estudiar los nidos puede ofrecer perspectivas renovadas sobre la interacción entre humanos, animales y medio ambiente en épocas pasadas.

En términos ecológicos, los nidos antiguos permiten analizar la dieta de la especie a lo largo del tiempo y, en consecuencia, reconstruir los cambios en los ecosistemas de montaña. También se convierten en un recurso clave para los programas de conservación, que buscan comprender las causas de la desaparición del quebrantahuesos en buena parte de Europa y orientar los proyectos de reintroducción de la especie.

Un cruce entre biología y cultura

El estudio muestra hasta qué punto las aves pueden convertirse en guardianas involuntarias de la memoria humana. El hecho de que un buitre acumule calzado, cestos o fragmentos de cuero durante siglos ilustra la profunda imbricación entre la vida silvestre y las actividades humanas. Los investigadores han señalado que, en el futuro, sería útil aplicar esta metodología de estudio a otras especies acumuladoras, como el alimoche (Neophron percnopterus), para comprobar en qué medida los nidos de rapaces pueden funcionar como archivos históricos.

El quebrantahuesos, un testimonio de la cultura material del pasado

Los nidos de quebrantahuesos del sur de España revelan un sorprendente legado arqueológico que une la biología de una especie amenazada con la historia cultural de las comunidades humanas que habitaron las montañas ibéricas durante siglos. Estos nidos se han convertido en involuntarias cápsulas del tiempo que guardan fragmentos de la vida cotidiana, la tecnología artesanal y las huellas del medio ambiente medieval y moderno.

Este hallazgo redefine la manera en que comprendemos la relación entre humanos y fauna salvaje. En la figura del quebrantahuesos se encarna un arqueólogo de la naturaleza, capaz de preservar en lo alto de los riscos un registro material que hoy resulta de gran significado para la ciencia.

Referencias

- Margalida, Antoni, et al. 2025. "The Bearded Vulture as an accumulator of historical remains: Insights for future ecological and biocultural studies". Ecology, 106.9: e70191. DOI: https://doi.org/10.1002/ecy.70191

Era una mañana cualquiera de finales de septiembre de 1928 cuando Alexander Fleming regresó a su laboratorio del Hospital St. Mary’s, en Londres, tras unas vacaciones. Su pequeño espacio de trabajo, apenas mayor que un cuarto de escobas, estaba desordenado como de costumbre. Las placas de cultivo, utilizadas para estudiar bacterias comunes como Staphylococcus aureus, se apilaban por decenas sobre la mesa. En medio del caos, una en particular llamó su atención: un círculo de moho había crecido sobre una de las placas, y en torno a él, sorprendentemente, no había rastro de bacterias vivas.

Lo que para otros habría sido motivo de limpieza inmediata, para Fleming fue una anomalía interesante. El moho, que luego sería identificado como Penicillium notatum, parecía tener la capacidad de eliminar bacterias. No estaba buscando una medicina, ni mucho menos una revolución terapéutica. Simplemente observó algo curioso, y decidió investigarlo. Sin saberlo, acababa de abrir la puerta a una nueva era: la de los antibióticos.

La ciencia del accidente

Fleming no fue un químico, ni un especialista en síntesis de medicamentos. Su papel fue esencialmente el de un observador perspicaz que no descartó lo inesperado. Pero tras su hallazgo inicial, su descubrimiento quedó prácticamente olvidado durante una década. La comunidad médica, poco impresionada, no supo ver el potencial de esa “sustancia antibacteriana” que salía del moho.

Fue en 1939 cuando un grupo de investigadores de la Universidad de Oxford retomó la investigación. Liderados por Howard Florey y Ernst Chain, y con el trabajo técnico del bioquímico Norman Heatley, lograron algo que Fleming no había conseguido: aislar, purificar y producir el compuesto en cantidades suficientes para probarlo en seres humanos. El resultado fue inmediato y asombroso: las infecciones bacterianas que antes llevaban inevitablemente a la amputación o la muerte comenzaron a ceder ante una pequeña dosis de penicilina.

En ese momento, se confirmó que no se trataba simplemente de un compuesto curioso. Era una herramienta terapéutica con un potencial inmenso.

De los ratones al campo de batalla

Los primeros ensayos con animales, realizados durante la Segunda Guerra Mundial, demostraron que la penicilina podía detener infecciones que hasta entonces eran letales. Sin embargo, la producción era un desafío titánico. Obtener una cantidad suficiente de penicilina requería miles de litros de caldo de cultivo. El hongo original, P. notatum, no era lo suficientemente eficiente para producir el antibiótico en grandes cantidades.

La situación cambió gracias a una anécdota que parece sacada de una novela: una asistente de laboratorio llevó una cantalupa cubierta de moho al laboratorio de Peoria, Illinois, donde científicos americanos trabajaban para mejorar la producción. Aquel hongo, Penicillium chrysogenum, resultó ser cientos de veces más productivo que el original. Con ayuda de rayos X y técnicas de mutación, los investigadores lograron cepas capaces de generar penicilina en cantidades suficientes para iniciar una producción industrial. Era el inicio de la farmacología moderna.

En los hospitales de campaña de la Segunda Guerra Mundial, la penicilina salvó miles de vidas. Ya no era necesario amputar brazos o piernas ante una simple infección. Las tasas de mortalidad por heridas de guerra se redujeron drásticamente. En los años siguientes, las industrias farmacéuticas expandieron su producción a escala mundial. Lo que nació por accidente acabó siendo la base de un nuevo arsenal médico.

El auge… y las primeras señales de alarma

Para 1945, la penicilina ya se distribuía masivamente en Estados Unidos y Europa. Fleming, Florey y Chain compartieron ese mismo año el Premio Nobel de Medicina por su contribución conjunta. Sin embargo, la historia tenía una cara menos visible: el propio Fleming comenzó a advertir sobre un fenómeno inquietante. El uso indiscriminado del antibiótico podría llevar a la aparición de bacterias resistentes.

Y así fue. La penicilina, que en un principio parecía una “bala mágica”, empezó a perder eficacia en algunos casos. Las bacterias, en su incansable capacidad de adaptación, comenzaron a desarrollar mecanismos de defensa. El fenómeno, conocido hoy como resistencia antimicrobiana, se convirtió con el tiempo en uno de los mayores desafíos de la medicina moderna.

Lejos de ser un fracaso, el declive parcial de la penicilina obligó a los científicos a buscar nuevas moléculas, inaugurando una época de oro en la investigación de antibióticos. Durante las décadas siguientes se desarrollaron decenas de variantes y nuevas clases de fármacos: tetraciclinas, estreptomicina, eritromicina y más. Muchas de ellas provenían de un origen natural similar: hongos, bacterias del suelo y microorganismos que llevaban millones de años luchando entre sí mediante armas químicas.

Un legado más allá del laboratorio

Hoy, a casi un siglo del descubrimiento de la penicilina, su legado sigue vivo. Estimaciones conservadoras calculan que este antibiótico y sus derivados han salvado más de 500 millones de vidas. Pero su impacto va más allá de la medicina: transformó la forma en que las sociedades entienden la salud, aceleró el desarrollo de la cirugía moderna, hizo posible el tratamiento de enfermedades infecciosas que antes eran mortales, y consolidó la investigación científica como una herramienta directa de progreso humano.

Paradójicamente, el descubrimiento de Fleming también fue el inicio de una carrera contra el tiempo. A medida que la resistencia bacteriana avanza, la ciencia debe reinventarse para mantener la ventaja. Hoy, investigadores recurren a tecnologías genéticas como CRISPR, o incluso a virus bacteriófagos, para encontrar nuevas formas de lucha contra los microorganismos. La penicilina abrió esa puerta. Y aunque su eficacia ya no es universal, su papel en la historia de la humanidad permanece incuestionable.

Lo que comenzó como un descuido, una placa olvidada en un rincón de un laboratorio, terminó reescribiendo las reglas del juego. El 28 de septiembre de 1928 no fue solo un día más para Alexander Fleming. Fue el día en que, sin saberlo, cambió el destino de la medicina moderna.

Referencias

- Clardy J, Fischbach MA, Currie CR. The natural history of antibiotics. Curr Biol. 2009;19(11):R437-R441. doi:10.1016/j.cub.2009.04.001

En un rincón remoto de la Patagonia argentina, un equipo de paleontólogos ha encontrado algo extraordinario: los restos fósiles de un dinosaurio carnívoro desconocido hasta ahora, con el hueso de un cocodrilo aún atrapado entre sus mandíbulas. El hallazgo, publicado recientemente en la revista Nature Communications, no solo revela una nueva especie de megaraptor sino también uno de los pocos ejemplos documentados de un dinosaurio fosilizado en pleno acto de alimentación.

Bautizado Joaquinraptor casali, este nuevo dinosaurio vivió hace aproximadamente 67 millones de años, en los últimos compases del Cretácico, justo antes del impacto que acabó con los dinosaurios no avianos. El ejemplar, excavado en la Formación Lago Colhué Huapi de la provincia de Chubut, en el corazón de la Patagonia, representa una de las especies más recientes y mejor conservadas de este grupo de depredadores.

El "rey del sur"

Mientras Tyrannosaurus rex dominaba el hemisferio norte, en Sudamérica el trono del depredador alfa lo ocupaban los megaraptores. Pero hasta ahora, la mayoría de los fósiles conocidos eran fragmentarios, escasos y difíciles de interpretar. Joaquinraptor casali cambia radicalmente ese panorama.

Los restos, que incluyen buena parte del cráneo, las mandíbulas, brazos, costillas, vértebras y extremidades, ofrecen una imagen mucho más completa de cómo era este carnívoro. Medía unos siete metros de largo y pesaba más de una tonelada. A diferencia del icónico T. rex, sus brazos eran largos, musculosos y terminaban en garras curvadas y afiladas como cuchillas. Un arma letal para cazar, desgarrar y manipular presas.

La forma del cráneo era alargada y ligera, y sus dientes, aunque pequeños para su tamaño, estaban adaptados para realizar cortes precisos más que para triturar huesos. Una adaptación evolutiva que le permitía cazar de forma veloz y letal, más como un cirujano que como un demoledor.

Un fósil congelado en acción

Lo que convierte a este fósil en una pieza única es lo que se encontró entre sus mandíbulas: el hueso del brazo de un cocodrilo prehistórico. Literalmente, el depredador murió con su comida aún en la boca.

Este tipo de evidencia directa de comportamiento es extremadamente rara en el registro fósil. Aunque los dientes afilados de los megaraptores ya sugerían una dieta carnívora, encontrar restos de una presa exactamente en el lugar donde estarían en vida es un golpe de suerte inusual. El hueso, un húmero de un cocodrilo primitivo, se encontraba encajado entre los dentarios del Joaquinraptor. Todo indica que estaba en plena comida cuando murió, quizá de forma repentina.

Los investigadores han considerado diversas posibilidades: ¿fue un atragantamiento?, ¿murió cazando?, ¿fue una lucha entre depredadores? Aunque no pueden descartarse otras explicaciones, el hecho de que el hueso esté marcado por los dientes y no se hayan hallado otros restos de cocodrilo en el entorno sugiere una escena congelada de una interacción depredador-presa. Un instante de hace 67 millones de años inmortalizado en piedra.

Un depredador ágil

Una de las lecciones más fascinantes del Joaquinraptor es cómo este animal representa una alternativa evolutiva radical al Tyrannosaurus rex. Donde el tiranosaurio era robusto, con un cráneo macizo y dientes capaces de romper huesos, el megaraptor era esbelto, rápido, con un cráneo más aerodinámico y brazos dominantes. Dos caminos distintos hacia el mismo objetivo: dominar la cima de la cadena alimenticia.