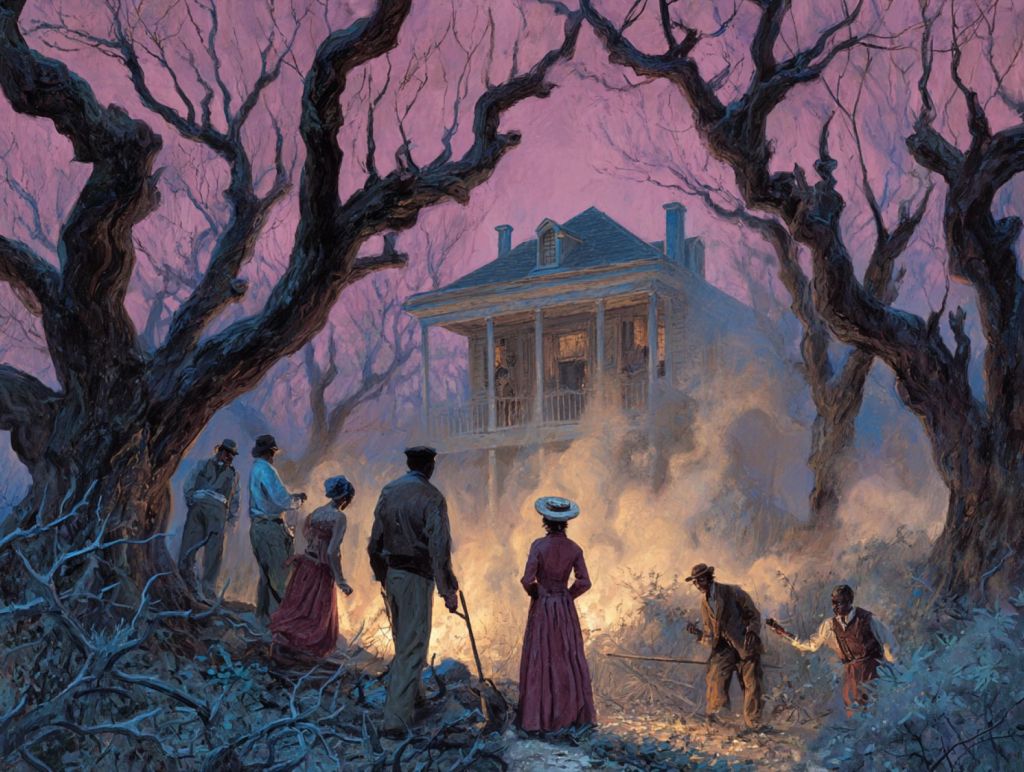

La noche del 8 de agosto de 2025, un incendio declarado en una de las capillas orientales de la Mezquita-Catedral de Córdoba volvió a situar al monumento en el centro de la atención internacional. Aunque el fuego fue controlado en poco más de una hora y los daños se han limitado a tres capillas, el suceso recuerda hasta qué punto este edificio, Patrimonio de la Humanidad, es un testigo frágil pero resistente de más de doce siglos de historia.

Más allá de la crónica inmediata del incendio, la Mezquita-Catedral es una síntesis viva de la historia de la península ibérica: un lugar donde se entrelazan las huellas del islam omeya, el cristianismo medieval y las transformaciones arquitectónicas del Renacimiento y el Barroco. Conocer su trayectoria es comprender por qué este templo es mucho más que un icono arquitectónico: es un símbolo cultural único, capaz de sobrevivir a terremotos, guerras y, como hemos visto, a las llamas.

De un emirato independiente al mayor oratorio de Occidente

La historia comienza en el siglo VIII, cuando la dinastía omeya, derrotada por los abasíes en Oriente, halló refugio en la península ibérica. En el año 785, Abderramán I ordenó la construcción de una mezquita en Córdoba que, con el tiempo, se convertiría en la más importante del Occidente musulmán. Para levantarla se reutilizaron columnas y capiteles romanos y visigodos, incorporando una de sus señas de identidad: la doble arcada con dovelas rojas y blancas.

El edificio inicial era ya un prodigio de técnica y simbolismo, pero su verdadero salto de escala llegó en el siglo X, cuando Córdoba, bajo el califato de Abderramán III y su hijo al-Hakam II, se convirtió en una de las ciudades más ricas y cultas del mundo islámico. Al-Hakam amplió el oratorio, erigió un majestuoso mihrab decorado con mosaicos dorados bizantinos y creó una macsura destinada al califa, un espacio ceremonial donde política y religión se daban la mano.

La última gran ampliación llegó a finales del siglo X con Almanzor, que extendió la mezquita hacia el este, añadiendo ocho nuevas naves y multiplicando su capacidad. Con más de 23.000 metros cuadrados, se convirtió en la segunda mezquita más grande del mundo, solo superada por la de La Meca.

Entre la cruz y la media luna

En 1236, Fernando III conquistó Córdoba y consagró el templo como iglesia cristiana. Durante décadas, las transformaciones fueron mínimas: se añadieron capillas y altares, pero se respetó la estructura islámica. La Capilla Mayor se instaló en la antigua macsura, y el mihrab se conservó como un vestigio admirado incluso por los nuevos propietarios.

A finales del siglo XIII y durante la Baja Edad Media, el edificio comenzó a acoger capillas privadas y espacios funerarios de nobles y obispos. Este diálogo arquitectónico entre el islam y el cristianismo se mantuvo relativamente armónico hasta el siglo XVI, cuando una decisión cambiaría para siempre el perfil del monumento.

El quiebre renacentista

En 1523, el obispo Alonso Manrique impulsó la construcción de una gran nave cruciforme en el corazón de la mezquita para albergar la nueva Capilla Mayor. El proyecto, que se prolongó durante más de 80 años y contó con la intervención de tres generaciones de arquitectos, supuso una ruptura radical con la disposición original del templo. La bóveda renacentista se elevó por encima de las cubiertas islámicas, alterando la percepción espacial de las arquerías.

Pese a la oposición inicial del concejo municipal y a las posteriores quejas del emperador Carlos V —quien llegó a lamentar la pérdida de la singularidad original—, la obra se completó y se convirtió en el núcleo litúrgico de la catedral. A esta transformación se sumaron la remodelación del campanario, que incorporó en su interior el antiguo alminar de Abderramán III, y la creación de un coro barroco en el siglo XVIII.

Redescubrimientos y restauraciones

El siglo XIX marcó el inicio de una nueva etapa de reconocimiento patrimonial. En 1882, la Mezquita-Catedral fue declarada Monumento Nacional, y en las décadas siguientes comenzaron campañas de restauración orientadas a recuperar sus elementos islámicos. El arquitecto Ricardo Velázquez Bosco retiró añadidos barrocos y puso en valor espacios como la Capilla de Villaviciosa.

En el siglo XX, las excavaciones dirigidas por Félix Hernández sacaron a la luz restos tardoantiguos y visigodos bajo el edificio, avivando el debate sobre el origen del solar. Más recientemente, las investigaciones arqueológicas han identificado un complejo episcopal anterior a la mezquita, con fases constructivas que se remontan a la Córdoba romana.

En 1984, la Unesco declaró la Mezquita-Catedral Patrimonio de la Humanidad, distinción ampliada a todo el centro histórico en 1994. En 2024, el monumento alcanzó su récord de visitantes con más de 2,18 millones de personas, confirmando su relevancia como uno de los principales destinos turísticos y culturales de España.

Un símbolo en constante riesgo

El incendio del 8 de agosto de 2025 no es el primero en la historia del edificio: en 1910 un cortocircuito dañó su crucero, y en 2001 otro fuego en el archivo destruyó varios documentos. Esta vez, el origen probable ha sido una barredora eléctrica en una zona de almacenamiento, y aunque la rápida intervención de los bomberos evitó daños mayores, el derrumbe del techo de la capilla de la Expectación y las pérdidas artísticas en su retablo son un recordatorio de la vulnerabilidad de este patrimonio.

La gestión del Cabildo y las medidas de seguridad, reforzadas tras el incendio de Notre Dame en 2019, han sido determinantes para evitar una tragedia mayor. La reapertura parcial al día siguiente del siniestro es prueba de la resistencia de un edificio que ha sobrevivido a guerras, cambios de culto, catástrofes naturales y al paso implacable del tiempo.

Un legado irrepetible

Hoy, la Mezquita-Catedral de Córdoba es un compendio arquitectónico único en el mundo. En sus muros conviven el arte emiral y califal, el gótico, el renacimiento y el barroco. Su bosque de columnas sigue evocando el esplendor de Al-Andalus, mientras la nave renacentista recuerda la ambición monumental de la España cristiana.

El incendio reciente no solo ha puesto de relieve la importancia de la conservación, sino también la necesidad de comprender la historia compleja de este lugar. La Mezquita-Catedral no es un vestigio estático, sino un organismo vivo que, desde hace más de mil doscientos años, se adapta, resiste y continúa inspirando a quienes cruzan sus puertas.

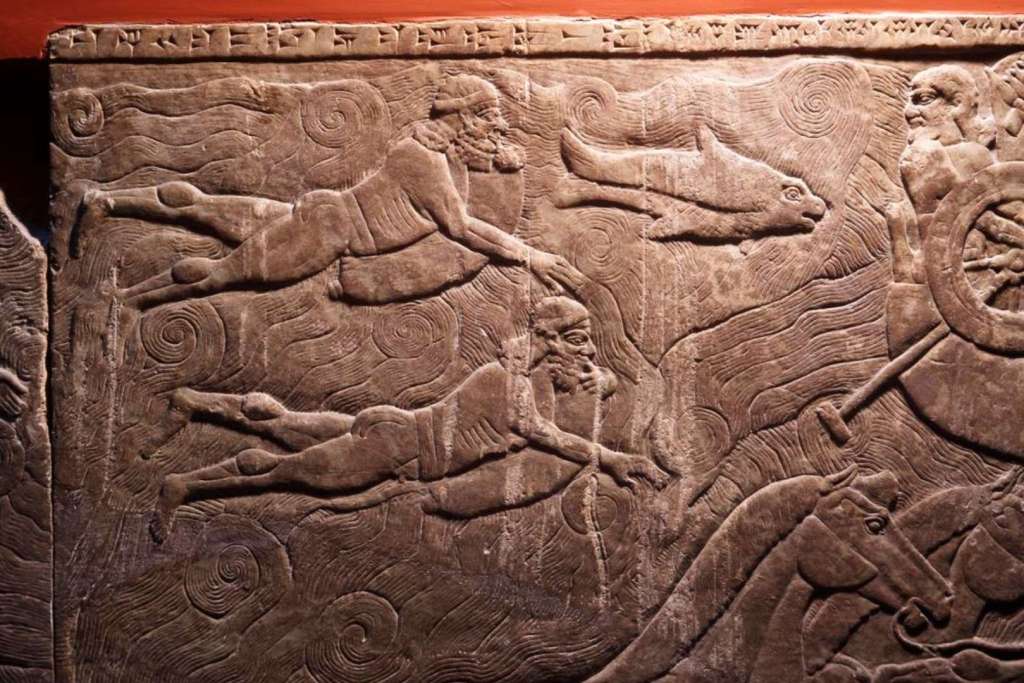

Según Homero y las reelaboraciones míticas posteriores, Eneas fue un héroe de la Guerra de Troya que, en su periplo de regreso al hogar, alcanzó las costa de Lacio. Y es, justamente, este personaje el que se ha elegido para dar nombre a una inteligencia artificial que marca un antes y un después en la investigación epigráfica. Se trata de Aeneas, una IA que no solo ayuda a restaurar textos dañados, sino que, basándose en paralelismos con otras inscripciones, también ofrece hipótesis sobre su datación y procedencia.

El valor histórico de las inscripciones romanas

El mundo romano se caracterizó, entre otras cosas, por la importancia del elemento escrito. Las inscripciones, talladas en piedra, metal o cerámica, formaron parte integral de la vida cotidiana del Imperio. Desde los decretos imperiales hasta los epitafios, estos textos constituyen una fuente esencial para conocer la historia política, social y cultural de Roma. Sin embargo, la interpretación de estas inscripciones plantea serios desafíos para los filólogos. La frecuente fragmentación de los textos, la ausencia de fechas y la vasta dispersión geográfica de la documentación epigráfica a menudo dificultan su contextualización.

La epigrafía romana nos conecta con las voces de un imperio que llegó a dominar cinco millones de kilómetros cuadrados hace más de dos mil años. Cada año se descubren unas 1.500 inscripciones latinas nuevas, lo que refleja tanto la magnitud como la riqueza de este legado. Con todo, a pesar de su abundancia, muchas inscripciones presentan lagunas. Los especialistas intentan resconstruirlas recurriendo tanto a textos paralelos como a su conocimiento del contexto histórico, lingüístico y material. Este proceso, sin embargo, es lento, exige un alto grado de especialización y depende del acceso a amplios recursos bibliográficos.

Así, la inteligencia artificial Aeneas surge como respuesta a esta necesidad histórica y metodológica. Propone un sistema que, además de automatizar parte del trabajo, también amplía la mirada del historiador mediante la detección de conexiones epigráficas menos evidentes.

¿Qué es Aeneas y qué aporta a la epigrafía?

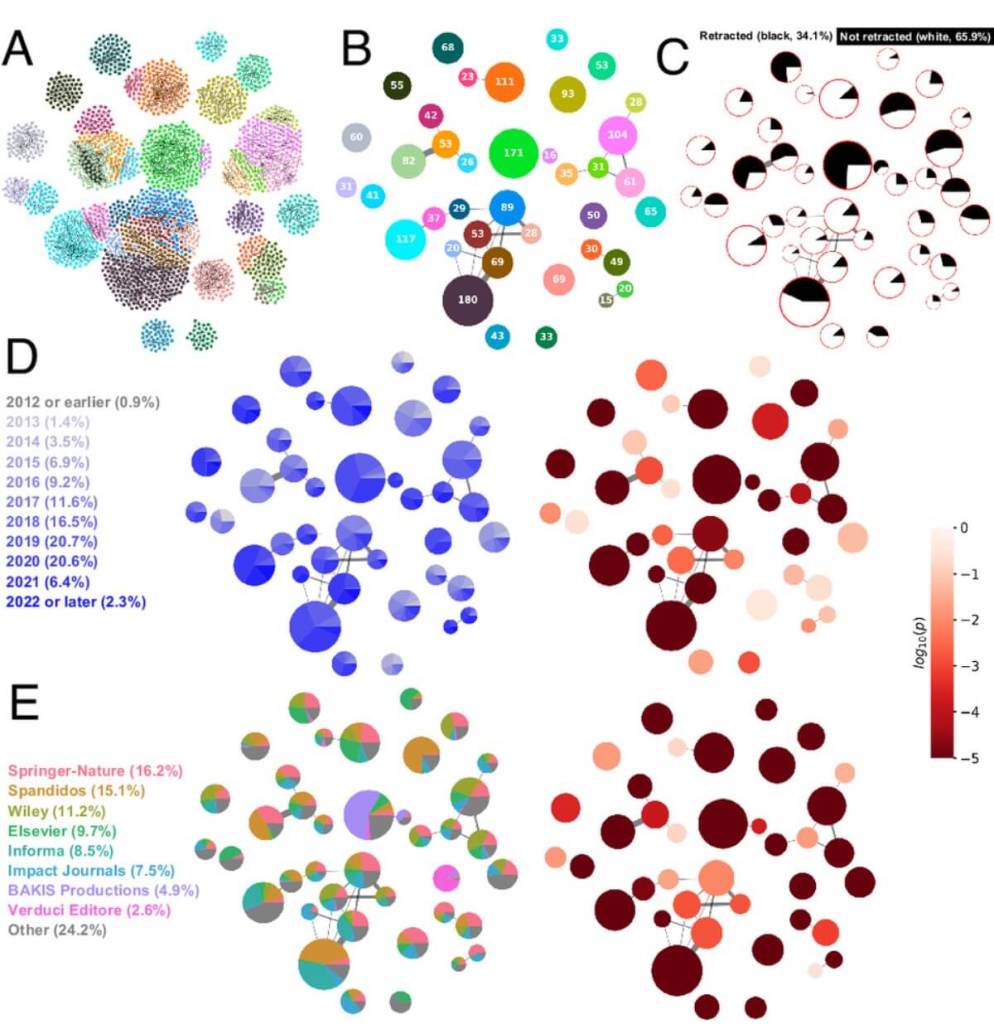

Desarrollado por un equipo internacional liderado por investigadores de DeepMind, Oxford, Nottingham y Warwick, entre otras instituciones, Aeneas es una red neuronal generativa multimodal capaz de contextualizar las inscripciones latinas antiguas. Inspirado en el héroe troyano que, guiado por los dioses, viajó haccia occidente hasta fundar el linaje que daría pie al surgimiento de Roma, el modelo Aeneas también “viaja” a través de las fuentes epigráficas para encontrar paralelos que permitan anclar un texto en su marco histórico.

Su capacidad de restaurar textos con lagunas de longitud desconocida lo convierte en un hito técnico. La aportación más revolucionaria se encuentra en su mecanismo de contextualización. Aeneas no solo busca coincidencias textuales, sino también analogías culturales, lingüísticas y cronológicas.

Una infraestructura sin precedentes: el Latin Epigraphic Dataset

Para entrenar a Aeneas, el grupo de investigación creó el Latin Epigraphic Dataset (LED), el mayor corpus digital de inscripciones latinas hasta la fecha. Este corpus reúne más de 176.000 inscripciones, datadas entre el siglo VII a.C. y el siglo VIII d.C., y procedentes de todo el mundo romano. La información se extrajo y armonizó a partir de tres bases de datos epigráficas fundamentales: la Epigraphic Database Roma, la Epigraphic Database Heidelberg y la Epigraphic Database Clauss-Slaby. Además de los textos, se integraron imágenes (disponibles para el 5% de las inscripciones), una funcionalidad que ha permitido a Aeneas combinar información visual y textual.

Aprender de los paralelos: una herramienta para el historiador

El punto fuerte de Aeneas reside en su capacidad para detectar paralelos. A diferencia de las búsquedas tradicionales, que se basan en coincidencias literales, Aeneas genera representaciones matemáticas enriquecidas con contexto histórico. Así, puede sugerir textos similares por estructura, contenido, función o estilo, aunque no compartan el vocabulario exacto.

En pruebas realizadas en colaboración con los historiadores, se demostró que los paralelos identificados por Aeneas resultaban útiles y pertinentes en el 90% de los casos. Estas conexiones no solo aumentaron la confianza de los expertos en sus hipótesis, sino que también redujeron el tiempo necesario para elaborar interpretaciones. Los estudiosos señalaron, además, que lo que antes podía requerir días de trabajo ahora puede hacerse en minutos.

La IA puesta a prueba: algunos casos de estudio

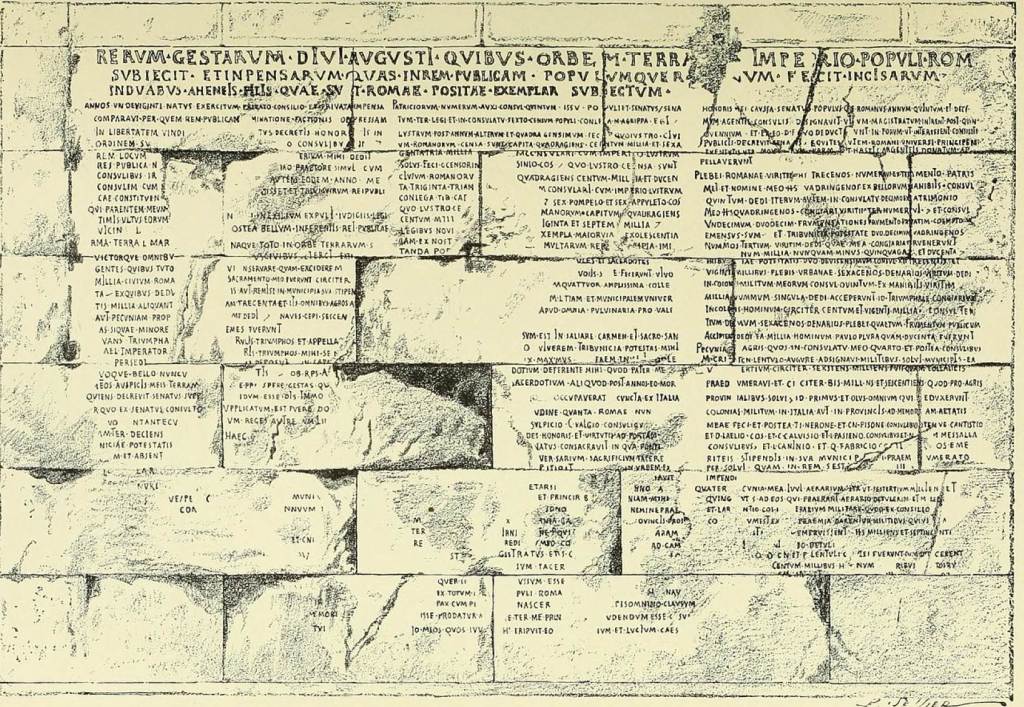

El Res Gestae Divi Augusti

Para demostrar la utilidad real de Aeneas, los investigadores aplicaron el modelo a la célebre inscripción del Res Gestae Divi Augusti (RGDA), el testamento político del emperador Augusto. Aeneas logró fechar el texto en una horquilla coherente con la cronología aceptada por los expertos, entre el 10 a.C. y el 20 d.C., sin dejarse confundir por las numerosas fechas consulares mencionadas en la inscripción. Mediante mapas de saliencia, además, el modelo identificó elementos clave como la ortografía arcaizante o las referencias institucionales precisas, como el título princeps iuventutis otorgado en el 5 a.C. o la mención del Ara Pacis, consagrada en el 13 a.C. Además, Aeneas identificó como paralelos textos jurídicos romanos de principios del siglo I d.C. Esto confirma la alineación del lenguaje y contenido de la inscripción con la ideología imperial de su tiempo.

Un altar militar en Mogontiacum

Otro ejemplo ilustrativo lo proporciona el altar votivo dedicado en 211 d.C. por Lucius Maiorius Cogitatus en la provincia de Germania Superior. Aeneas no solo propuso una datación correcta (214 d.C.) y una localización precisa, sino que también detectó como paralelo un altar similar dedicado por otro oficial en la misma ciudad en 197 d.C. Tal conexión evidencia una tradición local de inscripciones militares que comparaten fórmulas similares. Este ejemplo destaca la capacidad del modelo para detectar patrones epigráficos regionales y cronológicos, incluso cuando no se dispone del contexto arqueológico.

Una colaboración transformadora entre historiadores e inteligencia artificial

En el mayor estudio colaborativo entre historiadores y sistemas de IA llevado a cabo hasta la fecha, 23 especialistas en epigrafía evaluaron la funcionalidad de Aeneas en tareas reales de investigación. Los resultados muestran que la colaboración entre humanos e inteligencia artificial supera el rendimiento de ambos por separado.

Los expertos lograron mejores resultados en la restauración, la datación y la localización cuando contaban con los paralelos y predicciones dados por Aeneas. Muchos señalaron que el modelo les permitía centrarse en tareas de interpretación en lugar de dedicar tiempo a las búsquedas documentales.

Hacia una nueva forma de reconstruir la historia

Aeneas no pretende reemplazar al historiador, sino ampliar sus capacidades. Su potencia radica en su diseño orientado a la contextualización histórica, en su habilidad para trabajar con lagunas de longitud indeterminada y en su flexibilidad para adaptarse a distintos idiomas y soportes de escritura. Como herramienta de investigación, Aeneas representa un puente entre el análisis filológico tradicional y las nuevas tecnologías.

Referencias

- Assael, Y., Sommerschield, T., Cooley, A. et al. 2025. "Contextualizing ancient texts with generative neural networks". Nature. DOI: https://doi.org/10.1038/s41586-025-09292-5

No son famosas por ello, pero las mutaciones han dado origen a toda la diversidad y riqueza biológica que nos rodea. Estas alteraciones en las moléculas de ácido desoxirribonucleico (ADN) y ácido ribonucleico (ARN) han acompañado a los seres vivos desde sus orígenes. Sin el concurso de estos inesperados errores, no existiría la abundancia ni la variedad de formas que pueblan el planeta. Todas las características que muestran los seres que basan su existencia en el ADN o el ARN han ido apareciendo por los cambios progresivos que sufrían estas moléculas: desde las hojas de las plantas hasta el pelaje de los mamíferos, pasando por sus complejas rutas metabólicas. Cualquier rasgo biológico en el que pensemos no existía hasta que una mutación al azar lo originó.

A pesar de su relevancia, solamente en ocasiones puntuales les prestamos atención. Por ejemplo, cuando alteran la dinámica de un virus creando nuevas variantes que dificultan la superación de una pandemia. Sin embargo, estos cambios suceden constantemente. Tenían lugar hace miles de millones de años cuando se originó la vida, y es posible que mientras lees este texto también algo esté alterándose en el ADN de alguna de tus células. Bajo un mismo término describimos el mecanismo culpable de eventos trascendentes, como el origen de nuestros tumores y el de nuevas especies en la historia de la vida, y el responsable de otros sucesos anodinos, como la pérdida de una molécula de adenina en una región insulsa del genoma de una célula de un folículo piloso o en el ADN de la hoja de un árbol.

Esta disparidad de consecuencias nos obliga a tomar conciencia de que hay que aceptar que el término engloba situaciones con un mismo origen pero repercusiones muy distintas. Son cambios en el material genético, ADN o ARN (hablaremos principalmente del primero), susceptibles de transmitirse. Es decir, en su definición más básica, es un cambio en un texto, en el manual de instrucciones de los seres vivos dependientes de material genético. Lo que no podemos anticipar es si esa alteración se va a consolidar o propagar ni si tendrá importancia para su portador y su descendencia.

El motor biológico más incomprendido

Cualquier cambio en las piezas que conforman el ADN podemos convalidarlo por mutación: pérdidas, ganancias, reordenamientos, translocaciones, etcétera. Las formas de mutar son numerosas, pero no hace falta entrar en detalles: es mucho más esclarecedor centrarse en analizar lo variopinto de sus efectos. En el ADN (o ARN) de un virión o partícula viral (un soldado del ejército de virus), una mutación puede implicar que sintetice una de las moléculas de proteína que lo rodean con una forma tridimensional sutilmente distinta a la de otros miembros de su especie. Esto podría ocurrir si, al ser mutante, el material genético del virión tuviese alteradas algunas letras en el texto que dicta cómo construir la proteína. Imaginemos que produce una proteína novedosa que luce aspecto de interrogación (¿) en lugar de la forma original de exclamación (¡). Esto podría evitar que los anticuerpos del sistema inmunitario del hospedador reconociesen a la nueva proteína, si utilizaban la original como referencia para localizar al agente invasor.

Este tipo de situación se repite frecuentemente en la evolución de nuestros agentes patógenos, a los que la mutación ayuda azarosamente a escapar de nuestras defensas. No obstante, también ocurre con similar probabilidad que la modificación en el material genético del virus dote a la proteína de una nueva forma tridimensional que no es lo suficientemente distinta (por ejemplo, I) como para impedir que las defensas del hospedador la reconozcan. Una mutación no es otra cosa más que un cambio, trascendente o no; todo dependerá de dónde, cuándo y cómo ocurra y cuánto material genético se altere.

De hecho, para ilustrar la amplitud de situaciones que abarca un mismo término, podemos empezar con una división muy sencilla. En las clases de medicina, la mutación se explica como el origen de numerosos procesos oncológicos que descontrolan a las células y como la causante de horribles síndromes. Por el contrario, al hablar de evolución en biología, se define como la fuente única de toda la variabilidad de la vida; la responsable, por ejemplo, de que las aletas de los peces diesen lugar a extremidades que permitieron a los vertebrados poblar la tierra firme hace unos 400 millones de años, o la causa de que nuestra especie sea un primate capaz de hablar. La mutación también es la fuente de la variedad de formas y colores que adquieren plantas, animales, hongos, etcétera. Sin esas alteraciones no habría bioquímica, o mejor planteado: no habría flores de colores ni mariposas, ni cerebros para observarlas y disfrutarlas.

Mutaciones cotidianas e invisibles

Un panorama tan diverso como el que rodea el estudio de este fenómeno exige abrir una serie de interrogantes: ¿es normal que mute el ADN? ¿Por qué se producen las mutaciones? ¿Ocurren al azar? ¿Por qué distintas alteraciones tienen distinta importancia? ¿Pueden conseguir que en las generaciones venideras aparezcan seres humanos con garras de metal, como en los superhéroes de ficción?

Empecemos por la primera pregunta: ¿es esperable que el ADN mute? Sin duda, la respuesta es sí. El material genético es susceptible de estropearse, como todo lo material. El ADN y el ARN son ácidos grandes y complejos que encadenan largas sucesiones de pequeñas moléculas que se pueden ver degradadas, alteradas, desordenadas o modificadas de distintas maneras, al igual que cualquier compuesto químico.

Todo ello ocurre a pesar de que el material genético siempre se encuentra protegido, porque reside en el interior más profundo de nuestras células (el compartimento llamado núcleo que tenemos hongos, plantas y animales) o habita resguardado por una armadura de membranas y proteínas en virus y bacterias. Además, el ADN posee una estructura química robusta que permite preservar de forma extraordinaria el ordenamiento de sus piezas. Precisamente esa colocación de moléculas de forma ordenada codifica los mensajes; la modificación de esta disposición de elementos es la que puede traer consecuencias.

Una misma causa, mil consecuencias

El ADN es una macromolécula especialmente sólida, pero muy exigida y explotada en sus labores. Entre sus tareas cotidianas, debe ser leído por ciertas moléculas de la célula que capitanea. Así tiene que ocurrir para que se puedan aplicar las órdenes que el ácido desoxirribonucleico recoge en sus genes, pero, además, ha de ser copiado profusamente. El texto que alberga debe transmitirse idéntico a las nuevas células que se forman. En nuestro cuerpo, algunas células se renuevan a diario, lo cual implica, entre otros detalles, copiar la extensa molécula de ADN completa como quien replica un enorme texto letra a letra. Por ejemplo, nuestro intestino posiblemente sea del todo distinto de cómo era la semana pasada. La diferencia es indetectable porque se ha reconstituido siguiendo las mismas instrucciones, leyendo nuestro ADN personal y particular, pero, sin duda, es otro órgano. En resumen, la función rutinaria del material genético implica que debe pasar por procesos de copiado permanente que lo exponen a introducir erratas.

Además, hay que recordar que el material genético, sea el nuestro, el de un árbol o el de un virus, está expuesto a las inclemencias del ambiente: agentes químicos, radiaciones, interacciones moleculares, oxidación, etcétera. Todo ello también promueve que ocurran mutaciones. No olvidemos que el ADN es un conjunto de moléculas enlazadas, y, como tal, está sometido a las alteraciones que provocan las fuerzas físicas y químicas. Prueba de ello es que cuanto más tiempo llevamos viviendo, más mutaciones acumulamos, arriesgándonos a que alguna de ellas desencadene un proceso oncológico y ponga en jaque la exquisita coordinación que requiere un cuerpo.

Y no solo es un problema de envejecimiento, sino que de serie ya venimos algo mutados. Se estima –burdamente– que todos nacemos con al menos un centenar de mutaciones en nuestro material genético que no existían en el de nuestros padres del que procede. ¡Y todo esto antes de empezar a utilizar, copiar y exponer nuestro ADN!

¿Y por qué distintas mutaciones tienen distinta importancia?

Pensemos en el ejemplar de la revista que tienes en tus manos. Imagina que todas las hojas que ocupa este artículo apareciesen completamente en blanco. Si has perdido el contenido de media docena de páginas, seguramente pensarías que tu ejemplar está seriamente dañado. Y al contrario, si solamente apareciese una errata en una palabra del texto –por ejemplo, una e en medio de la palabra mutación–, el defecto podría ser pasado por alto, porque el mensaje se transmite igualmente. Ambas serían mutaciones, pero de distinto calado. No tiene la misma importancia si se logra trasmitir el mensaje que si este queda abortado.

Es difícil anticipar la importancia de una mutación. Las generalizaciones sirven de poco cuando se estudia este mecanismo. Podemos suponer que uno de los factores que afecta a la relevancia del cambio es la cantidad de ADN implicado, pero no es el único. Si mantenemos la metáfora de esta revista, hay mutaciones de una sola letra del texto del ADN, otras que afectan a palabras o frases y otras a artículos o revistas completas. Habitualmente, se cumple la lógica, y es más probable que produzcan un resultado impactante las mutaciones que afectan a áreas más grandes de material genético, pero puede no tener efecto si esa región se encuentra inactiva o juega un papel secundario. Inversamente, un simple cambio de letra en una frase clave desencadena enfermedades como la anemia falciforme.

Todos nacemos ya mutados

Otro factor determinante para evaluar la trascendencia de una mutación es el lugar y el momento del desarrollo del portador en que ocurre. Pensemos de nuevo en nuestra propia existencia, remontándonos hasta la concepción. Hubo un día en que fuimos un óvulo que acababa de recibir un espermatozoide. Ambos juntaron sus aportaciones de ADN para producir la que sería nuestra molécula personal y única. Ese óvulo fecundado, nuestra primera célula, empezó enseguida a copiarse, a dividirse, al compás de lo dictado por el nuevo ADN. Primero dio lugar a dos células, luego a cuatro, a ocho… En las divisiones sucesivas, cada una de las células iba leyendo distintas partes de las copias de nuestro particular ADN, que dotaban a los linajes celulares de un destino: un grupo acabaría constituyendo el sistema nervioso; otro, las extremidades; otro, el hígado, etcétera.

En esa dinámica, un cambio en la molécula de ADN de una célula que fuera a ser la madre de todas las que formaran –por ejemplo, nuestro sistema nervioso– se propagaría a millones de ellas. Pero si esa mutación afectara a una parte del texto del ADN cuyas instrucciones no participan en la construcción del, no importaría. Es decir, las modificaciones que ocurren en etapas tempranas del desarrollo pueden copiarse en millones de células derivadas y es más probable que tengan consecuencias visibles. Por el contrario, una alteración en la etapa adulta –imaginemos una célula de la piel– tiene, en principio, menos potencial: podría simplemente producir un lunar (aunque también podría dar lugar a un tumor).

Todavía más interesantes son las implicaciones en nuestras células reproductoras. Como se ha dicho, una mutación en una célula de nuestra piel, pulmón o hígado puede causarnos una enfermedad o un cáncer que nos elimine. O puede carecer de efecto. Ocurra lo que ocurra, solamente adquiere importancia en nuestro cuerpo y no más allá, porque morirá con él. Quizá sea muy trascendente para el individuo, pero no para la historia de la vida. Por el contrario, si ocurre en uno de nuestros óvulos o espermatozoides, y ese ejemplar resulta el elegido para dar lugar a un descendiente, el hijo adquirirá la mutación en su primera célula y, por consiguiente, en los 40 billones que se generarán a partir de ella. No solo eso, sino que las células reproductoras de nuestro vástago también la portarán, y, como consecuencia, todos sus futuros descendientes. Es decir, no es lo mismo que tu revista tenga una página en blanco porque se ha introducido accidentalmente una hoja vacía, a que ocurra en los miles de ejemplares de la tirada porque se ha estropeado la máquina impresora. Lo primero te afectaría a ti, lo segundo al total de los ejemplares y a las futuras tiradas.

La mutación como lotería genética

Al margen de las enfermedades, las mutaciones también ostentan el mérito de ser el mecanismo que ha generado toda la variabilidad de la vida. La existencia de seres dispares como los animales, las plantas, los hongos, las bacterias y todo lo que puebla el planeta con ADN en su interior se explica porque el material genético que se originó hace unos 4000 millones de años ha ido acumulando mutaciones. No obstante, no debemos olvidar que son errores aleatorios; lo esperable es que el resultado sea adverso. Imaginemos una orquesta que se dispone a tocar una obra sinfónica. Si desafinamos un instrumento al azar, lo más probable es que el concierto resulte desastroso, al menos peor que si hubiera una completa armonía.

Sin embargo, a lo largo de la historia de la vida ha habido suficientes intentos y tiempo, mucho tiempo, para que hayan surgido errores que han dado lugar a novedades funcionales. Nuestro cerebro no tiene recursos para procesar lo que significa que miles de millones de seres vivos hayan replicado su ADN miles de millones de veces durante miles de millones de años. De hecho, si tecleásemos letras al azar en una hoja en blanco una cantidad de veces equivalente, muchas veces obtendríamos textos coherentes. De forma análoga han aparecido nuevos mensajes en las secuencias genéticas que crean novedades en los seres, algunas de las cuales han resultado operativas, ya sean mejores, iguales o peores que la versión original. Funcionan y sus portadores sobreviven y, por tanto, las trasmiten. De ahí venimos todos, de esa acumulación de errores. Eso sí, no cabe duda de que la mayoría de los cambios han provocado modificaciones nocivas y deletéreas, frases sin sentido, pero los resultados desastrosos no los observamos. Solo está entre lo vivo aquello que surgió por azar, funcionó y pudo transmitirse.

Por ello, de la mutación se dice que tiene carácter preadaptativo, que quiere decir que las alteraciones ocurren independientemente de su trascendencia, y solamente las que son adaptativas, las que permiten la supervivencia de sus portadores y no les dificultan la existencia, tienen papeletas para perdurar. Si son nocivas y destruyen al portador, no se trasmiten, así que carecen de importancia evolutiva. Ni siquiera vemos su rastro, igual que no detectamos la mayoría de los abortos espontáneos que ocurren en las primeras etapas de la gestación por mutaciones tempranas (se estima que suceden en la mitad de las fecundaciones). Resulta complicado asumir la importancia que tiene en nuestra existencia un fenómeno que acontece al azar.

El azar tiene sus preferencias

Eso sí, no debemos caer en otro de los trampantojos habituales que no regala el estudio de la mutación. Que el azar sea su motor desencadenante no quiere decir que todas las alteraciones sean posibles, ni tampoco equiprobables. De hecho, hay numerosas mutaciones que reaparecen frecuentemente más de lo que correspondería en un reparto al azar de papeletas. Bien conocidos son algunos casos de cáncer que se disparan por daños o errores frecuentes en nuestro genoma (por ejemplo, producidos por la conocida mutación del gen KRAS). Ciertas zonas de nuestro ADN son más susceptibles de modificarse que otras, porque cada especie tiene sus puntos débiles, igual que ciertos coches tienden a sufrir averías en el embrague y otras marcas queman antes los frenos. La razón fundamental es que la molécula de ADN adquiere conformaciones tridimensionales que dejan regiones más expuestas que otras.

Sin embargo, la existencia de ciertas alteraciones recurrentes no nos permite anticipar, ni mucho menos, a dónde se encamina nuestra especie, por mucho que la ficción se haya empeñado en presentar propuestas originales. La mutación es un cambio sobre el material preexistente, sobre una molécula orgánica que dirige a otros compuestos químicos, así que no parece probable que vaya a permitirnos desarrollar esqueletos metálicos o visión láser. Aunque los cambios futuros tampoco tienen por qué ser simples o aburridos, más allá de los meros cambios en la coloración de la piel, los ojos o el pelo. Quizá incluso demos lugar a nuevas especies, si resistimos suficiente tiempo entre los supervivientes del planeta.

La vida escribe con lo que tiene

Durante mucho tiempo se creyó que a lo largo del proceso evolutivo solo ocurrían pequeños cambios graduales y progresivos, y hoy sabemos que eso no es cierto. Hasta la aparición de la genética del desarrollo, se postulaba que todas las novedades de la vida se habían producido paulatinamente, y que carecíamos de restos de algunas especies en el registro fósil que nos impedían ver ese proceso de transición paulatina. El hallazgo de ciertos genes, fundamentales en los seres pluricelulares (los bautizados como genes homeóticos), permitió concluir que no era necesario buscar los eslabones perdidos entre los animales con aletas y aquellos con extremidades, o entre los distintos tipos de flores en las plantas.

Las mutaciones que implican grandes cambios, particularmente en la evolución, son posibles. La alteración de algunos genes produce pequeños efectos, pero las de otros, como los citados homeóticos –esencialmente en etapas tempranas del desarrollo–, causan enormes reorganizaciones corporales. Todo ello a pesar de que no hay nada que diferencie marcadamente un gen homeótico de otro cualquiera; unos y otros no son más que distintas porciones de la molécula del ADN.

De nuevo, la mutación nos regala su característica manía de resultar difícilmente predecible en sus consecuencias. Eso sí, en cualquier caso, no podemos olvidar que la vida siempre trabaja sobre material preexistente. Es decir, aquellas novedades que surjan tendrán que aparecer modificando un texto escrito en el idioma que emplea el código del ADN, que solamente utiliza unos ladrillos concretos para construir los organismos vivos, los aminoácidos, que son el andamiaje de las proteínas. Por tanto, no es esperable que desarrollemos la capacidad de disparar rayos por los ojos, pero no es grave porque es mucho más interesante tener cerebros desarrollados que nos permiten entender la vida. Y, estos sí, surgieron por mutación.

Perder a alguien cercano es una experiencia que muchos describen como "un vacío en el pecho" o "un nudo permanente en el estómago". Pero más allá de la tristeza, la ciencia empieza a demostrar que el duelo intenso puede convertirse en una amenaza real para la salud. En Dinamarca, un equipo de investigadores siguió a 1.735 personas durante diez años tras la muerte de un familiar. Lo que descubrieron fue impactante: quienes experimentaron un duelo persistente y elevado tenían un riesgo de muerte casi el doble de alto.

Las emociones intensas del duelo pueden debilitar el cuerpo y afectar el corazón. Esto se conoce popularmente como "el síndrome del corazón roto", y aunque suene a metáfora, tiene bases fisiológicas reales. El estudio danés confirma que no se trata solo de tristeza: el dolor emocional crónico puede aumentar el uso de servicios de salud, de medicamentos psicotrópicos, y en última instancia, acortar la vida.

Los científicos clasificaron a los participantes en cinco trayectorias de duelo según la intensidad y duración de los síntomas. El grupo más vulnerable, que representaba un 6 % de los participantes, mostró niveles altos y constantes de dolor emocional incluso tres años después de la pérdida. Y fue ese grupo el que tuvo más riesgo de muerte en los años siguientes.

El duelo persistente afecta al cuerpo durante años

No se trata de sentir tristeza por unos meses. El estudio siguió a los participantes desde antes de la pérdida, luego a los seis meses y nuevamente tres años después. Se identificaron cinco tipos de trayectorias emocionales: desde quienes apenas mostraban síntomas hasta quienes mantenían un duelo elevado de forma persistente. Y la salud a largo plazo fue muy distinta entre ellos.

Los que sufrieron un duelo intenso y duradero acudieron más al médico y usaron más medicamentos psiquiátricos. Durante los primeros siete años tras la pérdida, este grupo tuvo un mayor número de consultas médicas, incluidas las atenciones de urgencias.

Además, presentaron más prescripciones de antidepresivos, ansiolíticos y sedantes, lo que indica un sufrimiento que se volvía también físico y clínico.

También se registró un uso mayor de servicios de salud mental. Las personas con duelo persistente tenían casi tres veces más probabilidades de buscar ayuda psicológica. Sin embargo, los investigadores alertan que, pese a recibir atención, muchos seguían sintiéndose igual de mal incluso una década después. Lo que sugiere que la atención actual podría no estar siendo suficiente para los casos más graves.

Cuando el corazón emocional afecta al corazón real

Una de las conclusiones más inquietantes del estudio es que el duelo intenso puede traducirse en una mayor probabilidad de morir. El grupo con síntomas persistentes tuvo una tasa de mortalidad un 88 % mayor que el grupo con menor nivel de síntomas. ¿Puede el sufrimiento emocional afectar directamente al cuerpo hasta ese punto?

La respuesta de la ciencia es cada vez más clara: el estrés del duelo puede desencadenar problemas físicos graves. El corazón roto no es solo una expresión poética: se ha documentado un tipo de miocardiopatía inducida por estrés que imita un infarto y que puede aparecer tras una pérdida emocional intensa. A esto se suma el debilitamiento del sistema inmunitario, la aparición de insomnio crónico, hipertensión y enfermedades inflamatorias.

Este fenómeno es especialmente preocupante en personas que ya tienen alguna enfermedad o factores de riesgo, como bajo nivel educativo o escaso apoyo social. La suma de estas condiciones puede convertir al duelo en un catalizador de deterioro progresivo. Y aunque la mayor parte de las personas no experimentan esta persistencia en el tiempo, un pequeño grupo queda atrapado en un dolor constante que afecta cada aspecto de su existencia.

Cómo reconocer las trayectorias del duelo

No todos los duelos se viven igual. El estudio identificó cinco trayectorias distintas basadas en cómo evolucionaban los síntomas a lo largo del tiempo. El grupo de "duelo bajo" era el más común, seguido por trayectorias con síntomas moderados que disminuían, y otros con picos tardíos de dolor emocional. El grupo más vulnerable fue el de "duelo alto persistente".

Detectar esas trayectorias podría ser clave para prevenir complicaciones a largo plazo. Los investigadores sugieren que los profesionales de salud podrían identificar a las personas en riesgo incluso antes de la pérdida, especialmente en entornos de cuidados paliativos.

Estas personas podrían beneficiarse de un seguimiento más cercano y de intervenciones adaptadas desde el inicio del proceso.

El dolor emocional puede manifestarse como agotamiento, problemas para dormir, ansiedad constante o retraimiento social. Cuando estos síntomas persisten más allá del primer año, podría tratarse de un duelo complicado o prolongado, reconocido clínicamente. En estos casos, el tiempo por sí solo no cura, y la intervención profesional se vuelve esencial.

El papel de la atención primaria

Uno de los hallazgos más importantes del estudio es que los familiares con síntomas persistentes de duelo tenían mayor contacto con la atención primaria, como visitas al médico de cabecera. Esto representa una oportunidad: los profesionales de salud están en una posición ideal para detectar y ayudar.

La medicina de familia puede ser la primera línea de apoyo en los casos de duelo complicado. Los médicos pueden identificar patrones de sufrimiento emocional a través de las consultas. Incluso podrían empezar el apoyo antes de la pérdida, preparando al familiar para el duelo y ofreciéndole recursos.

Los autores destacan que, a pesar de tener más acceso a servicios, muchos familiares continúan con altos niveles de sufrimiento. Esto apunta a una necesidad urgente de mejorar las estrategias de intervención, incluyendo terapias más personalizadas, mayor acceso a psicólogos y seguimientos prolongados.

El duelo no es una enfermedad, pero puede volverse un factor de riesgo grave si no se acompaña correctamente.

Una oportunidad para actuar a tiempo

El mensaje del estudio es claro: el duelo puede matar, pero también puede prevenirse el daño si se actúa a tiempo. Identificar a las personas en riesgo, entender sus trayectorias emocionales y ofrecerles apoyo real es una responsabilidad de los sistemas de salud, de las familias y de la sociedad.

El dolor por una pérdida no debe vivirse en soledad ni minimizarse. Sentirse triste es natural, pero cuando ese dolor no cede, cuando se convierte en una sombra permanente, entonces se necesita ayuda. No es debilidad: es una reacción humana ante un impacto profundo. Y la ciencia hoy nos dice que ignorarlo puede tener consecuencias físicas, emocionales y hasta mortales.

Con estudios como este, los investigadores no solo están demostrando la conexión entre emoción y cuerpo, sino también abriendo la puerta a una medicina más humana, que entienda que sanar el corazón también es cuidar la salud.

Referencias

- Nielsen, M. K., Pedersen, H. S., Sparle Christensen, K., Neergaard, M. A., Bidstrup, P. E., & Guldin, M. B. (2025). Grief trajectories and long-term health effects in bereaved relatives: a prospective, population-based cohort study with tenyear follow-up. Frontiers in Public Health. doi: 10.3389/fpubh.2025.1619730

Aunque el reciclaje es una práctica que se ha intensificado en las últimas décadas como consecuencia de las prácticas de consumo contemporáneas, los humanos llevamos milenios haciéndolo. Lo curioso es que, a lo largo de los siglos, no solo hemos reaprovechado materiales como los metales o las piedras. Sin ir más lejos, los romanos también practicaban formas complejas de reciclaje documental: reutilizaban el papiro, uno de los soportes de escritura más valiosos del mundo antiguo. De este modo, los soportes de escritura podían tener múltiples vidas.

A partir del análisis de múltiples documentos papirológicos, los expertos han podido reconstruir las diversas formas en que los papiros se reciclaron en el contexto romano. Así, las evidencias revelan que la escritura en el mundo romano fue una práctica integrada en un ciclo de uso y reutilización continuo.

Reutilizar antes que desechar: una lógica económica y cultural

El papiro era un bien de gran valor tanto en la República como en el Imperio romano. En su mayoría provenía de Egipto, por lo que su distribución en todo el Mediterráneo estaba sujeto a costes de transporte y a una disponibilidad variable según la coyuntura. Por ello, no sorprende que los romanos desarrollaran múltiples estrategias para prolongar la vida útil del papiro, ya fuese escribiendo en él varias veces o empleándolo para funciones distintas a la inicial.

Una de las formas más comunes de reutilización consistía en usar el reverso de los papiros ya escritos. Este tipo de documentos escritos por ambas caras se denominan opisthographai y revelan que, incluso los textos jurídicos, literarios o administrativos podían convertirse en soporte para garabatear borradores, cuentas o listas de la compra cuando se escribía en su reverso. Está práctica se documenta en contextos muy diversos, desde archivos personales hasta centros administrativos: estaba, por tanto, muy extendida.

Borrado, raspado y reescritura: técnicas del reciclaje de papiro

En ocasiones, la reutilización no se limitaba a usar la cara en blanco del papiro. Así, se recurría a métodos físicos para borrar la tinta de los textos anteriores y escribir de nuevo sobre la misma superficie. Esto podía lograrse raspando ligeramente la superficie con una esponja o con otros instrumentos. Aunque no era una técnica infalible —podían quedar huellas del texto anterior—, al menos permitía darle un nuevo uso a un recurso de por sí escaso.

Estos papiros parcialmente borrados y reescritos se conocen como palimpsestos, si bien este término se utiliza con mayor frecuencia en relación con los pergaminos. En el caso del papiro, algunos ejemplares conservados han permitido identificar varios ejemplos en los que las capas superpuestas de escritura cuentan historias dispares, reflejo de los cambios en la función del documento.

Estas capas sucesivas de escritura convierten el soporte en archivo, no solo de un mensaje, sino de su propia historia. Para los investigadores actuales, esta característica ofrece oportunidades extraordinarias para reconstruir tanto los propios textos como las prácticas culturales y hábitos documentales.

Del archivo al mercado: la reventa de papiros usados

Otro dato curioso sobre la reutilización en la antigüedad romana apunta a que los papiros no siempre eran reciclados por sus propietarios originales. En el pasado, también existía un pequeño mercado de materiales usados. En algunos casos, los documentos se vendían o cedían para que los estudiantes o los escribas en formación los reutilizaran como borradores . La reutilización, por tanto, formaba parte de un sistema de circulación más amplio, donde incluso los desechos podían adquirir un nuevo valor.

En este contexto, el papel de las escuelas resulta de especial interés. En varios yacimientos arqueológicos, como los de Oxirrinco en Egipto, se han hallado numerosos ejercicios escolares escritos sobre papiros reutilizados. Todo ello indica que la práctica educativa se alimentaba de materiales ya usados, que permitían ahorrar costes al tiempo que se entrenaba la destreza de los aprendices.

Usos secundarios: embalaje, envoltorios y sellos

Cuando ya no era posible reutilizar el papiro como soporte de escritura, el material todavía seguía siendo útil. Algunos documentos que se conservan muestran signos de haber sido plegados y utilizados como envoltorios o etiquetas. Otros fragmentos, que presentan orificios, podrían haber servido para colgar productos o para acompañar envíos, como una suerte de etiqueta informativa.

Esta transformación del papiro en objeto utilitario refleja una lógica pragmática típicamente romana: ningún recurso debía desperdiciarse mientras pudiera cumplir una función, por modesta que esta fuera. Incluso los documentos oficiales, cuando se volvían inservibles, podían acabar convertidos en tiras para atar objetos o en material de embalaje para proteger mercancías delicadas.

La reutilización institucional en el caso de los archivos

No solo los individuos reutilizaban papiros: también lo hacían las instituciones públicas y privadas. En ciertos archivos se ha comprobado que los documentos administrativos obsoletos se reaprovechaban sistemáticamente, ya fuera para tareas contables, registros internos o correspondencia. De este modo, la vida administrativa del Imperio romano generaba un flujo constante de documentación, pero también una gestión material eficiente.

Una práctica común en el mundo romano

La rica complejidad del mundo romano no solo se manifiesta a través de la lengua, la arquitectura o la religiosidad: también lo hace a través de la reutilización de los soportes de escritura. Este enfoque permite repensar la historia cultural de Roma desde una perspectiva material. En definitiva, el reciclaje de papiros en el Imperio romano refleja una sofisticada cultura documental, en la que nada se desperdiciaba, sino que todo podía disfrutar de una segunda vida. Un legado que, en nuestro presente, resulta más relevante que nunca.

Referencias

- Duckworth, Chloë N. y Andrew Wilson (eds.). 2020. Recycling and Reuse in the Roman Economy. Oxford Unievrsity Press.

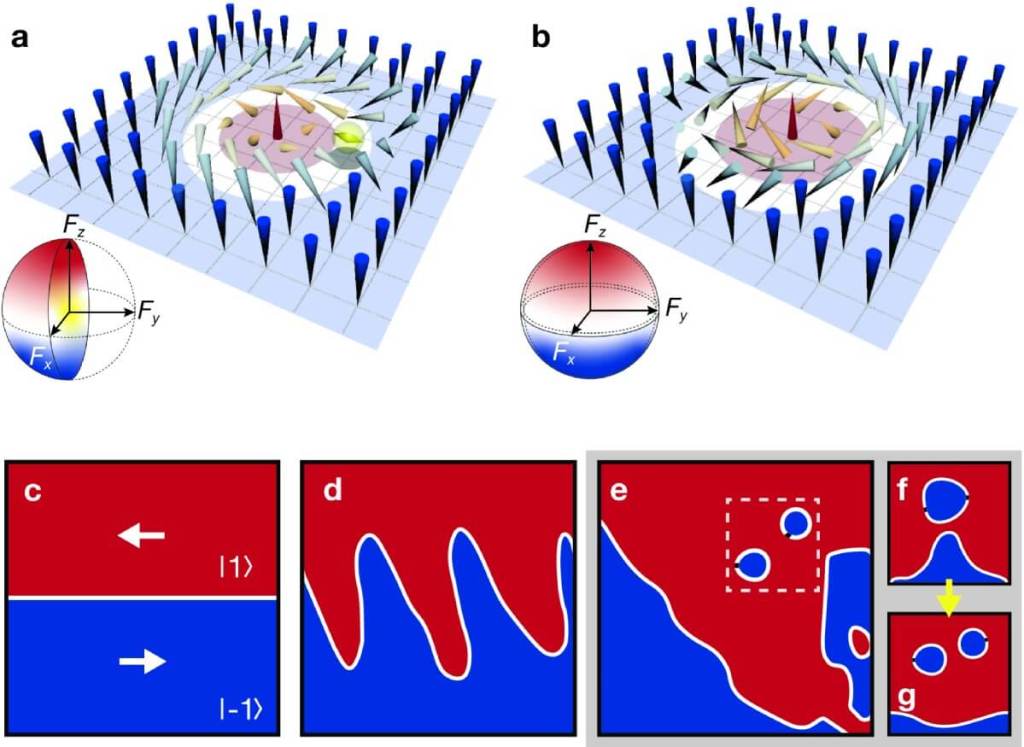

En lo profundo de una central nuclear suiza, un grupo de físicos ha conseguido lo que parecía inalcanzable: detectar una señal extremadamente débil de partículas que, pese a atravesar todo a su paso, casi nunca dejan rastro. Los protagonistas son los neutrinos, partículas elementales tan escurridizas que cada segundo atraviesan nuestro cuerpo en cantidades astronómicas sin que lo notemos. Lo asombroso de este logro no es que se haya detectado un neutrino —eso ya se consiguió hace décadas—, sino que se ha observado en un reactor nuclear un tipo muy concreto y raro de interacción que llevaba medio siglo resistiéndose a la observación en estas condiciones.

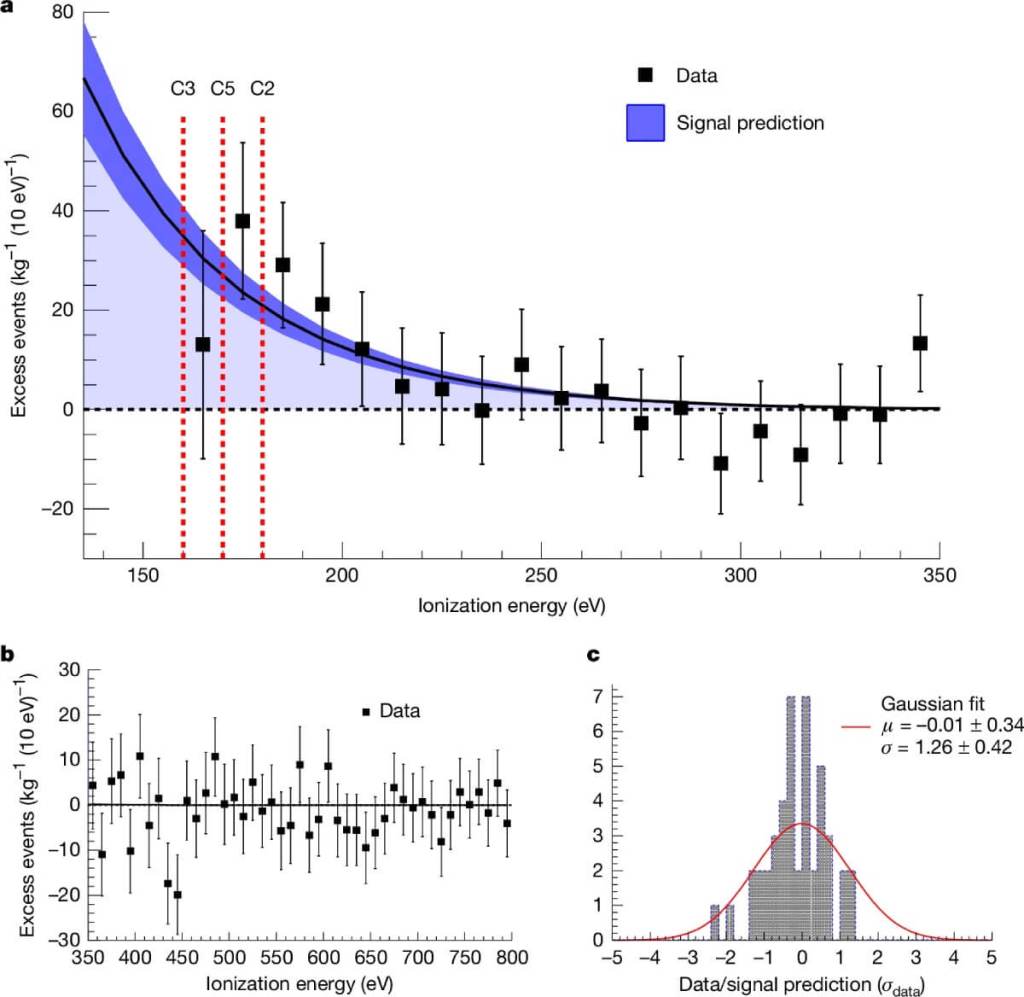

El experimento, llamado CONUS+, se realizó en el reactor de Leibstadt, en Suiza, con un detector de apenas tres kilogramos de masa activa. En palabras de sus autores, se trata de la “primera observación de una señal de neutrinos con una significancia estadística de 3,7σ” en este contexto, un dato que certifica la solidez del hallazgo. El estudio, publicado en Nature, no solo confirma una predicción formulada en 1974, sino que abre el camino a nuevas formas de explorar la física fundamental e incluso a posibles aplicaciones tecnológicas en vigilancia y control de reactores.

Un tipo de interacción casi imposible de atrapar

En física de partículas, no todos los choques son iguales. Lo que se ha conseguido medir en CONUS+ se llama dispersión coherente elástica de neutrinos con núcleos atómicos (CEvNS). A diferencia de interacciones más comunes, aquí el neutrino no golpea una partícula aislada dentro del núcleo, sino que interactúa con el conjunto de protones y neutrones como si fuera una única entidad. Este proceso aumenta la probabilidad de que se produzca el choque, pero la energía transferida es tan mínima que resulta extremadamente difícil de registrar.

La idea fue propuesta teóricamente por Daniel Z. Freedman en 1974. Sin embargo, no fue hasta 2017 cuando se observó por primera vez, y ocurrió en un acelerador de partículas, no en un reactor. Detectarlo en este último entorno es un reto diferente: los neutrinos del reactor tienen energías más bajas, lo que en principio favorece la coherencia completa del choque, pero obliga a contar con detectores extremadamente sensibles.

El detector de CONUS+ está hecho de cristales de germanio ultrapuro, capaces de registrar energías de apenas 160 electronvoltios. Según el artículo, “este umbral es solo dos órdenes de magnitud mayor que la energía mínima necesaria para crear un par electrón-hueco”, un logro técnico que ha requerido años de desarrollo.

El camino hasta Suiza

El proyecto comenzó en Alemania, en la central nuclear de Brokdorf, donde operó bajo el nombre de CONUS. Entre 2018 y 2022, los investigadores realizaron mediciones que establecieron límites muy precisos a la interacción buscada, pero sin llegar a detectarla. El cierre de esa central llevó a trasladar el experimento en 2023 al reactor de Leibstadt, de 3,6 gigavatios térmicos.

El nuevo emplazamiento implicó retos adicionales: el nivel de protección frente a la radiación cósmica es menor que en laboratorios subterráneos, y el entorno dentro del edificio del reactor impone restricciones de espacio, materiales y acceso. Aun así, las mejoras en el umbral de energía de los detectores y en su eficiencia de disparo permitieron multiplicar por casi diez la tasa prevista de interacciones.

Durante 119 días de operación con el reactor encendido, combinados con periodos de apagado para calibrar el fondo, los investigadores registraron un exceso de 395 ± 106 eventos atribuibles a neutrinos, en línea con las predicciones teóricas del Modelo Estándar.

Cómo se mide lo invisible

Observar CEvNS en un reactor implica diferenciar la señal de neutrinos de un fondo de eventos que la supera ampliamente. La mayor parte de estos eventos de fondo procede de rayos cósmicos y de la radiactividad ambiental, que pueden producir señales indistinguibles si no se filtran adecuadamente.

El equipo de CONUS+ empleó un blindaje de diez toneladas que combina plomo, polietileno y capas dopadas con boro, además de un sistema activo de veto con centelleadores plásticos para detectar el paso de muones cósmicos. El análisis de datos se hizo mediante un ajuste de máxima verosimilitud, comparando los espectros medidos con el reactor encendido y apagado.

Según el artículo, “el resultado implica la concordancia de los datos de CONUS+ con la sección eficaz de CEvNS del Modelo Estándar y con el flujo de antineutrinos estimado a partir de la potencia térmica del reactor”. Esto significa que, además de observar la interacción, han validado que el número de eventos coincide con lo previsto por la física conocida.

Por qué importa este hallazgo

Más allá de confirmar una predicción de hace 50 años, la medición abre nuevas vías para estudiar física dentro y fuera del Modelo Estándar. La dispersión coherente es sensible a todos los tipos de neutrinos, no solo a los electrones antineutrinos que se detectan con la técnica estándar de desintegración beta inversa. Esto permite investigar propiedades como posibles interacciones no estándar o la existencia de partículas mediadoras nuevas.

En un plano más práctico, detectores compactos como el de CONUS+ podrían usarse para monitorizar en tiempo real el funcionamiento de reactores nucleares, midiendo su potencia o la composición de sus isótopos combustibles sin necesidad de acceso intrusivo. También podrían desempeñar un papel en experimentos de astrofísica o en la detección de neutrinos procedentes de supernovas.

Mejoras y futuro del proyecto

El equipo no se ha detenido con este primer resultado. A finales de 2024 instalaron una nueva generación de detectores de germanio, cada uno de 2,4 kilogramos, con umbrales de energía aún más bajos. Mantendrán en funcionamiento uno de los detectores originales para comparar las distintas fases del experimento y garantizar la consistencia de las mediciones.

En el horizonte, el objetivo es reducir las incertidumbres sistemáticas, como la calibración de energía, y aumentar la estadística de eventos, especialmente durante los periodos con el reactor apagado, cuando el fondo se mide con mayor claridad. Esto permitirá poner a prueba teorías más allá del Modelo Estándar y afinar parámetros de interés en física nuclear y de partículas.

Si estas mejoras se cumplen, la colaboración espera que CONUS+ se convierta en un referente mundial en la medición de CEvNS en reactores y que sus datos sean combinados con los de otros experimentos, como COHERENT, para extraer información sobre la estructura de los núcleos y las propiedades fundamentales de los neutrinos.

Referencias

- Ackermann, N., Bonet, H., Bonhomme, A., Buck, C., Fülber, K., Hakenmüller, J., Hempfling, J., Heusser, G., Lindner, M., Maneschg, W., Ni, K., Rank, M., Rink, T., Sánchez García, E., Stalder, I., Strecker, H., Wink, R. & Woenckhaus, J. (2025). Direct observation of coherent elastic antineutrino–nucleus scattering. Nature, 643, 1229–1233. https://doi.org/10.1038/s41586-025-09322-2.

OpenAI ha vuelto a sacudir el tablero de la inteligencia artificial con el lanzamiento oficial de GPT-5, la nueva iteración de su modelo estrella que da vida a ChatGPT. La compañía asegura que no es solo una mejora incremental, sino un salto cualitativo que acerca a sus usuarios a lo que describen como “tener un equipo de expertos con doctorado en cualquier tema” al alcance de un clic.

El anuncio, respaldado por el extenso comunicado técnico publicado por OpenAI, llega en un momento de competencia feroz en el sector, con gigantes como Google, Meta, Microsoft, Amazon, Anthropic y xAI invirtiendo cantidades astronómicas en desarrollar modelos más potentes, rápidos y versátiles. GPT-5 pretende situarse a la cabeza de esa carrera con mejoras sustanciales en razonamiento, precisión, versatilidad y seguridad.

Una evolución hacia el razonamiento profundo

Uno de los avances más destacados que recoge el paper técnico es la integración de un sistema de “pensamiento” interno capaz de decidir cuándo ofrecer una respuesta rápida y cuándo dedicar más tiempo a un análisis profundo. Este mecanismo, denominado GPT-5 Thinking, actúa como un “enrutador” que evalúa la complejidad de la consulta, el contexto y las herramientas necesarias antes de responder.

La consecuencia práctica es que el modelo no solo reacciona más rápido en preguntas sencillas, sino que, cuando el reto lo requiere, despliega un razonamiento más elaborado, explicando pasos intermedios y fundamentando sus conclusiones. Según las pruebas internas, esta capacidad ha permitido marcar récords en benchmarks de alto nivel, desde matemáticas de competición hasta razonamiento científico de doctorado.

Un asistente más preciso y menos propenso a errores

El informe técnico de OpenAI señala una reducción significativa en las llamadas “alucinaciones” —esas respuestas falsas o inventadas que minan la confianza del usuario—. En entornos controlados, GPT-5 mostró un 45 % menos de errores factuales que GPT-4o y hasta un 80 % menos que el modelo o3 de la propia compañía cuando se activaba el modo de razonamiento profundo.

Esta mejora no se limita a la exactitud. El equipo ha introducido un nuevo enfoque de respuestas seguras que sustituye la tradicional disyuntiva entre cumplir o rechazar una petición. En lugar de negarse de forma tajante ante una solicitud potencialmente peligrosa, GPT-5 intenta ofrecer una respuesta útil pero segura, evitando detallar pasos que puedan ser malinterpretados o mal utilizados.

Capacidades que tocan todos los frentes

OpenAI presenta GPT-5 como un modelo capaz de desenvolverse con soltura en múltiples disciplinas. En programación, no solo resuelve problemas técnicos, sino que puede generar aplicaciones completas a partir de descripciones informales. Esta función, conocida como vibe coding, convierte ideas vagas en software funcional, incluyendo diseño visual y optimización de la interfaz.

En el ámbito de la escritura, el modelo demuestra mayor dominio de estilos, formatos y matices culturales, lo que le permite pasar de la creación poética con recursos literarios complejos a informes corporativos de estructura impecable sin perder coherencia ni precisión.

En el terreno de la salud, las pruebas con el benchmark HealthBench evidencian su capacidad para formular preguntas relevantes, interpretar resultados y contextualizar información médica. Siempre bajo la advertencia de que no sustituye a un profesional, GPT-5 ofrece un acompañamiento más informado y adaptado al contexto del usuario.

En su faceta multimodal, mejora de forma notable el análisis de imágenes, diagramas y vídeos, razonando sobre ellos con mayor acierto y profundidad, lo que abre posibilidades en educación, investigación y comunicación visual.

Junto a las mejoras de fondo, el lanzamiento incorpora novedades que afectan directamente a la experiencia de uso. Ahora es posible elegir entre varias personalidades preconfiguradas, desde un estilo conciso y profesional hasta uno más irónico o reflexivo. También se integra con herramientas como Gmail, Google Calendar o Google Contacts para automatizar tareas y gestionar información personal.

La interfaz puede personalizarse con distintos colores y el tono de interacción se adapta sin necesidad de instrucciones detalladas. Sumado a la mayor obediencia a órdenes complejas, el modelo ofrece una experiencia más cercana y alineada con las preferencias de cada usuario desde el primer contacto.

Un despliegue masivo con estrategia escalonada

GPT-5 ya está disponible para todos los usuarios de ChatGPT, aunque con límites distintos según el tipo de suscripción. La modalidad gratuita permite acceder al modelo, pero con un uso diario restringido que después se deriva a una versión mini optimizada para consultas ligeras. Los usuarios de pago cuentan con mayor capacidad de uso y, en el caso de la suscripción Pro, acceso a GPT-5 Pro, la variante de razonamiento extendido que alcanza las cotas más altas en pruebas especializadas.

OpenAI ha aprovechado el momento para liberar también dos modelos de código abierto de menor tamaño, un movimiento que responde a la presión creciente por abrir el acceso a las arquitecturas y pesos de la inteligencia artificial.

Por otro lado, la compañía subraya que el aumento de capacidades ha ido acompañado de un refuerzo en los protocolos de seguridad. GPT-5 ha pasado por 5.000 horas de red teaming, en las que expertos han buscado vulnerabilidades y posibles abusos. También se ha reducido de forma drástica la tendencia a respuestas serviles que en el pasado provocaban un exceso de acuerdo o complacencia ante propuestas dañinas.

Sin embargo, especialistas en ética recuerdan que, aunque estos avances son notables, la distancia entre las capacidades de la tecnología y la capacidad de la sociedad para regularla sigue aumentando. La facilidad con la que modelos como GPT-5 pueden producir contenido indistinguible del humano plantea desafíos urgentes en autenticidad, derechos de autor y responsabilidad.

¿Un paso hacia la inteligencia artificial general?

Sam Altman reconoce que GPT-5 no alcanza aún el nivel de inteligencia artificial general, pero defiende que las capacidades actuales habrían sido inimaginables hace apenas cinco años y representan una parte significativa del camino hacia esa meta. El modelo sigue sin poder aprender de forma continua en tiempo real, una condición que el propio Altman considera esencial para lograr una AGI auténtica.

Mientras tanto, OpenAI mantiene su apuesta por incrementar la capacidad de cómputo y explorar nuevas arquitecturas que reduzcan los tiempos de razonamiento sin sacrificar calidad. En un entorno en el que cada trimestre puede redefinir las reglas del juego, GPT-5 se presenta como una plataforma robusta para explorar los límites de lo que la inteligencia artificial puede ofrecer hoy.

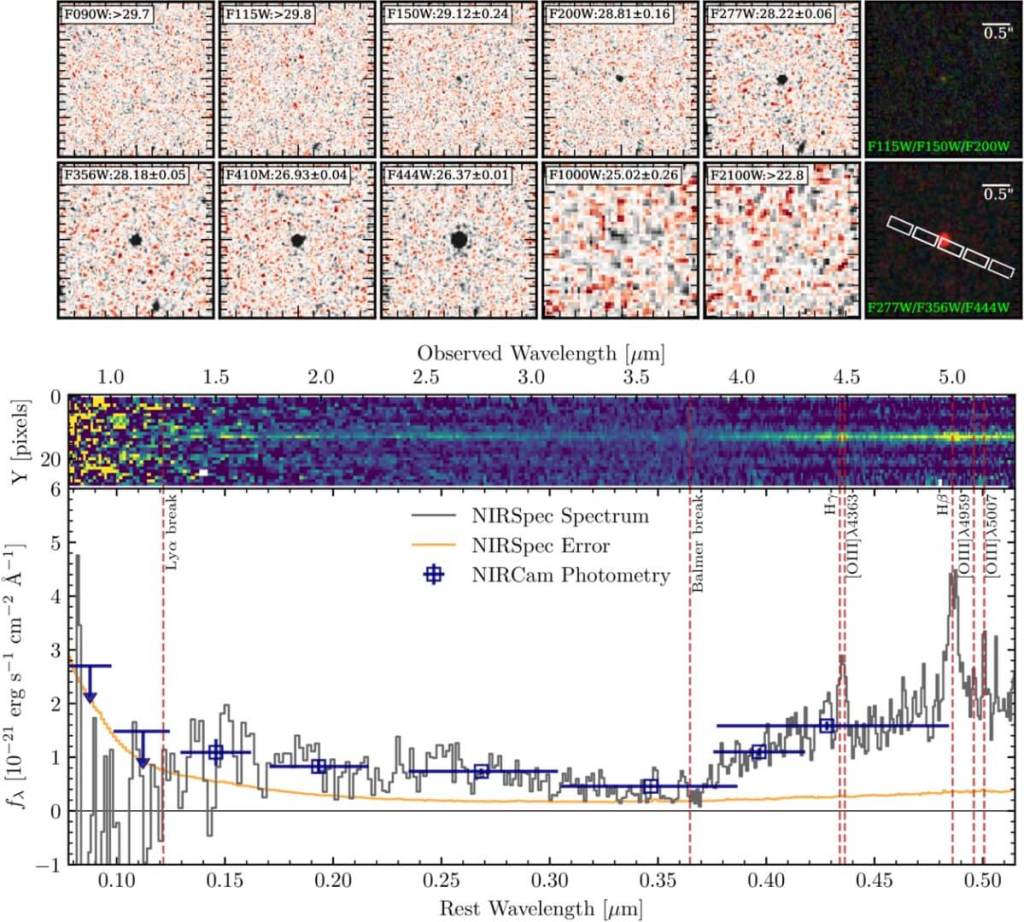

En los albores del universo, mucho antes de que existieran galaxias como la Vía Láctea, se estaban gestando las primeras estructuras capaces de dar lugar a estrellas. Estas semillas cósmicas, conocidas como minihalos de materia oscura, no solo atrajeron gas primordial, sino que lo comprimieron y agitaron con tal intensidad que moldearon el entorno donde nacerían las primeras estrellas.

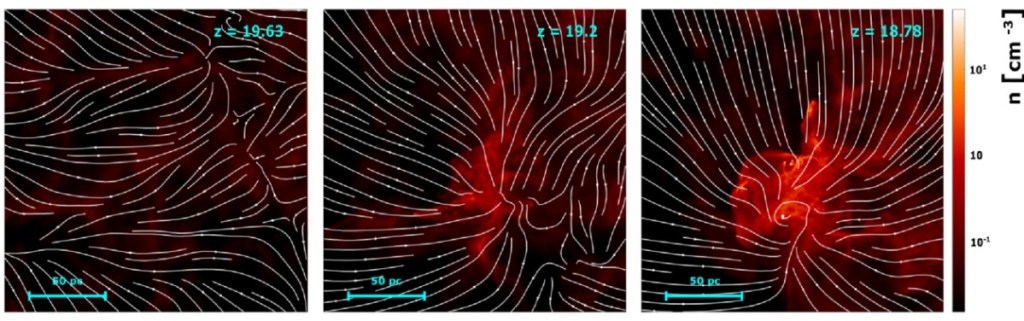

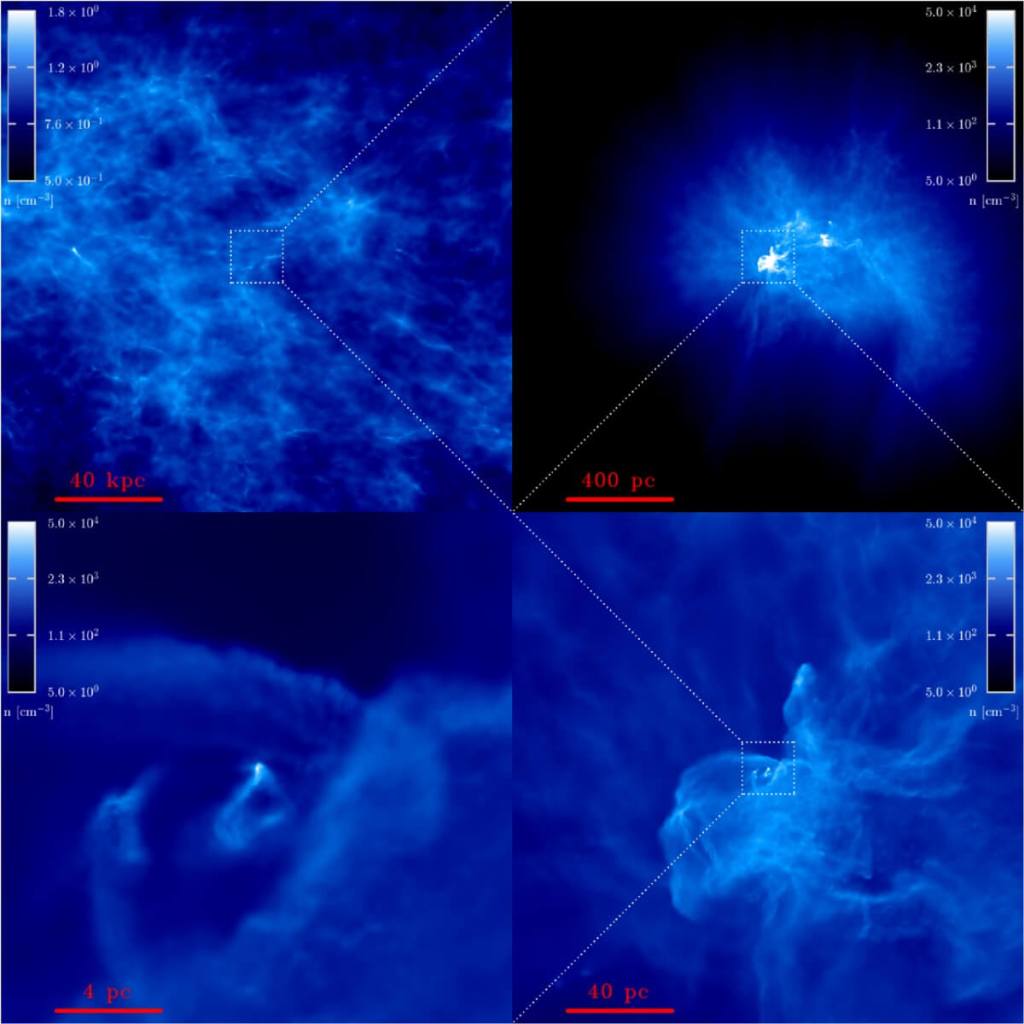

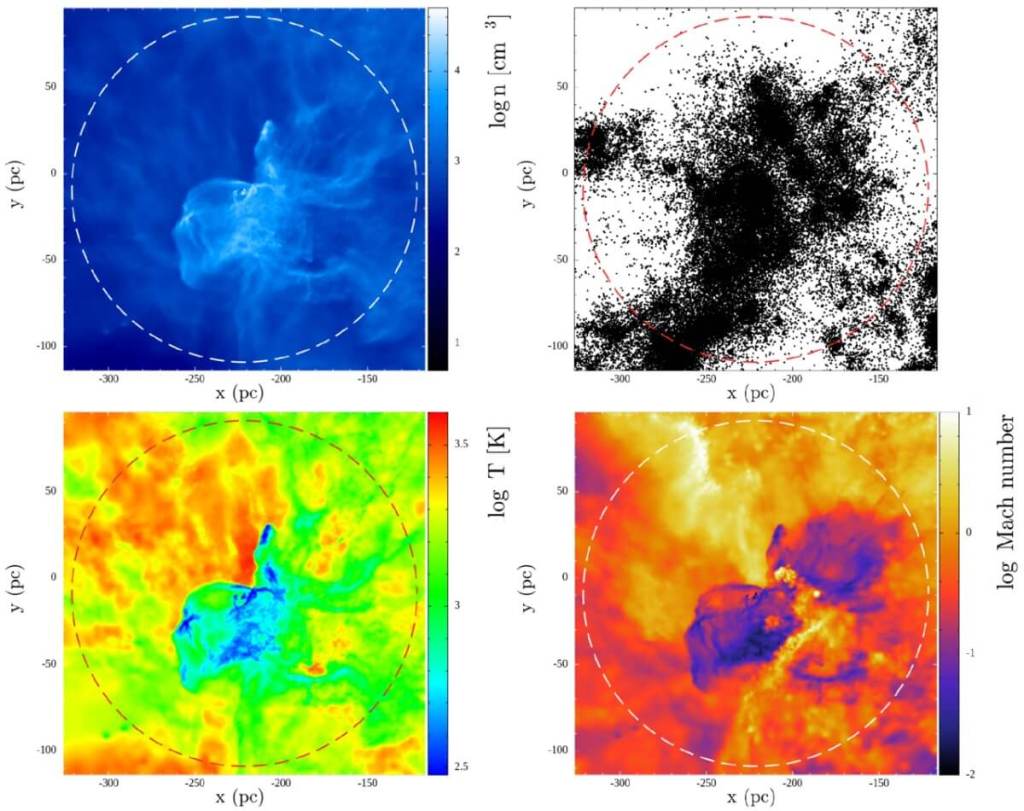

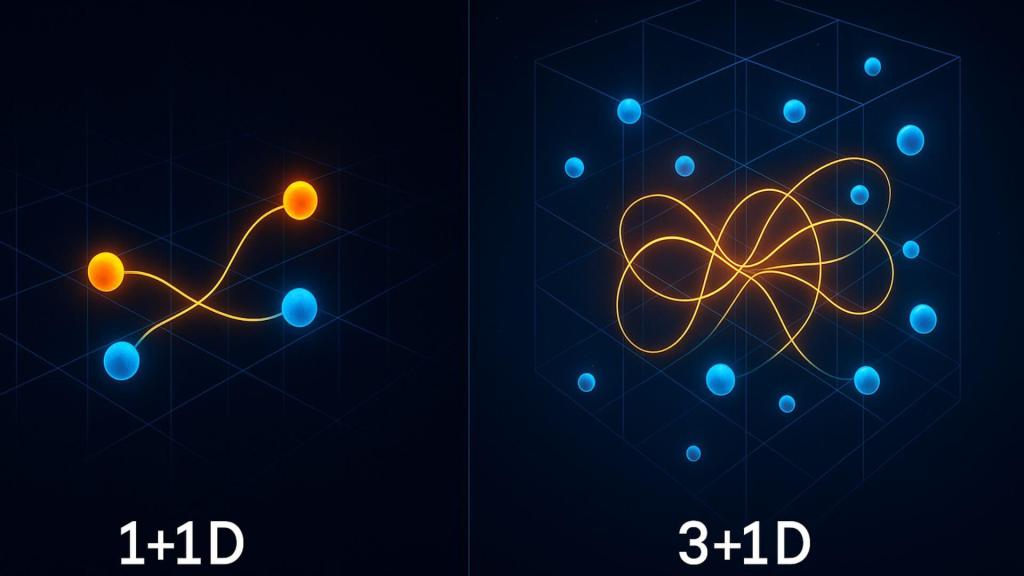

Gracias a simulaciones de altísima resolución, un equipo internacional ha podido observar este proceso con un nivel de detalle sin precedentes. El estudio, publicado en The Astrophysical Journal Letters y liderado por Ke-Jung Chen y sus colegas, revela que en el interior de estos halos se desarrolló turbulencia supersónica con velocidades cinco veces superiores a la del sonido. Este fenómeno no era un simple acompañante del colapso gravitatorio: fragmentaba las nubes de gas en múltiples grumos, reduciendo así el tamaño de las primeras estrellas. Como señala el artículo, “encontramos que una fuerte turbulencia supersónica con un número de Mach característico de ∼5,2 se desarrolla de forma natural dentro del halo en colapso”, un hallazgo que redefine lo que creíamos saber sobre los orígenes estelares.

El laboratorio cósmico del pasado

En el modelo cosmológico estándar, las fluctuaciones cuánticas surgidas tras el Big Bang crecieron con el tiempo gracias a la gravedad, formando una red de filamentos y nudos. En esos nudos, la materia oscura se concentraba en estructuras compactas que actuaban como “cunas” de las estrellas de Población III. Según el propio trabajo, “los llamados minihalos de materia oscura, con masas de ∼10⁵–10⁶ M⊙, se cree que son las cunas de las estrellas de Población III”.

El equipo partió de datos de la simulación cosmológica IllustrisTNG, que reproduce la evolución del universo a gran escala. De ahí extrajeron un minihalo en formación hace más de 13.000 millones de años y aumentaron la resolución original en un factor de 100.000 mediante una técnica de división de partículas. Este refinamiento les permitió seguir la dinámica del gas desde escalas de cientos de parsecs hasta el interior de la nube donde surgía la turbulencia.

Más allá de la mejora técnica, este enfoque permitió capturar cómo el entorno a gran escala influía en el núcleo formador de estrellas. Las interacciones gravitatorias, los flujos de gas y la propia estructura del halo condicionaban el tipo de turbulencia que se desarrollaba en su interior, algo que estudios con áreas más pequeñas no podían mostrar.

El papel de la turbulencia supersónica

La turbulencia supersónica implica que el gas se mueve y choca a velocidades varias veces superiores a la del sonido en ese medio, generando ondas de choque que comprimen y calientan la materia. En el minihalo estudiado, el número de Mach —que mide esta relación— alcanzaba picos de hasta 28, aunque la mayor parte del gas se situaba alrededor de 5.

Este tipo de flujo no es pasivo. Como detalla el equipo, “esta turbulencia remueve eficazmente el gas, favoreciendo la fragmentación de la nube formadora de estrellas en múltiples grumos densos”. En lugar de un único colapso que formara una estrella gigantesca, se producían varios núcleos más pequeños. En la simulación, uno de ellos alcanzó las 8,07 masas solares, lejos de las más de 100 que se atribuían a las primeras estrellas en modelos anteriores.

El hallazgo no solo redefine la masa típica de las primeras estrellas, sino que también plantea un cambio en su ciclo vital. Menos masa significa diferente luminosidad, distinta duración de vida y una composición química final alterada respecto a lo que produciría una estrella supermasiva.

Un proceso jerárquico y caótico

El gas no caía de forma uniforme sobre el halo, sino siguiendo patrones complejos. Flujos anisótropos, torsiones y acumulaciones locales creaban estructuras filamentosas que se extendían desde escalas de 100 parsecs hasta menos de 1.

Dentro de esos filamentos, las diferencias de densidad y temperatura eran marcadas: las zonas más densas se enfriaban gracias a la formación de moléculas de hidrógeno, lo que favorecía aún más el colapso. Este enfriamiento, combinado con el movimiento supersónico, daba lugar a un proceso de fragmentación múltiple.

Las imágenes de la simulación muestran cómo las irregularidades a gran escala se transmiten a escalas menores, dividiendo la nube en múltiples regiones potencialmente estelares. Este efecto de “cascada” es característico de la turbulencia y explica por qué la masa de las primeras estrellas podría haber sido mucho menor de lo previsto.

En este escenario, cada núcleo no es un sistema aislado, sino parte de una red de interacciones dentro del halo. Su evolución dependía tanto de sus propias condiciones como de la dinámica global del gas y la materia oscura circundante.

Consecuencias para la formación estelar temprana

Una de las grandes incógnitas de la cosmología observacional es por qué no encontramos firmas químicas claras de estrellas de Población III muy masivas. Si estas hubieran existido en gran número, sus explosiones de supernova deberían haber dejado huellas detectables en las generaciones posteriores de estrellas.

El nuevo estudio ofrece una respuesta plausible: la fragmentación inducida por la turbulencia habría limitado la masa de muchas de las primeras estrellas a valores inferiores a 40 masas solares. Este cambio en el rango de masas altera el tipo de supernovas resultantes y, por tanto, los elementos que liberan al medio interestelar.

De hecho, si el límite habitual fuera de menos de 80 masas solares, no se producirían las supernovas de inestabilidad de pares, cuya huella química es muy característica y, hasta ahora, ausente en los registros astronómicos. Así, el trabajo no solo describe un mecanismo físico, sino que aporta un argumento observacional sólido.

Simulación y técnica innovadora

Para llegar a este resultado, los autores no se limitaron a observar un pequeño volumen en alta resolución, como en estudios previos. Capturaron todo el entorno del halo desde su formación, lo que les permitió ver cómo la energía turbulenta se inyectaba a escalas de hasta tres veces el radio virial del halo.

Este detalle conecta directamente con los procesos de acreción de gas y materia oscura. La turbulencia se origina en interacciones a gran escala y luego se transmite a escalas menores, algo imposible de reproducir si solo se modela el núcleo central.

Gracias al refinamiento de partículas y a un modelo detallado de enfriamiento y química del gas primordial, el equipo siguió la evolución durante 17,5 millones de años de tiempo físico. Este seguimiento cubre la transición desde un halo en formación hasta una nube densa lista para formar estrellas.

Un futuro con más variables

Aunque este trabajo no incluye todos los ingredientes posibles —por ejemplo, no se han modelado los campos magnéticos—, los autores destacan que añadirlos podría enriquecer la imagen. En galaxias actuales, la turbulencia supersónica amplifica los campos magnéticos, y estos, a su vez, afectan a la formación de estrellas. Si algo similar ocurrió en el universo primitivo, el papel de la turbulencia sería aún más determinante.

Fenómenos como la velocidad de flujo entre materia bariónica y oscura, resultado de las oscilaciones acústicas de bariones en el universo temprano, también podrían modificar las condiciones iniciales del colapso. Aunque no se incluyó en este caso, su interacción con la turbulencia es un campo abierto para la investigación futura.

Mirando hacia la "aurora cósmica"

El periodo en que nacieron las primeras estrellas se conoce como el amanecer cósmico. Comprenderlo no es solo un reto teórico: tiene implicaciones directas para interpretar las observaciones del Telescopio Espacial James Webb y otros futuros instrumentos.

Al conocer mejor las condiciones físicas de los minihalos y el papel de la turbulencia, los astrónomos pueden afinar sus modelos para identificar las señales más sutiles de aquellas primeras estrellas. Como concluye el equipo, “nuestros resultados sugieren que la formación temprana de estructuras puede generar de forma natural turbulencia supersónica, que desempeña un papel crucial en el modelado de las nubes de gas primordiales y en la regulación de la escala de masas de las estrellas de Población III”.

Referencias

- Chen, K.-J., Ho, M.-Y., & Tung, P.-C. (2025). Formation of Supersonic Turbulence in the Primordial Star-forming Cloud. The Astrophysical Journal Letters, 988, L67. https://doi.org/10.3847/2041-8213/adf18d.

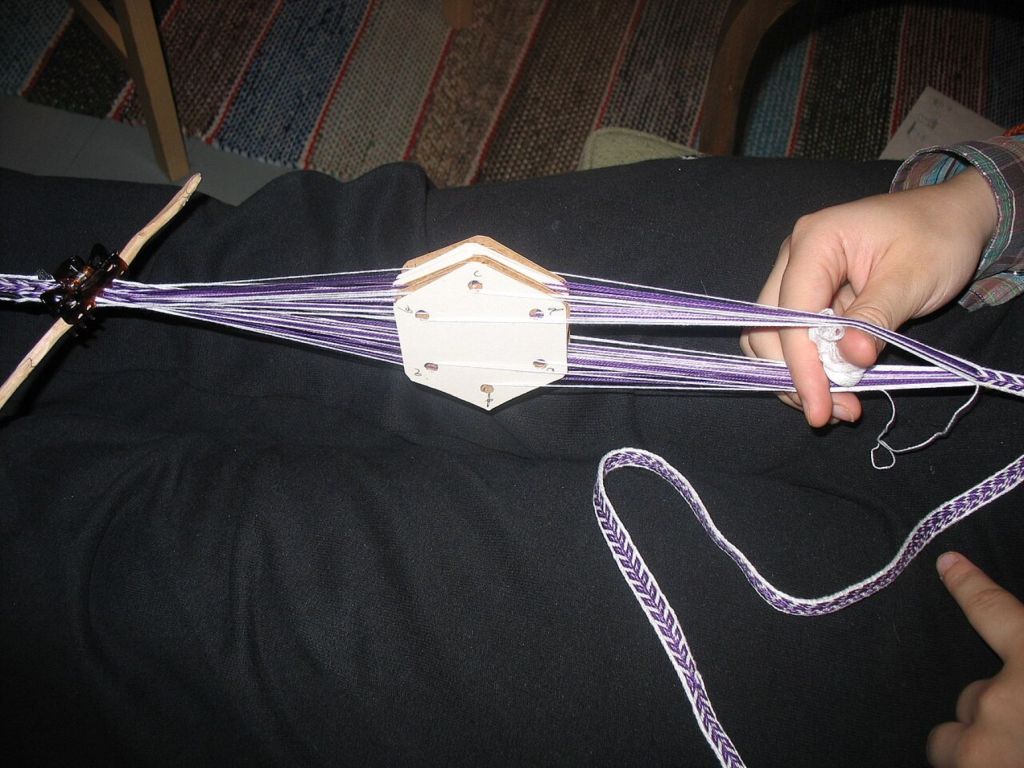

¿Cómo vivían realmente los habitantes del pasado? ¿Cómo se vestían? ¿Tenían un concepto de moda? Nos solemos hacer estas y otras preguntas cuando imaginamos la vida humana en otros tiempos y latitudes y, a veces, la historia y la arqueología logran responderlas. A principios del siglo XX, un grupo de arqueólogos descubrieron, en el helado asentamiento noruego de Herjolfsnes, un conjunto de prendas medievales notablemente conservadas gracias a las condiciones anaeróbicas de una turbera. Entre ellas, se encontraba el denominado "vestido 38". Ahora, un equipo interdisciplinar del Carleton College (Northfield, Minnesota) ha emprendido un ambicioso proyecto de arqueología experimental con el objetivo de reproducir fielmente esta prenda de lana.

La importancia de las prendas de Herjolfsnes

Los restos de vestuario hallados en Herjolfsnes se han datado entre los siglos XIV y XV. Constituyen un conjunto excepcional dentro del panorama arqueológico textil del norte de Europa. Los climas húmedos y fríos no suelen ayudar a que sobrevivan los tejidos naturales, por lo que estos hallazgos excepcionales han permitido reconstruir, en gran medida, la vestimenta cotidiana de las poblaciones nórdicas medievales.

El vestido 38 se recuperó, junto al cuerpo, en una tumba de turbera. Poul Nørlund ya documentó el hallazgo minuciosamente en 1924 y casi un siglo después, en 2011, Fransen, Nørgaard y Østergård presentaron nuevos datos en un artículo publicado en Medieval Garments Reconstructed. Ambos trabajos fueron fundamentales para poder realizar el actual experimento.

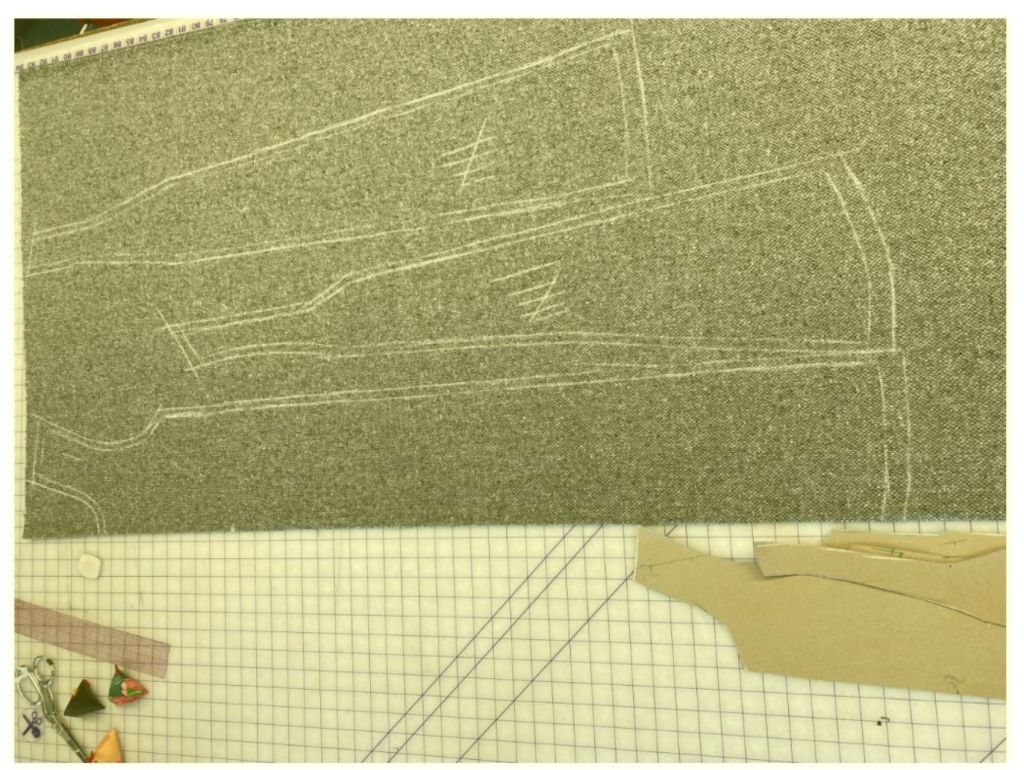

Diseñar un patrón desde el original

El equipo liderado por Jake Morton, Ruby Becker y Helen Banta decidió construir el patrón desde cero basándose en los dibujos originales del vestido presentes en el volumen Medieval Garments Reconstructed. Esta decisión les permitió comprender a fondo lel modo en el que se había diseñado la prenda y adaptarla con precisión a las medidas de su modelo, a la sazón Becker. Si bien el vestido original se creó para adaptarse al cuerpo de una persona de unos 140–147 cm de estatura, el nuevo patrón se ajustó para que pudiese servirle a una persona de 170 cm. Las responsables d ela reconstrucción respetaron las proporciones originales para que no alterar la caída original del vestido.

Materiales elegidos con criterios arqueológicos

Uno de las decisiones fundamentales de este experimento tuvo como objetivo la selección rigurosa de los materiales. Para la confección, se utilizó una tela de lana 100% con un tejido relativamente suelto, similar al del original, procedente de de Kerry Woollen Mills (Irlanda). La elección del hilo, las agujas y las técnicas de acabado también respondieron a criterios arqueológico. Así, emplearon hilo de lana sin teñir, agujas antiguas similares a las usadas para coser lona (por su semejanza con las medievales) y cera de abeja para endurecer y proteger el hilo, un método documentado en el registro arqueológico.

Dos técnicas de costura en un solo vestido

El experimento tiene un punto de originalidad a mayores. El equipo de Morton dividió el vestido en dos mitades: cosieron una de ellas aplicando las técnicas modernas de costura a mano, mientras que confeccionaron la segunda siguiendo los métodos documentados en el siglo XIV. Esta aproximación comparativa permitió evaluar las diferencias en las resistencia, la estética, la facilidad de ejecución y la adaptabilidad de las costuras.

En la mitad medieval del vestido, las costuras se realizaron mediante una técnica de solapado de telas, donde la costura principal permanece invisible en la parte exterior del vestido. Todo ello genera un acabado discreto y funcional. A diferencia de la costura moderna a mano, que resulta más visible, la técnica medieval demostró ser la más adecuada para trabajar tejidos gruesos y tramas sueltas. Así, el equipo constantó que las técnicas tardomedievales facilitan la inserción de piezas triangulares (los denominados gussets o cuñas) al tiempo que permite ajustes precisos sin necesidad de planchado.

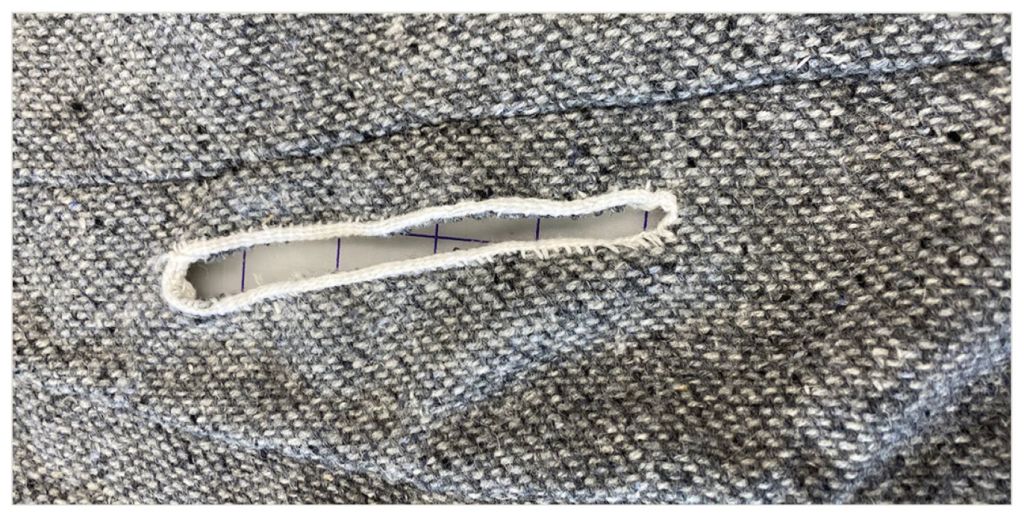

La inserción de cuñas: una prueba clave

Uno de los momentos claves del proyecto que puso de relieve las fuertes diferencias entre las técnicas modernas y las medievales de confección fue la incorporación de las cuñas o gussets —piezas de refuerzo y ampliación típicas de la indumentaria medieval— en el frontal y la parte trasera del vestido. Mientras que la cuña moderna, cosida con pespunte, produjo tensiones visibles en la tela y requirió de un planchado para quedar plana, la cuña cosida con técnica medieval se adaptó al tejido sin formar arrugas y conservando mejor la caída de la prenda. Esto pruebaque las técnicas de costura medievales estaban pensadas para adaptarse a las necesidades del diseño modular de la época.

El desafío del acabado: dobladillos y tejido con un telar de tarjetas

Otro elemento característico que se logró reproducir fue el tejido con telar de tarjetas, presente en los dobladillos y las aberturas del vestido original. A pesar de la dificultad inicial, esta técnica permitió crear un borde decorativo y muy resistente sin añadir volumen a la prenda, a diferencia del moderno dobladillo doblado que, aunque más rápido de hacer, resulta menos estable. Aunque tejer los acabados con un telar de tarjetas fue el paso más laborioso del proceso, el equipo concluyó que su efecto tanto visual como funcional justificaba su uso.

Las mangas: adaptación y reconstrucción

Las mangas supusieron un un reto técnico considerable, tanto por su patrón poco convencional como por la falta de detalles al respecto en las fuentes. El equipo consultó a distintos especialistas en moda y confección histórica para obtener datos que les permitiesen comprender dónde colocarlas en el vestido, así como determinar la función de los refuerzos triangulares en la parte trasera de la manga.

La reconstrucción experimental demostró que el diseño medieval favorecía la libertad de movimiento y se adaptaba mejor a las tensiones producidas en la zona de los hombros que los patrones actuales. En este caso, sin embargo, la técnica moderna resultó más sencilla de ejecutar. Esto podría explicarse por la falta de experiencia del equipo con las técnicas de cosidos medievales en zonas curvas.

Los bolsillos: funcionalidad en clave medieval

Una diferencia sorprendente se halló en la construcción de los bolsillos. En vez de un bolsillo con fondo cosido a la prenda, como en la ropa moderna, el vestido 38 presentaba unas simples aberturas reforzadas a través de las cuales se podía acceder a las bolsas portadas bajo la ropa. El experimento reveló, además, que los acabados medievales hechos con telar de tarjetas no solo eran más duraderos, sino también más estéticos y prácticos, en comparación con los bordes sobrehilados de la versión moderna, que tendían a deshilacharse.

Un vestido de 600 años

El experimento de reconstrucción del vestido de Herjolfsnes, además de aportar luz sobre las técnicas textiles del pasado, también demostró la eficacia y la funcionalidad de los métodos de costura medievales en condiciones reales de trabajo. Como han podido probar las estudiosas resposanbles del artículo, estos métodos ofrecían ventajas concretas frente a los procedimientos modernos. Se consumía menos hilo, el tejido se adaptaba mejor a la forma del cuerpo y resultaba más fácil insertar refuerzos. Además, el acabado era más discreto y no requería de planchado.

La experiencia también demostró que la ropa medieval estaba diseñada no solo para ser usada, sino también para ser reparada. Por ello, este proyecto nos invita a repensar nuestra relación con la confección, el consumo y la durabilidad de las prendas a partir de un vestido que pasó siete siglos enterrado en una turbera.

Referencias

- Morton, Jake, Ruby Becker y Helen Banta. 2025. "Resurrecting a Bog Dress: A Comparative approach to Medieval Textile Construction." EXARC Journal 1. URL: https://exarc.net/ark:/88735/10783

Los smartphones actuales incorporan pantallas de alta frecuencia, cámaras con inteligencia artificial y baterías de carga ultrarrápida para una experiencia más fluida. También destacan por su conectividad 5G y mejoras en eficiencia energética.

Con el verano en su punto álgido, Samsung refuerza su presencia en la gama media con una rebaja destacada en su Galaxy A16 LTE de 256 GB.

Aunque su precio habitual supera los 186€ en tiendas como Amazon o MediaMarkt, la alianza entre la marca asiática y PcComponentes lo deja ahora en solo 160,65 euros.

Combina un sistema triple de cámaras traseras con un sensor principal de 50 MP para capturar fotos nítidas incluso en baja iluminación, acompañado de una lente gran angular de 5 MP y una macro de 2 MP para más versatilidad. Su cámara frontal de 13 MP asegura selfies y videollamadas de alta calidad. Además, incorpora una pantalla Super AMOLED FHD+ de 6.7 pulgadas, teniendo una tasa de refresco de 90 Hz.

Con una batería de 5000 mAh y carga rápida de 25W, el Galaxy A16 LTE ofrece 256 GB de almacenamiento permiten guardar miles de fotos, vídeos y apps sin problemas, junto a 8 GB de RAM y un procesador MediaTek G99 Octa-Core. La seguridad está garantizada con Samsung Knox, junto a desbloqueo facial y lector de huellas para un acceso rápido y seguro.

OPPO también se pone seria y reduce drásticamente el coste del RENO13 PRO 5G

Después del último movimiento de Samsung, OPPO no se queda atrás y reacciona con una fuerte rebaja en su Reno13 Pro 5G, que ahora baja hasta los 490 euros. Una ocasión atractiva, ya que su precio habitual en tiendas como Fnac, MediaMarkt, PcComponentes o Amazon supera los 565€.

Cuanta con resistencia extrema gracias a su exclusivo Butterfly Shadow Design, grosor de 7,55 mm, peso de 195 g y certificación IP69, lo que permite incluso fotografía submarina y uso con pantalla mojada gracias a Splash Touch. Su pantalla AMOLED FHD+ de 6,83 pulgadas con brillo máximo de 1.600 nits y 120Hz ofrece una experiencia visual fluida y vibrante, mientras que el modo Ultra Volumen 300% asegura un sonido claro sin auriculares.