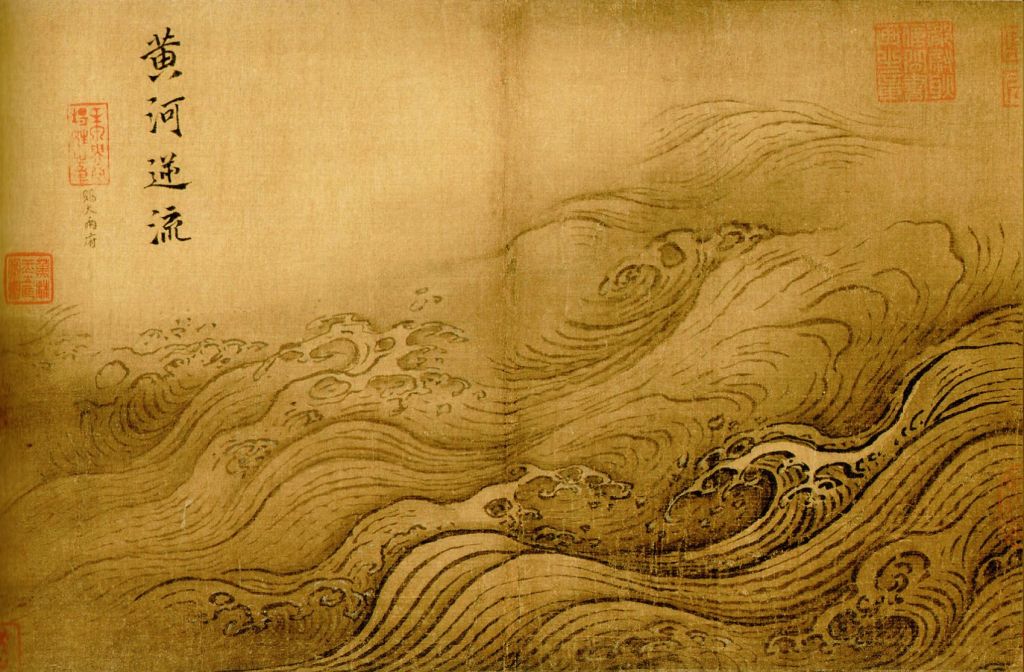

La Piedra del Sol, un disco de basalto de olivino de veinticuatro toneladas, permaneció sepultada más de doscientos años. El terrible rostro del dios que los aztecas tallaron sobre la roca entre 1250 y 1521 fue enterrado boca abajo por orden del arzobispo Alonso de Montúfar, en 1559. De su reposo no saldría hasta diciembre de 1790, cuando se iniciaron unas reformas urbanas en la entonces capital de Nueva España. Es decir, en la actual plaza de la Constitución de Ciudad de México, que reposa sobre la antigua Tenochtitlán, capital azteca. Pero ¿qué llevó a desear su desaparición? El monumento, que pudo formar parte de una plataforma gladiatoria sacrificial (temalácatl), luce la complicada cosmogonía de esta cultura.

En su centro, la deidad, posiblemente Tonatiuh, el astro rey, hambriento del tributo humano, aprisiona sendos corazones y saca la lengua, un cuchillo de pedernal. A su alrededor, se desenvuelve un registro del tiempo basado en la división de años, meses, semanas y días propia de esta civilización. Y, por eso, es conocido erróneamente como el calendario azteca. Cuando los españoles lo condenaron al olvido, se cerraba un ciclo de 52 años, en los que confluían el devenir religioso y el devenir civil, y temieron el renacer de las ceremonias paganas.

Pelotas, medicina y calendarios

Ejemplifica el sesgo con el que interpretamos manifestaciones culturales ajenas. «Las comunidades de las Américas desarrollaron prácticas matemáticas que, a diferencia de las difundidas por Occidente, estaban entremezcladas con su cosmovisión y trabajo diario», explica Hilbert Blanco-Álvarez, editor de la Revista Latinoamericana de Etnomatemática (RLE).

Empezamos nuestro viaje al pasado en Mesoamérica, una gran franja que va desde México hasta el norte de Costa Rica, y cuyos pueblos supieron medir con gran precisión el tiempo. Culturas como la tarasca, la olmeca, la mixteca, la zapoteca, la teotihuacana, la maya y la mexica (o azteca) formaron, entre el siglo xv a. C. y el xvi d. C., un intrincado y todavía indescifrado patrón.

Estas civilizaciones tuvieron en común, entre otras muchas cosas, el juego de la pelota, el nahualismo, el sacrificio humano, la medicina, el sistema de numeración, el calendario y la astronomía, según el antropólogo alemán nacionalizado mexicano Paul Kirchhoff.

Estos aspectos estaban tan estrechamente unidos como el cielo y la tierra, el paso de los días, la recogida de la cosecha, los impuestos y los ritos religiosos. El calendario habría nacido como compendio de las observaciones astronómicas y los cálculos matemáticos realizados a lo largo de cientos o miles de años.

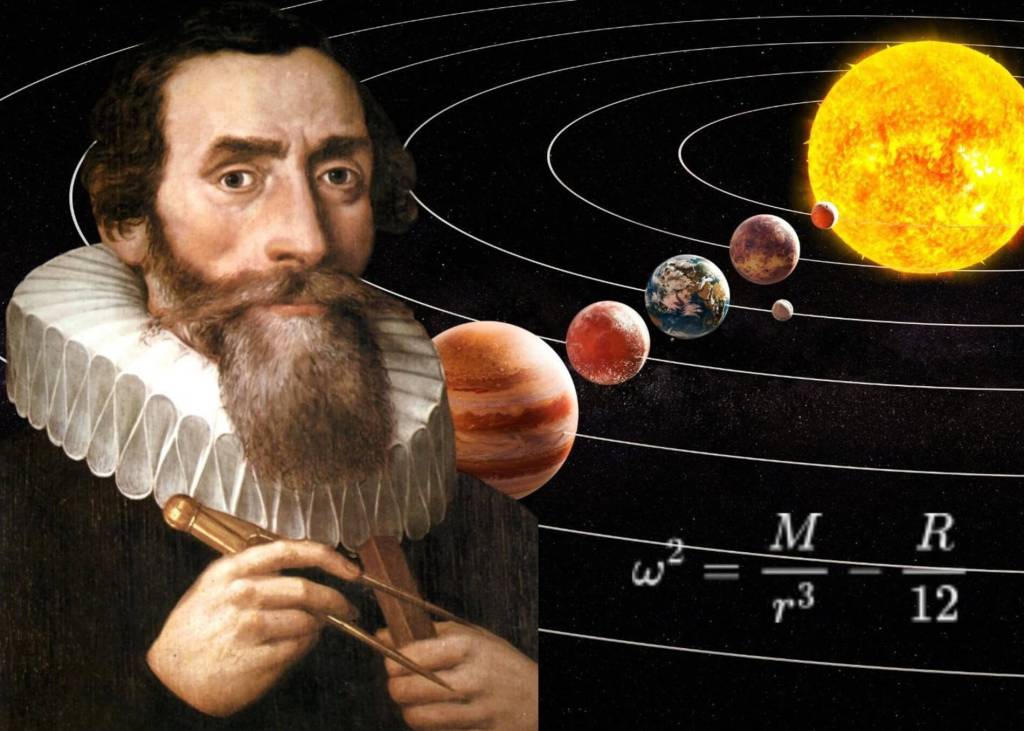

Uno de los más renombrados y precisos es el de los mayas, que fueron capaces de descifrar la duración del año solar (365,242 días frente a los 365,242198 actuales) y la del mes lunar (29,5302 días frente a los 29,53059 actuales).

Este pueblo usó tres calendarios: el tzolkin, sagrado o religioso; el haab, civil o solar; y la cuenta larga, una especie de escala temporal absoluta, cuya base podría ser la fecha fundacional maya: el 11 o el 13 de agosto de 3114 a. C.

Existen evidencias de que los olmecas tenían un método similar. Este pueblo, que vivió entre 1200 y 400 a. C., conforma la cultura madre de Mesoamérica y habría legado a sus más notorios sucesores el sistema numérico.

Con tres símbolos basta

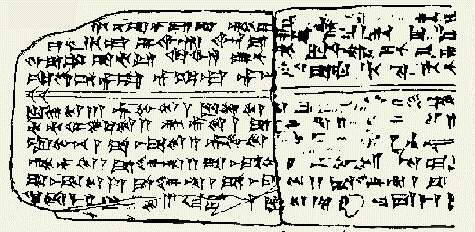

Los investigadores han podido acercarse a los conocimientos matemáticos de los mayas gracias a sus estelas, pinturas, jeroglíficos y manuscritos o códices. Poseían un «sistema de numeración vigesimal posicional de una gran eficacia y cuya representación solo requería de tres símbolos: el punto (uno), la raya (cinco) y el óvalo (cero)», aclaran los profesores Eugenio M. Fedriani y Ángel F. Tenorio en el artículo «Los sistemas de numeración maya, azteca e inca», publicado en Lecturas Matemáticas, vol. 25 (2004).

Así, los mayas podrían haber ejecutado las cuatro operaciones básicas –sumar, restar, multiplicar y dividir– e incluso obtener raíces. También representaban las cifras del uno al veinte con el llamado sistema de cabezas variables, que, según Fedriani y Tenorio, se basaba en una serie de jeroglíficos antropomórficos que representaban cabezas de deidades.

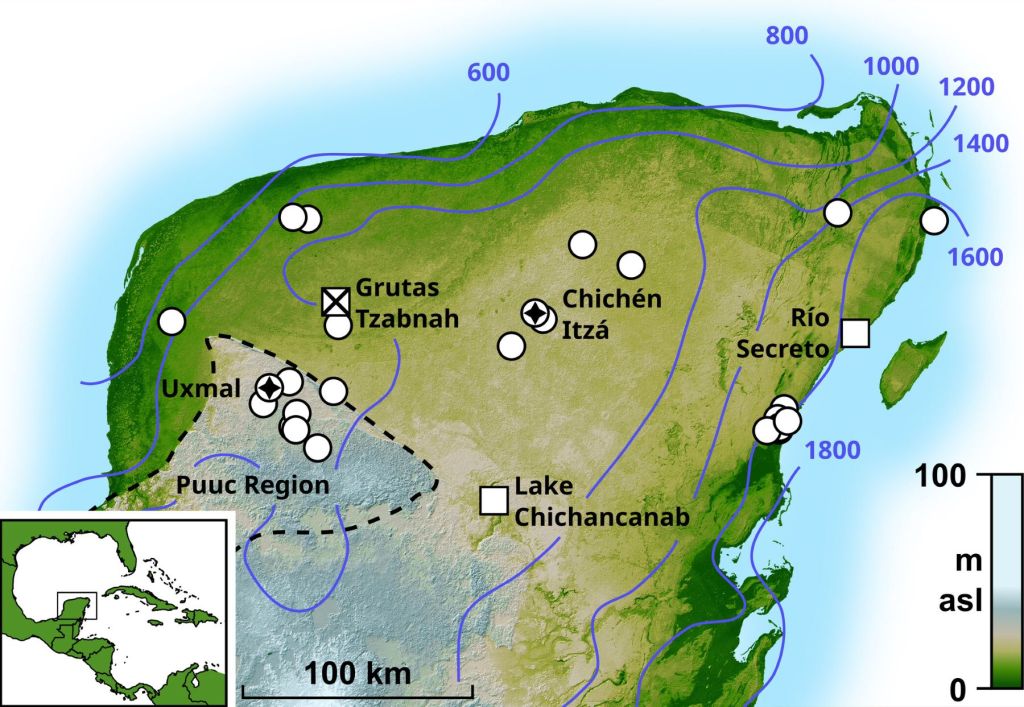

Al dominio de la astronomía, se unía el uso de la geometría, como demuestran sus magníficos palacios, pirámides, templos y observatorios. El complejo religioso maya de Chichén Itzá, el templo dedicado al dios Kukulcán –la serpiente emplumada–, encierra en sus armónicas proporciones referencias temporales, civiles y sagradas. Es el escenario de un fenómeno que ocurre al caer la tarde durante los equinoccios de primavera y otoño, cuando una sombra serpenteante desciende por una de sus escalinatas.

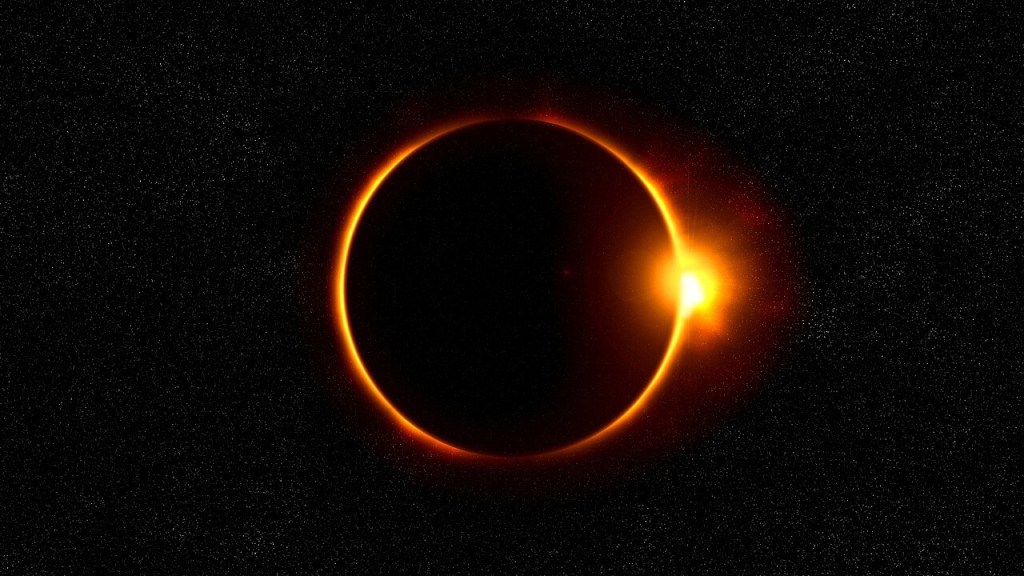

El prodigio es el resultado de la observación de las variaciones de la luz y las sombras durante cada día del año, causadas por la posición del Sol y los movimientos de la Tierra, y de la orientación final de una de sus fachadas. ¿Casualidad? Desde Chichén Itzá se puede observar el tránsito de Venus como un lunar negro sobre el Sol; portento que tuvo lugar en 2012 y se repetirá en 2117.

Porque los mayas calcularon los periodos sinódicos de Venus y Marte, y quizá de Júpiter y Saturno, y supieron predecir eclipses solares y lunares.

Grandes topógrafos

Para cuando llegaron los españoles, reinaban los aztecas o mexicas. En 1519, su capital, Tenochtitlán, era una de las ciudades más formidables del mundo, con cerca de 250 000 habitantes. A los aztecas, quienes también usaron un sistema vigesimal, pero no posicional y carente del cero, se les atribuye un procedimiento más intuitivo, menos eficiente que el maya y caracterizado por la posibilidad de anotar un número de al menos tres maneras.

Como su sistema económico se basaba en la agricultura y la recaudación de tributos, realizaban mediciones topográficas con el objetivo de fijar los impuestos que debían pagar sus súbditos. Las académicas Carmen Jorge y Jorge (Universidad Nacional Autónoma de México) y Barbara Williams (Universidad de Wisconsin) han descubierto que para ello, además de la técnica de multiplicar ancho por largo, recurrían a las fracciones, entidades unitarias similares a las pulgadas y los minutos. Dibujos de flechas, corazones, huesos, brazos y manos representaban partes del todo. Armados de esa diligencia catastral, censal y agrimensora, demostraron a los españoles que les exigían de más.

Guardianes de nudos

A 5000 kilómetros de allí, el rey inca tutelaba a unos diez millones de personas. Lo hacía desde el ombligo del mundo, Cuzco, la capital del Tahuantinsuyo, un imperio que se extendía desde el sur de Colombia hasta el norte de Chile. El orden y la organización regían este imperio, en el que una legión de funcionarios se afanaba por registrar información, a pesar de que esta civilización careció de escritura.

Los incas contaron con un sistema de numeración decimal posicional que definió la base de su administración y organización social. Con fines censales, distribuyeron a la población en grupos, de manera que los responsables multiplicaban su radio de autoridad directa por diez: el puriq, el cabeza de familia, era el encargado de una unidad, su familia; el chunka kamayuq, de diez familias; el pachaka kamayuq, de cien; el waranqa kamayuq, de mil; el hunu kamayuq, de diez mil... Así pudieron establecer un control sobre el trabajo, la producción y los impuestos.

A ello responden los quipus, cuerdas anudadas que servían para anotar información numérica y quizá histórica y cultural. El registro y seguimiento de la información corría a cargo de los quipucamayoc o guardianes de los nudos; cada ciudad podía tener entre uno y treinta.

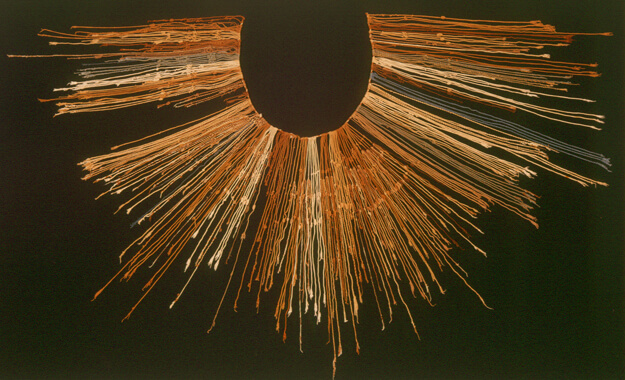

Los quipus –nudos, en quechua– estaban formados por un grueso cordel central, sin nudos, que podía medir entre diez centímetros y tres metros y del que pendían otras cuerdas, hechas de algodón o lana, según describen las profesoras Mónica Lorena Micelli y Cecilia Rita Crespo Crespo en su artículo «Ábacos de América prehispánica».

Estas cuerdas colgantes, a su vez, se caracterizaban por distintas longitudes y colores. El amarillo simbolizaba el oro; el blanco, la plata; el rojo, el número de guerreros; y el negro, el tiempo. Cada cuerda secundaria representaba un número, formado a partir de una secuencia de grupos de nudos en base decimal. La decena de millar ocupaba la posición más alta, le seguía la unidad de millar y la secuencia seguía hasta llegar a la unidad en el extremo inferior. El cero se indicaba con un espacio mayor de lo normal. En las ruinas de la ciudad sagrada de Caral, cuna de las culturas andinas, se ha hallado el ejemplar más antiguo, del año 2500 a. C.

El secreto de la cruz del sur

Fueron también avezados ingenieros. Entre sus conocimientos matemáticos, destacó el dominio de una geometría práctica que posibilitó el desarrollo de monumentos, ciudades y fortalezas, puentes colgantes y otras obras de ingeniería civil, entre ellas canales de irrigación y el famoso Qhapaq Ñan, 5200 kilómetros de calzada que se unieron a una extensa red viaria de más de 20 000 kilómetros.

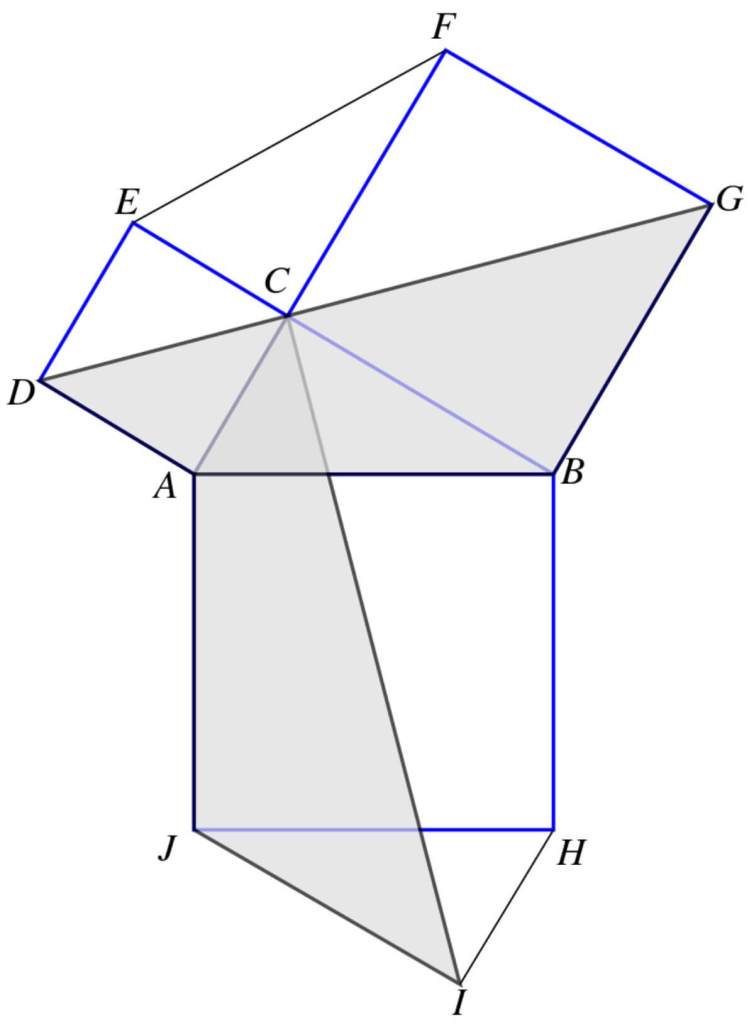

Según Leonardo Alcayhuaman Accostupa, catedrático de la Escuela de Ingeniería Civil de la Universidad Ricardo Palma, en Lima (Perú), «la cruz cuadrada es una figura geométrica usada como símbolo ordenador de los conceptos matemáticos religiosos en el mundo andino [...]. Su forma se origina de un desarrollo geométrico que toma como punto de partida un cuadrado unitario que, al crecer por diagonales sucesivas, permite determinar con bastante exactitud el valor de pi (π) y conformar un sistema». Conocida como la cruz del sur, chacana o cruz andina, este emblema escalonado de doce puntas es fruto de la observación astronómica y contiene la particular cosmogonía andina.

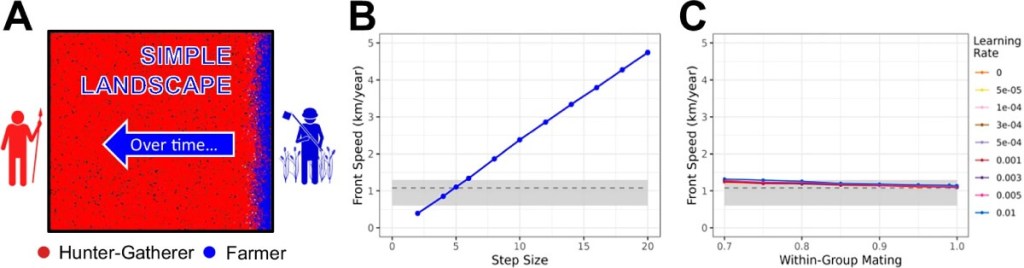

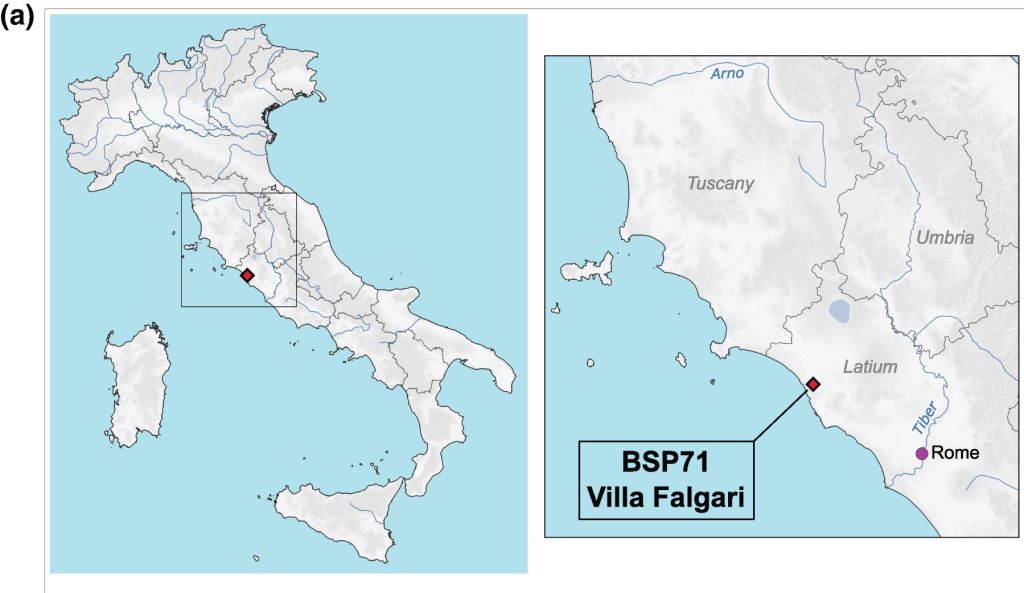

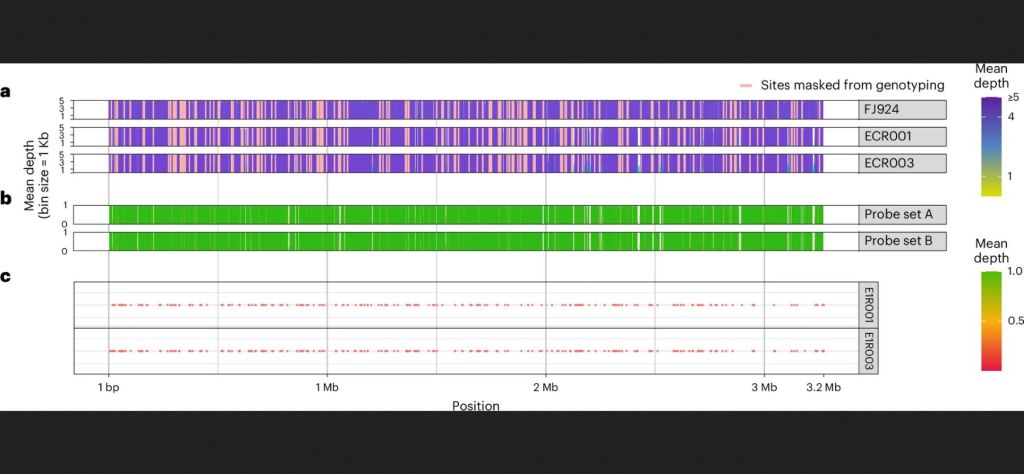

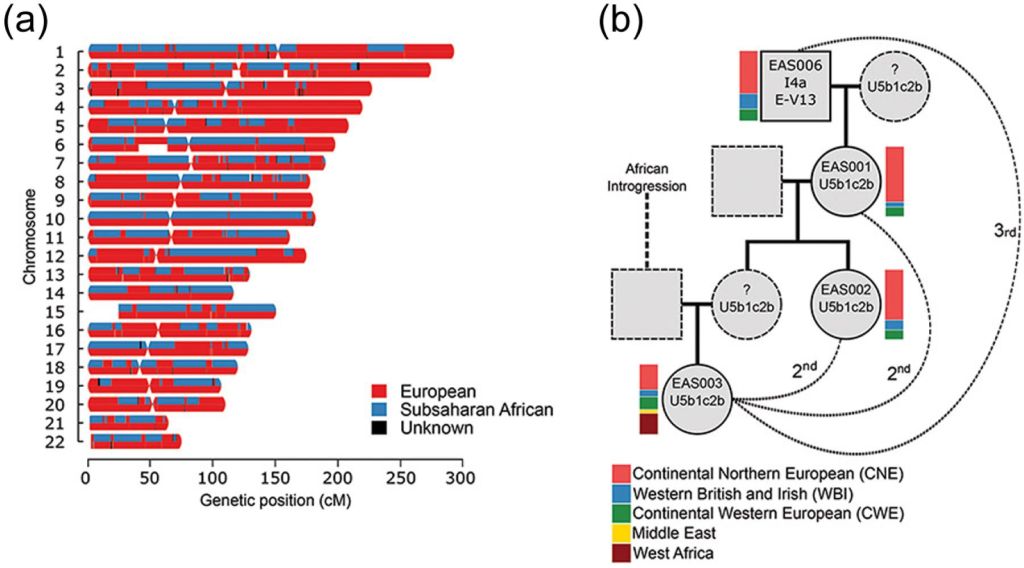

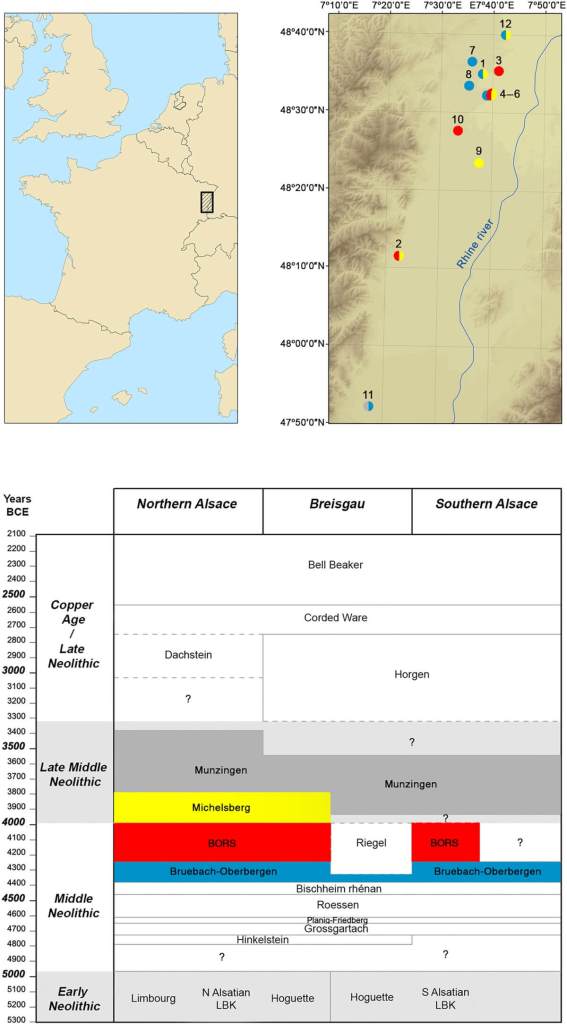

Hace unos 10.000 años, en algún lugar del suroeste asiático, alguien sembró una semilla y esperó... Ese gesto (imaginario), que hoy parece cotidiano, transformó la historia humana. Las comunidades dejaron de depender exclusivamente de lo que cazaban o recolectaban y empezaron a vivir de lo que cultivaban. Pero ¿cómo llegó esta forma de vida a Europa? La historia tradicional decía que los grupos locales de cazadores-recolectores fueron adoptando poco a poco las nuevas técnicas de cultivo. Sin embargo, un nuevo estudio liderado por investigadores de Penn State propone un giro radical a esta narrativa.

Combinando genética antigua, modelos matemáticos y simulaciones computacionales, el estudio publicado en Nature Communications concluye que la agricultura no se difundió como una idea entre vecinos, sino que llegó con poblaciones migrantes que trajeron consigo sus cultivos, sus animales y su ADN. La contribución de la transmisión cultural —es decir, que los locales aprendieran a cultivar observando o conviviendo con los recién llegados— fue prácticamente nula. Algo que hoy pervive, ¿pues no es habitual que una persona se lleve sus alimentos y recetas a los países a los que va a vivir?

ADN antiguo y un viejo debate

Es bien sabido que desde hace décadas, tanto arqueólogos como genetistas han debatido qué mecanismo impulsó la expansión agrícola en Europa: ¿fue un fenómeno cultural o demográfico? El primer modelo, llamado difusión cultural, sugiere que los pueblos cazadores-recolectores adoptaron gradualmente las técnicas agrícolas de sus vecinos. El segundo, conocido como difusión demográfica, sostiene que fueron los propios agricultores quienes se desplazaron y ocuparon nuevos territorios, desplazando o sustituyendo a las poblaciones locales.

La novedad del trabajo dirigido por Christian D. Huber y Troy M. LaPolice es que integra ambos mundos: genética y simulación demográfica, lo que permite cuantificar con precisión cuánto pesó cada factor en la expansión de la agricultura. En palabras del artículo: “nuestros hallazgos indican una transmisión cultural limitada y un apareamiento predominantemente dentro del mismo grupo”. Es decir, los grupos agricultores y los grupos cazadores-recolectores coexistieron, pero apenas se mezclaron ni cultural ni genéticamente.

Modelos, simulaciones y 618 genomas

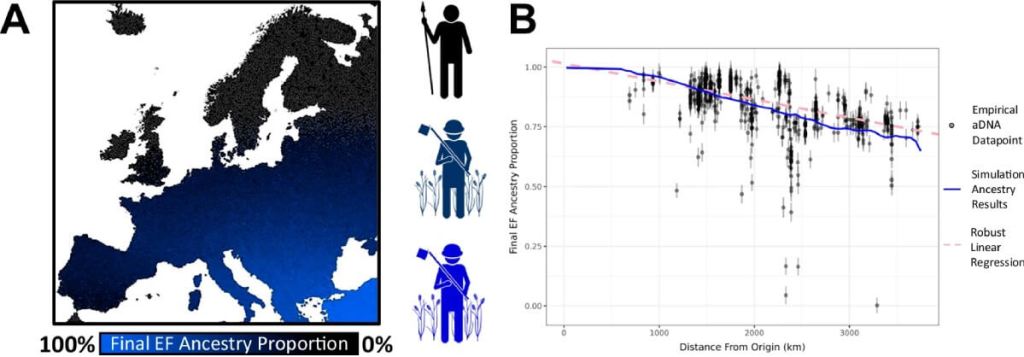

El equipo de Penn State desarrolló simulaciones computacionales basadas en ADN antiguo de 618 individuos europeos del Neolítico, fechados entre hace 8.500 y 5.000 años. A través de estos datos y un mapa digital de Europa, modelaron cómo se expandió la agricultura desde Anatolia —el origen más probable— hacia el resto del continente.

El resultado más claro es que la tasa de aprendizaje cultural era extremadamente baja. Según los modelos, solo un 0,1 % de los agricultores convertía a un cazador-recolector en agricultor por año. Traducido: en una comunidad de mil agricultores, solo uno lograba transmitir sus conocimientos agrícolas a un miembro de otro grupo en un año. Este dato es consistente con el patrón de ADN observado, donde la mayor parte de la herencia genética pertenece a los agricultores migrantes.

Además, se estimó que el apareamiento entre grupos era inferior al 3 %, lo que refuerza la idea de barreras sociales o culturales fuertes entre agricultores y cazadores. Como señala el estudio, “hubo un apareamiento predominantemente dentro del mismo grupo, con muy pocos emparejamientos entre agricultores y cazadores-recolectores”.

Lo que dice el ADN (y lo que no dice)

El ADN antiguo ha revolucionado nuestra capacidad para reconstruir el pasado. En este caso, permitió observar con claridad cómo el componente genético de los primeros agricultores se fue extendiendo por Europa. Sin embargo, el ADN no puede explicar por sí solo los comportamientos, las decisiones ni las dinámicas culturales. Por eso este trabajo combina modelos matemáticos con datos arqueológicos y genéticos, lo que permite interpretar no solo qué poblaciones estaban allí, sino cómo interactuaban entre sí.

Uno de los hallazgos más interesantes es que incluso con una expansión principalmente demográfica, no siempre se produce un reemplazo completo de la población local. Es decir, los grupos migrantes pueden imponerse culturalmente sin borrar completamente la huella genética de los pueblos anteriores. Este matiz es crucial: si solo miráramos el ADN, podríamos malinterpretar ciertas expansiones como puramente culturales, cuando en realidad fueron migratorias, pero sin sustitución total.

¿Y si no fue un aprendizaje, sino una presión?

Aunque el modelo de Huber y su equipo se refiere a “aprendizaje”, no se especifica si este fue voluntario. La transmisión cultural, en este contexto, no implica necesariamente que los cazadores-recolectores eligieran cambiar su modo de vida. Podría haber habido presiones económicas, sociales o incluso conflictos que los empujaran hacia el nuevo sistema. De hecho, estudios previos han documentado alta conflictividad en algunos puntos del Neolítico europeo, lo que refuerza la hipótesis de que la transición al cultivo no siempre fue pacífica ni consensuada.

Este dato abre otra línea de debate: ¿cuánto de la revolución agrícola fue una elección libre y cuánto una necesidad impuesta? Aunque el artículo no entra a fondo en este terreno, sí deja claro que la adopción de la agricultura fue, en términos cuantificables, mínima por parte de las poblaciones locales.

Un patrón que se repite

Este modelo de migración con mínima mezcla genética no es único del Neolítico europeo. También se ha documentado algo similar con la expansión de la cultura Campaniforme en la Edad del Bronce. Al principio, parecía una difusión cultural —porque los objetos y estilos se expandían sin grandes cambios genéticos—, pero estudios recientes han revelado que también hubo migraciones importantes, aunque sin reemplazo completo de las poblaciones previas. Lo mismo puede decirse de algunas fases de la expansión agrícola en el Próximo Oriente.

Esto sugiere que la dicotomía clásica entre “expansión cultural” y “expansión demográfica” puede ser demasiado rígida. Tal vez debamos empezar a hablar de modelos mixtos, donde los cambios culturales y genéticos no siempre van de la mano ni en la misma proporción.

Una nueva mirada a la prehistoria europea

El trabajo de LaPolice, Williams y Huber ofrece mucho más que un dato técnico. Propone una nueva manera de leer la historia europea, en la que la agricultura fue introducida por migrantes que se movían, se asentaban y transformaban el paisaje humano y genético a su paso. La herencia de ese movimiento sigue viva en el ADN de millones de europeos actuales.

Aunque la idea de que los pueblos aprenden unos de otros es atractiva, los datos del ADN antiguo y la simulación demuestran que la transición agrícola en Europa fue, en su mayor parte, un fenómeno de reemplazo, no de adopción cultural. Eso no significa que no haya habido excepciones, mezclas o resistencias locales, pero sí deja claro cuál fue el motor principal del cambio.

Como concluye el artículo: “Nuestro análisis sugiere que solo una fracción mínima de los agricultores pudo haber estado activamente involucrada en interacciones culturales con los cazadores-recolectores”.

Referencias

- Troy M. LaPolice, Matthew P. Williams & Christian D. Huber. Modeling the European Neolithic expansion suggests predominant within-group mating and limited cultural transmission. Nature Communications. 2025. https://doi.org/10.1038/s41467-025-63172-0.

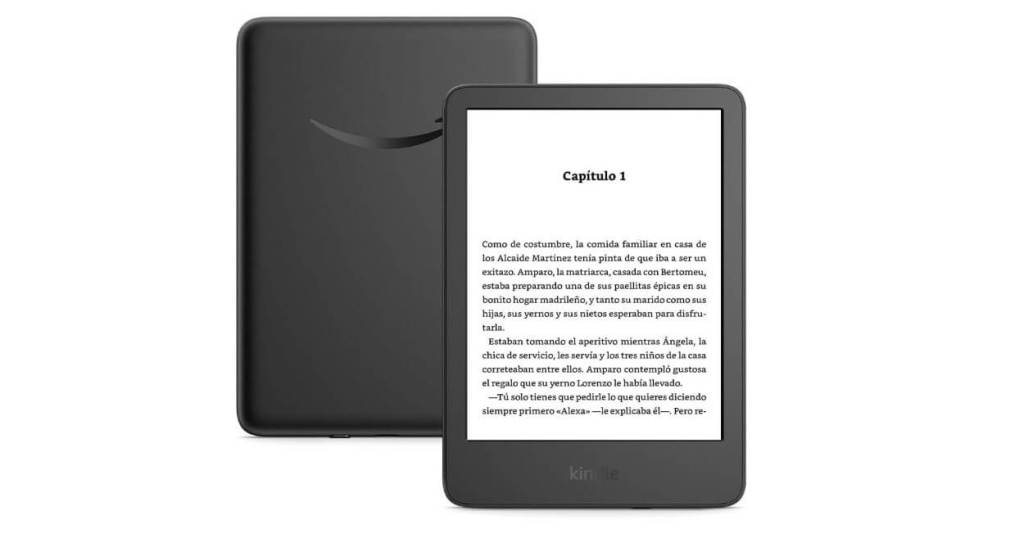

La lectura digital se ha convertido en una de las grandes protagonistas de los últimos años. Con la facilidad de llevar en un solo dispositivo miles de libros, revistas o apuntes académicos, los ebooks han revolucionado la forma en la que estudiantes, profesionales y lectores habituales disfrutan de sus lecturas.

Ahora que el verano llega a su fin y arranca la vuelta al cole, Amazon ha decidido acelerar la campaña de septiembre con el hundimiento del precio de manera drástica de su Kindle Paperwhite.

Normalmente, este lector electrónico de referencia de Amazon se mueve en torno a los 140€ en varias tiendas como PcComponentes, Worten, MediaMarkt y Miravia. No obstante, Amazon quiere seguir liderando el sector liquidándolo hasta los 131,40 euros.

Este modelo de Amazon incorpora una pantalla de 7 pulgadas con tecnología Paperwhite, resolución de 300 ppp, 16 tonos de escala de grises y luz frontal integrada regulable. Además, su diseño ultraligero combina portabilidad con resistencia al agua IPX8.

Así mismo, integra 16 GB de almacenamiento interno, destacando por una batería cuya autonomía es de hasta 12 semanas con uso moderado, recargándose en menos de 2,5 horas. Compatible con redes WiFi de 2,4 y 5 GHz, admite múltiples formatos de contenido como AZW, EPUB, PDF, DOCX y MOBI. Además de otras funciones como modo oscuro, ajuste de fuentes, interlineado y márgenes.

Amazon también rebaja muy ligeramente su modelo Kindle más económico

Para quienes buscan iniciarse en la lectura digital sin necesidad de tantas prestaciones, Amazon también ha ajustado el precio de su Kindle básico hasta los 98,35 euros. Una ligera rebaja, puesto que en webs como MediaMarkt y PcComponentes su precio es de 100€.

Incorpora una pantalla de 6 pulgadas con resolución de 300 ppp, este libro electrónico cuenta con 6 tonos de escala de grises y luz frontal integrada. Teniendo también 16 GB de memoria, cuya autonomía es de hasta 6 semanas por carga.

Compatible con redes WiFi de 2,4 y 5 GHz, admite una amplia gama de formatos como AZW, EPUB, MOBI, PDF, DOCX. Además de tener opciones de accesibilidad como ajuste de fuentes, interlineado, márgenes y modo de inversión de colores.

*En calidad de Afiliado, Muy Interesante obtiene ingresos por las compras adscritas a algunos enlaces de afiliación que cumplen los requisitos aplicables.

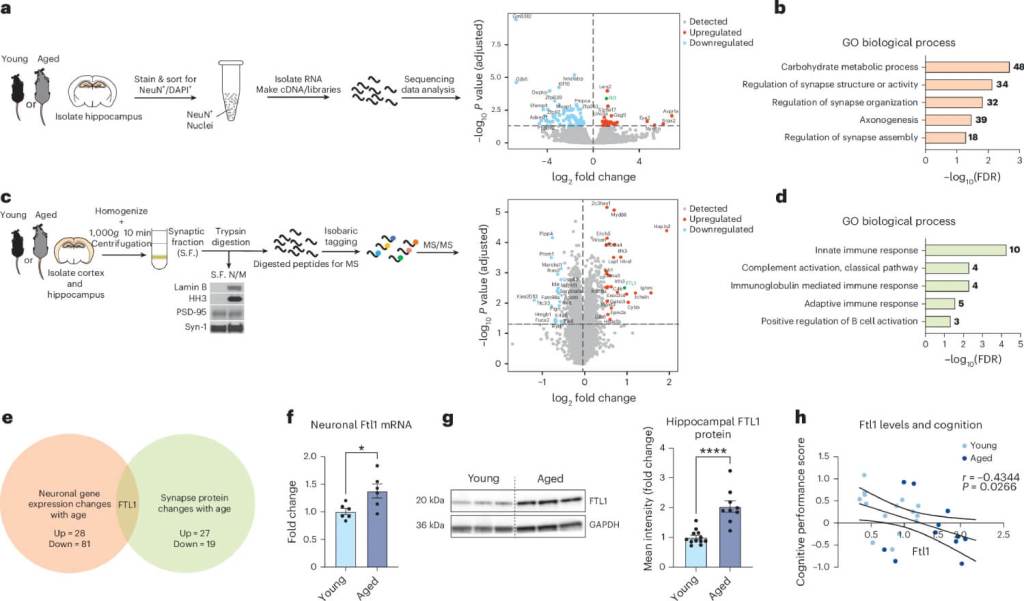

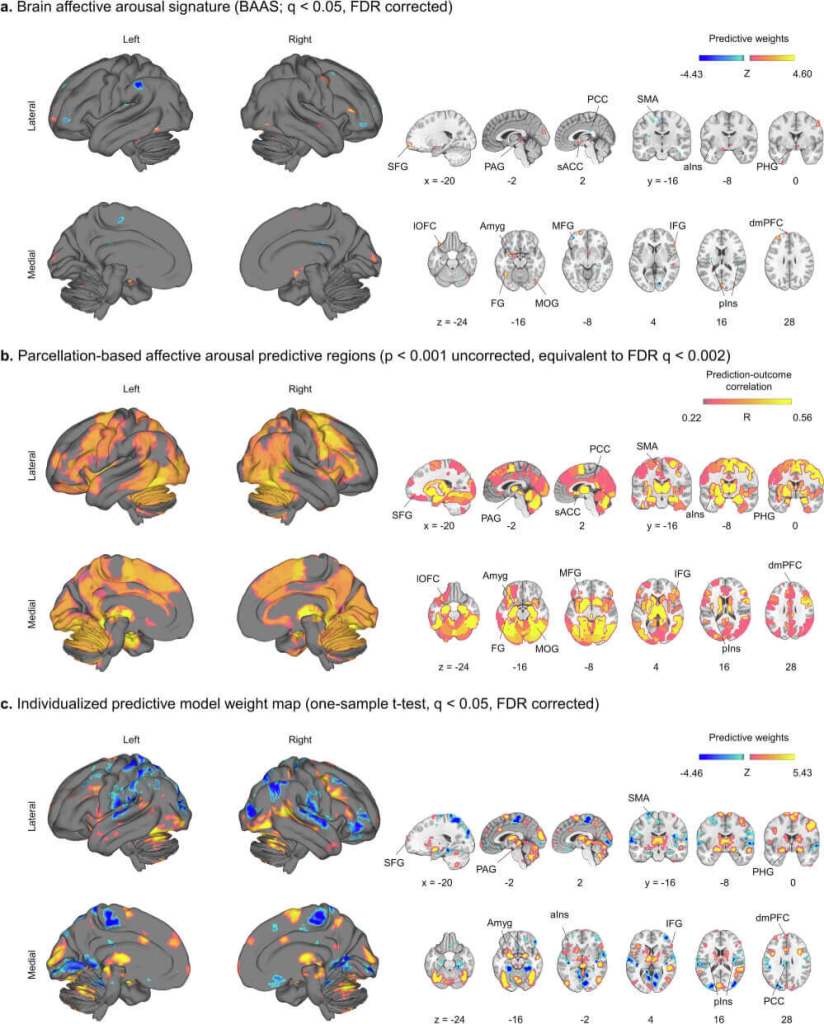

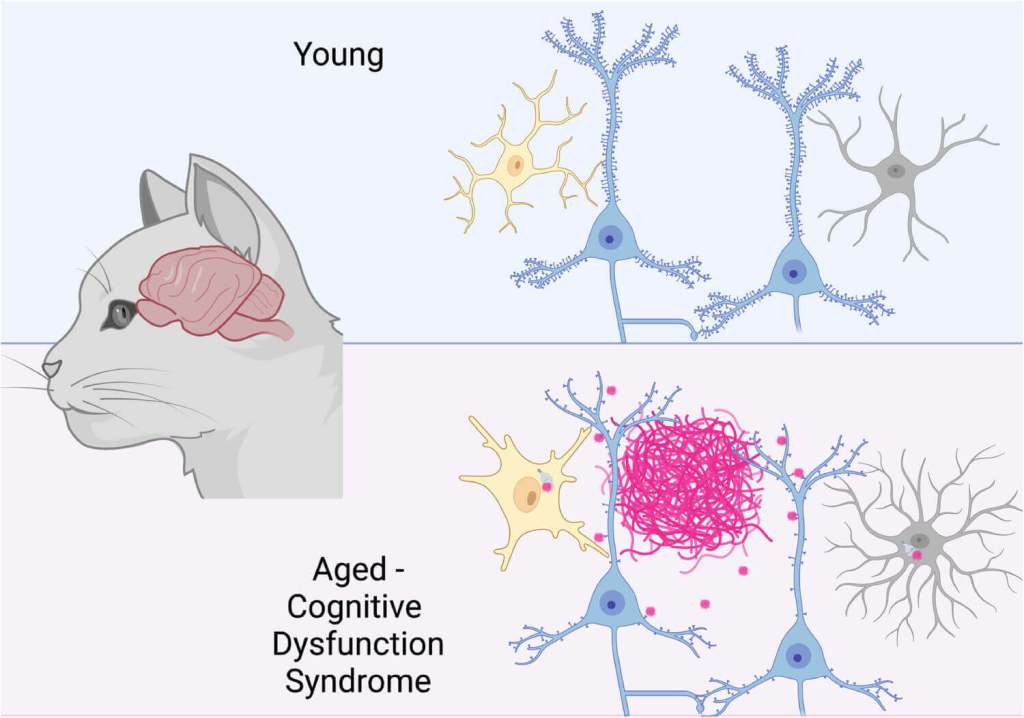

El envejecimiento no siempre implica la muerte de neuronas. A menudo, lo que ocurre es una pérdida de eficiencia en las conexiones sinápticas, esas diminutas estructuras que permiten que las células cerebrales se comuniquen. Con los años, la plasticidad del cerebro disminuye y aparecen dificultades para recordar, aprender o mantener la atención. Hasta ahora, la mayoría de los estudios se habían centrado en daños irreversibles como los observados en el alzhéimer. Sin embargo, la investigación más reciente apunta a que ciertos cambios moleculares podrían ser reversibles.

Los científicos llevan tiempo preguntándose qué impulsa realmente este declive cognitivo. ¿Se trata solo de un desgaste inevitable o existen factores concretos que lo aceleran? El nuevo estudio responde en parte a esta incógnita al identificar a FTL1 (Ferritin Light Chain 1) como un factor pro-envejecimiento en el cerebro. Se trata de una proteína relacionada con el almacenamiento de hierro que, en exceso, desestabiliza el delicado equilibrio neuronal.

Este hallazgo publicado en Nature Aging es clave porque demuestra que el envejecimiento cerebral no es un destino sellado de antemano. La acumulación de FTL1 en el hipocampo, la región cerebral esencial para la memoria, se asoció directamente con peores resultados en pruebas cognitivas en ratones viejos. Eso significa que un solo factor molecular puede marcar la diferencia entre recordar y olvidar.

El papel oculto del hierro en la memoria

El hierro es indispensable para la vida. Participa en la producción de energía y en múltiples procesos celulares. Pero cuando su regulación falla, puede convertirse en un enemigo silencioso. En el cerebro, los niveles de hierro deben mantenerse con precisión. Lo que observaron los investigadores es que, con la edad, FTL1 se acumula en exceso dentro de las neuronas, alterando la manera en que el hierro cambia entre sus formas químicas.

Este desajuste provoca que se incremente el hierro oxidado (Fe³⁺), lo que a su vez impacta en el metabolismo energético de las neuronas y en la salud de las sinapsis.

En los experimentos, los ratones jóvenes a los que se les forzó a producir más FTL1 mostraron signos prematuros de envejecimiento cerebral: sinapsis más débiles, neuronas menos ramificadas y fallos de memoria.

El efecto fue tan claro que los animales dejaron de preferir un objeto nuevo frente a uno familiar, una prueba clásica de memoria. También perdieron la capacidad de orientarse correctamente en un laberinto, algo que los ratones jóvenes y sanos resuelven sin dificultad. La conclusión es contundente: demasiada FTL1 convierte a un cerebro joven en un cerebro viejo.

Bloquear la proteína para rejuvenecer

La pregunta lógica fue: ¿qué ocurre si se elimina o bloquea FTL1 en un cerebro ya envejecido? Los investigadores realizaron el experimento opuesto, reduciendo la presencia de la proteína en el hipocampo de ratones de edad avanzada. Los resultados fueron sorprendentes: las neuronas recuperaron parte de sus conexiones y los animales mejoraron su memoria.

Las pruebas demostraron que, tras el tratamiento, los ratones eran capaces de reconocer objetos nuevos y de recordar recorridos en un laberinto de manera más eficiente.

A nivel celular, se observó un incremento de sinapsis excitadoras e inhibidoras, es decir, las autopistas de comunicación entre neuronas volvieron a ser más sólidas y activas.

Este rejuvenecimiento no fue un simple espejismo. Se confirmó también en análisis moleculares: al reducir FTL1, las neuronas recuperaron receptores y proteínas esenciales para la plasticidad sináptica. En otras palabras, el cerebro de los ratones viejos empezó a comportarse como el de animales más jóvenes.

Energía, metabolismo y memoria

El estudio no se quedó en la observación superficial, sino que indagó en los mecanismos profundos. Al comparar la actividad genética de las neuronas, se detectaron cambios en rutas metabólicas clave, sobre todo en la producción de ATP, la molécula que actúa como moneda de energía en las células.

Cuando la FTL1 aumentaba, la producción de ATP se desplomaba, dejando a las neuronas sin la energía suficiente para mantener sus complejas funciones. En cambio, al bloquear la proteína, los genes relacionados con la respiración celular y la síntesis de energía se reactivaban. Este descubrimiento refuerza la idea de que el envejecimiento cerebral está ligado, en gran parte, a fallos energéticos en las neuronas.

Para confirmar este vínculo, los investigadores probaron un suplemento: NADH, un coenzima que impulsa la producción de ATP. Al administrarlo a ratones con exceso de FTL1, se logró contrarrestar parte de los efectos negativos, restaurando la memoria y la salud sináptica. La prueba es clara: mejorar el metabolismo puede revertir la pérdida cognitiva asociada al envejecimiento.

Más allá de los ratones: ¿qué significa para nosotros?

Aunque el trabajo se realizó en modelos animales, su relevancia trasciende. En humanos, se sabe que niveles altos de ferritina y desajustes en el metabolismo del hierro se relacionan con peor rendimiento cognitivo y mayor riesgo de alzhéimer. De hecho, mutaciones en el gen Ftl1 provocan una rara enfermedad neurodegenerativa llamada neuroferritinopatía, caracterizada por problemas motores y de memoria.

Los resultados en ratones sugieren que el mismo mecanismo podría estar en juego en el envejecimiento humano. La acumulación de FTL1 en el cerebro podría actuar como un gatillo silencioso del deterioro cognitivo.

Y lo más prometedor: al ser una proteína concreta y bien identificada, podría convertirse en una diana terapéutica para desarrollar fármacos que ralenticen o reviertan la pérdida de memoria.

Los científicos insisten en que aún queda camino por recorrer antes de trasladar estos hallazgos a personas. Pero el simple hecho de demostrar que bloquear FTL1 rejuvenece el cerebro de un animal viejo abre un horizonte completamente nuevo en la investigación del envejecimiento.

Un futuro para la memoria

El hallazgo de FTL1 como proteína clave en el envejecimiento cerebral se suma a un cambio de paradigma en la ciencia: la idea de que el cerebro envejecido puede ser rejuvenecido. Ya no se trata únicamente de aceptar el deterioro como inevitable, sino de buscar las llaves moleculares que permitan retrasarlo o incluso revertirlo.

Este trabajo, realizado por un equipo internacional liderado desde la Universidad de California en San Francisco, no solo identifica a FTL1 como un enemigo silencioso de la memoria, sino que demuestra que actuar sobre ella es posible. Y al hacerlo, se revitalizan funciones tan esenciales como la plasticidad sináptica y la capacidad de aprender.

Para millones de personas preocupadas por el deterioro cognitivo, los resultados ofrecen una dosis de esperanza. Aunque aún no existe un tratamiento listo para humanos, la investigación marca un camino claro: si controlamos las moléculas que alimentan el envejecimiento, podremos proteger la memoria y la identidad que nos define.

Referencias

- Remesal, L., Sucharov-Costa, J., Wu, Y. et al. Targeting iron-associated protein Ftl1 in the brain of old mice improves age-related cognitive impairment. Nat Aging (2025). doi: 10.1038/s43587-025-00940-z

Renault ha asentado en España uno de sus pilares industriales más sólidos: en los primeros siete meses de 2025, más de la mitad de los vehículos vendidos en el país se fabricaron en Valladolid y Palencia. En total, 27.996 unidades, lo que supone un 54,9 % del mercado nacional. Este dato refleja mucho más que una cifra comercial: es la confirmación de que España es hoy un núcleo esencial para la estrategia global del grupo.

Nuestro país no es solo un centro de ensamblaje. Se ha convertido en el Polo Mundial de Hibridación de Renault, donde se producen cinco de los siete modelos híbridos completos de la marca: Captur y Symbioz en Valladolid, junto a Austral, Espace y Rafale en Palencia. El resultado es una gama competitiva, eficiente y tecnológicamente avanzada, que ha sabido conectar con un cliente cada vez más consciente del valor de la sostenibilidad.

Los números hablan por sí solos. El Captur lidera con holgura, con más de 12.000 matriculaciones. Le siguen Austral, Symbioz, Rafale y Espace, todos ellos con ADN español. Estos modelos no solo representan la fuerza industrial de Renault, sino también su capacidad para generar empleo, innovación y valor añadido en territorio nacional.

La tecnología híbrida E-Tech, además, está siendo clave. Representa ya el 44 % de las ventas de turismos de la marca en España, frente a una media del mercado que apenas roza el 18 %. Y todo ello se consigue en fábricas modernizadas, donde la robótica, la digitalización y la inteligencia artificial ya forman parte del día a día, situando a Valladolid y Palencia entre las plantas más avanzadas de Europa.

Captur, líder indiscutible en las carreteras españolas

Con más de 12.000 matriculaciones, el Captur es el buque insignia de Renault fabricado en Valladolid. Su equilibrio entre diseño urbano, practicidad y motorización híbrida E-Tech lo convierten en el preferido de los clientes.

Gracias a su eficiencia, es capaz de reducir consumos hasta en un 40 %, circulando en modo eléctrico durante gran parte de los trayectos urbanos.

Austral: la apuesta SUV hecha en Palencia

El Austral es el segundo modelo más demandado entre los fabricados en España. Con casi 6.500 unidades vendidas, este SUV confirma el papel clave de la planta de Palencia en la nueva gama híbrida. Combina deportividad y confort, y se ha convertido en el heredero natural del Kadjar, marcando el paso de Renault en el segmento C.

Symbioz, la nueva cara de Valladolid

El Symbioz, lanzado recientemente, ya ha encontrado su lugar en el mercado con casi 5.000 unidades. Fabricado también en Valladolid, destaca por un diseño audaz y un habitáculo tecnológico.

Es un modelo que simboliza la capacidad de adaptación de la factoría vallisoletana, capaz de responder con agilidad a la demanda de nuevas tendencias de movilidad.

Rafale: un SUV coupé con sello premium

El Rafale suma más de 2.700 matriculaciones en lo que va de año. Producido en Palencia, se sitúa como la alternativa más refinada de la gama, con un aire premium y un diseño inspirado en la aviación.

Representa el salto cualitativo de Renault hacia un mercado más exigente, donde el diseño y la tecnología van de la mano.

El Espace, un clásico que se reinventa

Con más de 1.500 unidades, el nuevo Espace mantiene viva la tradición de los grandes familiares Renault, ahora en versión híbrida y fabricado en Palencia.

Comparte plataforma y tecnología con Austral y Rafale, pero conserva su espíritu práctico, ofreciendo espacio y confort a las familias que buscan versatilidad sin renunciar al estilo.

Valladolid, laboratorio de innovación

La planta vallisoletana se ha transformado en un referente de la industria 4.0. Con la incorporación de inteligencia artificial, sistemas de trazabilidad digital y robótica avanzada, ha elevado los estándares de calidad y eficiencia.

Aquí se combinan tradición y modernidad: décadas de experiencia industrial respaldan un presente marcado por la innovación constante.

Palencia, cuna de los grandes SUV

La factoría de Palencia se especializa en los modelos más grandes y sofisticados de la gama híbrida. Austral, Rafale y Espace salen de sus líneas de producción con procesos altamente automatizados y un enfoque sostenible.

La modernización de sus instalaciones ha permitido a Renault responder a la demanda creciente de SUV electrificados en toda Europa.

La revolución híbrida E-Tech

Los híbridos E-Tech fabricados en España son responsables de casi la mitad de las ventas de Renault en nuestro país. Esta tecnología permite combinar eficiencia, bajas emisiones y una conducción placentera sin necesidad de enchufar el vehículo.

El éxito de esta gama demuestra que la hibridación es una fórmula muy valorada por los clientes que buscan sostenibilidad sin complicaciones.

Ventajas de fabricar en casa

La producción local ofrece beneficios estratégicos: reduce tiempos logísticos, minimiza la huella de carbono del transporte y asegura mayor flexibilidad frente a la demanda. Además, fortalece el empleo y la competitividad de la industria española, situando a nuestro país en el mapa global de la automoción.

Renaulution: un plan con acento español

El plan estratégico “Renaulution” tiene en España uno de sus ejes fundamentales. Valladolid y Palencia son piezas clave para que la marca avance en electrificación y sostenibilidad.

Esta apuesta convierte a nuestro país en un socio imprescindible para el futuro del grupo, tanto en Europa como en mercados internacionales.

Nuevas apuestas eléctricas que refuerzan el futuro

Renault no se limita a los híbridos fabricados en España. El nuevo R4 E-Tech se convierte en un coche urbano, robusto y 100 % pensado para el futuro, recuperando un icono histórico con alma eléctrica.

Este lanzamiento simboliza cómo la marca conecta su legado con la nueva movilidad, combinando nostalgia, tecnología y sostenibilidad en un mismo vehículo.

Boreal, un SUV con ambiciones globales

Otra gran apuesta es el Boreal, un modelo que refuerza la estrategia internacional de Renault. Boreal llega con producción estratégica y ambiciones internacionales, posicionándose como un SUV de referencia en mercados globales. Su diseño moderno y su planteamiento sostenible lo convierten en un pilar de la nueva era de Renault, con España como base de parte de ese crecimiento industrial.

La producción local como valor estratégico

El éxito de Renault en España demuestra que la producción local es un valor estratégico. Con más de la mitad de sus ventas provenientes de modelos “Made in Spain”, el grupo ha reforzado su competitividad, ha dado un paso decisivo en electrificación y ha situado a Valladolid y Palencia en la primera línea de la automoción europea. Renault no solo fabrica coches: impulsa innovación, empleo y orgullo industrial en nuestro país.

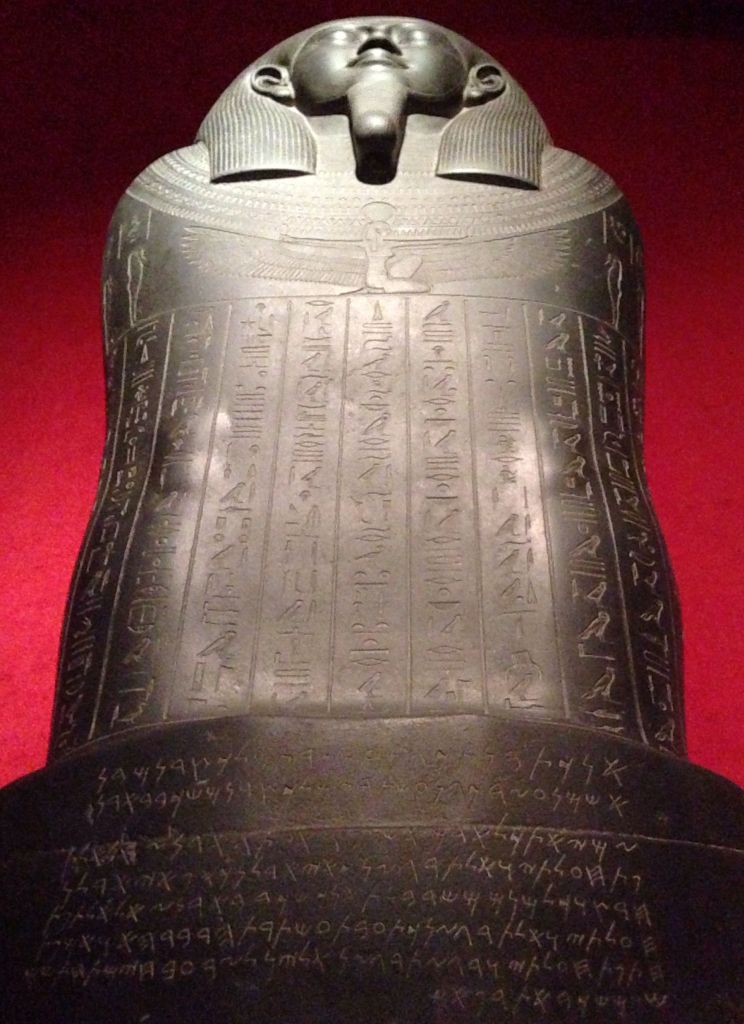

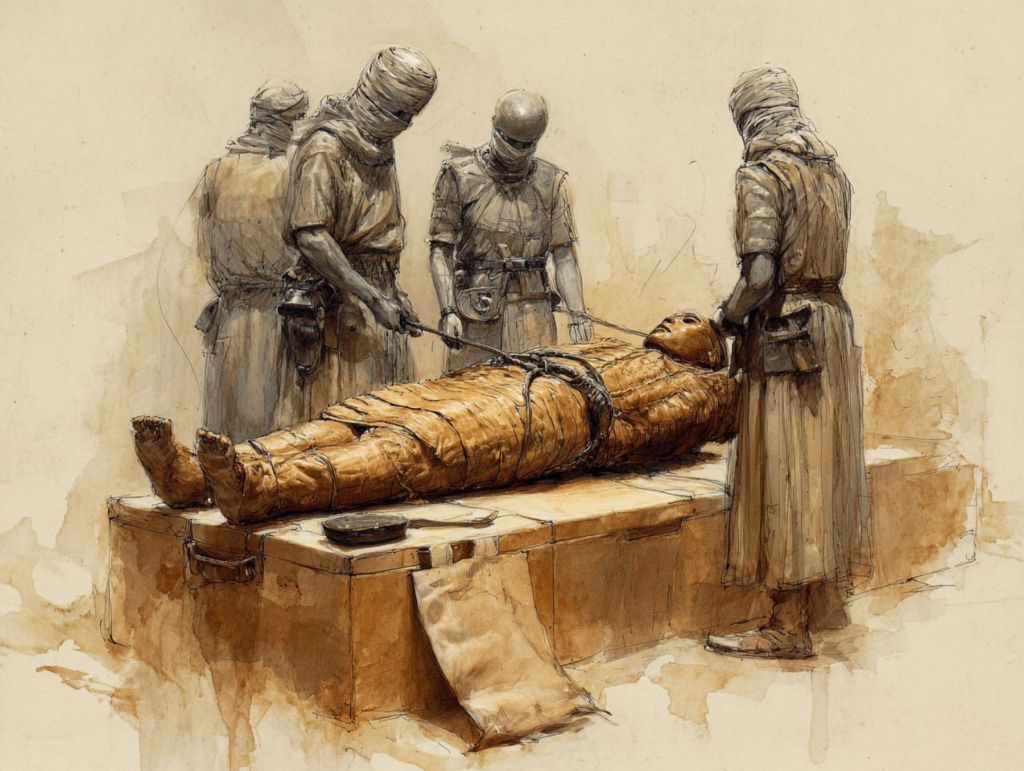

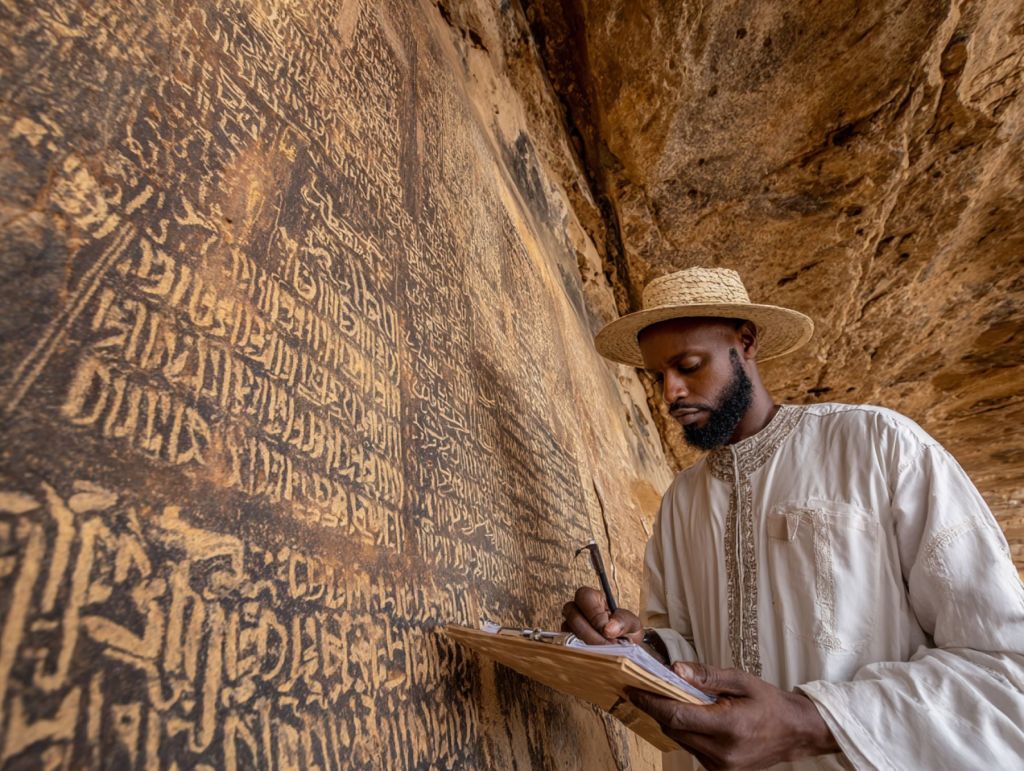

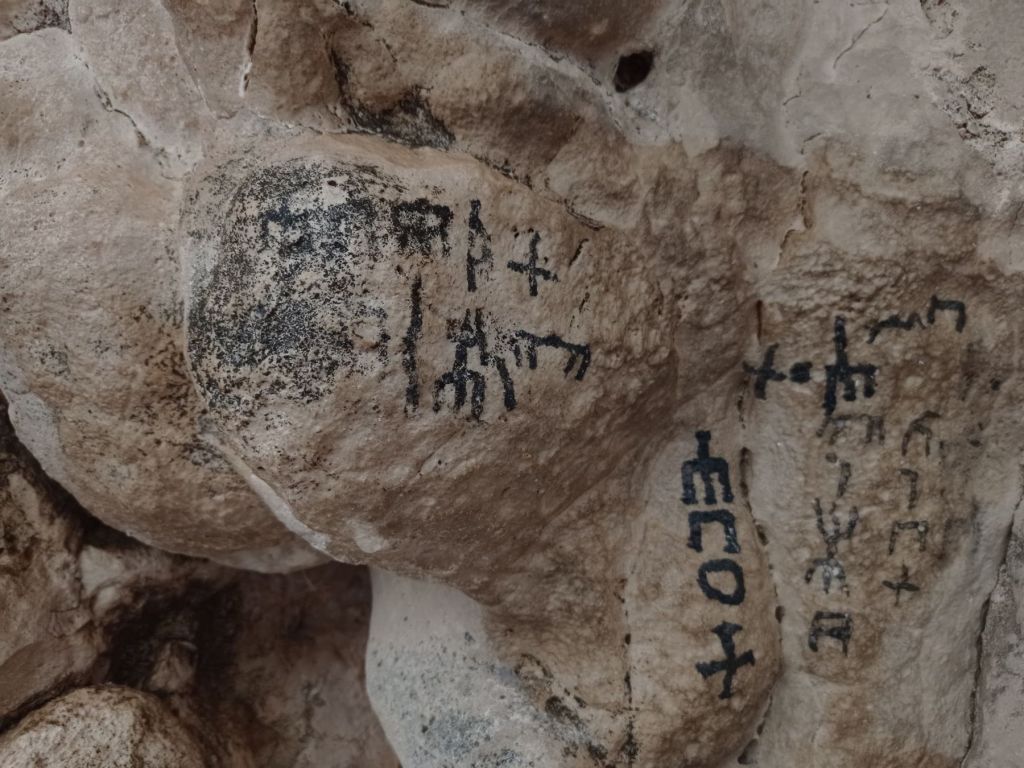

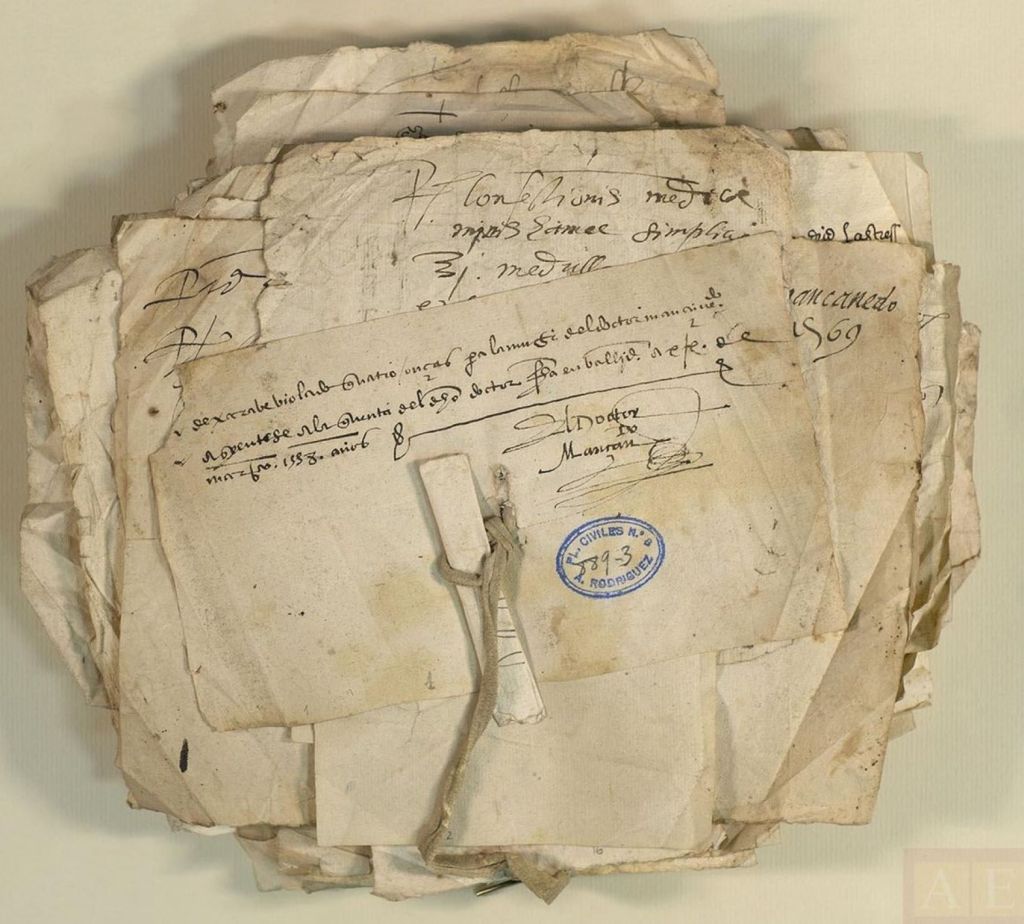

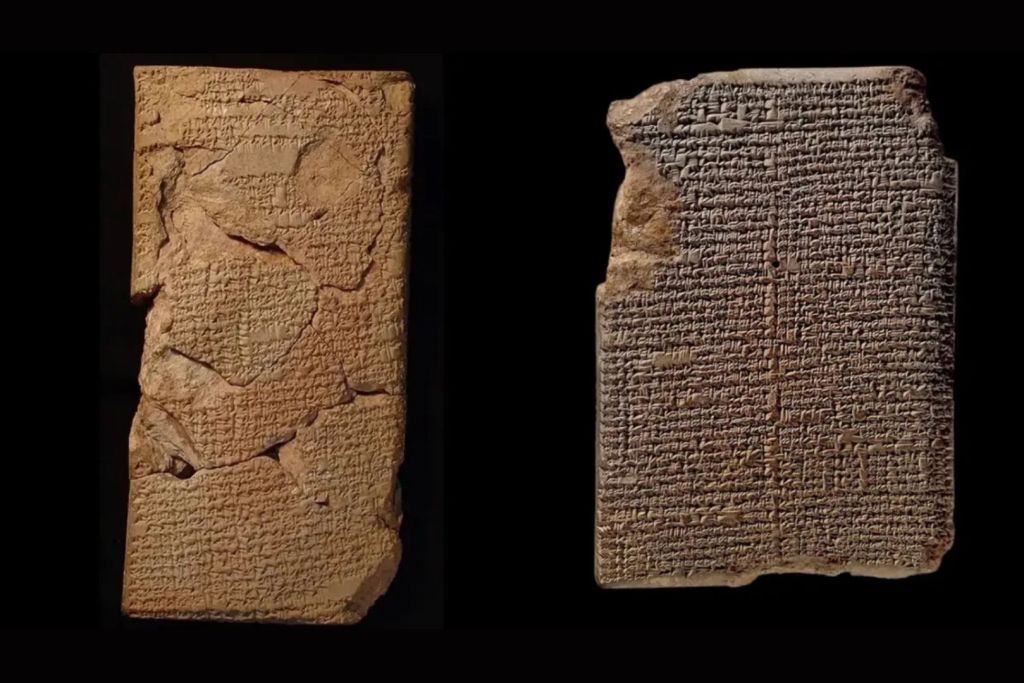

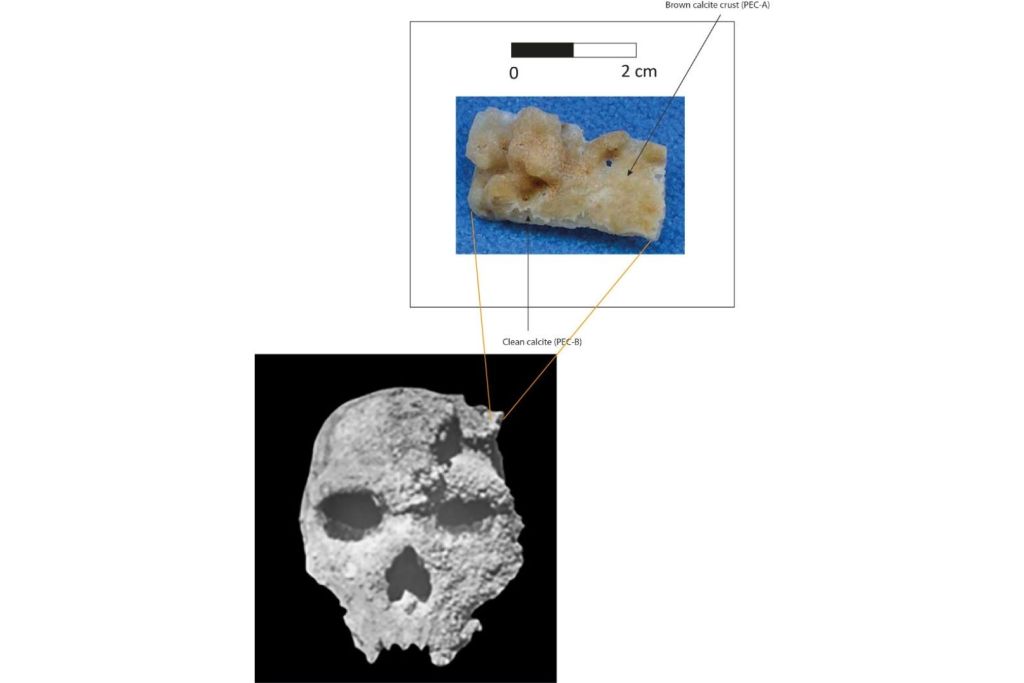

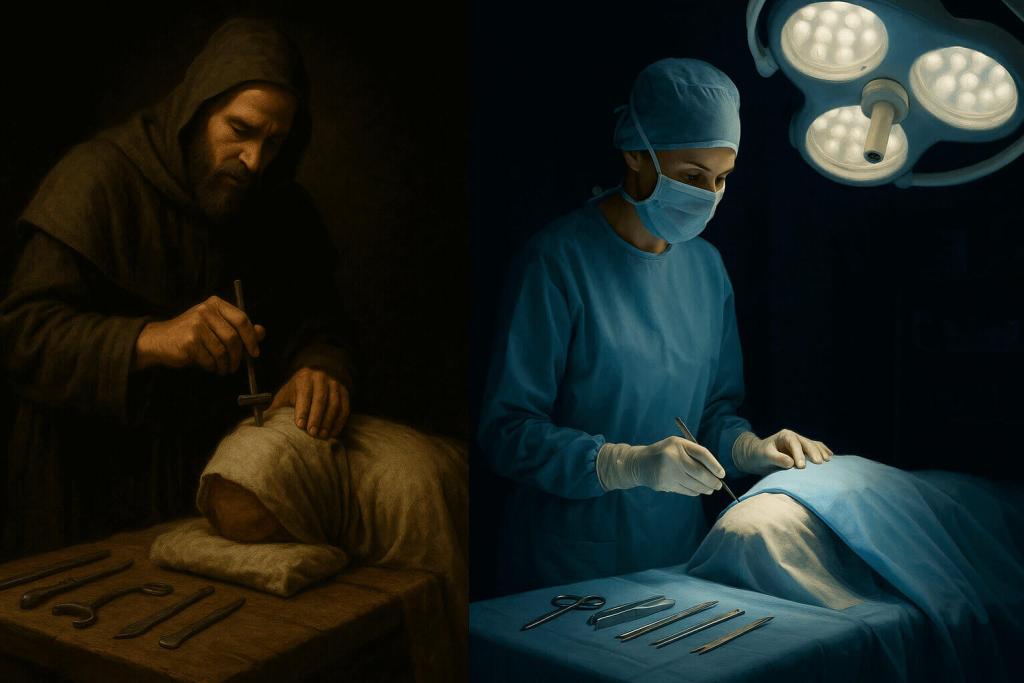

La momificación por medios artificiales se considera uno de los rasgos distintivos de la antigua civilización egipcia. La iconografía, los testimonios clásicos y, sobre todo, los propios restos humanos hallados en las tumbas faraónicas confirman esta particularidad. Sin embargo, una investigación reciente de la historiadora Helen Dixon plantea un escenario cultural más complejo. Según la autora, algunos fenicios del Levante pudieron haber practicado una forma de momificación o embalsamamiento simbólico en plena época persa (ca. 500-300 a. C.).

El artículo de Dixon se basa en el análisis de inscripciones funerarias, sarcófagos antropoides, descripciones de excavaciones del siglo XIX y XX y la presencia recurrente de aceites y resinas en los ajuares mortuorios. El conjunto de estas evidencias sugiere que la élite fenicia desarrolló rituales destinados a garantizar la integridad física del difunto, aunque el resultado no siempre implicase la conservación física del cadáver. Por ello, Dixon propone el concepto de “momificación simbólica”.

Los fenicios y la diversidad de sus rituales funerarios

El estudio parte de la idea de que la práctica funeraria fenicia mostró una notable diversidad, sobre todo en comparación con otras culturas del Mediterráneo durante la Edad del Hierro. En los cementerios del litoral siropalestino, se han hallado tanto cremaciones como inhumaciones que, en ocasiones, incluso coexistían en un mismo espacio. Algunas tumbas mostraban sarcófagos antropoides de piedra, mientras que en otras se empleaban simples fosas o nichos excavados en la roca.

La ausencia de restos momificados en buen estado en el registro arqueológico había llevado a muchos investigadores a descartar la posibilidad de que se hubiese practicado el embalsamamiento entre los fenicios. No obstante, los testimonios del siglo XIX, sobre todo los vinculados a las excavaciones de Sidón, revelan la presencia de difuntos conservados de un modo inusual. Así, se habrían encontrado cuerpos cubiertos de fluidos aceitosos o acompañados de tablones de madera y restos de vendajes. Estas evidencias tempranas, aunque difíciles de verificar hoy, apuntan a que los fenicios pudieron haber manipulado y tratado los cadáveres con la intención de preservarlos.

El caso emblemático del rey Tabnit de Sidón

La prueba más célebre procede del hallazgo en 1887 del sarcófago del rey Tabnit de Sidón, fechado hacia finales del siglo VI o inicios del V a. C. Cuando los arqueólogos retiraron la tapa de basalto, encontraron el cuerpo sumergido en un líquido descrito como “aceitoso”. Se conservaban los tejidos blandos y los órganos internos intactos. Esta circunstancia sorprendió a los especialistas, pues el proceso de momificación egipcia implicaba la extracción de las vísceras.

El rey Tabnit se convirtió así en la única “momia” fenicia documentada con cierta seguridad. Sin embargo, su conservación fue efímera. Al entrar en contacto con el aire, el cuerpo se desintegró rápidamente.

Con todo, el caso plantea algunas dudas. ¿El líquido hallado en el sarcófago deriva de una técnica aplicada de manera intencional o es el resultado de las reacciones postdeposicionales? Aun así, su estado inicial apunta al empleo de resinas y aceites como agentes de preservación ritual.

Tablas, vendas y resinas: las huellas materiales de la preparación del cuerpo

Otros hallazgos en los sitios de Sidón y Amrit apuntan en la misma dirección. Se encontraron, por ejemplo, tablones de madera que presentaban orificios que pudieron emplearse para sujetar el cadáver mediante cuerdas o tiras de telas. Estos elementos, junto con la presencia de fragmentos de vendajes de lino, se han interpretado como las pruebas de un intento de momificación.

Además, varios sarcófagos contenían residuos resinosos o aceitosos. En Cartago, por ejemplo, se hallaron depósitos que algunos excavadores del siglo XIX relacionaron con las técnicas de embalsamamiento inspiradas en Egipto. La reiteración de estos materiales en contextos funerarios de élite revela que la preparación del cuerpo respondía a rituales cuidadosamente codificados, aunque su eficacia en términos de conservación fuese limitada.

La momificación como símbolo: más allá de la preservación física

El argumento central de Dixon es que estas prácticas no buscaban, necesariamente, obtener un cuerpo incorruptible, como en Egipto, sino transmitir un mensaje simbólico. Así, más que la preservación orgánica del cadáver, los fenicios buscaron “colocar a sus muertos en la eternidad” como un modo de asegurar la estabilidad y permanencia del enterramiento.

El uso de aceites aromáticos y resinas cumplía una función performativa: envolver el cuerpo en sustancias preciosas asociadas a lo sagrado, garantizar la pureza del rito y crear la sensación de una preservación espiritual del difunto. El hecho de que los órganos no se extrayesen refuerza la hipótesis de que lo importante era mantener la integridad del cuerpo, no modificarlo.

El testimonio de las inscripciones funerarias

Las inscripciones halladas en los sarcófagos reales de Biblos y Sidón parecen respaldar esta interpretación. Una de ellas, perteneciente a un rey anónimo de Biblos del siglo V a. C., afirma explícitamente que el cadáver fue “preparado en mirra y bedelio”, dos resinas aromáticas muy valoradas en el Mediterráneo antiguo.

Otra inscripción, la de la reina Batnoam, madre del rey Azbaal de Biblos, describe cómo se la enterró con un atuendo regio, tocada con la tiara y los símbolos de su dignidad. Estos textos, por tanto, apuntan a que la preparación del cuerpo y su adorno se concebían como actos de trascendencia, parte de un ritual que vinculaba al difunto con la eternidad y con los dioses.

Paralelos culturales y reinterpretaciones modernas

Los sarcófagos antropoides y el empleo de resinas, vendajes y tablones recuerdan a las técnicas faraónicas. Sin embargo, Dixon insiste en que los fenicios adaptaron de forma creativa estos elementos al desarrollar un modelo propio de “momificación simbólica”.

El análisis histórico revela, además, un cambio en la percepción académica. Mientras los investigadores del siglo XIX tendían a exagerar las similitudes con Egipto, a partir de mediados del siglo XX se impuso el escepticismo y se minimizó la importancia de la práctica. El estudio actual propone un punto intermedio: reconocer que sí hubo intentos y rituales de preservación, aunque con objetivos distintos a los mostrados en Egipto.

Una eternidad simbólica

La investigación de Helen Dixon ofrece un marco renovado para comprender las prácticas funerarias fenicias. Lejos de limitarse a copiar modelos egipcios, las élites fenicias elaboraron un lenguaje ritual y funerario propio, en el que aceites, resinas y sarcófagos no solo cumplían funciones prácticas, sino también simbólicas.

Según el estudio, la momificación fenicia fue, más que un proceso técnico de conservación, un acto performativo que aseguraba al difunto un lugar en la eternidad. En este sentido, las tumbas fenicias revelan una concepción del más allá profundamente enraizada en la identidad cultural de estas comunidades del Levante, capaces de integrar y reinterpretar influencias externas.

Referencias

- Dixon, Helen. 2022. "Placing Them 'in Eternity': Symbolic Mummification in Levantine Phoenicia". Rivista di Studi Fenici, 50. DOI: https://doi.org/10.19282/rsf.50.2022.06

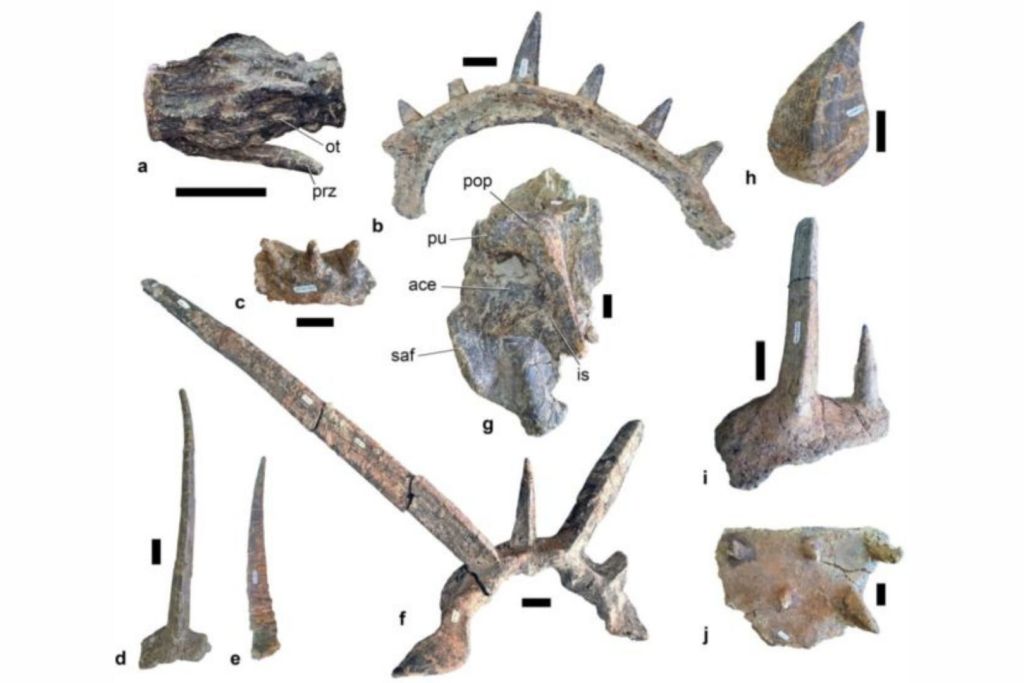

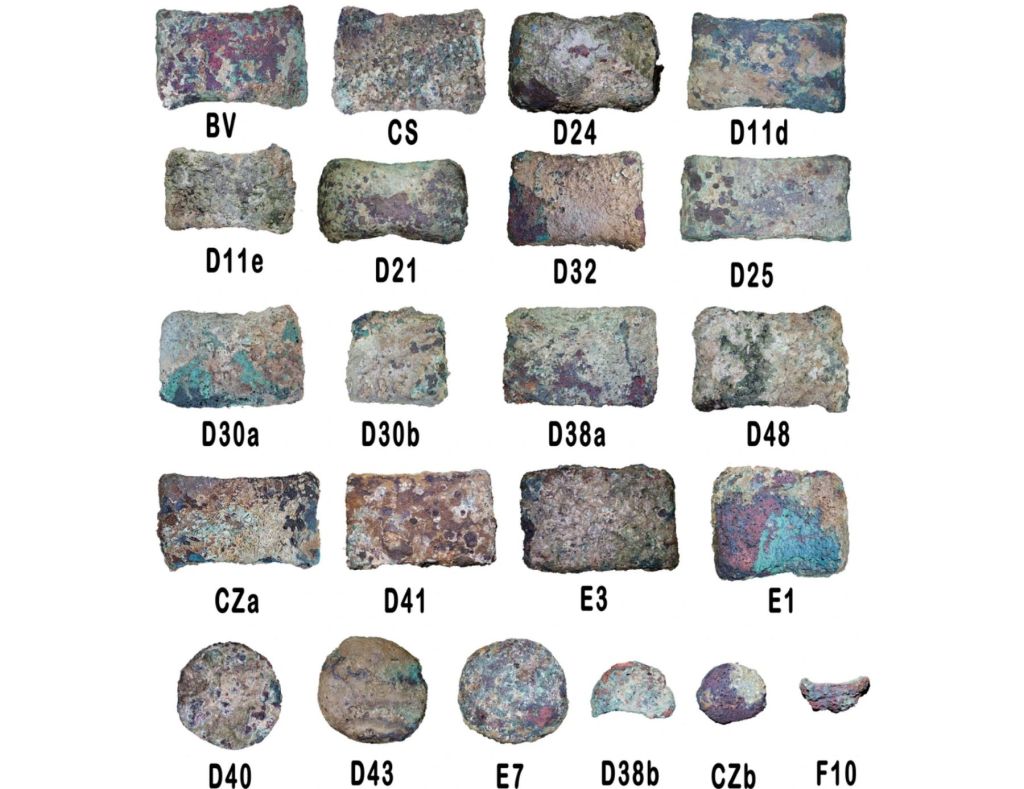

En las áridas laderas del Alto Atlas marroquí, donde hoy solo sopla el viento sobre la roca, hace unos 168 millones de años caminaba uno de los animales más insólitos que jamás haya existido. Medía apenas cuatro metros de largo y era herbívoro, pero su cuerpo estaba cubierto por una auténtica muralla viviente: placas, espinas y púas afiladas de todos los tamaños sobresalían de su cuello, su espalda, su cadera y sus costillas. Algunas de estas estructuras óseas alcanzaban casi un metro de longitud. El descubrimiento de Spicomellus afer, presentado recientemente en la revista Nature, ha sacudido los cimientos de la paleontología, revelando una versión primitiva, pero al mismo tiempo extraordinariamente elaborada, de los dinosaurios acorazados.

Hasta hace poco, Spicomellus era apenas un nombre en los márgenes de la ciencia, conocido únicamente por un fragmento de costilla fosilizada hallado en 2021. Sin embargo, el hallazgo de un conjunto más completo de restos —incluyendo múltiples vértebras, placas dérmicas y una especie de collar óseo con espinas— ha confirmado no solo su pertenencia al grupo de los anquilosaurios, sino que lo posiciona como el más antiguo de su linaje y el más ornamentado de todos ellos. Un hecho que contradice completamente las teorías evolutivas tradicionales.

Una armadura que no tiene igual

Los anquilosaurios son célebres por su blindaje corporal y, en sus formas más tardías, por la icónica maza en la cola. Pero este hallazgo va mucho más allá. Su esqueleto conserva evidencia de algo nunca antes visto: púas fusionadas directamente con las costillas. Este rasgo es absolutamente único en todo el reino animal, tanto en especies actuales como extintas. Es como si el dinosaurio hubiese nacido con lanzas saliendo directamente de sus costados. Y no hablamos de pequeñas protuberancias: algunas de estas espinas midieron hasta 87 centímetros, y posiblemente fueron más largas en vida.

Además del “collar” con púas, Spicomellus también tenía grandes placas y estructuras puntiagudas sobre las caderas, y una posible maza en la cola, de acuerdo con los restos fosilizados de vértebras caudales fusionadas que recuerdan a las de otros anquilosaurios más modernos. Estos rasgos sugieren que muchos de los elementos que definieron a este grupo ya estaban presentes mucho antes de lo que se pensaba.

Lo más desconcertante es que se trata del primer miembro del grupo que conocemos —vivió 30 millones de años antes que otros anquilosaurios ya descritos—, y sin embargo, ostenta la armadura más exagerada y variada. Esto desafía el patrón evolutivo habitual, donde las formas más primitivas suelen ser más simples y las complejidades aparecen con el tiempo. En este nuevo dinosaurio ocurre justo lo contrario.

¿Armas o adornos?

Una de las grandes preguntas que plantea el descubrimiento es la funcionalidad de semejante panoplia corporal. A primera vista, el blindaje sugiere una adaptación defensiva contra depredadores, y en parte lo sería. Sin embargo, los investigadores destacan que ciertas estructuras, como las púas del cuello, parecen demasiado exageradas y poco prácticas como para haber tenido solo ese propósito. El animal vivía en un entorno de vegetación densa y moverse con ese peso y tamaño extra habría supuesto un coste energético significativo.

Así, se plantea que muchas de estas estructuras pudieron tener funciones sociales y de exhibición, como ocurre hoy en día con las astas de los ciervos o la cola de los pavos reales. Podrían haber servido para atraer pareja, intimidar rivales o reforzar jerarquías dentro del grupo. Es un recordatorio de que, en la evolución, el combate y la reproducción son fuerzas tan poderosas como la supervivencia misma.

Una rareza africana que cambia la historia

El descubrimiento de Spicomellus también tiene una gran relevancia geográfica. Hasta ahora, la mayoría de los anquilosaurios se habían hallado en ecosistemas del hemisferio norte, particularmente en América del Norte, Europa y Asia. Este es el primer anquilosaurio conocido en África, y además, el más antiguo del mundo. Lo que indica que el grupo pudo haberse originado en este continente o, al menos, que tuvo una distribución mucho más amplia de lo que se pensaba durante el Jurásico Medio.

La región marroquí del Atlas, donde se hallaron los fósiles, está emergiendo como una mina de oro paleontológica. Con un registro fósil históricamente subestimado, Marruecos empieza a cobrar protagonismo como un enclave crucial para reconstruir la evolución de los dinosaurios en Gondwana, el antiguo supercontinente del hemisferio sur.

El hallazgo fue posible gracias a una colaboración internacional liderada por paleontólogos del Natural History Museum de Londres, la Universidad de Birmingham y la Université Sidi Mohamed Ben Abdellah de Fez. Fue en 2023 cuando un agricultor marroquí local encontró los restos tras unas inundaciones. El equipo acudió al lugar bajo un permiso oficial y realizó la excavación completa. Ahora, con los fósiles analizados y el estudio publicado, comienza una nueva etapa en la exploración de este ecosistema jurásico poco conocido.

Otro de los aspectos más fascinantes del caso Spicomellus es que su morfología podría representar un “experimento evolutivo” temprano dentro del grupo de los anquilosaurios. Posteriormente, con la aparición de grandes depredadores como Allosaurus en el Jurásico tardío y Tyrannosaurus rex en el Cretácico, los anquilosaurios evolucionaron armaduras más funcionales, menos vistosas y más eficientes desde el punto de vista defensivo. Su espectacularidad pudo haber sido un rasgo descartado por la selección natural conforme las amenazas crecieron.

Por tanto, el dinosaurio marroquí podría ser el último vestigio de una línea evolutiva más decorativa y exhibicionista, una que fue sustituida por la sobriedad letal de la funcionalidad pura. Pero en su tiempo, en un paisaje aún no dominado por los grandes carnívoros, Spicomellus fue un espectáculo andante: un herbívoro cubierto de espinas, caminando lentamente con su extravagante armadura como estandarte de un mundo aún en construcción.

El estudio ha sido publicado en la revista Nature.

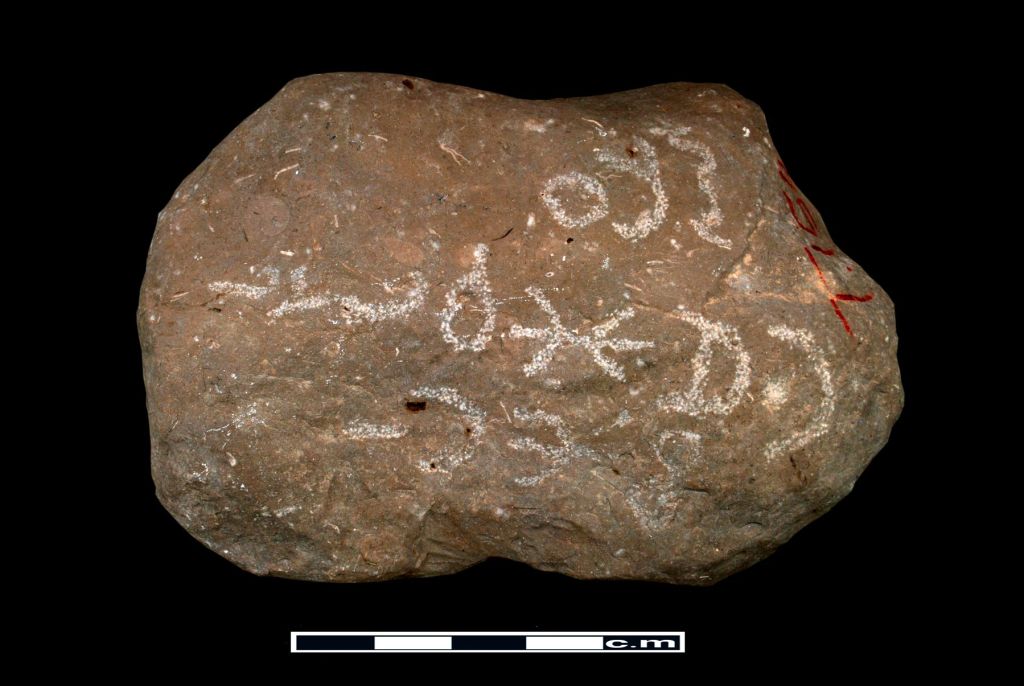

Durante décadas, la idea de que el arco y la flecha eran exclusivos de Homo sapiens ha dominado los relatos sobre el desarrollo de las tecnologías de caza en la prehistoria. Esta narrativa ha servido, entre otras cosas, para subrayar la supuesta superioridad cognitiva de los humanos modernos frente a otros homínidos como los neandertales. Sin embargo, un descubrimiento reciente en el yacimiento de Obi-Rakhmat, en Uzbekistán, está sembrando dudas.

Un equipo internacional de arqueólogos ha presentado pruebas de lo que podrían ser las puntas de flecha más antiguas conocidas hasta la fecha, con una antigüedad de alrededor de 80.000 años. Y lo más llamativo no es solo su edad, sino su contexto: fueron halladas en un estrato muy anterior a la llegada documentada de Homo sapiens a la región, lo que plantea una pregunta tan fascinante como polémica: ¿podrían haber sido los neandertales los primeros en desarrollar armas con proyectiles?

Un hallazgo escondido en la microescala

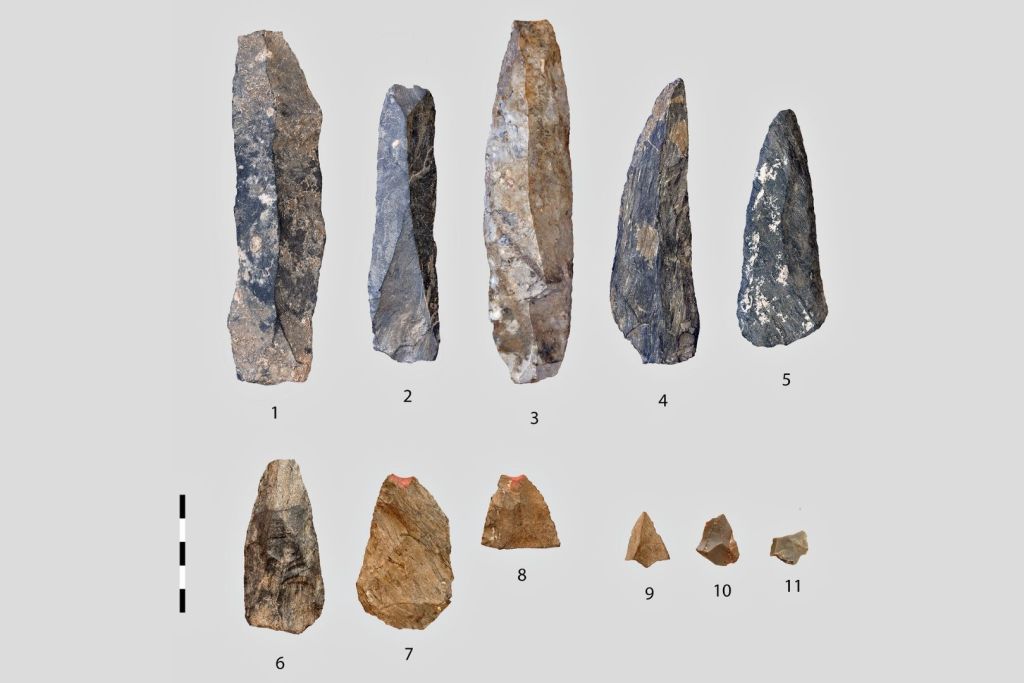

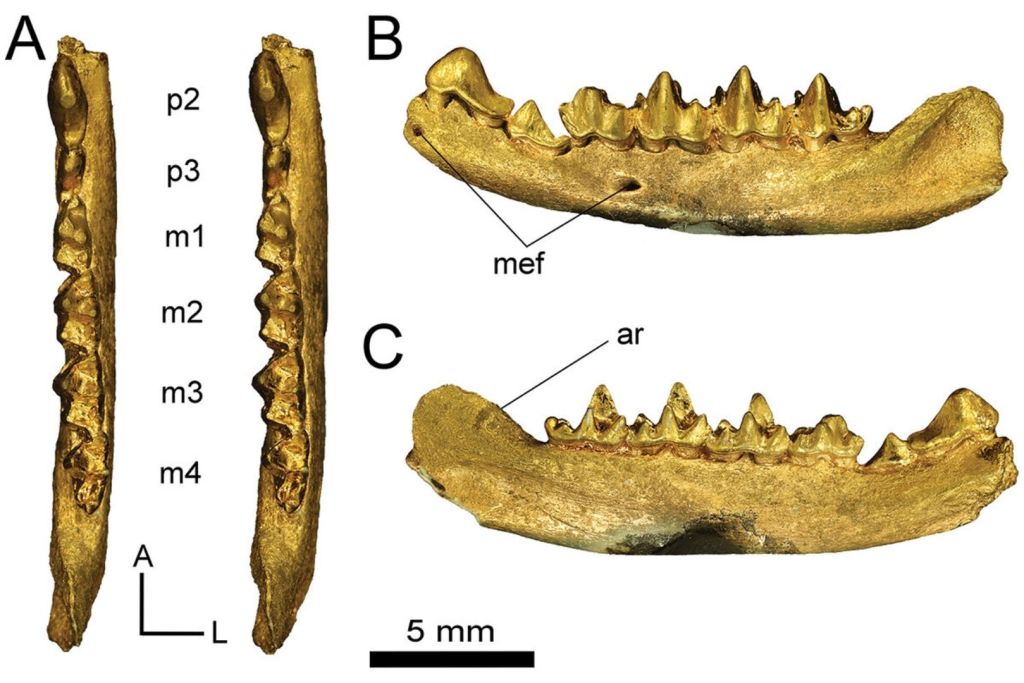

El descubrimiento, publicado en PLOS ONE por Hugues Plisson y Andrei Krivoshapkin junto a un equipo multidisciplinar, no consiste en lanzas o restos óseos humanos, sino en micropuntas de sílex de apenas unos pocos centímetros de largo, muchas de ellas fragmentadas. Durante años, estos restos pasaron desapercibidos en las excavaciones realizadas en el refugio rocoso de Obi-Rakhmat, al norte de las montañas Tian Shan, en Uzbekistán.

A diferencia de las grandes puntas de lanza típicas del Paleolítico medio, estas piezas presentan características propias de proyectiles diseñados para alcanzar a distancia, como su forma triangular, su reducido tamaño y un patrón de fractura compatible con el impacto a alta velocidad. Lo más significativo: algunas conservan microtrazas de impacto, similares a las que se observan en las verdaderas puntas de flecha empleadas por grupos humanos miles de años después.

La mayoría de estas micropuntas fueron fabricadas con piedra caliza silificada local, talladas mediante técnicas sofisticadas de reducción Levallois y producción de láminas. En total, se han identificado tres tipos de armaduras líticas: puntas grandes retocadas, láminas delgadas, y especialmente estas micropuntas sin retocar que, según los autores, solo habrían podido fijarse a astiles delgados como los de las flechas.

¿Fueron flechas... y quién las fabricó?

La datación estratigráfica del nivel en el que se hallaron estas piezas sitúa el conjunto en torno a los 80.000 años antes del presente, es decir, mucho antes de las evidencias más tempranas de arcos y flechas en África (74.000 años en Sibudu, Sudáfrica) o Europa (unos 54.000 años en Mandrin, Francia).

Este dato por sí solo ya resulta impactante. Pero la controversia aumenta si se considera el contexto humano del yacimiento. En Obi-Rakhmat, los únicos restos humanos asociados a niveles semejantes corresponden a un niño de entre 9 y 12 años con rasgos dentales de neandertal, aunque su cráneo muestra características más ambiguas, lo que ha llevado a plantear la posibilidad de que se tratase de un individuo híbrido entre Homo sapiens, neandertal o incluso denisovano.

La hipótesis más plausible, según los investigadores, es que la población de Obi-Rakhmat estuviese compuesta por neandertales, o al menos por un grupo de origen neandertal adaptado al paisaje estepario del Asia Central. La región, situada en un corredor natural entre el Altái y el Cáucaso, pudo haber sido un crisol de intercambios biológicos y culturales entre diferentes poblaciones humanas.

Tecnología avanzada en tiempos insospechados

La importancia del hallazgo va más allá de la mera identificación de puntas. Implica una comprensión más profunda de cómo cazaban estos grupos humanos, y qué tipo de armas empleaban para sobrevivir en un entorno exigente.

El diseño de estas micropuntas revela una lógica de fabricación orientada a proyectiles ligeros, ideales para cazar presas ágiles como el íbice siberiano o el ciervo rojo, animales frecuentes en el registro faunístico de Obi-Rakhmat. Las armas pesadas, como lanzas, habrían sido menos efectivas para estos fines.

Además, los experimentos llevados a cabo por el equipo con reconstrucciones modernas —micropuntas fijadas a astiles de 8 mm de diámetro y lanzadas con arcos de 36 libras— confirman que estas puntas eran funcionales y mortales. Tras atravesar una carcasa animal suspendida, algunas se rompieron al impactar contra estructuras duras, dejando fracturas típicas de uso como proyectil.

Si bien es cierto que ni los arcos ni las flechas se conservan —los materiales orgánicos como la madera o las fibras vegetales raramente sobreviven 80.000 años—, la lógica del diseño y el patrón de fractura son, según los investigadores, pruebas razonables de que se trataba de armas lanzadas a distancia. Y si no eran arcos, debieron usarse con algún sistema de lanzamiento como propulsores. Pero todo apunta a un conocimiento técnico avanzado, insospechado en ese contexto temporal.

¿Y si fueron los neandertales?

El gran debate gira en torno a la autoría de estas armas. ¿Fueron inventadas por Homo sapiens y llevadas a Asia Central durante una migración temprana desde el Levante? ¿O fueron desarrolladas de forma independiente por grupos neandertales locales?

La segunda opción, aunque rompedora, es cada vez más plausible. La arqueología reciente ha demostrado que los neandertales no eran los “brutos” que durante tanto tiempo describieron los manuales escolares. Sabemos que enterraban a sus muertos, utilizaban pigmentos, tallaban herramientas complejas y ahora, quizá, también desarrollaron armas de proyectil sofisticadas.

En este sentido, el hallazgo de Obi-Rakhmat reabre el debate sobre la inteligencia tecnológica neandertal y la posibilidad de que ciertas innovaciones atribuidas exclusivamente a Homo sapiens hayan tenido un origen paralelo o incluso independiente. Además, la posibilidad de contactos o intercambios entre distintas poblaciones en Asia Central podría explicar similitudes tecnológicas observadas miles de kilómetros al oeste, en yacimientos europeos.

Un nuevo relato para una humanidad plural

Los investigadores no afirman haber resuelto el misterio, pero dejan claro que los resultados de su estudio exigen una revisión crítica de las narrativas lineales sobre la evolución cultural humana.

El hecho de que herramientas idénticas a las empleadas por Homo sapiens 25.000 años después aparezcan en este rincón del mundo, en manos quizás de otros homínidos, pone en cuestión la idea de que solo nuestra especie fue capaz de innovar.

Quizás, como ya se empieza a aceptar, la historia de la humanidad no fue una carrera en solitario, sino una red de trayectorias paralelas, con préstamos, convergencias y, por supuesto, grandes dosis de creatividad. Y es que Obi-Rakhmat, con sus piedras pequeñas y su enigma gigante, nos recuerda que aún queda mucho por descubrir sobre quienes fuimos… y sobre lo que fuimos capaces de imaginar.

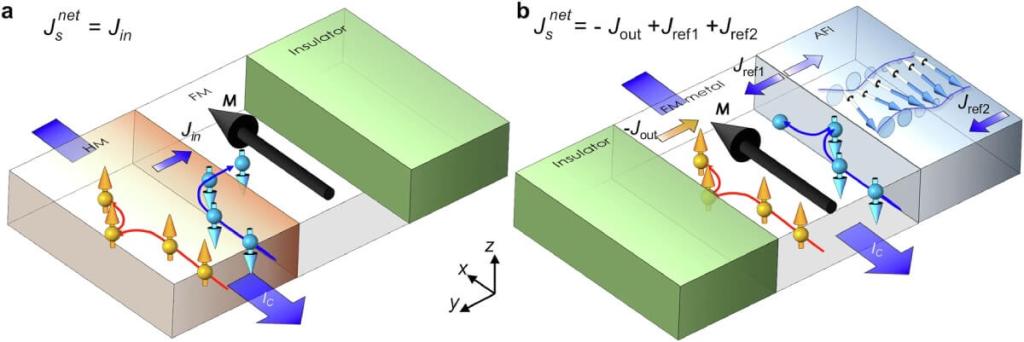

Este artículo busca acercar al lector algunas de las ideas contenidas en un estudio galardonado con el premio a la “Mejor contribución metodológica en el campo de la Estadística”, otorgado por la Sociedad de Estadística e Investigación Operativa y la Fundación BBVA [1].

1. Estadística con curvas

Tradicionalmente, los resultados de los experimentos científicos se limitaban a valores numéricos concretos, como la velocidad de caída de un objeto o la temperatura corporal de una persona. Hoy en día, los avances tecnológicos permiten registrar de forma (casi) continua esos datos, convirtiéndolos en curvas: en lugar de medir la velocidad de llegada al suelo del objeto, se dispone de su velocidad (casi) instantánea durante toda la caída, o de la evolución de la temperatura de una persona a lo largo de todo un día. Este hecho ha requerido la creación de técnicas estadísticas específicas para el manejo de curvas, dando lugar al Análisis de Datos Funcionales (FDA por su nombre inglés) [2, 3].

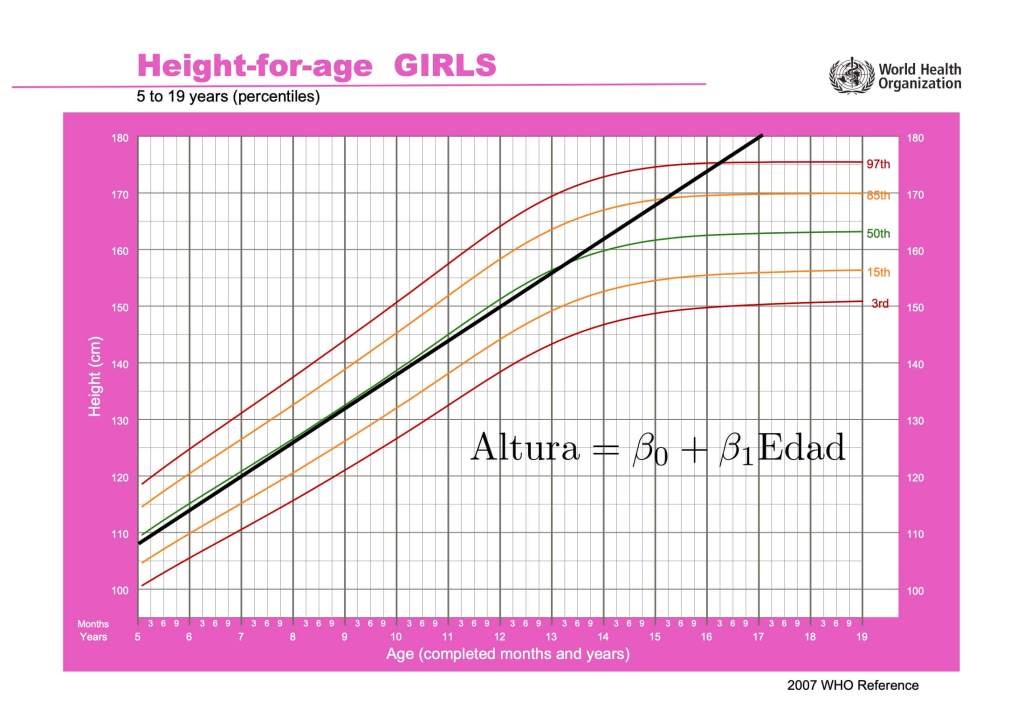

En ciencia, es habitual construir modelos matemáticos que simplifican, en cierta medida, la realidad. El modelo de regresión lineal, cuyo origen se remonta al siglo XIX, es uno de los pilares de la estadística moderna. Este modelo plantea la relación Y = β0 + β1 X + ε entre dos variables numéricas X e Y que incluye un error aleatorio ε. Sin embargo, es obvio que para adoptar un modelo matemático hay que comprobar su ajuste al fenómeno que pretende modelar. La posible sobresimplificación impuesta por un modelo puede no ajustarse a la realidad, creando vacas esféricas o prediciendo que una niña se jubilará midiendo más de cuatro metros si utilizamos una regresión lineal que se ajusta bastante bien sus alturas desde los tres a los trece años.

El objetivo de [1] es evaluar el ajuste de un modelo de regresión lineal cuando se pretende utilizar una curva para predecir una variable numérica, concluyendo mediante un test de validez si en los datos existen discrepancias significativas con la predicción del modelo. El interés del contraste de hipótesis radica en que, cuando trabajamos con curvas, no disponemos de intuición gráfica para valorar si la regresión lineal puede ser razonable o no.

El modelo de regresión lineal destaca tanto por su simplicidad como por la variedad de situaciones en las que es aplicable. Un ejemplo de su empleo es usar la curva del número de infectados con cierto virus hasta hoy para predecir cuántos nuevos infectados van a surgir durante la semana que viene. Otro ejemplo es determinar el contenido de grasa de una pieza de carne a partir de una curva que describe cómo absorbe radiaciones de distintas longitudes de onda.

El contraste de hipótesis propuesto en [1] para evaluar el modelo de regresión lineal utiliza la simplificación proporcionada por las proyecciones aleatorias. Esta herramienta “comprime” cada curva en un número “representativo” de la misma. Esto simplifica notablemente el contraste del modelo, ya que, en vez de una curva y una variable numérica, se trabaja con dos variables numéricas. Un aspecto clave para esta “representatividad” es el carácter aleatorio de las proyecciones.

2. ¿Qué es una proyección?

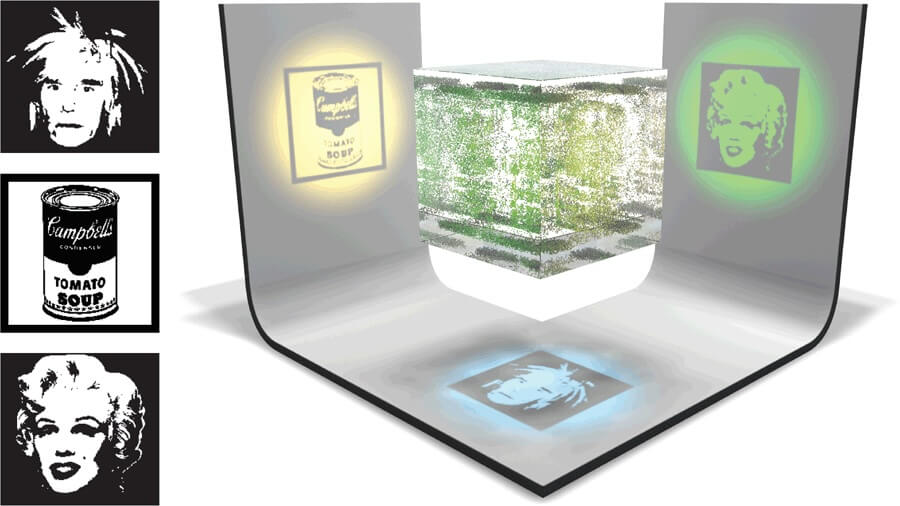

La palabra proyección en matemáticas es (casi) equivalente a sombra. Si suspendemos en el aire una pelota y la iluminamos desde arriba con una linterna, la sombra que aparece en el suelo es su proyección sobre él.

Podemos identificar la linterna con un punto que emite rayos de luz en cierto embudo de direcciones. En Estadística, en lugar de linternas, se suelen usar “pantallas de rayos X” o pantallas luminosas, que son superficies planas formadas por infinitos puntos que emiten rayos perpendiculares a dicha superficie. Si iluminamos la pelota con una de ellas situada en el techo, la sombra proyectada es una circunferencia con radio igual al de la pelota. Si tomamos otra pelota de diferente tamaño, la sombra será también circular, pero las distinguiremos por el tamaño de sus radios. Pero si cogemos un balón de rugby, sucede que la sombra solo es una circunferencia si el eje más largo del balón es perpendicular a la pantalla. Obtendremos una elipse si es paralelo y sombras asimétricas en las demás orientaciones.

Los rayos X atraviesan un objeto perdiendo parte de su energía, absorbida por dicho objeto. Esta absorción depende de la composición y espesor del objeto que atraviesan: si el rayo X llega a una pantalla blanca sin interferencias, su energía quema el punto de llegada y este se vuelve negro. En caso de que el objeto absorba completamente el rayo, el punto de llegada no recibe energía y permanece blanco. Los tonos grises indican una absorción parcial de la energía del rayo por parte del objeto.

Con esta analogía, a diferencia de los rayos luminosos, los rayos X permiten, por ejemplo, distinguir un huevo de madera de otro de gallina con, exactamente, la misma forma y tamaño. El de madera tendrá una sombra más o menos homogénea (aunque más oscura en los bordes, porque se atraviesa menos madera), mientras que la sombra del de gallina mostrará con claridad la yema que hay en su interior, porque la yema y la clara absorben de manera diferente los rayos X.

Por lo tanto, si tenemos dos objetos diferentes (por forma o composición) y diseñamos un emisor del estilo de los de rayos X, en el que los rayos sean parcialmente absorbidos, las proyecciones de ambos objetos van a permitir saber cuál es cuál, a no ser que los objetos que se van a proyectar tengan cierta similitud y, además, los coloquemos muy cuidadosamente. En otras palabras: si elegimos al azar la posición de un balón de rugby, con total seguridad su proyección va a delatar que no es esférico.1 El posicionamiento al azar es clave para evitar engaños de objetos cuidadosamente construidos para proyectar sombras que no son representativas de su estructura (ver [4] para una colección de ejemplos inspiradores).

3. Proyecciones en Estadística

A partir de ahora, balones y huevos van a ser reemplazados por nubes de puntos en dimensión dos, tres o superior. Estos conjuntos de datos están formados por 𝑛 vectores Xi = (Xi1,…,Xip ), 𝑖 = 1,…,𝑛, de dimensión 𝑝 que aparecen cuando se miden simultáneamente 𝑝 variables numéricas. Ejemplos de datos tridimensionales (𝑝 = 3) son el peso, la altura y la presión sanguínea de personas. Pero la tecnología permite medir muchas variables al mismo tiempo y no es raro encontrar situaciones con millares de dimensiones, lo que aumenta la complejidad de los objetos considerablemente. Para distinguir estos objetos necesitaremos un emisor-receptor de rayos X adecuado.

Haremos dos suposiciones importantes:

- 3.1 Para cada conjunto de datos hay un patrón (llamémosle patrón poblacional) que determina cómo se distribuyen estos datos.

- 3.2 Los datos que tenemos son una muestra obtenida de cierta población, y, por lo tanto, siguen el patrón poblacional que corresponda.

Las pantallas planas emisoras de rayos X tienen sentido en dimensión tres. En dimensión cuatro aparece un problema (que se mantiene en dimensiones superiores): habría que usar pantallas tridimensionales. Pero, ¿qué es una pantalla tridimensional? ¿Cómo vemos las absorciones? El uso de pantallas de dimensión superior a dos no parece ni sencillo ni de utilidad.

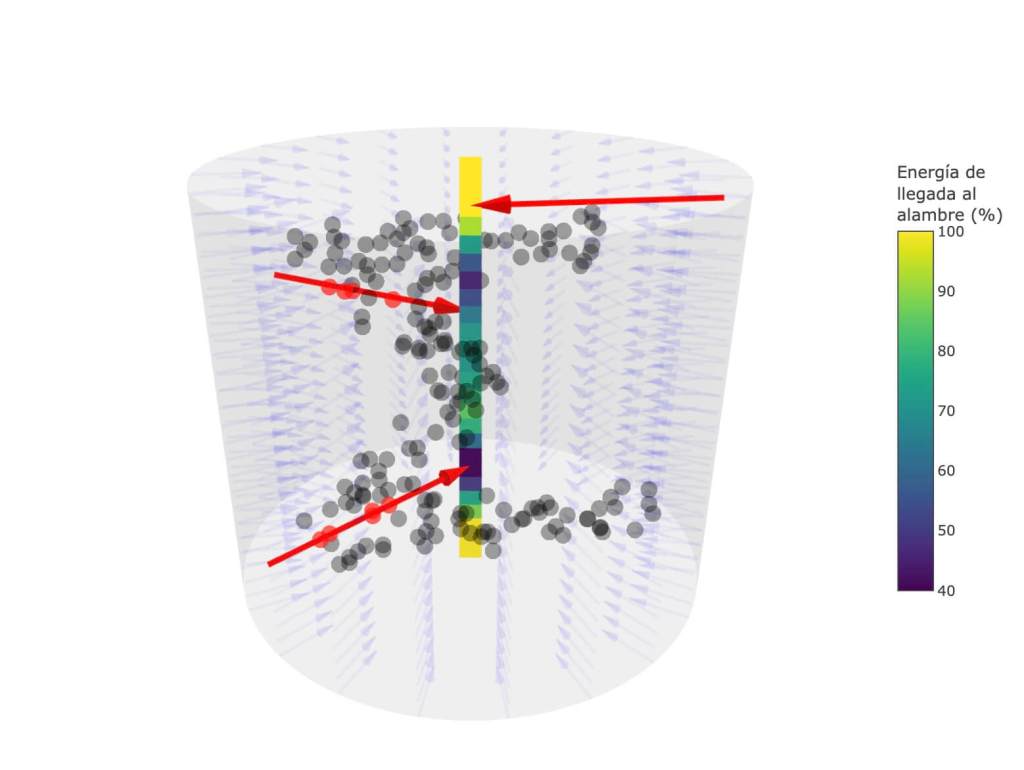

La búsqueda de un buen emisor-receptor de rayos X, que sea manejable en cualquier dimensión, se resuelve de modo sorprendentemente sencillo: ¿y si usamos un alambre como receptor en todas las dimensiones? En dimensión tres solo hay que usar una pantalla emisora cilíndrica lo suficientemente grande como para contener la nube proyectada y situar un alambre en el eje del cilindro. Podemos imaginar que todos los puntos de la superficie interior de la pantalla emisora cilíndrica emiten rayos con la misma energía hacia el eje central. Si nos fijamos en el punto situado a altura x del eje del cilindro, como las absorciones solo se producen por choques con puntos de la nube, midiendo la energía de cada rayo a la llegada, sabemos cuántos choques ha sufrido y, como no puede haber un punto que interfiera con dos rayos, sumando el número de choques sabemos el número de puntos de la nube que están situados a la altura x.

En consecuencia, podemos olvidarnos de los rayos X, del cilindro y de todo, menos del alambre central. Vamos a fijar la recta que representa a este alambre. Lo único que tenemos que hacer es coger el punto que está a altura x en esta recta y mirar cuántos puntos de la nube están a esta misma altura.

Matemáticamente, esta operación está relacionada con el producto escalar de dos vectores, Xi (dato) y h = (h1,…,hp ) (colineal con el eje del cilindro), que se define como el número

Esta operación permite comprimir el conjunto de datos 𝑝-dimensional {X1,…,Xn } al conjunto de datos proyectado {X1 ⋅ h,…,Xn ⋅ h }, ahora contenido en dimensión uno. En el caso del cilindro de la figura 4, tomamos h = (0,0,1) y el producto escalar nos proporciona las terceras coordenadas de la nube de puntos tridimensional. Es obvio que esta construcción puede hacerse en cualquier dimensión, no solo en 𝑝 = 3.

Ahora bien, ¿mantiene esta compresión la información de los datos? La respuesta es afirmativa con matices. Si elegimos la recta h al azar, el resultado principal de [5] muestra que, si hacemos las proyecciones con dos nubes de puntos con patrones diferentes, ¡es imposible que los patrones de las proyecciones coincidan! Por lo tanto, podemos distinguir patrones en los datos originales a partir de sus proyecciones aleatorias.

4. Proyecciones aleatorias en la práctica

En el punto 3.2 hemos dicho que suponemos que se eligen muestras usando determinado patrón poblacional. Pero es bien conocido que las muestras tienen cierta variabilidad natural. Por ello, aun teniendo dos patrones idénticos de partida, esta variabilidad va a hacer imposible que dos muestras obtenidas con el mismo patrón coincidan exactamente.

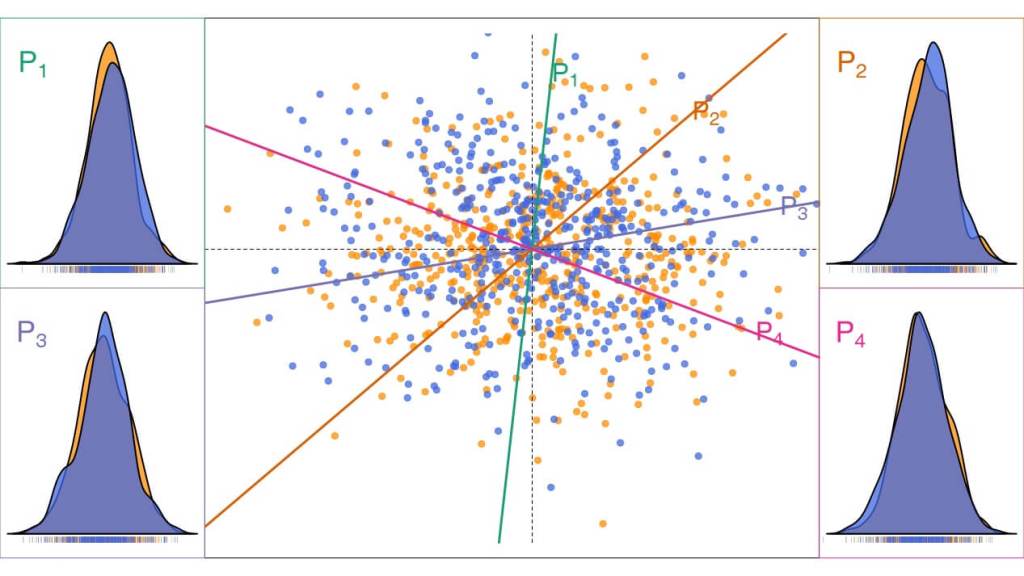

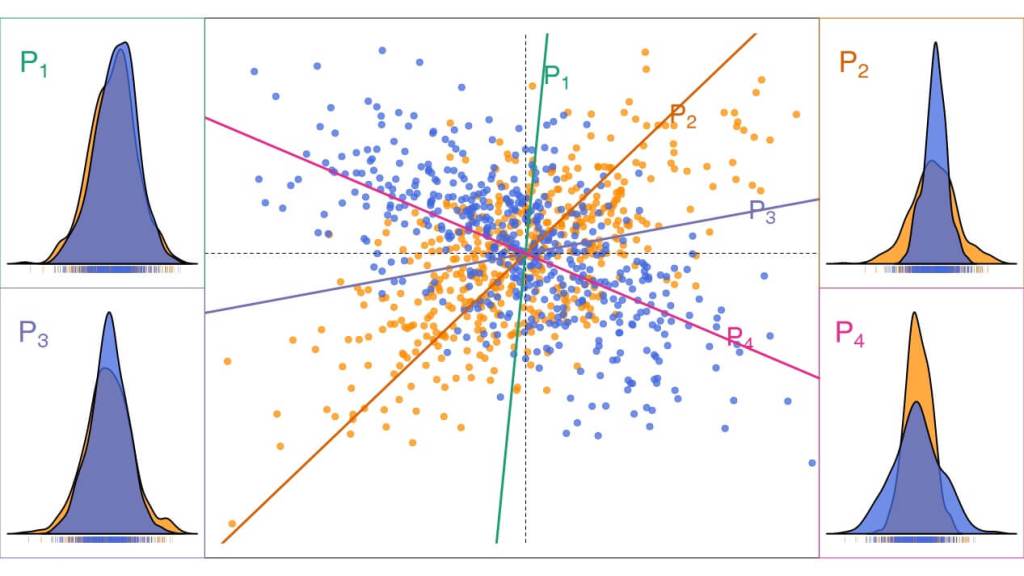

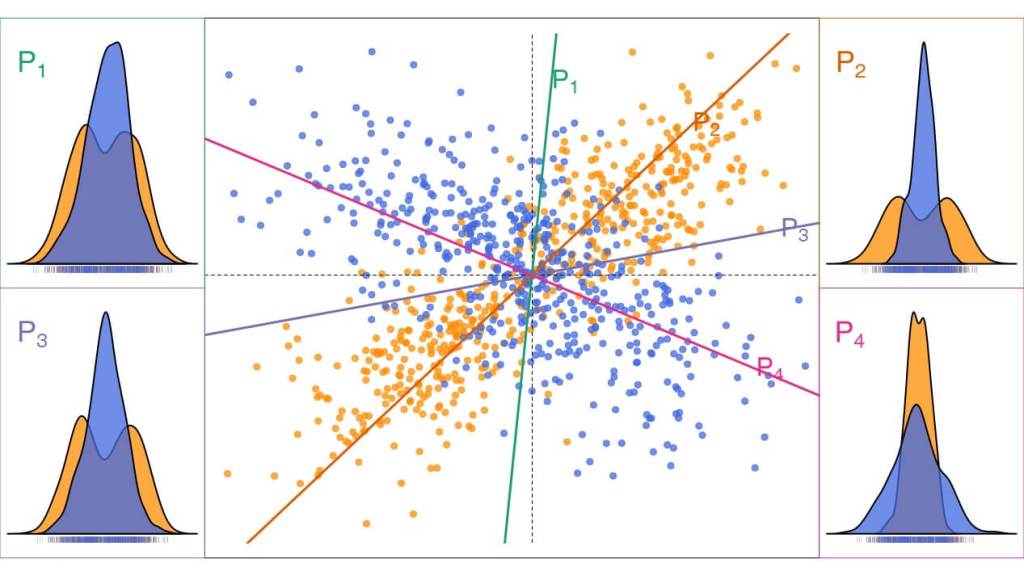

Cada una de las figuras 5, 6 y 7 contiene dos muestras de 500 puntos tomadas de dos poblaciones. Las poblaciones son idénticas en la figura 5, diferentes pero parecidas en la 6 y muy diferentes en la 7. Además, se han calculado cuatro proyecciones sobre los ejes señalados que han sido elegidos aleatoriamente. En las esquinas de las cuatro figuras, se muestran cuatro gráficos que, en el pie, recogen las proyecciones obtenidas (cada rayita vertical corresponde a la proyección de un punto) y, encima, una estimación de la densidad de probabilidad (patrón) que las produjo.

En la figura 5 estas gráficas deberían haber sido idénticas, pero la variabilidad de las muestras hace que aparezcan pequeñas diferencias entre ellas. Las muestras de la figura 6 tienen proyecciones claramente diferentes, excepto que se elija como recta el eje vertical o el horizontal.2 Como la recta P1 está próxima al eje vertical, resulta que las diferencias entre las dos proyecciones en esta recta son pequeñas. Pero a medida que nos alejamos de esta recta, las diferencias entre las proyecciones aumentan. Finalmente, las dos poblaciones involucradas en la figura 7 son tan diferentes, que sus proyecciones no se parecen en ninguna de las rectas elegidas.

Estos hechos plantean dos problemas:

- 4.1 ¿Qué diferencia tiene que haber entre las proyecciones para que estemos razonablemente seguros de que no se deben al azar? Una vez resuelta esta cuestión, tendríamos un procedimiento para poder afirmar con seguridad que dos nubes proceden de patrones diferentes.

- 4.2 Aunque según la teoría de [5], con suficientes datos, una única proyección es suficiente para distinguir entre dos patrones diferentes, la figura 5 muestra que, en la práctica, el azar puede elegir una dirección en la que las diferencias entre proyecciones sean similares a las esperadas por el azar.

Está claro que, si se soluciona el primer punto y se dispone de una herramienta de proyección, podemos analizar la semejanza o diferencia entre patrones de objetos complejos (curvas o datos de alta dimensión) simplemente analizando diferencias entre sus valores proyectados (números), que es una tarea más asequible.

5. De vuelta a las curvas

Los problemas 4.1 y 4.2 han sido resueltos en [1] para construir el test de validez del modelo de regresión lineal cuando la variable X (t ) es una curva (por ejemplo, dependiente del tiempo t ). Este modelo establece que existe una función β (t ) desconocida, de modo que cada curva X (t ) tiene asociado un valor numérico de Y determinado por

donde ε es un error aleatorio. La proyección de la curva X (t ) en la dirección determinada por la curva h (t ) se define como

lo que representa una extensión natural del producto escalar entre dos vectores.

La solución del problema 4.1 ocupa la mayor parte de [1] porque es técnica y compleja. La complejidad proviene de que la dimensión del espacio de curvas es infinita, lo que dificulta la estimación de β (t ).

La solución del problema 4.2 es más sencilla. Consiste en elegir varias direcciones de proyección y usar los resultados para decidir.3 La experiencia muestra que la posibilidad de distinguir entre patrones diferentes aumenta bastante utilizando entre 5 y 15 proyecciones aleatorias.

En conclusión, las proyecciones aleatorias son una herramienta de uso sencillo, que permite responder al complejo problema de decidir si la relación entre una población de curvas y una de respuestas numéricas puede ser lineal. El lector interesado en profundizar en las contribuciones técnicas del trabajo puede encontrar en [6] una exposición más detallada.

Notas

- El balón de rugby se delata siempre que su eje mayor no coincida exactamente con la perpendicular de la pared roja.

- Estos ejes se comportan igual que el eje mayor del balón de rugby.

- Una solución puede ser aplicar el test a las proyecciones disponibles y quedarse con la dirección en que los patrones son más diferentes; pero también se pueden promediar los resultados del test en todas las direcciones.

Referencias

- [1] Cuesta-Albertos, J.A., García-Portugués, E., Febrero-Bande, M. y González-Manteiga, W. (2019). Goodness-of-fit tests for the functional linear model based on randomly projected empirical processes. The Annals of Statistics, 47(1), 439–467. doi:10.1214/18-AOS1693.

- [2] Cuevas, A. (2014). A partial overview of the theory of statistics with functional data. Journal of Statistical Planning and Inference, 147, 1–23. doi:10.1016/j.jspi.2013.04.002.

- [3] Wang, J.-L., Chiou, J.-M., Müller y H.-G. (2016). Functional data analysis. Annual Review of Statistics and Its Application, 3, 257–295. doi:10.1146/annurev-statistics-041715-033624.

- [4] Mitra, N. J. y Pauly, M. (2009). Shadow art. ACM Transactions on Graphics, 28(5):1–7. doi:10.1145/1618452.1618502. En acceso abierto a través de https://graphics.stanford.edu/~niloy/research/shadowArt/shadowArt_sigA_09.html.

- [5] Cuesta-Albertos, J.A., Fraiman, R. y Ransford, T. (2007). A sharp form of the Cramer–Wold theorem. Journal of Theoretical Probability, 20, 201–209. doi:10.1007/s10959-007-0060-7.

- [6] Cuesta-Albertos, J.A., García-Portugués, E., Febrero-Bande, M. y González-Manteiga, W. (2024). Tests de bondad de ajuste para el modelo lineal funcional basados en proyecciones. Boletín de Estadística e Investigación Operativa, 40(3), 7–20. https://www.seio.es/wp-content/uploads/2024_40_3_BEIO_Estadistica.pdf

Juan Antonio Cuesta Albertos

Doctor en Ciencias Matemáticas

Eduardo García Portugués

Doctor en Estadística e Investigación Operativa

Manuel Febrero Bande

Doctor en Estadística e Investigación Operativa

Wenceslao González Manteiga

Doctor en Estadística e Investigación Operativa

Cerca de los arrecifes del Pacífico occidental, entre ramas de coral que parecen salidas de un paisaje extraterrestre, vive un animal diminuto y casi imposible de ver. No es un mito marino ni una ilusión óptica. Se trata del Hippocampus bargibanti, un caballito de mar pigmeo que se esconde a plena vista gracias a un camuflaje tan perfecto que engaña tanto a depredadores como a buceadores. Su cuerpo reproduce con precisión los colores, formas y texturas del coral del que depende, hasta el punto de que durante años nadie supo que existía.

Un reciente estudio, publicado en la revista Proceedings of the National Academy of Sciences (PNAS), ha mostrado que este prodigioso mimetismo no se debe a una acumulación de adaptaciones genéticas, como cabría esperar, sino a una sorprendente pérdida de genes clave. El trabajo, liderado por un equipo germano-chino, ha secuenciado por primera vez el genoma completo del caballito de mar pigmeo y descubierto que su transformación evolutiva se debe, en gran medida, a lo que ya no tiene en su ADN. Lo que desapareció fue tan determinante como lo que quedó.

Una forma que desaparece en el entorno

La capacidad del caballito de mar pigmeo para fusionarse visualmente con su entorno no es anecdótica, puesto que es una cuestión de supervivencia. Su tamaño, de apenas dos centímetros, lo convierte en una presa fácil si no logra pasar desapercibido. Para evitarlo, ha evolucionado hasta desarrollar una textura corporal con pequeños nódulos que imitan los pólipos del coral Muricella, su anfitrión habitual. Además, su coloración cambia sutilmente para coincidir con la del coral específico donde vive.

Lo más llamativo de este caso es que estos cambios físicos tan específicos no se lograron añadiendo complejidad genética, sino suprimiéndola. El estudio descubrió que el Hippocampus bargibanti ha perdido al menos 438 genes completos en comparación con otros caballitos de mar, así como 635 genes adicionales que están presentes pero mutados y ya no funcionan. Estas pérdidas afectan no solo a la forma externa, sino también a sistemas internos fundamentales, como el inmunológico.

El gen perdido que modeló la cabeza

Una de las claves más sorprendentes del estudio tiene que ver con la forma de la cabeza del animal. A diferencia de otros caballitos de mar, que presentan un hocico alargado característico, el caballito pigmeo tiene un hocico corto, redondeado, similar a los nódulos del coral. Esta diferencia estructural no es casual. Los investigadores descubrieron que el gen hoxa2b, un gen regulador crucial en el desarrollo craneofacial, se ha perdido completamente en esta especie.

"Normalmente, una combinación de diferentes componentes genéticos hace que el hocico del caballito de mar crezca proporcionalmente más rápido que otras partes del cuerpo", explica Axel Meyer, coautor del estudio. "En el caballito pigmeo, sin embargo, hemos descubierto que estas tasas de crecimiento están suprimidas porque el gen hoxa2b se ha perdido". Esto mantiene la cabeza en un estado juvenil permanente, con proporciones pequeñas que coinciden mejor con la estructura del coral y mejoran su camuflaje.

Una piel diseñada por la pérdida

Además del hocico, la piel del Hippocampus bargibanti también revela huellas de una evolución por sustracción. La formación de los nódulos dérmicos que imitan el coral parece estar relacionada con la desactivación de ciertos genes que controlan la morfogénesis normal de la piel. Aunque aún no se ha determinado exactamente qué genes regulan la formación de estas protuberancias, los investigadores observaron una reorganización sustancial en los patrones de expresión genética durante el desarrollo embrionario, en especial en las regiones responsables del crecimiento de la cabeza y la piel.

El estudio también apunta a la pérdida de numerosos "interruptores genéticos", es decir, secuencias reguladoras cercanas a los genes que no codifican proteínas pero que controlan cuándo y cómo se activan ciertos genes durante el desarrollo. Esta pérdida de control habría contribuido a que ciertos rasgos, como el hocico corto y la textura de la piel, se mantuvieran constantes desde las primeras etapas del crecimiento hasta la adultez.

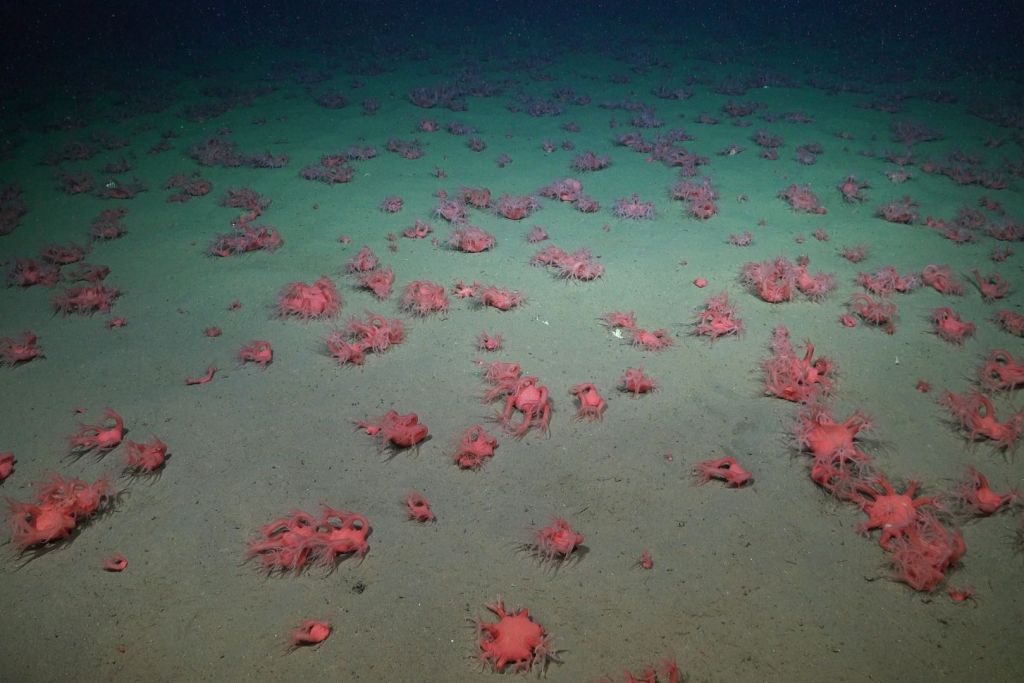

El sistema inmune más reducido entre los vertebrados

Uno de los descubrimientos más llamativos del estudio tiene que ver con el sistema inmunológico del caballito de mar pigmeo. El análisis genético reveló que esta especie ha perdido numerosos genes relacionados con la inmunidad, incluyendo los genes MHC, que codifican proteínas esenciales para reconocer y combatir agentes patógenos. Esto lo convierte, según los autores, en el vertebrado conocido con el repertorio inmunológico más reducido.

En otras circunstancias, esta fragilidad inmunitaria sería un grave problema. Sin embargo, el caballito pigmeo ha encontrado una solución inesperada: la vida en simbiosis con su coral huésped. Estos corales producen compuestos antimicrobianos naturales que actúan como una barrera química, protegiendo tanto al coral como al caballito. Al parecer, vivir permanentemente sobre el coral ha permitido al caballito desprenderse de parte de su sistema inmunológico sin sufrir consecuencias negativas.

El papel del sistema inmune en la reproducción

La pérdida de genes inmunitarios no solo influye en la defensa contra enfermedades, sino también en la forma en que estos animales se reproducen. En los caballitos de mar, el macho es quien incuba los embriones en una bolsa especial del abdomen. En la mayoría de los vertebrados, esta situación generaría una respuesta inmunitaria del cuerpo del macho contra los embriones, al considerarlos tejido ajeno. Sin embargo, en el Hippocampus bargibanti, la pérdida de genes inmunitarios habría facilitado esta peculiar forma de embarazo masculino al evitar el rechazo inmunológico de los embriones.

"Perder genes del sistema inmunológico fue necesario para debilitar la respuesta inmunitaria correspondiente", indicó Axel Meyer. Esta adaptación ha permitido que la reproducción en el caballito pigmeo ocurra de forma más eficiente en un entorno donde el mimetismo, la inmovilidad y la simbiosis son claves para la supervivencia.

Evolución por descarte: una estrategia poco común

El caso del caballito de mar pigmeo rompe con la idea convencional de que la evolución opera añadiendo complejidad. En lugar de ganar nuevos genes, esta especie ha ganado ventajas adaptativas al eliminar partes de su genoma. Esto sugiere que, en ciertos contextos, la pérdida genética puede ser no solo beneficiosa, sino fundamental para la supervivencia.

"En todas estas adaptaciones vemos ejemplos de pérdidas masivas de genes y una aparente liberación paradójica de creatividad evolutiva, que en última instancia explica el aspecto inusual y la biología extraordinaria de estas criaturas", escriben los autores del artículo. Esta perspectiva ofrece una nueva forma de entender cómo opera la selección natural, especialmente en organismos que dependen de una relación tan estrecha con su entorno.

Referencias

- M. Qu, Y. Zhang, J. Woltering, Y. Liu, Z. Liu, S. Wan, H. Jiang, H. Yu, Z. Chen, X. Wang, Z. Zhang, G. Qin, R. Schneider, A. Meyer, Q. Lin (2025): Symbiosis with and mimicry of corals were facilitated by immune gene loss and body remodeling in the pygmy seahorse, Proceedings of the National Academy of Sciences, 122 (35) e2423818122. https://doi.org/10.1073/pnas.2423818122.

La llamada dieta mediterránea suele considerarse un legado ancestral, una práctica alimentaria transmitida casi sin rupturas desde la antigüedad hasta el presente. Su prestigio contemporáneo, asociado a la salud, la longevidad y la identidad cultural, ha consolidado la idea de que se trata de una tradición milenaria. Sin embargo, las investigaciones arqueobotánicas matizan esta visión al revelar que la dieta en las orillas orientales del Mediterráneo experimentó variaciones, adaptaciones y tensiones ligadas tanto al entorno ecológico como a los cambios políticos y económicos.

Un reciente estudio firmado por Jessica Feito analiza los restos macrobotánicos procedentes de 65 yacimientos en el Levante para reconstruir de manera precisa qué comían sus habitantes entre el 1000 a.C. y el 500 d.C. El trabajo abarca desde la Edad del Hierro hasta la Antigüedad tardía, pasando por las etapas persa, helenística y romana. Los resultados destacan la importancia de los cultivos locales y la persistencia de hábitos alimentarios específicos frente a las modas imperiales.

Los cereales: entre la estabilidad y la adaptación