Las piedras, los huesos y las piezas metálicas suelen soportar bien el paso del tiempo y, por ello, se han convertido en preciados aliados de la arqueología y la historia. Los materiales orgánicos, por el contrario, se deterioran con rapidez, por lo que no siempre pueden ser estudiados. Por eso, este rarísimo sombrero romano de 2.000 años de antigüedad, que se ha restaurado y expuesto recientemente al público por primera vez en el Bolton Museum (Inglaterra) resulta tan excepcional. Fabricado en lana y con un diseño adaptado para soportar las duras condiciones del desierto egipcio, este ejemplares el que muestra un mejor estado de conservación de los tres que se conocen en todo el mundo.

El sombrero y su contexto histórico

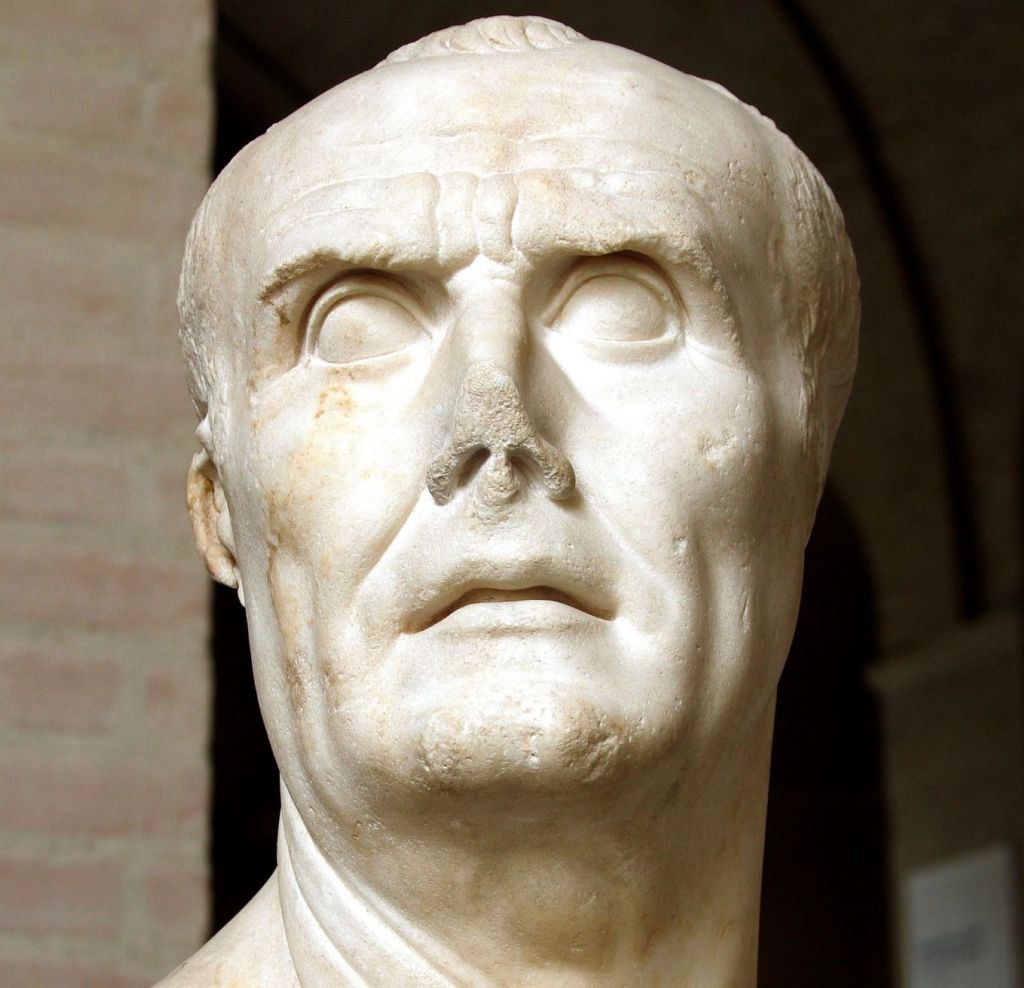

El sombrero se ha fechado hacia el año 30 a. C., poco después de la muerte de Cleopatra VII y de la transformación de Egipto en provincia del Imperio romano. Tras la derrota de Marco Antonio y Cleopatra en la batalla de Accio, el país pasó a estar gobernado directamente por Roma, razón por la que se enviaron destacamentos militares para asegurar el control político y económico de la región. Entre esos soldados romanos, algunos tuvieron que enfrentarse a un clima muy diferente al del territorio itálico y de otras provincias imperiales: el calor extremo del desierto, el sol abrasador y las tormentas de arena.

El ejemplar hallado parece haber sido una adaptación de un tipo de tocado militar estándar de la época, modificado para ofrecer protección frente a la intensa radiación solar y las partículas en suspensión. De los tres sombreros de este tipo que han sobrevivido, uno se conserva en la Whitworth Art Gallery de Mánchester, otro en un museo de Florencia, y el tercero —el de Bolton— es, según los especialistas, el mejor preservado de todos.

De Egipto a Inglaterra: un viaje arqueológico

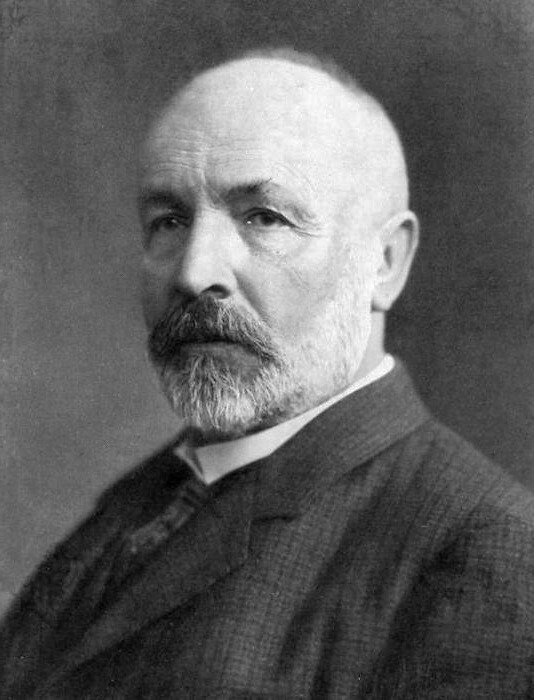

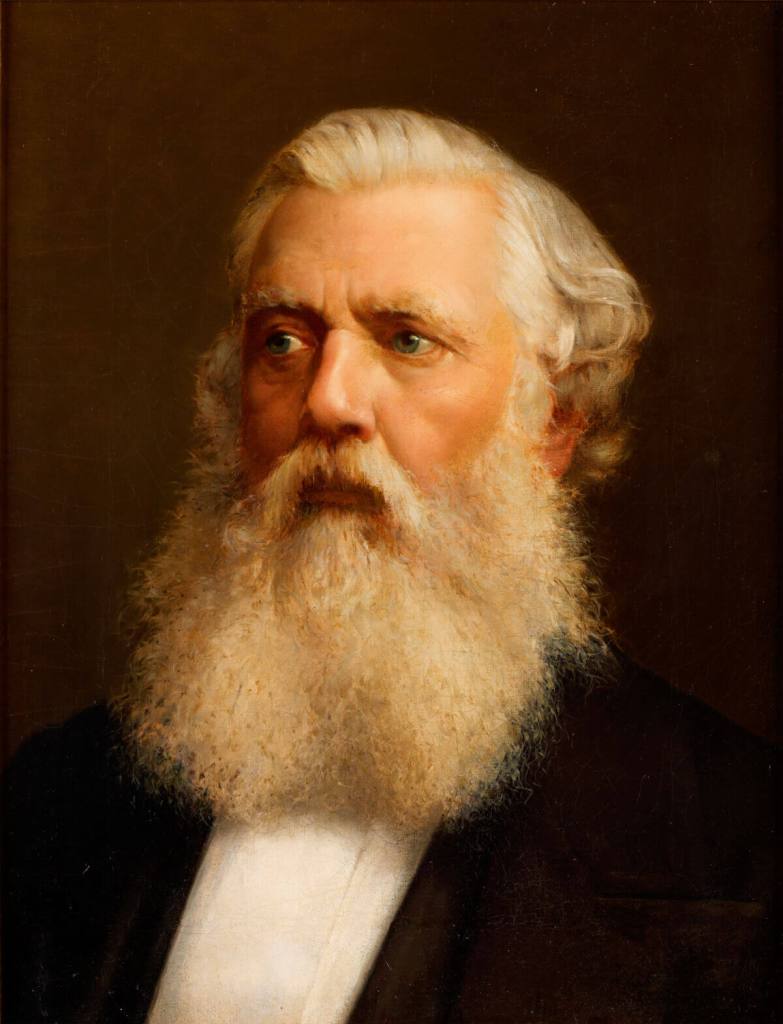

El arribo de esta pieza a Inglaterra se debe al trabajo de William Matthew Flinders Petrie, uno de los arqueólogos más influyentes del siglo XIX y principios del XX. Apodado “el hombre que descubrió Egipto”, Petrie revolucionó las prácticas arqueológicas en una época en la que muchas excavaciones eran poco más que expediciones de saqueo. Frente al interés de conseguir objetos valiosos y espectaculares con los que llenar los expositores de los museos, Petrie introdujo métodos de excavación sistemáticos, registros meticulosos y la valoración de piezas en apariencia insignificantes, como cerámicas rotas o textiles deteriorados, que aportaban información esencial sobre la vida diaria de las sociedades antiguas.

En 1911, Petrie donó el sombrero al Chadwick Museum, el primer museo de la ciudad de Bolton. Desde entonces y durante décadas, el artefacto permaneció guardado en una caja, lejos del público.

Un desafío para la restauración textil

Cuando la conservadora textil Jacqui Hyman vio por primera vez el sombrero romano, la pieza no era más que un fragmento plano y quebradizo, con daños serios provocados por las polillas. Recuperar su volumen y estabilizar los restos requería un trabajo minucioso y un profundo conocimiento de las técnicas de conservación de fibras antiguas.

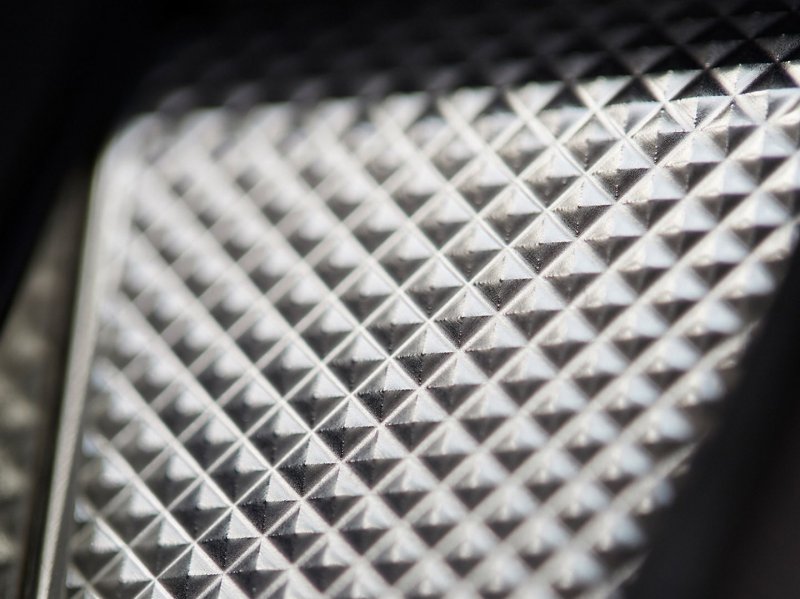

Con casi cinco décadas de experiencia trabajando para museos y colecciones de todo el mundo, Hyman planificó un tratamiento a medida que respetara la fragilidad de la pieza. Para estabilizar las zonas donde el fieltro original había desaparecido, utilizó un tejido similar, teñido a mano para igualar el color y la textura. Con este soporte interno, el sombrero recuperó su forma original. Así, pasó de ser un objeto aplastado y frágil a convertirse en una prenda tridimensional que permite apreciar su forma y función.

Un testimonio de la vida militar romana en Egipto

Más allá de su rareza, el sombrero constituye un testimonio tangible del día a día de los soldados romanos destinados a las provincias lejanas. Las legiones movilizadas en Egipto, además de mantener la seguridad y el control político, tuvieron que adaptarse a condiciones ambientales que ponían a prueba su resistencia física. En este contexto, vestir la indumentaria adecuada resultaba tan importante como las armas. Protegerse del sol y del calor podía marcar la diferencia entre seguir en servicio o sucumbir a las duras condiciones.

Este inusual tocado revela cómo el ejército romano era capaz de adaptar los materiales y diseños de su equipamiento a las necesidades específicas de cada territorio. En Egipto, la lana trabajada como fieltro, ligera y transpirable, cumplía la doble función de bloquear la radiación solar y ofrecer cierta protección frente la arena.

Del almacén a la vitrina

En la actualidad, el sombrero rescatado por Petrie se exhibe en las galerías egipcias del Bolton Museum. La institución considera que su valor no radica únicamente en la conexión con la historia global, sino también en la capacidad de inspirar a las nuevas generaciones. El montaje expositivo, addemás, permite a los visitantes observar de cerca los detalles de la pieza, su textura y las secciones que se han restaurado. Ofrece, así, una oportunidad única para reflexionar sobre la vida cotidiana en la antigüedad y sobre las técnicas de conservación que permiten que objetos tan frágiles lleguen hasta nosotros.

Una historia de adaptación encerrada en un sombrero

La restauración del sombrero romano de Bolton supone la recuperación de una historia que conecta el Egipto de Cleopatra con la Inglaterra contemporánea, pasando por las manos de un arqueólogo visionario y de una restauradora experimentada. Ilustra la adaptación de un soldado a un medio hostil, la pervivencia de un objeto humilde frente al paso del tiempo y el valor de la colaboración entre museos, especialistas y comunidad. Desde los desiertos bañados por el Nilo hasta las neblinosas tierras británicas, dos milenios después, este singular objeto vuelve a ver la luz.

Referencias

- Bolton Library and Museum. URL: https://www.boltonlams.co.uk/bolton-museum

- Chaudhari, Saiqa. 2025. "Bolton Museum display Ancient Eygptian relic for the first time". The Bolton News. URL: https://www.theboltonnews.co.uk/news/25369974.bolton-museum-display-ancient-eygptian-relic-first-time/

- Puiu, Tibi. 2025. "A Rare 2,000-Year-Old Roman Hat From Cleopatra’s Egypt Has Been Restored to Its Former Glory". ZME Science. URL: https://www.zmescience.com/science/archaeology/a-rare-2000-year-old-roman-hat-from-cleopatras-egypt-has-been-restored-to-its-former-glory/

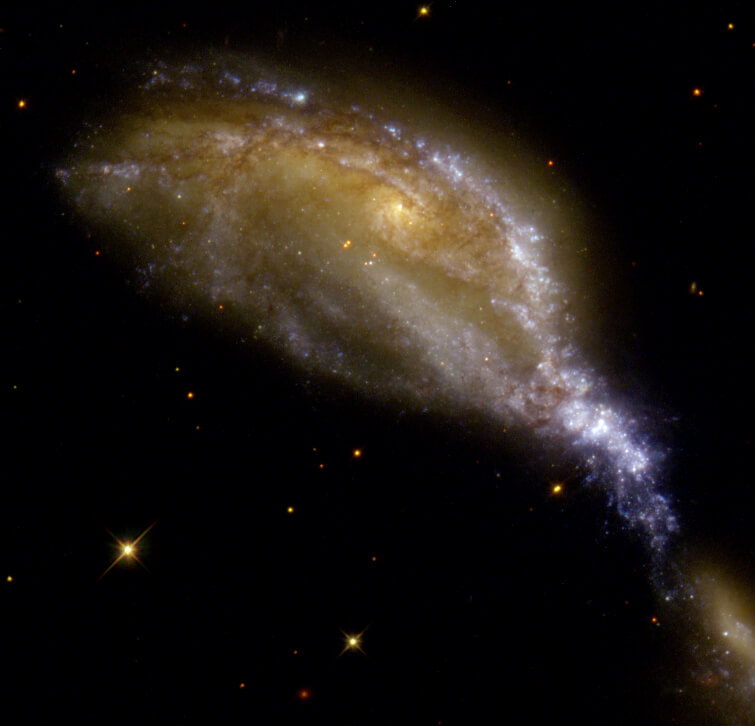

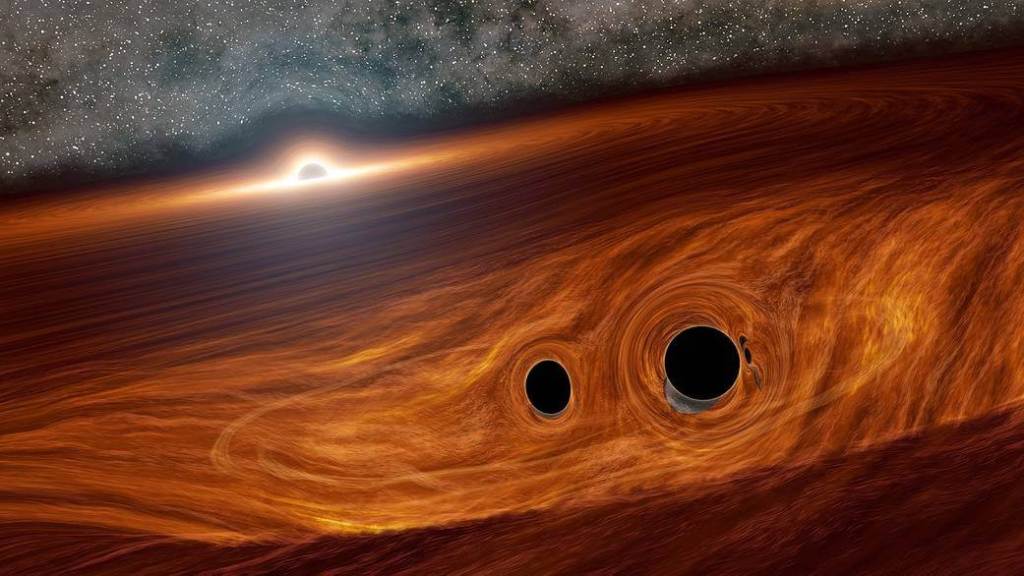

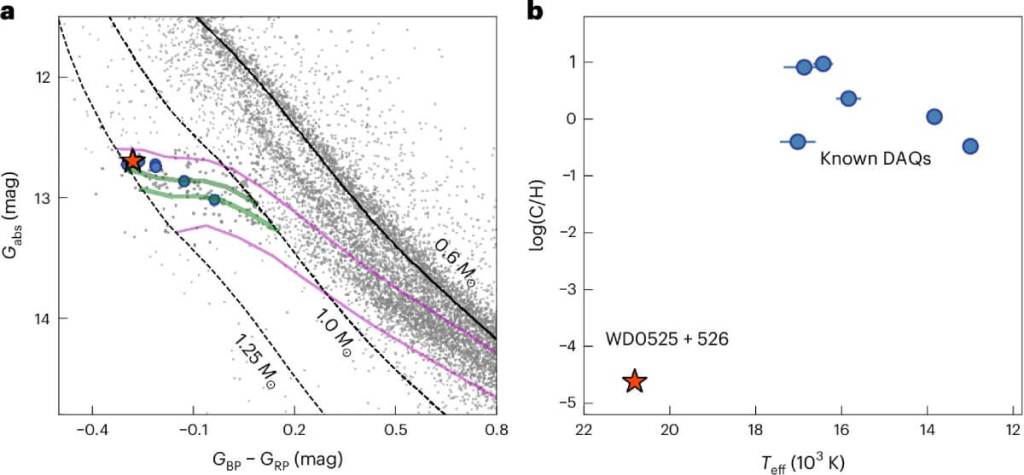

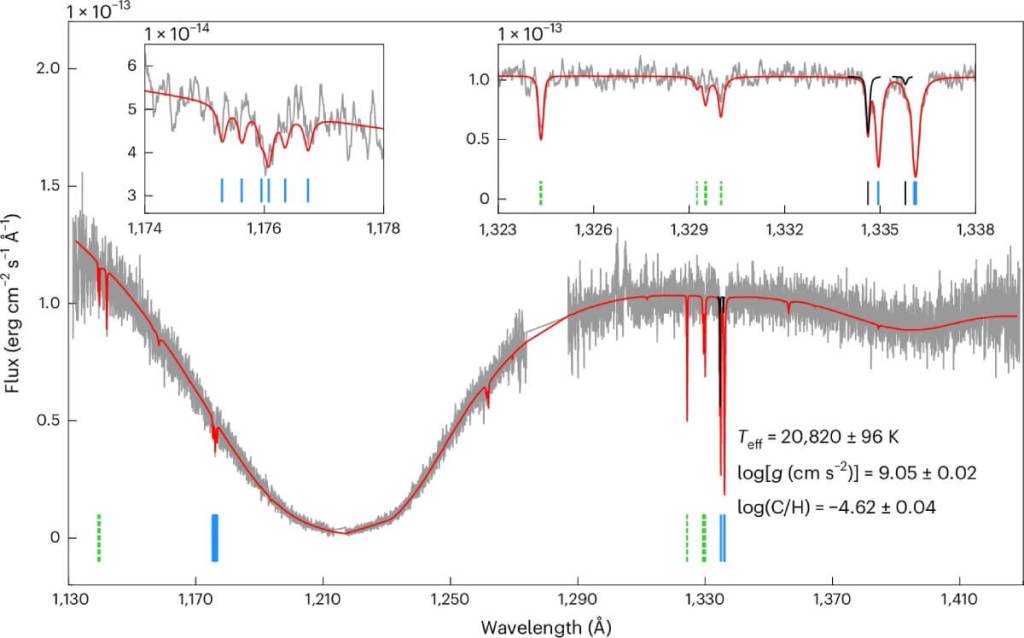

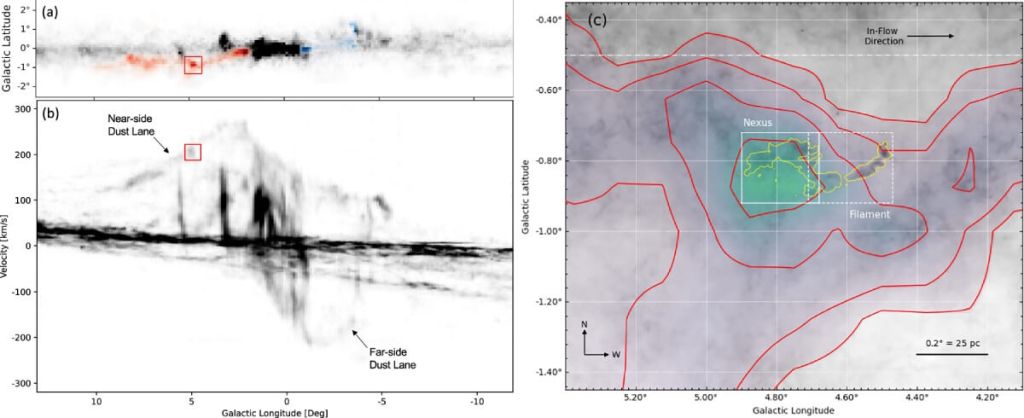

En 2019, el detector LIGO captó una señal que parecía provenir de la fusión de dos agujeros negros. Nada fuera de lo común, si no fuera porque esta fusión tenía una particularidad que desconcertó a los científicos: las masas de los objetos involucrados eran muy diferentes, algo extremadamente raro en este tipo de eventos. Lo que parecía una simple anomalía se convirtió, años más tarde, en una pista crucial para entender un fenómeno más complejo: la posible existencia del primer sistema triple de agujeros negros jamás detectado.

Un nuevo estudio, publicado en The Astrophysical Journal Letters, ha reanalizado aquella señal de 2019, conocida como GW190814. Gracias a técnicas de modelado avanzadas, los investigadores han descubierto indicios sólidos de que una tercera presencia invisible —posiblemente un agujero negro supermasivo— estaba influenciando el movimiento del par de agujeros negros que se fusionaron. Es como si dos bailarines hubieran chocado en plena danza, empujados por una fuerza silenciosa desde la penumbra del escenario.

Un evento que no encajaba en los modelos clásicos

El evento GW190814 se caracterizó por la colisión entre dos objetos de 23 y 2,6 veces la masa del Sol, respectivamente. Esta diferencia extrema desconcertó a los astrofísicos. Normalmente, cuando dos agujeros negros se fusionan, sus masas son más similares, lo cual facilita la pérdida de energía gravitacional necesaria para que se acerquen y colapsen juntos. Sin embargo, en este caso, la asimetría era tan inusual que resultaba difícil de explicar con los modelos tradicionales.

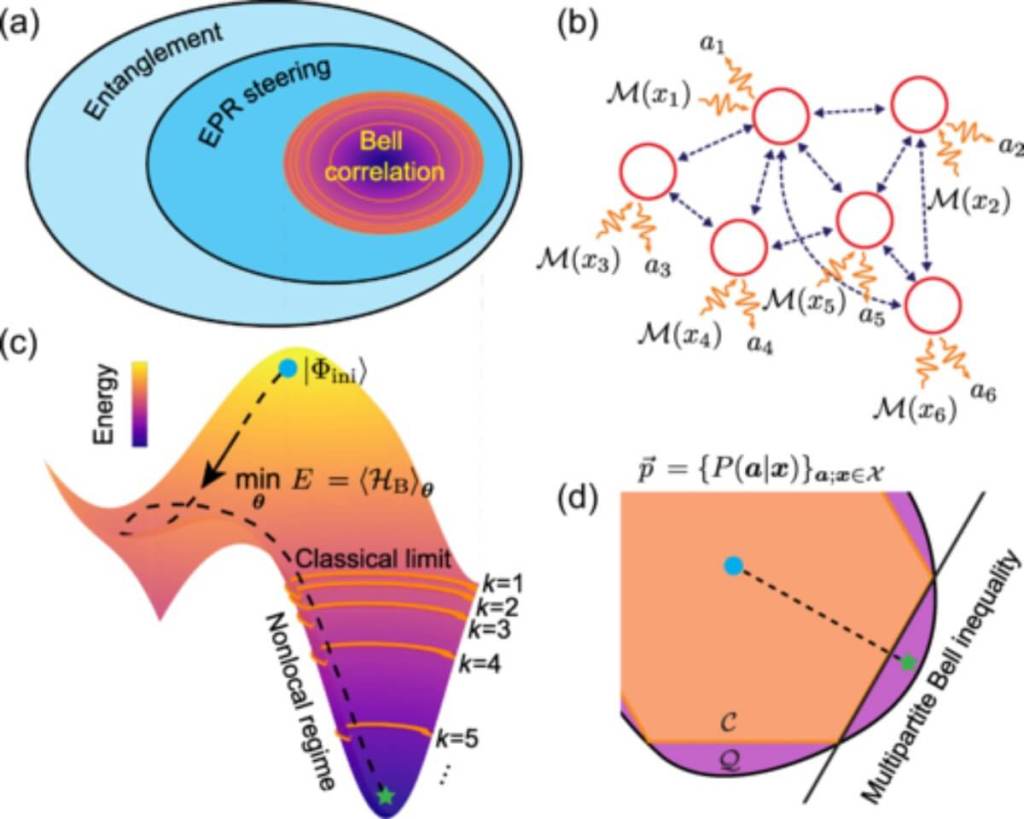

El nuevo análisis, liderado por investigadores del Observatorio Astronómico de Shanghái y otras instituciones, propone una explicación basada en la presencia de un tercer objeto cercano. Este objeto habría generado una aceleración adicional en la línea de visión del sistema, algo que deja una huella detectable en la señal de ondas gravitacionales. Según los autores del estudio, "concluimos que esta es la primera indicación que muestra que agujeros negros binarios en proceso de fusión están situados cerca de un tercer objeto compacto" .

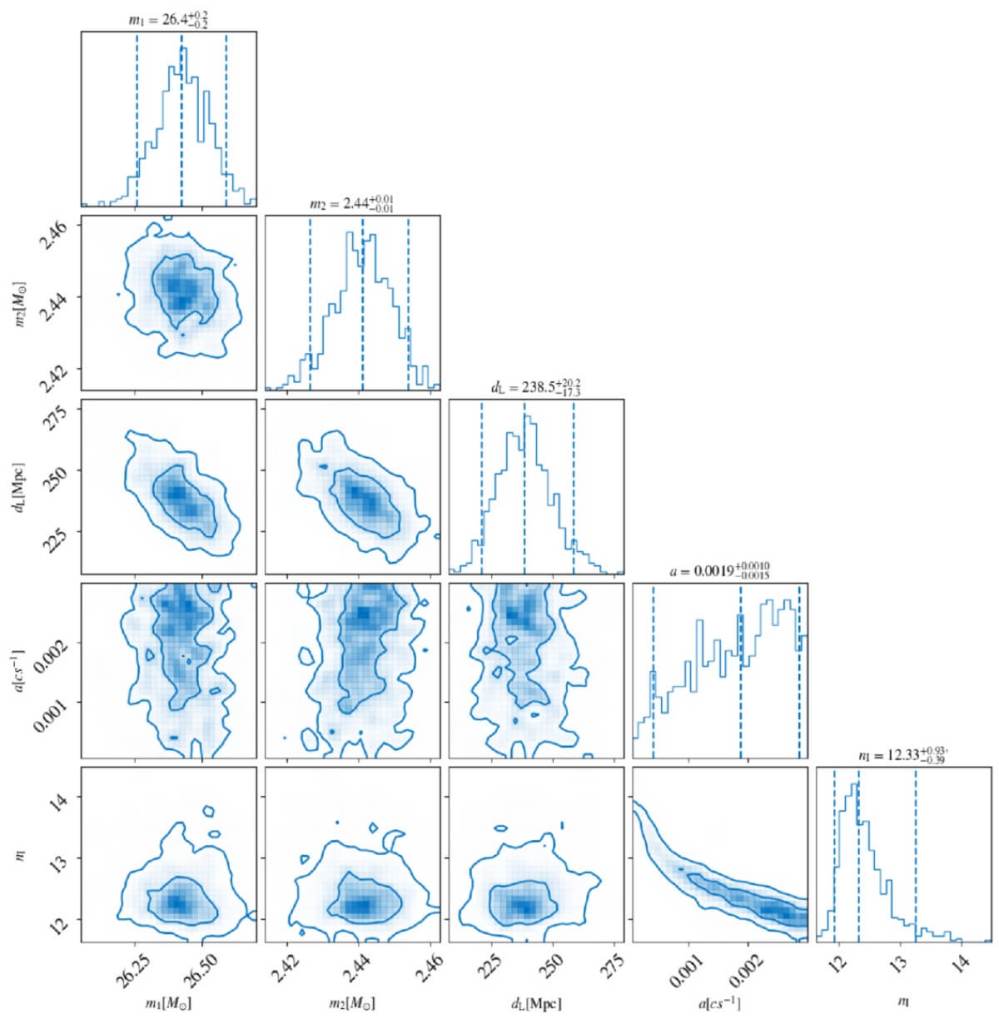

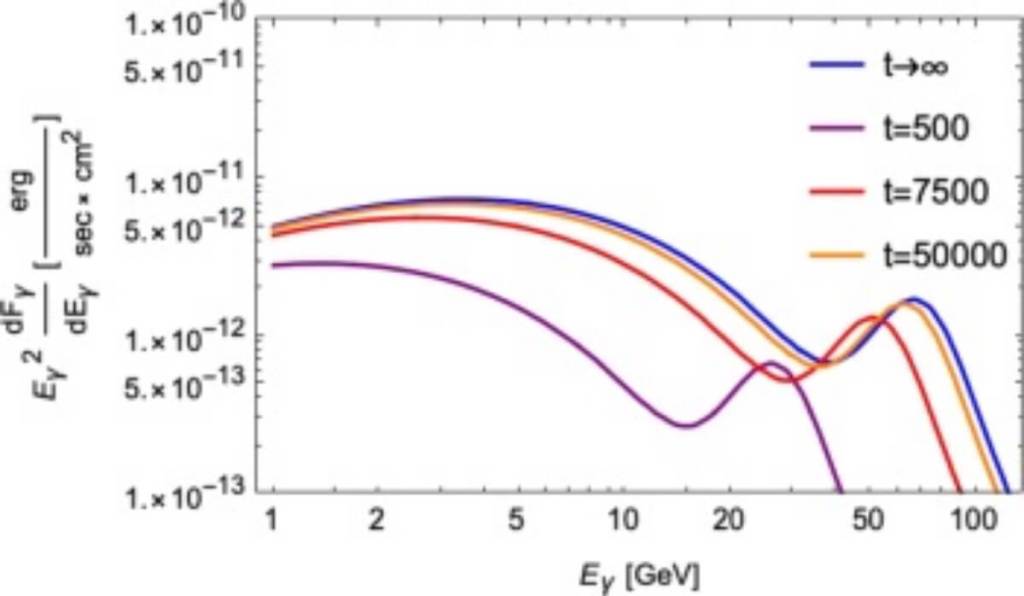

Los resultados se obtuvieron aplicando un modelo que considera la llamada aceleración en la línea de visión (LSA, por sus siglas en inglés). Esta técnica permite detectar pequeñas variaciones en la frecuencia de la señal debido al efecto Doppler causado por la aceleración del sistema en su entorno gravitacional. El análisis estadístico arrojó un valor de 58/1 a favor del modelo con LSA frente al modelo sin aceleración, lo cual representa una evidencia contundente según los criterios científicos actuales.

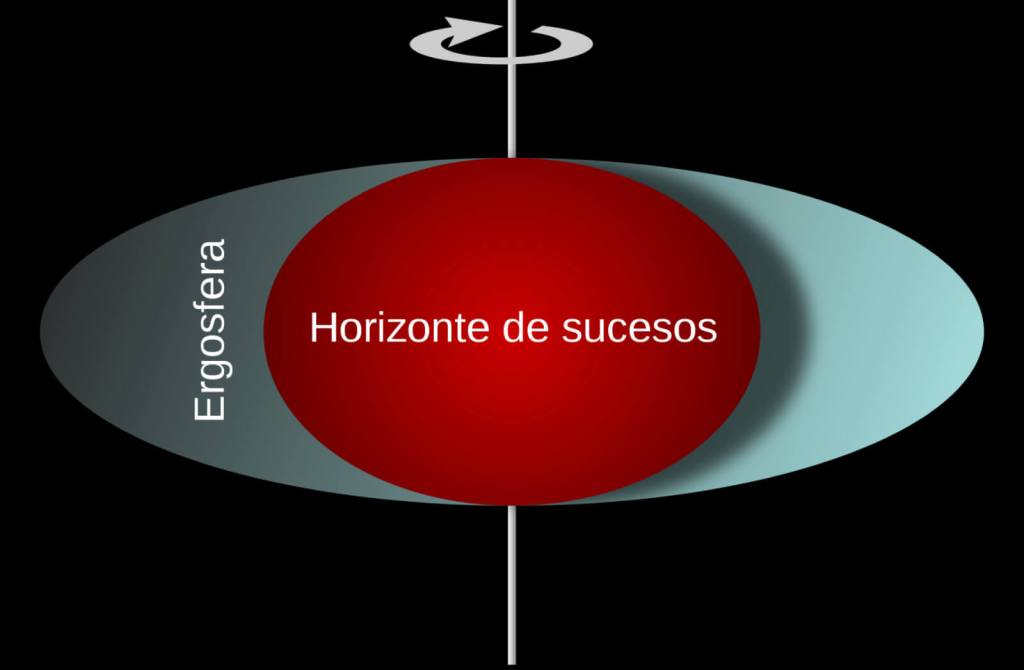

¿Cómo se puede "ver" un objeto que no emite luz?

Los agujeros negros, por definición, no emiten luz. Detectarlos requiere observar sus efectos sobre el entorno. En este caso, el tercer objeto no fue observado directamente, sino a través de las sutiles alteraciones que provocó en la señal de las ondas gravitacionales.

Estas ondas son ondulaciones en el espacio-tiempo que se producen cuando ocurren eventos extremadamente energéticos, como la fusión de agujeros negros. El detector LIGO (y su homólogo europeo Virgo) ha registrado decenas de estos eventos desde 2015. Pero GW190814 destacaba por sus características únicas. El equipo de investigación desarrolló simulaciones detalladas para predecir cómo sería la señal si hubiera un tercer cuerpo ejerciendo influencia. La coincidencia entre la señal real y la predicción del modelo fue sorprendente.

En palabras del artículo científico, "una fuente que se acelera produce una masa que varía con el tiempo en el marco del detector, lo que deja una huella en la forma de onda gravitacional". Esto significa que no solo se detectó la fusión, sino también los efectos dinámicos de un cuerpo adicional cuya existencia fue inferida gracias a su firma gravitacional.

¿Un agujero negro supermasivo escondido?

Aunque no se ha podido determinar con precisión qué tipo de objeto era el tercero en discordia, los autores consideran que la opción más plausible es un agujero negro supermasivo. Este tipo de cuerpos celestes puede superar los 100.000 soles en masa y suele encontrarse en el centro de las galaxias. Su inmensa gravedad puede capturar objetos cercanos y alterar significativamente sus trayectorias.

Los datos obtenidos sugieren que el sistema binario de agujeros negros estaba orbitando alrededor de este coloso, de forma similar a como la Tierra y la Luna giran mientras se mueven juntas en torno al Sol. Según los investigadores, la aceleración estimada del sistema (de aproximadamente 0,0015 c/s, donde c es la velocidad de la luz) solo puede explicarse si hay un objeto muy masivo ejerciendo influencia desde las cercanías .

No se descarta, sin embargo, que el tercer objeto pueda ser un agujero negro de masa estelar especialmente denso, aunque esto requeriría condiciones muy específicas. En cualquier caso, la detección abre nuevas posibilidades para estudiar los entornos donde nacen y evolucionan los sistemas de agujeros negros.

Implicaciones para el estudio del universo

Este hallazgo tiene un enorme valor para la astrofísica moderna. Hasta ahora, se pensaba que la mayoría de las fusiones de agujeros negros ocurrían en sistemas aislados. La posibilidad de que estén interactuando con otros cuerpos más grandes, como agujeros negros supermasivos o estrellas densas, cambia el enfoque de muchas teorías sobre su formación.

Además, este tipo de estudios ayuda a afinar los modelos de detección de ondas gravitacionales. La presencia de un tercer objeto introduce variaciones sutiles en las señales que pueden ser confundidas con otros fenómenos si no se tienen en cuenta. Al perfeccionar los modelos y las técnicas de análisis, será posible identificar con mayor precisión futuros sistemas complejos.

También se abre la puerta a una nueva clase de sistemas: los triples gravitacionales. Hasta ahora, los sistemas de tres agujeros negros eran solo una posibilidad teórica. Este trabajo representa el primer indicio firme de su existencia. La frase del estudio, "este es el primer indicio que muestra que agujeros negros binarios en proceso de fusión están situados cerca de un tercer objeto compacto", resume la trascendencia del hallazgo.

El futuro de la observación gravitacional

Con la próxima generación de detectores, como el Telescopio Einstein o la misión espacial LISA, será posible observar señales aún más débiles y lejanas. Esto permitirá detectar sistemas múltiples con mayor facilidad y, probablemente, confirmar de forma directa la existencia de tríos gravitacionales como el descrito en este estudio.

Por otro lado, las observaciones combinadas —las llamadas “multimensajero”— que integran ondas gravitacionales con emisiones electromagnéticas (como rayos X o estallidos gamma), permitirán estudiar estos eventos de forma más completa. Esto podría confirmar, por ejemplo, si el entorno del sistema era un disco de acreción activo alrededor de un agujero negro supermasivo, como se sospecha.

Este caso demuestra cómo una anomalía en los datos puede convertirse, años después, en una pista clave para avanzar en nuestra comprensión del cosmos. Un evento que parecía desconcertante ha terminado revelando una compleja coreografía de tres gigantes invisibles bailando en la oscuridad del universo.

Referencias

- Shu-Cheng Yang, Wen-Biao Han, Hiromichi Tagawa, Song Li, Chen Zhang. Indication for a Compact Object Next to a LIGO–Virgo Binary Black Hole Merger. The Astrophysical Journal Letters. DOI: 10.3847/2041-8213/adeaad.

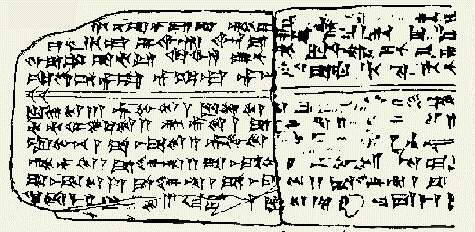

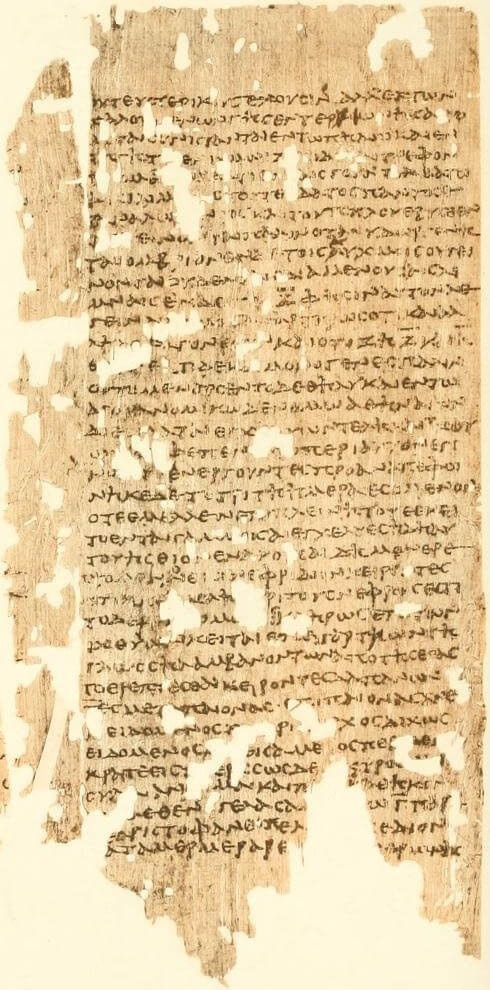

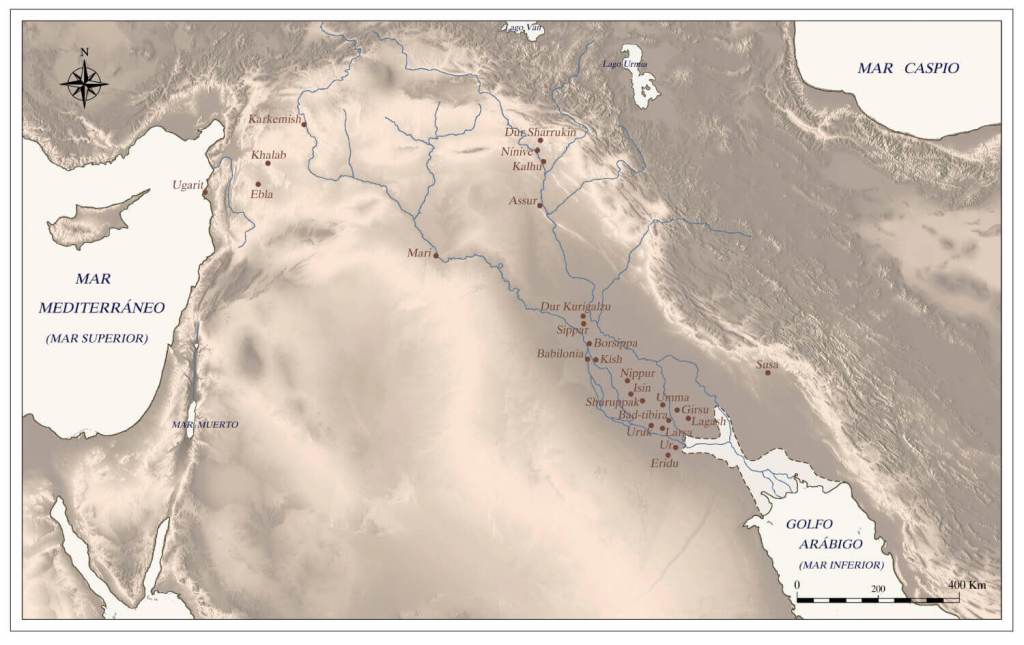

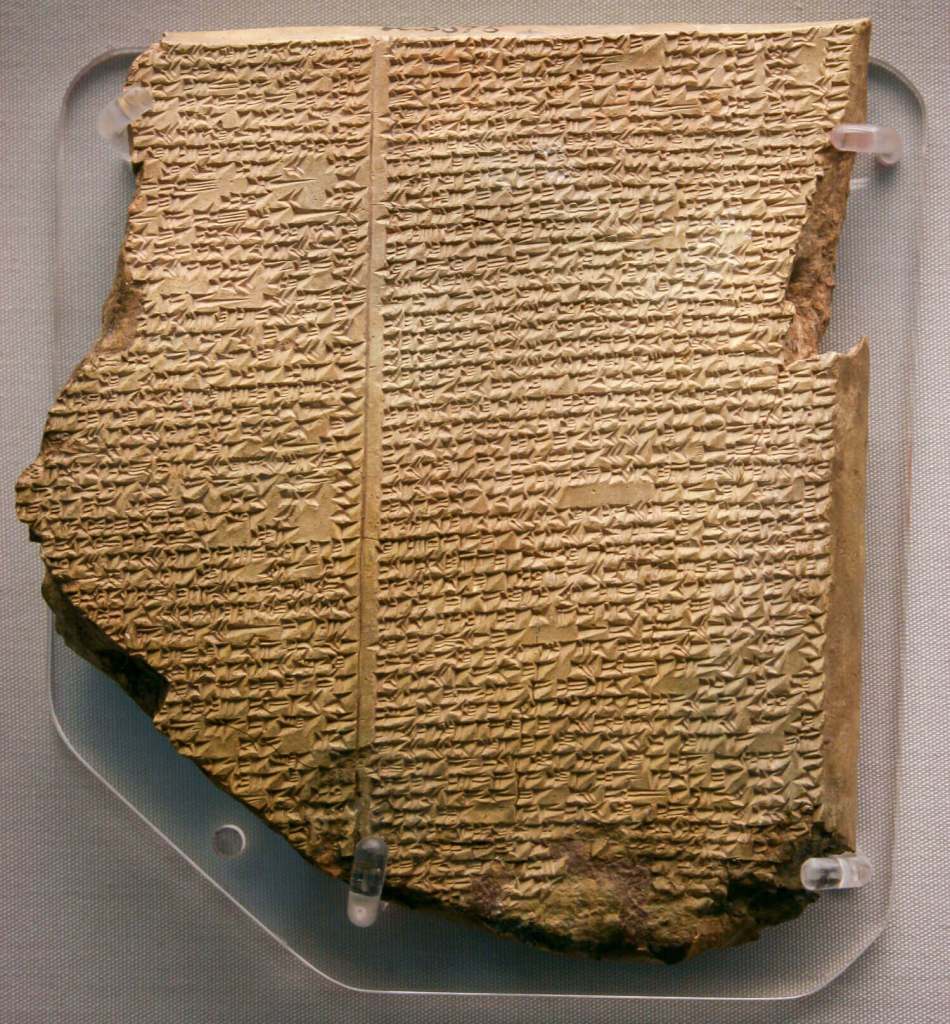

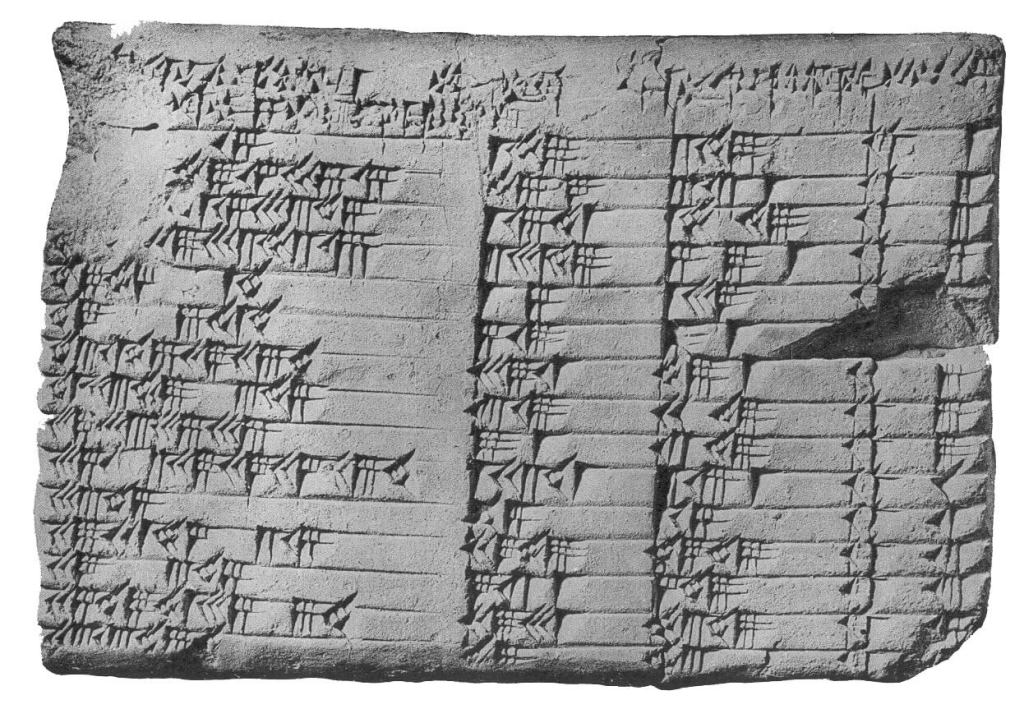

En un contexto tan burocratizado como el mesopotámico, en el que la escritura servía para registrar la producción de bienes, la tasación de actividades y las transacciones económicas y comerciales, los escribas detentaban un rol fundamental. Es a través de la labor escritural de los copistas, los estudiosos y los funcionarios letrados que tenemos acceso a las preocupaciones cotidianas que ocupaban los días de los antiguos mesopotámicos.

Reclutados de entre las familias de la elite, los aspirantes a escriba adquirían los rudimentos del cuneiforme en la edubba, la casa de las tablillas de barro, donde un maestro los instruía siguiendo un currículum preestablecido. En la edubba se aprendía a elaborar tablillas, a reconocer los signos cuneiformes y sus valores a través de silabarios y listas, se memorizaba vocabulario, se aprendía a redactar textos legales y administrativos, se estudiaban composiciones literarias y se adquirían nociones de matemática.

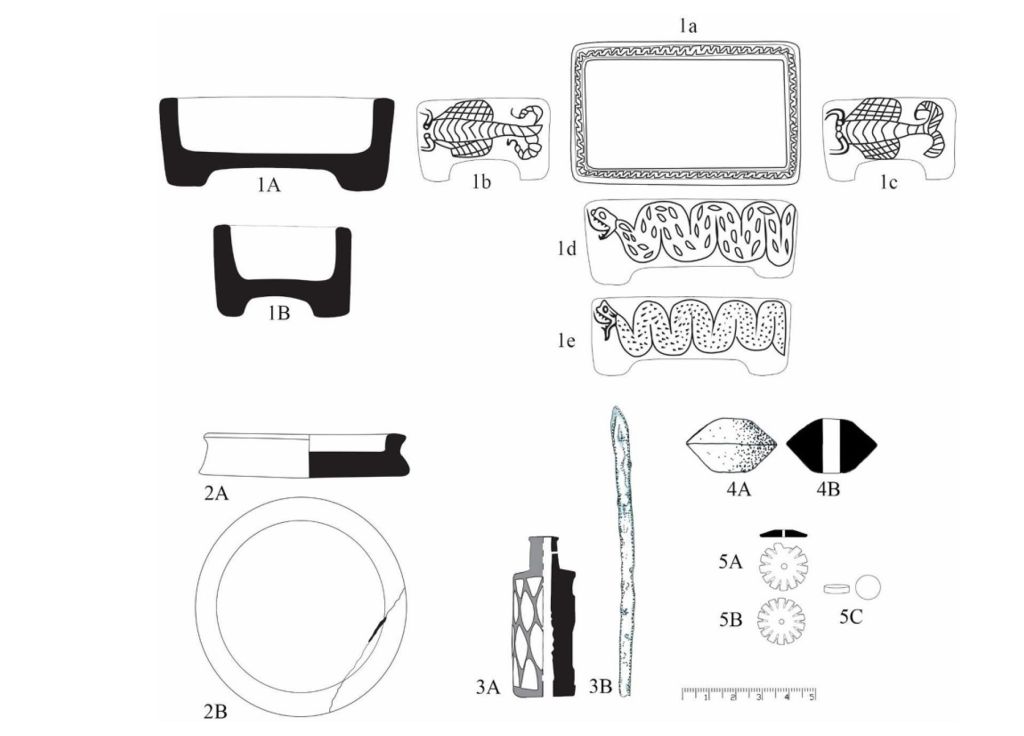

Tanto en la didáctica como en la práctica cotidiana de la escritura, se utilizaban materiales comunes y fácilmente disponibles en Mesopotamia: barro para las tablillas y caña para la elaboración del cálamo con el que se incidía la superficie todavía blanda de la arcilla. También podían utilizarse tableros cubiertos de cera. Otros materiales comunes que se utilizaban como soportes de la escritura eran el metal, el marfil y, para las inscripciones monumentales, la piedra, que los lapicidas incidían siguiendo las indicaciones de los escribas.

Los escribas se empleaban en las administraciones del palacio o del templo, se dedicaban a la gestión de actividades económicas, legales y burocráticas de todo tipo o proseguían su especialización en algunos de los campos de pericia dominados por adivinos, literatos o sacerdotes responsables del culto. Aunque la mayoría de los escribas que conocemos por su nombre eran hombres, también sabemos de la existencia de mujeres escribanas, responsables de la gestión de instituciones religiosas y empresas comerciales, cuando no secretarias al servicio de mujeres de la aristocracia.

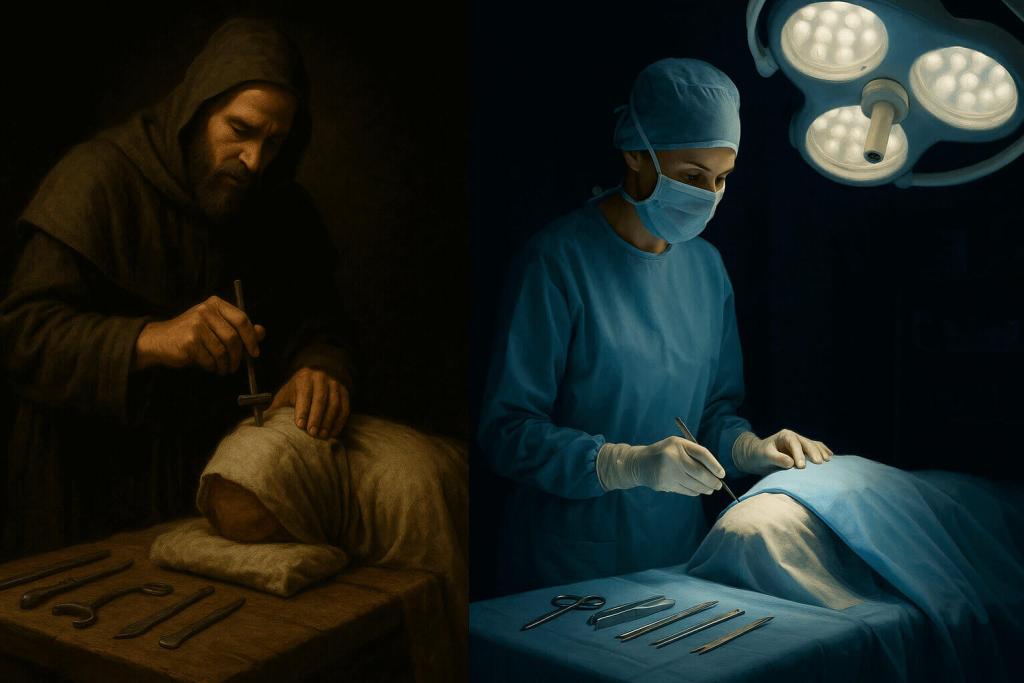

La medicina mesopotámica

Mesopotamia cuenta con una larga tradición escrita en los campos de la medicina, la profilaxis y la diagnosis de males. Las tablillas cuneiformes de contenido médico más antiguas datan del 2500 a. C. y recogen encantamientos y rituales terapéuticos destinados a tratar afecciones tan diversas como los males del vientre, los problemas oculares y las dificultades durante el parto. El interés de las elites cultas por recoger en forma escrita y sistematizar el vasto acerbo de remedios, procedimientos diagnósticos y prontuarios de materia médica se mantuvo inalterado hasta las últimas fases de vida del cuneiforme, en un dilatado periodo que se extendió a lo largo de tres milenios. Prueba de esa tradición recibida se encuentra en las colecciones de tablillas procedentes de Nimrud, Asur y Uruk, y en bibliotecas como la que Asurbanipal creó en Nínive.

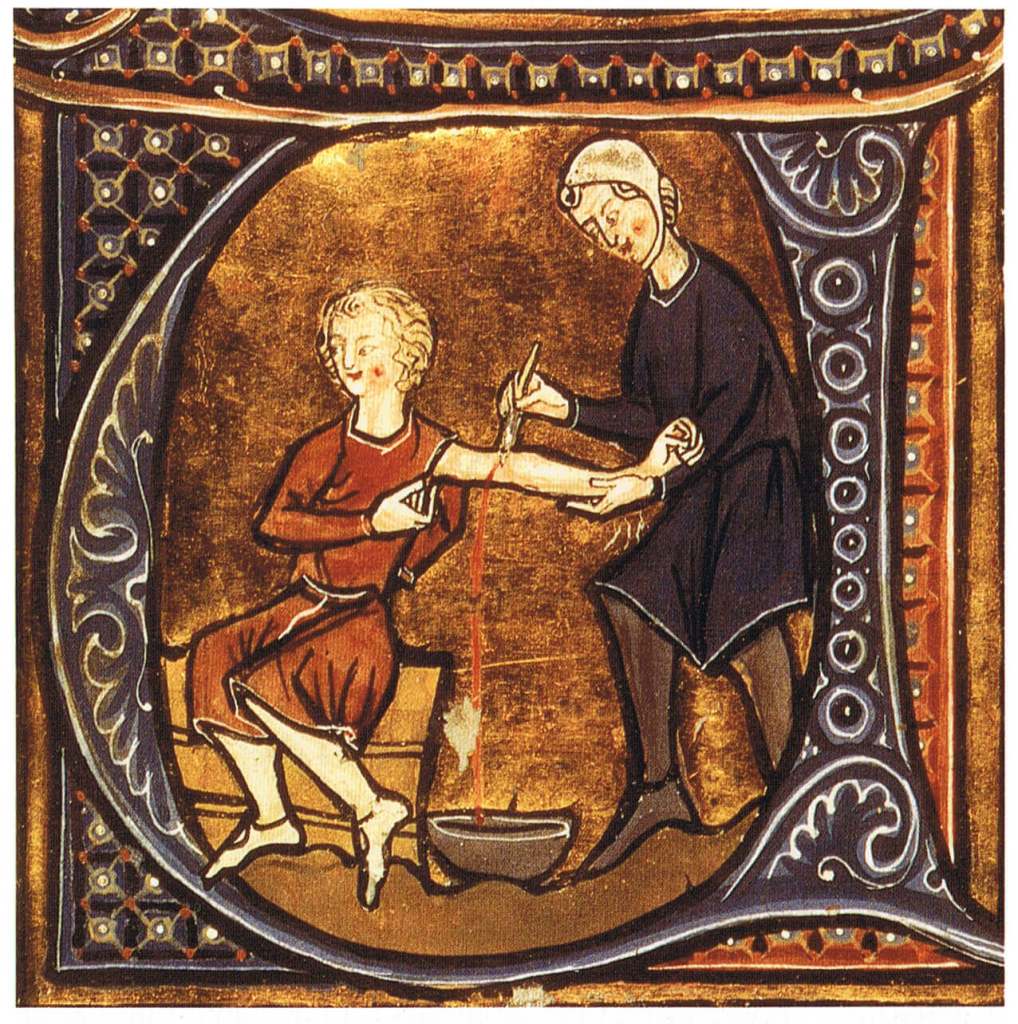

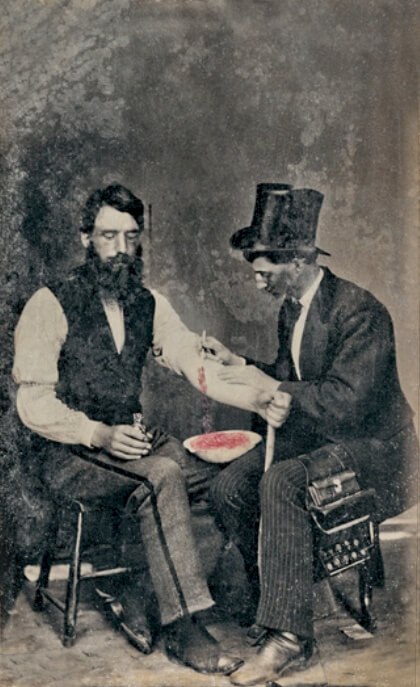

Las tablillas cuneiformes revelan la existencia de dos especialistas médicos que operaban en los contextos de poder: el āšipu y el asû. El āšipu se caracterizaba por ser un operador ritual especialista en la expulsión y remoción de los agentes malignos, como los demonios y los espectros, que causaban enfermedades e infortunios. Su relación con la esfera de los dioses, de los que el āšipu había recibido su conocimiento, le permitía actuar en aquellas circunstancias que anunciaban penurias y desgracias para el rey, el país y su población.

Contribuía con su sabiduría, pues, a mantener el orden de las cosas tanto humanas como divinas. Sabemos que también tenía conocimientos de fitoterapia y podía recurrir a remedios farmacológicos para el tratamiento de pacientes. El asû, por su parte, se ocupaba de tratar heridas, contusiones, huesos rotos y, en general, afecciones que se manifestaban principalmente en el exterior del cuerpo, para lo que aplicaba ungüentos, emplastos y vendajes. Disponía de conocimientos relativos a las plantas medicinales, que utilizaba en su práctica cotidiana. Otras figuras especialistas en el cuidado de enfermos, infantes y parturientas, como las comadronas, las enfermeras y las nodrizas, así como los veterinarios y los curanderos locales, aparecen menos documentadas en el registro escrito.

Las enfermedades

El elenco de enfermedades que los mesopotámicos intentaban tratar con sus remedios abarca desde picaduras y ataques de serpientes y escorpiones hasta dolencias oculares, pasando por las afecciones dérmicas, los problemas intestinales, el miedo y los trastornos de comportamiento, las consecuencias de los excesos alcohólicos, la impotencia sexual, la ayuda al parto o el dolor de dientes. Los peligros que acechaban a los vivos a lo largo de sus vidas, desde la más tierna infancia hasta la edad vetusta, se condensan en estas tablillas que revelan una lucha constante por recuperar la salud, congraciarse con la divinidad y reescribir el propio destino.

Los tipos de remedios a los que se recurría incluían medicamentos como pomadas, ungüentos, pociones y sahumerios, y en su elaboración se utilizaban ingredientes cotidianos como la harina, la cerveza o los dátiles, así como plantas medicinales, resinas y minerales. Las referencias en los textos a intervenciones quirúrgicas superficiales, suturas, entablillamientos y otros tratamientos similares son raros, cuando no inexistentes. Aunque sin duda se practicaron, apenas han dejado huella en el registro escrito.

Conocemos los pormenores de un buen número de rituales de diversa complejidad en los que se buscaba expulsar, revertir o eliminar la causa que había propiciado la enfermedad del paciente. Así, se recurría a la recitación de encantamientos, la invocación de divinidades como Ištar, Gula y Šamaš, la manipulación de objetos como mechones de lana colorida, frutos y enseres domésticos, y el empleo de figurillas que representaban al paciente y al agente causante del mal.

También se utilizaban amuletos de diverso tipo: conchas marinas y piedras como la cornalina, el lapislázuli y la diorita se enhebraban y se aplicaban alrededor de la garganta, los brazos o las piernas; minerales y plantas se combinaban dentro de bolsitas de cuero que luego se portaban colgadas del cuello, y lo mismo se hacía con las cabezas de piedra o arcilla que representaban a Pazuzu o con las pequeñas placas inscritas con fórmulas para prevenir los ataques de la mortífera Lamaštu y que, a menudo, también se acompañaban con representaciones de esta peligrosa divinidad.

No era infrecuente que se realizasen ofrendas votivas a los dioses para que estos proporcionasen protección, salud y larga vida a los miembros de las familias pudientes. Los objetos ofrendados incluían estatuas, copas o figurillas de perros, el animal sacro de la divinidad médica Gula.

Los agentes causantes

En cuanto a los agentes que se reconocían como causantes de enfermedad, las artes médicas mesopotámicas hacían hincapié en las acciones nocivas de figuras suprahumanas. De demonios como los utukkū lemnūtu, el rābiŞu merodeador y la Lamaštu, codiciosa de bebés y gestantes, se decía que golpeaban, apresaban e incluso se vestían con el cuerpo del enfermo. Los fantasmas furiosos de aquellos que no recibían el obligado culto fúnebre o de los que habían sufrido una muerte violenta o acerba atosigaban a los vivos con apariciones espectrales, tinitos y dolores de cabeza. Los dioses podían enviar variados males a la humanidad y, cuando decidían despojar a los fieles de su divina protección, los abocaban a sufrir pérdidas económicas, familiares y de salud. La brujería era igualmente causa de disturbios que se caracterizaban con frecuencia por afectar el vientre, los intestinos y la potencia sexual.

De hechiceros y brujas se decía que ungían con sustancias ponzoñosas a la víctima, a la que también daban de beber y comer inmundicias. También se atribuía el origen de ciertos males y disfunciones a factores climáticos, atmosféricos y circunstanciales (insolación, intoxicación, vejez, etc.) y se manejaban conceptos de transmisión de enfermedades por contacto y contagio. Esto escribía Zimri-Lim, rey de Mari, a su esposa Šībtu hace más de tres milenios y medio: «He oído que Nanname está enferma de simmu [una enfermedad de la piel] y, aun así, sigue frecuentando mucho el palacio. Acabará contagiando a muchas mujeres con lo suyo. Ahora, da órdenes severas para que nadie beba de su copa ni se siente en la silla que ella usa ni se tumbe en su cama para evitar que contagie a muchas mujeres con lo suyo. La enfermedad simmu es muy contagiosa».

La astrología y otras mancias

Desde la perspectiva mesopotámica, las divinidades utilizaban el mundo y todo lo que él contenía para comunicarse con los humanos. Así, las potencias divinas utilizaban los cielos, el comportamiento animal o el mismo cuerpo humano para escribir sus mensajes y advertencias. Esto explica la existencia de las técnicas adivinatorias: son mecanismos que permiten desentrañar los mensajes ocultos de los dioses y, en caso de que fuese necesario, aplicar las medidas apotropaicas indispensables para que el mal anunciado no golpee. Por ello, los astrólogos y los expertos en distintas artes adivinatorias se dedicaban a escrutar la vastedad del cielo y de la tierra en busca de estos signos divinos.

La observación celeste en Mesopotamia tenía una doble finalidad. Por un lado, servía para marcar el tiempo, determinar los meses lunares y las estaciones, algo necesario en la organización del calendario agrícola. Por otro, el escrutinio del firmamento facultaba el reconocimiento de los signos fastos y nefastos que anunciaban peligros políticos, sociales y militares. Es de esa observación que nacieron las colecciones de profecías solares y lunares, el registro de eclipses y las conjeturas sobre el significado que determinadas conjunciones, fenómenos atmosféricos y presencias celestes albergaban para el individuo y la comunidad.

La extispicia constituía otra mancia muy recurrida en la Mesopotamia antigua. Se basaba en la observación del hígado (y, a veces, también de los pulmones y las entrañas) de una oveja sacrificada. Se utilizaba esta disciplina para determinar si empresas como la construcción de un templo, una campaña militar o la evolución de la enfermedad que atenazaba a un miembro de la familia real serían propicias. El bārûtu era el especialista encargado de interpretar los signos presentes en cada una de las secciones del órgano con base en un complejo conocimiento técnico recogido en colecciones de presagios y modelos de hígados de arcilla.

El cuerpo humano encerraba mensajes reveladores. La adivinación fisionómica exploraba rasgos de la persona como el color de los cabellos, la forma de los pechos o los modos de comportamiento para determinar sus cualidades morales, su valía como esposo o esposa y la prosperidad o la desdicha que le aguardaba en la vida.

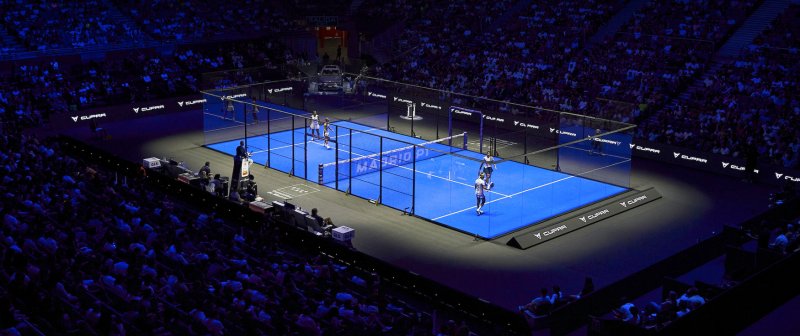

Música, danza y espectáculo

La música formaba parte del paisaje sonoro de las ciudades. Se interpretaban canciones en ambientes cotidianos, durante la realización de tareas agrícolas o en las plazas, pero las actuaciones musicales también ocupaban un lugar relevante en contextos militares (durante los desfiles que festejaban victorias, por ejemplo) y como parte de las funciones religiosas, en rituales de construcción de edificios y templos, en tratamientos terapéuticos, durante los funerales y en muchas otras circunstancias tanto públicas como privadas.

Los escribas que entraban al servicio de la institución templaria recibían formación musical que les permitía interpretar cantos religiosos durante festividades y ceremonias. Altos cargos como los que detentaba el kalû, el responsable de la ejecución de determinadas liturgias que requerían la ejecución de cantos y piezas musicales, aprendían así las claves de la versificación, la interpretación con instrumentos y la notación musical.

Hombres y mujeres podían ejercer la profesión de músico. Estudiaban canto e interpretación con instrumento con un maestro y los instrumentos musicales podían ser de cuerda, viento o percusión. Tenemos constancia de la existencia de aerófonos en caña, madera o metales preciosos como la plata; de tamboriles, tímpanos, grandes tambores y panderos, así como de sistros y címbalos; y de laúdes, salterios, liras y arpas, que el músico podía tañer de pie o sentado. Se han conservado, además, algunas tablillas con notación musical para cordófonos.

La música acompañaba también espectáculos de lucha y danza que, en ocasiones, se integraban en ceremonias de corte religioso. Los saltos ocupaban un lugar predominante en las coreografías y eran habituales los bailes con espadas. Los músicos ambulantes se exhibían solos o en compañía de cómicos, bufones, acróbatas y animales, en especial monos.

El refinamiento culinario

Comer pan y beber cerveza constituyen los dos pilares de la alimentación y la base cultural de la civilización mesopotámica. Los alimentos básicos de la dieta en Mesopotamia incluían los cereales y muy especialmente la cebada, las legumbres, los vegetales y las frutas como granadas, uvas, ciruelas, dátiles e higos cultivados en los huertos, y las especias y plantas aromáticas, que se utilizaban comúnmente en la preparación de platos y bebidas.

Además de la leche y sus derivados, otras fuentes de proteína procedían de los peces, las tortugas y los crustáceos que se capturaban en los ríos y canales, de las aves apresadas en los pantanos y zonas fluviales, así como de la carne de animales domésticos (ovejas, cabras, cerdos, bueyes) y de las viandas de caza que se servían en la mesa del rey. Todos estos ingredientes se utilizaban en la preparación de panes, dulces como el mersu (a base de dátiles y pistachos), sopas, potajes y asados de variado tipo.

El descubrimiento de varias tablillas del siglo xvii a. C., en las que se recogían unas cuarenta recetas para preparar caldos y carnes cocidas, han proporcionado un testimonio inapreciable sobre el refinamiento culinario de las clases pudientes mesopotámicas. A base de carne de ciervo, gacela, cabrito, cordero, francolín y otros animales, estas recetas demuestran un marcado gusto por el uso de plantas aliáceas como el puerro, el ajo y la cebolla, así como la tendencia a usar la grasa, los menudillos y, a veces, la sangre del animal en la elaboración.

Algunas recetas incluso proporcionan información minuciosa de las distintas fases en la preparación del guiso, desde la limpieza y descarne del animal hasta la fase final de la cocción, así como del modo de presentar y servir el plato en la mesa. Estos testimonios dan cuenta, por tanto, de la suntuosidad de la que gozaba la mesa del rey, pero también de la abundancia y variedad de platos que se sucedían durante la celebración de las festividades político-religiosas.

Durante años, la cafeína se ha estudiado casi siempre en laboratorios. Allí se comprobó que mejora el rendimiento mental, la atención y la sensación de energía. Sin embargo, faltaba una pieza clave: entender cómo actúa en la vida real, en el día a día, cuando la gente bebe café en la oficina, té en casa o refrescos en la calle. ¿Realmente cambia nuestro ánimo o todo se reduce a una ilusión de estar más despiertos?

Para responder, investigadores de Alemania y Estonia realizaron dos estudios con jóvenes adultos en su vida cotidiana. En lugar de pruebas de laboratorio, usaron un método llamado experience sampling (muestreo de experiencias). Este consiste en pedir a los participantes que contesten encuestas cortas varias veces al día, durante varias semanas, sobre cómo se sienten y si habían tomado cafeína recientemente.

La idea era sencilla pero potente: observar qué ocurre con las emociones en los 90 minutos posteriores a consumir cafeína. Así se podía evaluar si la bebida realmente influía en el estado afectivo y en qué momentos del día ese efecto era más fuerte. Lo innovador del trabajo es que, en lugar de situaciones artificiales, recogió datos en entornos naturales: en el trabajo, en la universidad, con amigos o en casa.

Miles de encuestas para seguir el pulso al café

El primer estudio se realizó con 115 participantes, de entre 18 y 25 años, durante dos semanas. Cada día, recibían siete avisos en el móvil para rellenar un cuestionario: si habían consumido cafeína, cómo de cansados se sentían y cuál era su estado emocional en ese momento. En total, se recogieron más de 8.300 encuestas.

El segundo estudio fue aún más ambicioso. Participaron 121 jóvenes, de 18 a 29 años, a lo largo de 28 días. Con el mismo sistema de recordatorios, se acumularon casi 20.000 encuestas. Con este volumen de datos, los investigadores pudieron analizar de manera muy precisa la relación entre el consumo de cafeína y los cambios en el estado de ánimo.

Los resultados fueron claros: tras tomar cafeína, las personas declararon sentirse más positivas. No se trataba solo de estar menos cansados, sino de experimentar emociones concretas como entusiasmo, felicidad y satisfacción.

Aunque el efecto no era enorme, sí era consistente, y se repetía en distintos días y contextos. En definitiva, la evidencia mostraba que la cafeína estaba vinculada a una mejora real del estado de ánimo en la vida cotidiana.

El mejor momento: las primeras horas del día

Uno de los hallazgos más interesantes fue que el efecto positivo de la cafeína era más fuerte en las primeras dos horas y media después de despertar. Ese café de la mañana no solo ayuda a abrir los ojos: también parece potenciar las emociones agradables de manera especial en ese intervalo.

Después de ese pico inicial, la asociación entre cafeína y emociones positivas disminuía a lo largo del día. Aunque podía volver a aparecer de forma leve por la tarde o la noche, ya no tenía la misma intensidad que en la mañana. Los investigadores interpretan que esto podría deberse a varios factores, entre ellos la reversión de síntomas de abstinencia tras la noche sin cafeína.

En otras palabras: para quienes beben café todos los días, la primera taza actúa como un “reinicio” que no solo combate la somnolencia, sino que también restaura un ánimo más positivo. No se trata únicamente de química, sino también del ritual matutino y de la expectativa de que el café ayudará a empezar el día con mejor pie.

"La cafeína funciona bloqueando los receptores de adenosina, lo que puede aumentar la actividad de la dopamina en regiones clave del cerebro, un efecto que los estudios han relacionado con un mejor estado de ánimo y una mayor alerta", dijo Anu Realo, autor del estudio y profesor de la Universidad de Warwick.

¿Reduce la tristeza o solo aumenta la alegría?

El estudio no solo analizó emociones positivas, sino también negativas, como sentirse triste, molesto o preocupado. Aquí los resultados fueron más matizados. En el segundo estudio, con más participantes y encuestas, se observó que la cafeína se asociaba a una ligera disminución de la tristeza y el enfado. Sin embargo, esa relación no apareció en el primer estudio.

Esto sugiere que los efectos de la cafeína sobre el afecto negativo son menos consistentes y probablemente más débiles. Mientras que el impulso positivo es claro y repetido, la reducción de emociones desagradables no parece ser tan directa ni tan fuerte. Dicho de otro modo: la cafeína te ayuda a sentirte más animado, pero no necesariamente a librarte de las preocupaciones.

Los autores destacan que esto podría deberse a que las emociones negativas suelen estar más ligadas a factores duraderos —como el estrés, los problemas personales o las circunstancias externas—, que no se resuelven con un café. En cambio, las emociones positivas pueden ser más sensibles a pequeños estímulos cotidianos, como el acto de consumir cafeína.

Cansancio, compañía y contexto: factores que cambian el efecto

La investigación también exploró qué otros factores podían moderar la relación entre cafeína y estado de ánimo. Un hallazgo notable fue que el efecto positivo era mayor cuando los participantes estaban más cansados de lo habitual. En esos momentos, la cafeína parecía aportar un extra de energía emocional, no solo física.

Otro aspecto llamativo fue la influencia del contexto social. Cuando los participantes estaban acompañados, la relación entre cafeína y afecto positivo era más débil. Esto podría deberse a que las interacciones sociales ya influyen en el estado de ánimo, reduciendo la percepción del “subidón” de la cafeína. Por el contrario, cuando las personas estaban solas, el efecto del café sobre el ánimo era más evidente.

Además, los investigadores analizaron si el consumo habitual, la dependencia de la cafeína, la calidad del sueño o síntomas de ansiedad y depresión modificaban la relación. Sorprendentemente, no encontraron diferencias importantes: el efecto positivo aparecía de forma bastante uniforme en todos los grupos. Esto refuerza la idea de que la cafeína actúa como un modulador general del ánimo en situaciones cotidianas.

"Nos sorprendió un poco no encontrar diferencias entre personas con diferentes niveles de consumo de cafeína o diferentes grados de síntomas depresivos, ansiedad o problemas de sueño. Los vínculos entre la ingesta de cafeína y las emociones positivas o negativas fueron bastante consistentes en todos los grupos", dijo el autor del estudio Justin Hachenberger, de la Universidad de Bielefeld en Alemania.

Lo que nos dice el estudio sobre el café y la vida diaria

El trabajo aporta varias conclusiones útiles. La principal es que la cafeína está asociada con un aumento del afecto positivo en la vida real, especialmente en la mañana.

Este hallazgo va más allá de lo que ya se sabía en laboratorio, porque confirma que la bebida más popular del mundo influye en cómo nos sentimos en nuestros entornos naturales.

Al mismo tiempo, los investigadores subrayan que los efectos no son milagrosos. La cafeína no elimina de golpe el cansancio acumulado ni las emociones negativas fuertes. Tampoco sustituye un buen descanso, ni resuelve problemas de ansiedad o depresión. Más bien, su papel parece ser el de un pequeño “empujón emocional” que, en momentos adecuados, ayuda a sentir más entusiasmo y alegría.

En definitiva, este estudio pone en cifras lo que muchos ya intuían en su rutina: que esa primera taza de café por la mañana no solo despeja, sino que también mejora el humor. Y lo hace de forma tan consistente que se convierte en uno de los rituales cotidianos más influyentes en nuestro bienestar emocional.

Referencias

- Hachenberger, J., Li, YM., Realo, A. et al. The association of caffeine consumption with positive affect but not with negative affect changes across the day. Sci Rep. (2025). doi: 10.1038/s41598-025-14317-0

La muerte para los etruscos, al igual que para muchas otras poblaciones de la antigüedad, era un tránsito que requería de una serie de rituales preparatorios que facilitasen el tránsito del difunto. Aunque no poseemos textos escritos por los propios etruscos que detallen sus creencias sobre el más allá, la abundancia de tumbas decoradas, ajuares funerarios y restos arqueológicos permite reconstruir, al menos en parte, su particular imaginario fúnebre. El estudio de la iconografía funeraria de las necrópolis, por tanto, ofrece un panorama fascinante y enigmático sobre el destino del alma.

La dificultad de conocer el más allá etrusco

La ausencia de fuentes escritas directas ha obligado a los etruscólogos a interpretar la religión funeraria etrusca a través de sus monumentos. A menudo, los investigadores han proyectado sobre estas imágenes ideas tomadas de la mitología griega, como la travesía en barca hacia las Islas de los Bienaventurados o la estancia en el Hades. Sin embargo, la evidencia iconográfica muestra que estas nociones no siempre se aplican de manera sistemática en el caso etrusco.

En la época arcaica (siglos VII-V a. C.), los etruscos parecen haber concebido un destino post mortem donde la parte inmaterial del difunto —su “sombra” o espíritu— continuaba existiendo, en un lugar distinto al de la sepultura física. No obstante, las representaciones de ese más allá no siempre proporcionan la imagen de un inframundo poblado de dioses o criaturas demoníacas, sino, más bien, se expresan a través de símbolos y escenas rituales.

La visión que emerge, por tanto, es compleja. Por un lado, comparte elementos con las concepciones griegas arcaicas, como la idea de un viaje post mortem. Por otro, revela interpretaciones propias que no se reducen ni a los Campos Elíseos ni al sombrío Hades. El análisis de las puertas falsas pintadas en las tumbas, de los rituales representados y de los objetos simbólicos sugiere que los etruscos creían en un más allá, pero que este no siempre implicaba un trayecto peligroso hacia tierras lejanas.

Las puertas falsas: umbrales simbólicos

Uno de los motivos más reveladores en las tumbas pintadas de Tarquinia es la representación de la puerta falsa. Estas puertas, que comenzaron a incluirse en la arquitectura funeraria en la primera mitad del siglo VI a. C., no podían abrirse, ya que carecían de bisagras, cerraduras o llamadores. Situadas casi siempre en la pared opuesta a la entrada, parecían invitar al paso hacia un espacio invisible.

La hipótesis más aceptada apunta que estas puertas no eran para los vivos, sino para el alma del difunto. Constituían un umbral hacia un espacio simbólico, el lugar al que se dirigía el espíritu tras abandonar el cuerpo. La decoración que acompañaba a las puertas podía variar. Así, en la Tumba de los Augures, en la necrópolis de Monterozzi, por ejemplo, dos hombres en actitud de duelo flanquean el vano, mientras que, en la Tumba de las Olimpíadas, figuras mitológicas como Hermes, Hera, Atenea y Afrodita parecen desligarse de las connotaciones funerarias.

En algunos casos, la puerta era el especio elegido para llevar a cabo rituales específicos, como el threnos o canto fúnebre, o la deposición de objetos (por lo general, un ánfora y una crátera para el vino) junto al umbral. Estos recipientes enmarcaban el paso al otro lado del alma a través de ceremonias de libación o banquetes que acompañaban el tránsito espiritual.

El papel de los rituales y el banquete funerario

Algunas pinturas funerarias de Tarquinia muestran que, para los etruscos, la despedida del alma se acompañaba de música, danzas y consumo de vino. Las escenas de komos (procesiones festivas con bebedores y músicos) pueden rodear las puertas falsas o las entradas a las cámaras mortuorias. En algunos casos, los participantes están identificados por nombre, lo que sugiere que, durante las celebraciones, se conmemoraba personajes reales y no simples figuras simbólicas.

La combinación de luto y celebración festiva formaba parte de un mismo rito de paso. Los banquetes podían evocar la idea de una vida que continúa en el más allá, pero, al mismo tiempo, cumplían una función de cohesión social y de homenaje a la memoria del difunto.

Dioniso y otros dioses en el imaginario funerario

Las escenas dionisíacas son frecuentes en la iconografía funeraria etrusca. Sátiros, hiedra, grandes cráteras y gestos de embriaguez decoran frontones y paredes, y sugieren la influencia del dios del vino y la fertilidad en la concepción etrusca de la muerte. Sin embargo, no todos los elementos de estas tumbas remite a Dioniso. En los bosquecillos sagrados que aparecen pintados, cuelgan joyas, telas y guirnaldas que evocan a Turan (Afrodita) o Aplu (Apolo). Este lucus o arboleda sagrada funcionaba como espacio liminal, lugar de ofrenda y comunión con lo divino. El hecho de que los bosques aparezcan combinados con banquetes o procesiones subraya la interconexión entre lo sagrado y lo social en el contexto funerario.

El cambio en el siglo V a. C. y la desaparición de las puertas falsas

A partir del segundo cuarto del siglo V a. C., las puertas falsas comienzan a desaparecer del programa decorativo de las tumbas. En su lugar, algunos sepulcros muestran el marco dórico pintado en la puerta real de acceso a la cámara, quizá como una alusión simbólica al umbral del más allá. Con todo, este cambio no implica, necesariamente, una sustitución directa de las creencias. De hecho, las escenas pintadas siguen mostrando banquetes, músicos y ritos, pero la disposición espacial y la iconografía se adaptan a nuevas tendencias artísticas.

La aparición, hacia finales del siglo V a. C., de demonios de la muerte en la pintura etrusca sugiere una transformación en la concepción del destino post mortem. Estas figuras, ausentes en la etapa arcaica, introducen una imaginería más cercana al control divino o sobrenatural del tránsito del alma.

¿Un viaje largo y peligroso?

Contrariamente a otras tradiciones religiosas que presentan el tránsito del alma como un viaje marítimo, la iconografía etrusca arcaica no confirma ese trayecto épico. Las tumbas no muestran al difunto cruzando mares ni enfrentándose a pruebas, sino escenas que subrayan el umbral simbólico (la puerta falsa) y los ritos que acompañaban el paso del alma a un lugar invisible.

El silencio que guarda la pintura etrusca sobre el paisaje del más allá parece reforzar la idea de que lo importante era el acto de la separación, el momento en que la parte espiritual dejaba el espacio físico del cadáver para dirigirse a un destino que, desde el punto de vista etrusco, bien podía tratarse de un auténtico lugar físico. La religión etrusca, por tanto, concebía la muerte como un tránsito ritualizado hacia un espacio invisible, marcado por umbrales simbólicos y acompañado de ceremonias complejas. Las puertas falsas, los banquetes, la música y las procesiones no describen tanto los espacios del más allá como la importancia del rito de paso que aseguraba el viaje del alma.

Referencias

- Weber-Lehmann, "Where Does the Soul Go? Some Thoughts on Etruscan Afterlife", en Karolina Sekita, y Katherine E. Southwood(eds.), Death Imagined: Ancient Perceptions of Death and Dying, pp. 201-236. Liverpool University Press, 2025.

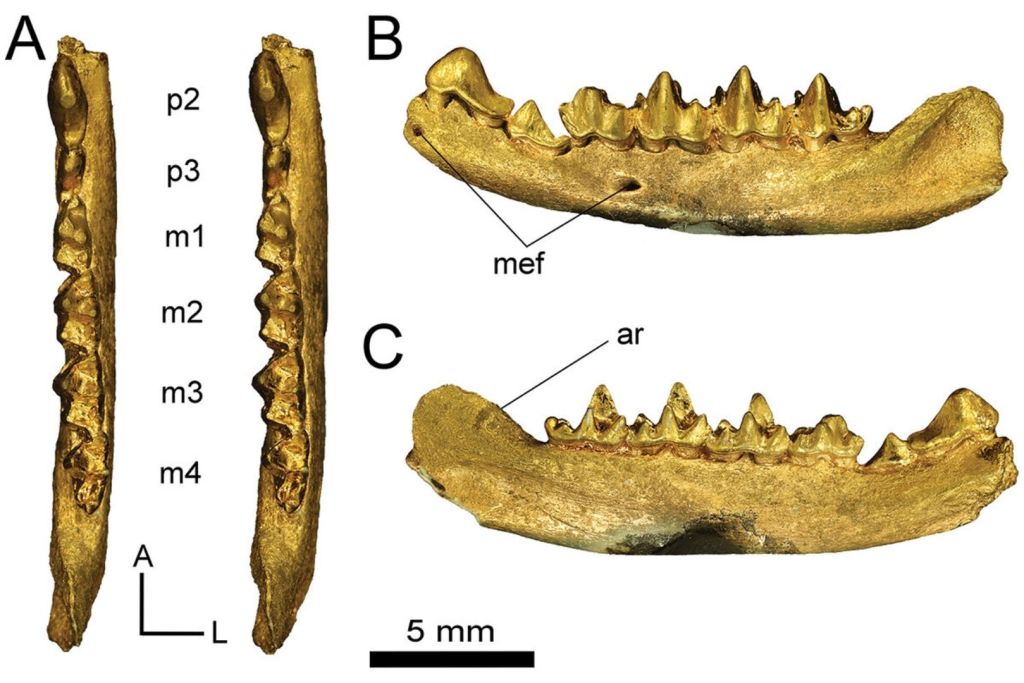

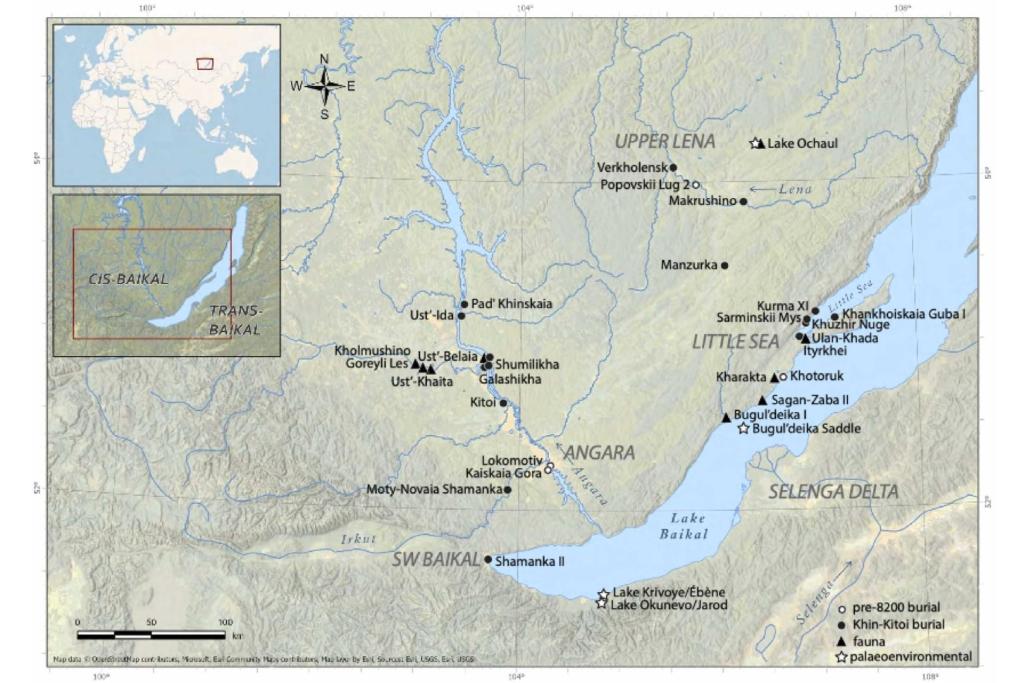

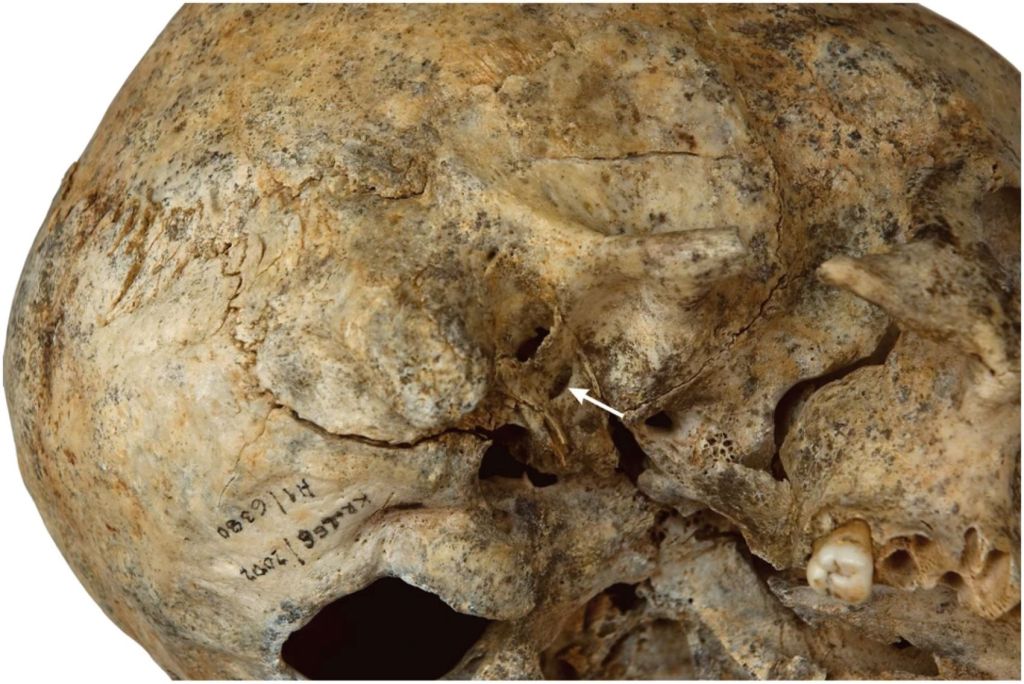

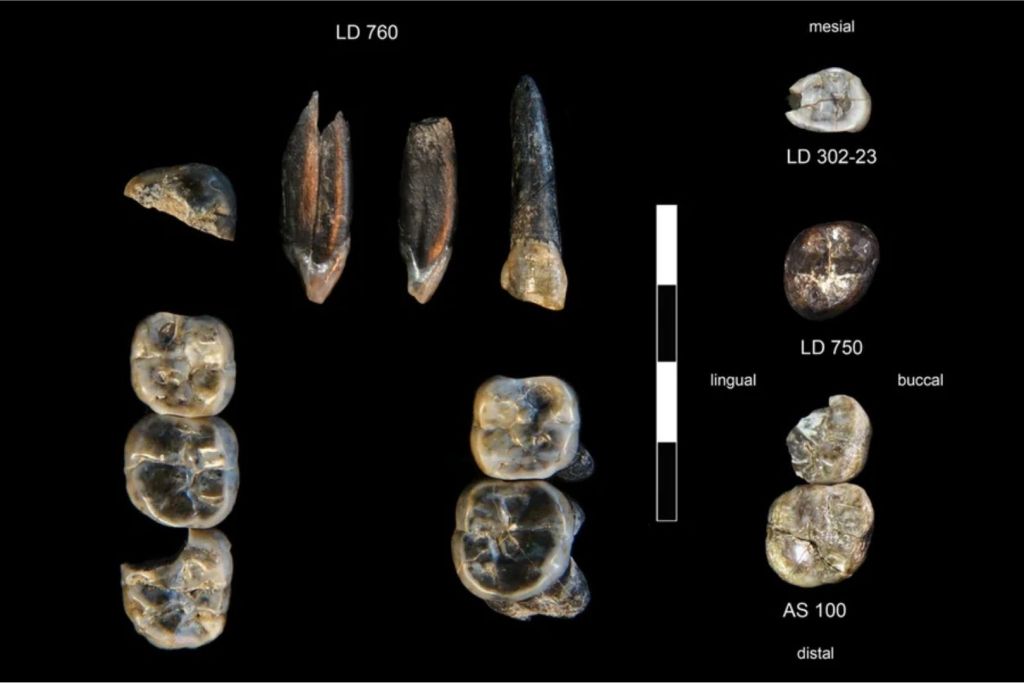

Durante más de seis décadas, una pregunta ha flotado sin respuesta en la paleoantropología europea: ¿quién fue el homínido que habitó la cueva de Petralona, en Grecia, y por qué su cráneo no encaja del todo ni con los neandertales ni con los humanos modernos? Descubierto en 1960 por un habitante local mientras exploraba una cueva kárstica al sur de Tesalónica, el fósil ha sido motivo de controversia científica, hipótesis enfrentadas y dataciones contradictorias que oscilaban entre los 170.000 y los 700.000 años. Hasta ahora.

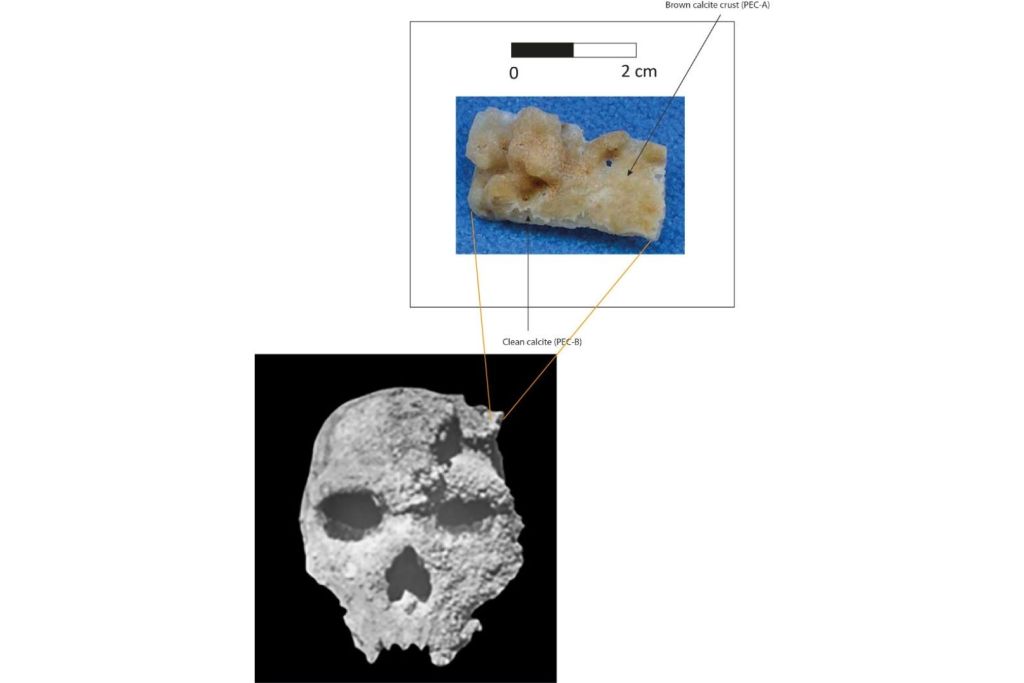

Un equipo internacional de investigadores liderado por el Institut de Paléontologie Humaine de París ha logrado aplicar con éxito una técnica de datación basada en series de uranio a los depósitos calcíticos que cubren directamente el cráneo. El resultado, publicado recientemente en el Journal of Human Evolution, no solo reduce radicalmente el rango de edad estimado, sino que apunta a una cronología que cambia, una vez más, nuestra comprensión sobre la evolución humana en Europa.

Una cueva, un cráneo y un misterio persistente

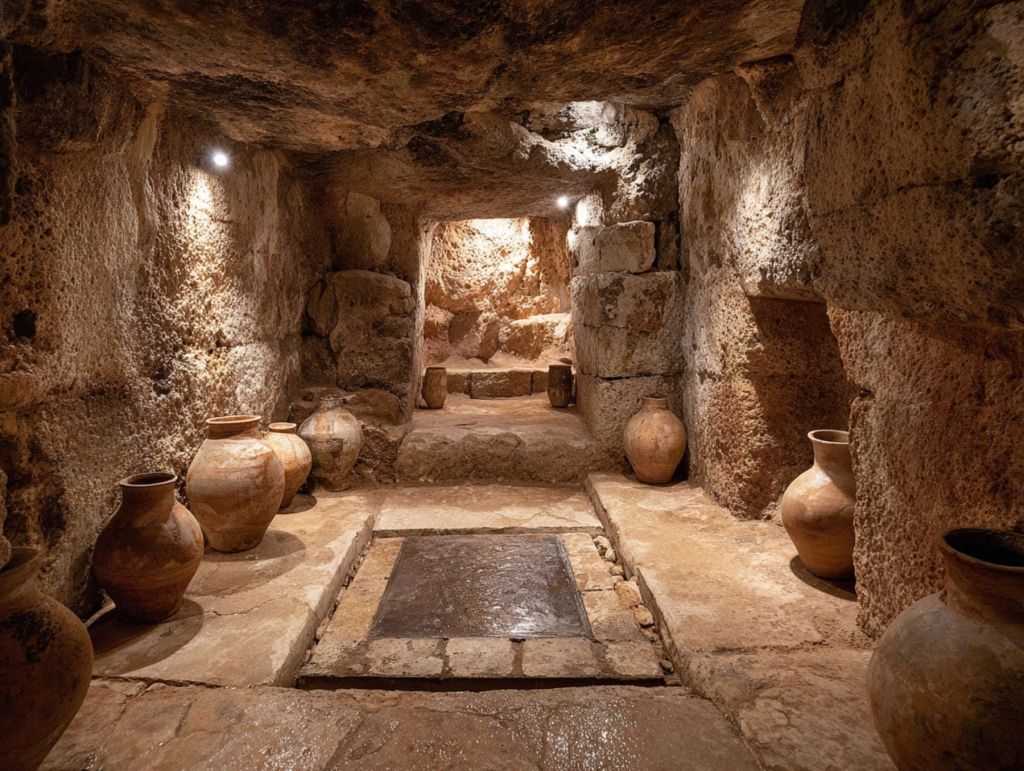

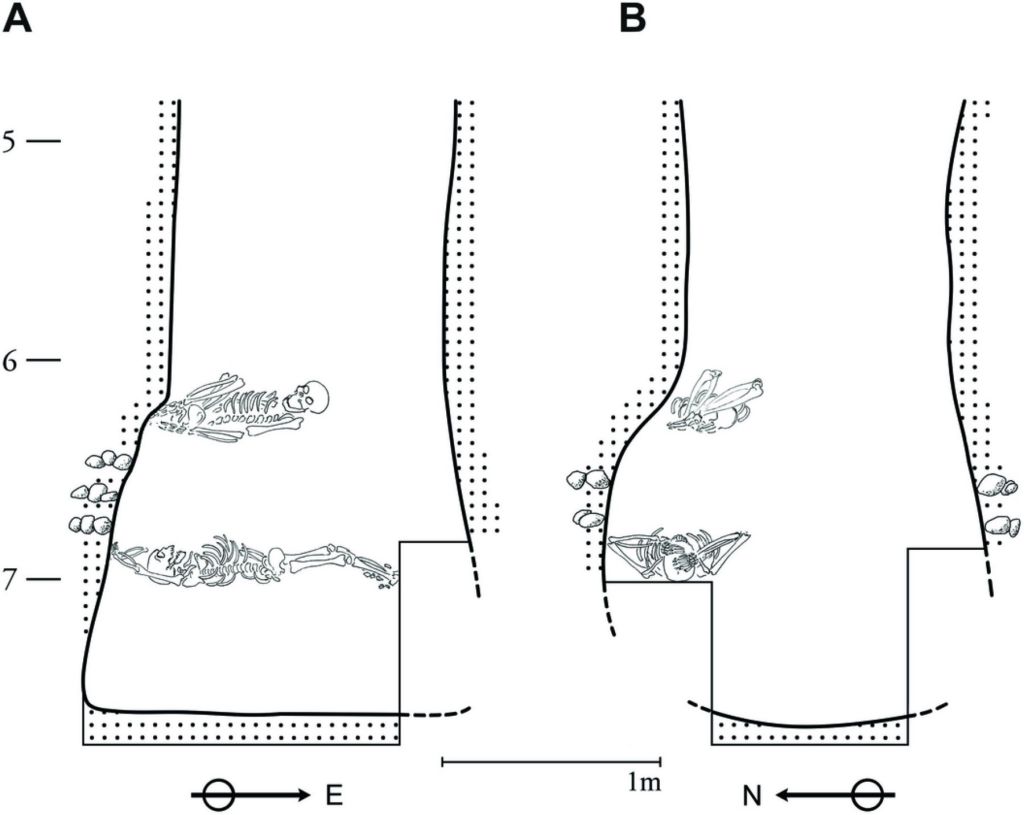

La cueva de Petralona, situada en la región de Calcídica, no parecía muy distinta de otras formaciones kársticas del Mediterráneo. Pero en su interior, en una pequeña cámara conocida como el “Mausoleo”, apareció incrustado en una pared un cráneo humano casi completo, aunque sin mandíbula. Lo que siguió fue una larga historia de investigaciones, debates y desacuerdos. El problema no era solo su extraña morfología, distinta tanto de Homo sapiens como de los neandertales clásicos, sino también la imposibilidad de determinar con precisión su edad.

El fósil no estaba asociado a un estrato arqueológico claro. Tampoco se encontraron herramientas ni restos del esqueleto que permitieran contextualizarlo cultural o temporalmente. Y para complicar aún más las cosas, el cráneo estaba cubierto por una gruesa capa de calcita, resultado de procesos de sedimentación propios del ambiente subterráneo. Aquello que parecía un obstáculo, sin embargo, se ha convertido en la clave para resolver el enigma.

Cómo el uranio resolvió el dilema

La técnica que ha permitido este avance se conoce como datación por series de uranio (U-series). A grandes rasgos, consiste en medir la proporción entre isótopos de uranio y torio presentes en depósitos minerales como estalactitas o costras calcíticas. En un entorno cerrado como una cueva, donde el agua filtra lentamente minerales disueltos que luego se cristalizan en forma de calcita, es posible calcular el momento en que comenzó ese proceso. Y si esa calcita recubre un fósil, como ocurre con el cráneo de Petralona, se puede establecer con exactitud una edad mínima para el mismo.

El equipo de investigadores analizó no solo la calcita del cráneo, sino también otras formaciones en diferentes zonas de la cueva: el Mausoleo, el pasadizo que conduce a él —conocido como el “Paso de los Dardanelos”— y varias secciones más. Los resultados son reveladores: el depósito calcítico más interno que cubre el cráneo empezó a formarse hace al menos 286.000 años, con un margen de error de ±9.000 años. Esto implica que el fósil ya estaba allí en ese momento, probablemente desde mucho antes.

¿Una especie olvidada o un ancestro compartido?

Este hallazgo no es solo una cuestión de datación. Lo que vuelve fascinante al cráneo de Petralona es que no encaja fácilmente en ninguna categoría. A lo largo de los años ha sido clasificado —y reclasificado— como Homo erectus, Homo heidelbergensis, Homo neanderthalensis e incluso Homo sapiens arcaico. Su morfología recuerda más al cráneo de Broken Hill (Zambia), también conocido como Kabwe, que a otros fósiles europeos de su misma época. Esto ha llevado a algunos expertos a plantear que Petralona podría pertenecer a una población distinta, más primitiva, que coexistió con los primeros neandertales en Europa durante el Pleistoceno medio.

Los nuevos datos parecen apoyar esa idea. Según los investigadores, el cráneo se habría depositado en la cueva entre 410.000 y 277.000 años atrás si fue arrastrado allí, o incluso entre 539.000 y 277.000 años si realmente estaba unido a la pared del Mausoleo, como se creyó originalmente. Sea cual sea el caso, estamos ante un fósil anterior al surgimiento definitivo de los neandertales como los conocemos, pero posterior a los primeros Homo erectus del continente.

Esto sugiere un escenario más complejo para la evolución humana en Europa, con diferentes linajes conviviendo durante miles de años, compartiendo territorios, recursos y quizás incluso genética. Un panorama menos lineal y más ramificado, en el que especies arcaicas persistieron más tiempo del que creíamos.

El contexto europeo: una época de transición

Entre hace 500.000 y 300.000 años, Europa vivió una etapa crucial en la evolución humana. Los fósiles de esta época —como los de la Sima de los Huesos en Atapuerca, Mauer en Alemania o Ceprano en Italia— muestran una gran diversidad morfológica y nos hablan de una transición progresiva desde formas más primitivas hacia los neandertales clásicos. Algunos individuos presentan rasgos derivados, otros conservan características ancestrales, y muchos no encajan del todo en las categorías convencionales.

El cráneo de Petralona encaja en este mosaico evolutivo como una pieza singular. No parece haber sido un ancestro directo de los neandertales, pero tampoco de los Homo sapiens. Su edad, combinada con su morfología, apunta a una población europea que evolucionó de forma paralela y probablemente independiente. Una rama que pudo coexistir con otras formas humanas, adaptándose a su entorno, pero que finalmente desapareció sin dejar descendencia directa.

Reescribiendo la historia desde una cueva griega

El caso de Petralona ilustra a la perfección lo difícil que es construir la historia de nuestros orígenes. Los fósiles son escasos, el tiempo los entierra y los transforma, y los contextos se pierden con facilidad. Pero también demuestra cómo la ciencia, incluso décadas después de un descubrimiento, puede ofrecer nuevas respuestas gracias al desarrollo de nuevas tecnologías.

Más allá del debate taxonómico, el estudio del Institut de Paléontologie Humaine aporta una certeza fundamental: el cráneo de Petralona tiene al menos 286.000 años. Y con eso, se convierte en uno de los fósiles humanos más antiguos del continente europeo con una datación directa confiable.

Una historia que comenzó en una cueva olvidada de Grecia se transforma, hoy, en una pieza clave para entender cómo fue realmente la evolución de nuestra especie en el Viejo Mundo. Quizás, como ocurre a menudo en la ciencia, las respuestas definitivas nunca lleguen. Pero cada nueva fecha, cada capa de calcita, cada miligramo de uranio nos acerca un poco más a comprender quiénes fuimos… y quiénes no llegamos a ser.

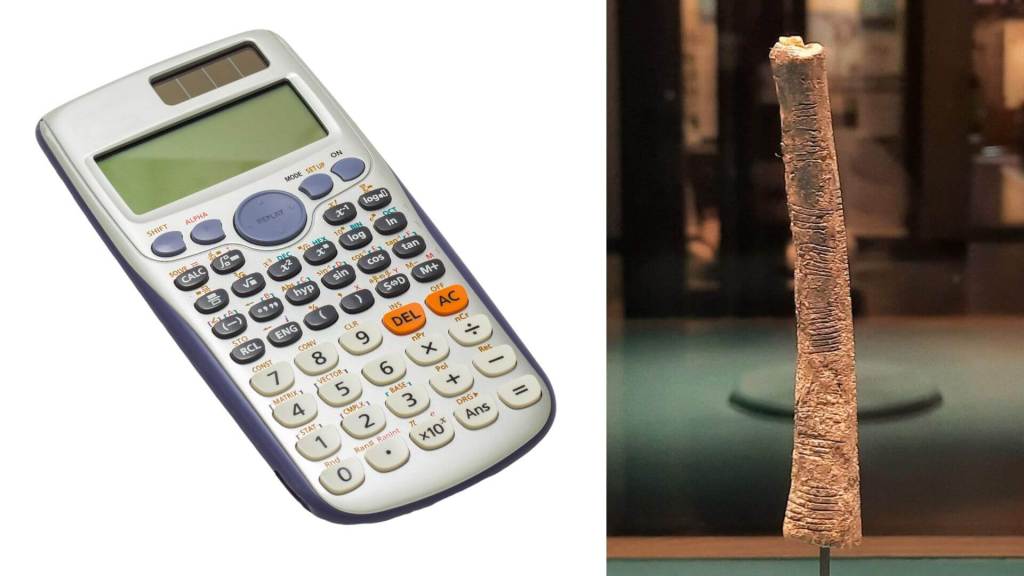

Cuando pensamos en Leonardo da Vinci, solemos imaginar al pintor de la Mona Lisa o al inventor visionario, pero Leonardo también se adentró en el maravailloso mundo de las matemáticas. Uno de sus aportes menos conocidos es una elegante demostración del teorema de Pitágoras, la célebre relación a2+b2=c2 entre los lados de un triángulo rectángulo. En este artículo exploraremos cómo concibió Leonardo su propia prueba de este teorema y qué nos revela sobre su manera de pensar en la confluencia de arte, ciencia y geometría.

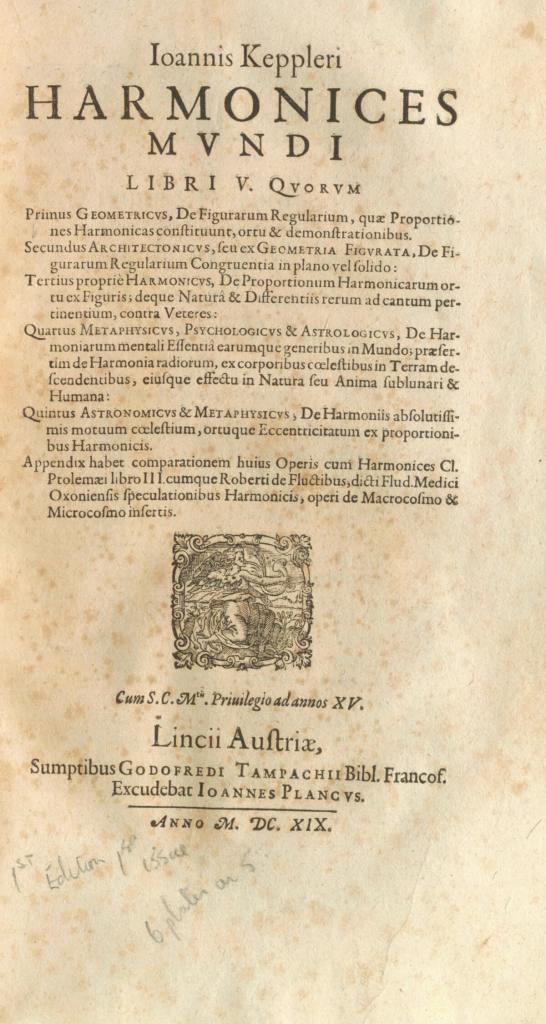

La relación pitagórica (que dice que el área del cuadrado sobre la hipotenusa equivale a la suma de las áreas de los cuadrados sobre los catetos) se conocía desde la antigüedad, pero recibió el nombre de teorema de Pitágoras porque se cree que fue el filósofo griego Pitágoras quien aportó la primera demostración formal en el siglo VI a.C.. A lo largo de la historia han surgido decenas de demostraciones distintas —desde las recopiladas por Euclides hasta ingeniosas construcciones modernas—, pero pocas son tan originales y accesibles como la que ideó Leonardo da Vinci en pleno Renacimiento.

Un artista fascinado por las matemáticas

La imagen típica de Leonardo es la del maestro pintor e ingeniero, pero tras esa faceta artística había también una mente profundamente atraída por la matemática. Aunque nunca recibió educación formal en matemáticas y jamás llegó a dominar el álgebra, Leonardo poseía una notable intuición geométrica y habilidad espacial, cualidades presentes en muchos de sus proyectos e inventos. Para él, conceptos como la proporción, la simetría y la perspectiva eran clave para comprender la belleza de la naturaleza y las leyes del universo. De hecho, Leonardo llegó a describir la aritmética y la geometría como la “belleza de las obras de la naturaleza y ornato del mundo”, dejando claro el valor que otorgaba a las matemáticas para descifrar la realidad.

La obsesión de Leonardo por el rigor numérico quedó plasmada en sus propios escritos. En sus cuadernos afirmó que “no existe ninguna certeza cuando no se pueda aplicar alguna de las ciencias matemáticas”, subrayando que las ciencias solo eran verdaderas si se fundamentaban en demostraciones matemáticas. Fiel a esta filosofía, estudió con ahínco las obras clásicas de geometría. Hacia 1496, durante su estancia en Milán, entabló amistad con el fraile matemático Luca Pacioli, quien lo guio en el estudio de Euclides y con quien colaboró en tratados como De divina proportione (1509), un célebre compendio sobre la sección áurea que Leonardo ilustró con meticulosos dibujos de poliedros. Gracias a Pacioli, Leonardo profundizó más formalmente en la geometría (llegando incluso a ayudar en una edición de Los Elementos de Euclides), pero siempre la abordó desde una óptica visual y práctica, acorde con su formación autodidacta.

Una prueba visual e ingeniosa

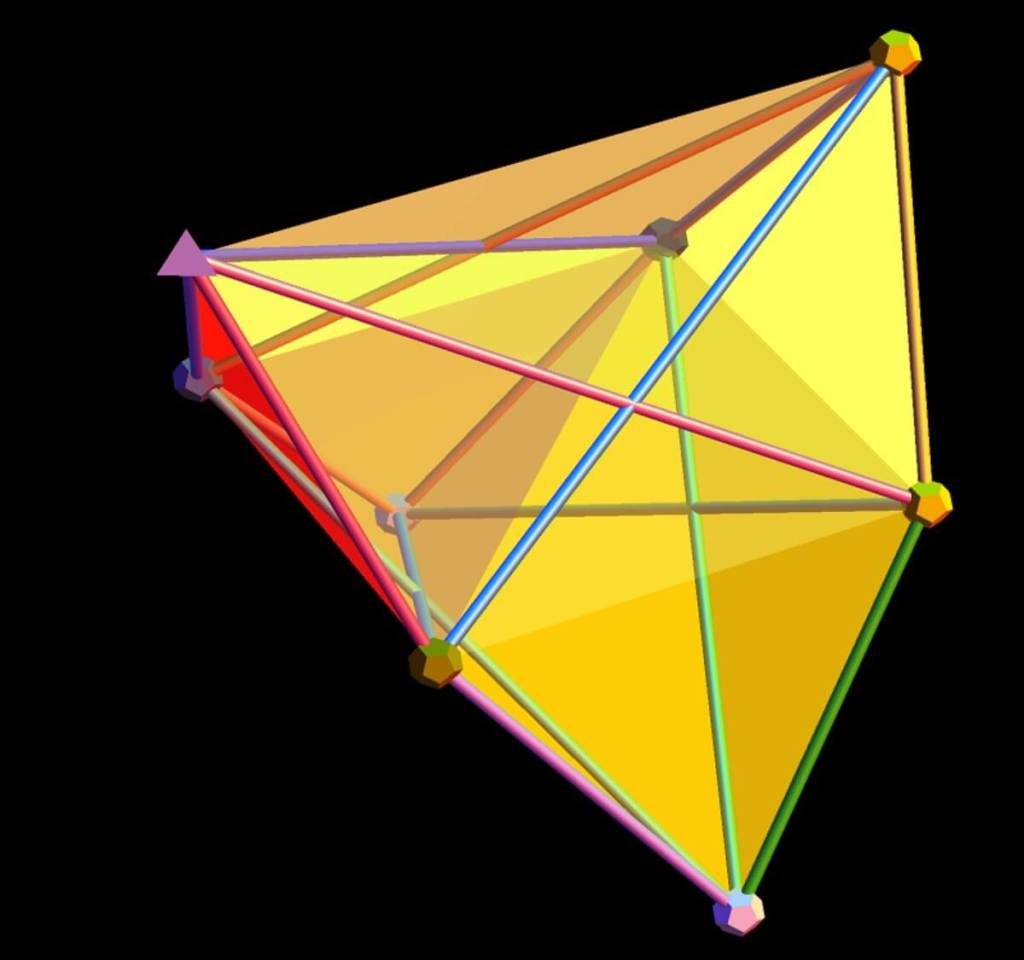

La demostración pitagórica de Leonardo da Vinci aprovecha al máximo el razonamiento geométrico. Su planteamiento es sumamente gráfico: Leonardo dibujó un triángulo rectángulo con los tradicionales cuadrados adosados a cada lado y luego añadió elementos a la figura para reorganizar las áreas de manera reveladora. El resultado fue una argumentación visual tan clara que se ha dicho que “casi no necesita explicación” al contemplarla.

En su construcción, Leonardo agregó dos copias del triángulo inicial a la figura (el ECF y el HIJ en la imagen de abajo), colocándolas junto a los cuadrados ya dibujados. De este modo formó dos polígonos compuestos de igual superficie: uno incluye el cuadrado de la hipotenusa junto con dos triángulos, y el otro reúne los dos cuadrados de los catetos más dos triángulos. Si ambas figuras comparten el mismo área total, al retirar de cada una los dos triángulos añadidos (idénticos en ambas), las porciones restantes deben ser equivalentes. Esas porciones no son otras que el gran cuadrado construido sobre la hipotenusa en un caso, y la suma de los dos cuadrados menores construidos sobre los catetos en el otro. Así quedaba demostrado de forma puramente gráfica que c2=a2+b2, confirmando el teorema de Pitágoras sin necesidad de fórmulas.

La genialidad de esta demostración reside en su simplicidad: más que cálculos, emplea comparaciones de forma y área. Leonardo había creado una suerte de rompecabezas geométrico que prueba el teorema de forma visual e intuitiva. Cabe destacar que esta preferencia por lo gráfico no es casual: al no estar versado en las técnicas algebraicas de su época, Leonardo confió en su poderosa percepción espacial para resolver el problema. Su prueba de Pitágoras es, en efecto, un ejemplo de “matemáticas sin palabras”, alineado con su talento de artista para comunicar ideas mediante imágenes.

Paso a paso

- Se parte del triángulo rectángulo ABC, con los cuadrados construidos sobre sus lados.

- Leonardo añade dos triángulos idénticos al original, llamados ECF y HIJ, que encajan en la figura sin alterar sus proporciones.

- Con estas piezas forma dos polígonos compuestos:

- El polígono ADEFGB, que incluye los dos cuadrados de los catetos.

- El polígono ACBHIJ, que incluye el cuadrado de la hipotenusa.

- Cada polígono puede dividirse en dos mitades simétricas, y Leonardo demuestra que esas mitades son equivalentes comparando lados y ángulos.

- Para reforzar la equivalencia, muestra que un simple giro de la figura convierte una mitad en la otra, garantizando que son congruentes.

- De esa manera concluye que los dos polígonos completos tienen la misma área total.

- Finalmente, si a cada polígono se le quitan los triángulos añadidos (que son iguales), lo que queda es:

- En un caso, los dos cuadrados de los catetos.

- En el otro, el cuadrado de la hipotenusa.

- El resultado es la igualdad buscada: la suma de las áreas de los catetos equivale al área de la hipotenusa.

No entiendo que al ser dos polígonos iguales se demuestre el teorema... ¡te lo explicamos!

- El polígono ADEFGB está formado por:

- Los dos cuadrados de los catetos (el de AB y el de AC).

- Más dos copias del triángulo inicial (los que Leonardo añadió).

- El polígono ACBHIJ está formado por:

- El cuadrado de la hipotenusa (el de BC).

- Más esas mismas dos copias del triángulo inicial.

- Leonardo demuestra que los dos polígonos enteros tienen la misma área total.

- Como ambos incluyen las mismas dos copias del triángulo, si quitamos esos triángulos de cada polígono lo que queda debe seguir siendo igual.

- ¿Y qué queda?

- En el polígono ADEFGB, al quitar los triángulos, solo quedan los dos cuadrados de los catetos.

- En el polígono ACBHIJ, al quitar los triángulos, solo queda el cuadrado de la hipotenusa.

- Por lo tanto, queda demostrado que la suma de las áreas de los cuadrados de los catetos equivale al área del cuadrado de la hipotenusa, que es exactamente el teorema de Pitágoras.

Arte, ciencia y legado renacentista

La demostración pitagórica de Leonardo ilustra a la perfección la unión entre arte y ciencia propia del Renacimiento. Un mismo hombre podía pintar una obra maestra y, a la vez, razonar sobre principios geométricos. Leonardo concebía la pintura como una ciencia, que debía apoyarse en principios matemáticos al igual que la óptica o la mecánica. Su interés por el teorema de Pitágoras no fue un capricho aislado, sino parte de un empeño mayor por encontrar armonía y orden numérico en el mundo. En su famoso dibujo del Hombre de Vitruvio, por ejemplo, explora las proporciones ideales del cuerpo humano mediante figuras y medidas geométricas, reflejando la convicción renacentista de que el universo está regido por patrones matemáticos.

Aunque la demostración de Leonardo no se publicó en su época en ningún tratado matemático, hoy la recordamos como una curiosidad histórica que reúne pedagogía y arte. Su valor reside, más que en aportar un avance técnico, en ejemplificar la brillantez multidisciplinar de Leonardo. Nos muestra cómo un artista e inventor podía también incursionar en la geometría teórica, guiado por la misma pasión de descubrir las verdades de la naturaleza. En última instancia, esta ingeniosa prueba visual refuerza la imagen de Leonardo da Vinci como el arquetipo del genio renacentista: un espíritu universal capaz de ver la profunda interconexión entre los números, las formas y la realidad.

Los smartphones de gama media están alcanzando prestaciones de gama alta sin disparar el precio. Cada vez más usuarios buscan potencia, buena pantalla, cámaras de calidad y gran autonomía por debajo de los 1.000 euros.

En un mercado cada vez más competitivo, Google refuerza su estrategia con una agresiva rebaja del Pixel 8 Pro, un smartphone de gama media con prestaciones premium que compite directamente con rivales como Samsung, Huawei y Realme.

Aunque su precio habitual supera los 519€ en tiendas como Miravia o PcComponentes, la alianza entre la marca americana y AliExpress lo deja ahora en solo 427,99 euros, marcando una de las rebajas más atractivas del momento.

Incorpora un sistema de cámaras profesionales con sensor principal de 50 MP, ultra gran angular de 48 MP y teleobjetivo de 48 MP con zoom óptico 5x y digital hasta 30x. Su cámara frontal de 10,5 MP ofrece selfies más nítidos y gran angular mejorado con Visión Nocturna, Astrofotografía y Controles Pro.

En vídeo, destaca por el Optimizador de Vídeo, el Borrador Mágico para Audio y Tono Real. Con 128 GB de almacenamiento, traducción instantánea en 49 idiomas y seguridad avanzada gracias a Tensor G3 y Titan M2, este smartphone ofrece además 7 años de actualizaciones, VPN integrada y alertas inteligentes.

Realme contraataca con una fuerte rebaja en su Realme 14T para ganar terreno en el mercado

Después de la jugada de Google, Realme reacciona sin demora y lanza una agresiva rebaja en su Realme 14T, que ahora se puede conseguir por solo 142,99 euros. Una oportunidad difícil de dejar pasar, teniendo en cuenta que en tiendas como Miravia, PcComponentes o Amazon su precio supera habitualmente los 185€.

Destaca por su procesador Dimensity 6300 de última generación, que ofrece potencia, fluidez y descargas ultrarrápidas en multitarea, gaming y navegación. Su pantalla AMOLED de 120 Hz brinda colores vivos, gran nitidez y protección ocular. Todo ello acompañado por 8 GB de RAM y 256 GB de almacenamiento.

En autonomía, equipa una batería Titan de 6000 mAh con carga rápida de 45 W, asegurando energía para todo el día y recargas veloces. Su sistema de cámaras con IA incluye un sensor principal de 50 MP con mejoras nocturnas y retratos optimizados, además de una cámara frontal de 16 MP para selfies y videollamadas claras. Completan la experiencia Android 15, conectividad 5G, Wi-Fi rápido y doble SIM.

*En calidad de Afiliado, Muy Interesante obtiene ingresos por las compras adscritas a algunos enlaces de afiliación que cumplen los requisitos aplicables.

Cada vez más jóvenes y adolescentes mueren por suicidio en España. Aunque sigue siendo un fenómeno difícil de comprender y de aceptar, los datos no mienten: entre 2012 y 2022, más de 3.300 menores de 30 años perdieron la vida por esta causa. Y lo más preocupante es que el número no deja de crecer, especialmente entre chicos de 15 a 29 años. ¿Qué está ocurriendo? ¿Por qué se disparan los casos en ciertas comunidades? ¿Qué papel juega la edad, el género o incluso el mes del año?

La salud mental de la infancia y la adolescencia se ha convertido en una prioridad en las agendas públicas de numerosos países. En España, la evolución reciente de las cifras de suicidio en población menor de 30 años ha suscitado preocupación entre profesionales de la salud, la educación, la psicología y el trabajo social. Aunque el suicidio sigue siendo un fenómeno relativamente infrecuente en esta etapa vital, su tendencia ascendente, junto con su fuerte impacto individual, familiar y comunitario, lo convierten en un fenómeno de alto interés desde el punto de vista preventivo y social.

¿Quiénes son las víctimas?

En España, entre 2012 y 2022, se registraron 3.368 suicidios entre personas menores de 30 años. De ellos, 118 correspondieron a niños y niñas menores de 15 años, y 3.250 al grupo de 15 a 29 años. Aunque los casos infantiles son menos frecuentes, su impacto social es profundo: cada muerte representa una pérdida devastadora para familias, centros escolares y comunidades enteras y ponen en evidencia situaciones de sufrimiento profundo en edades tempranas que exigen una respuesta estructural por parte de los sistemas de salud y protección.

El análisis por sexo muestra una clara desigualdad: los varones presentan tasas de suicidio notablemente superiores a las de las mujeres. En el grupo de 15 a 29 años, aproximadamente el 74 % de los casos fueron hombres. Esta diferencia, coherente con patrones internacionales, ha sido constante en el tiempo. En menores de 15, el patrón se repite, aunque en algunos años, como 2017 o 2020, las cifras entre chicas igualaron o incluso superaron a las de los chicos.

Tendencias que preocupan

La evolución de los datos a lo largo de la década muestra un aumento progresivo de casos en población joven, con picos destacados en 2021 y 2022. El grupo de 15 a 19 años, en particular, ha experimentado un crecimiento llamativo: en 2022 se registraron 75 suicidios en este grupo, frente a los 53 del año anterior. El incremento fue especialmente notable entre los chicos.

También se observan patrones estacionales significativos. Entre los menores de 15 años, los meses con mayor número de suicidios son mayo, marzo y octubre. En jóvenes de 15 a 29 años, destacan los meses de septiembre, julio y junio. Estos momentos del año podrían estar asociados a transiciones académicas que podrían generar estrés escolar, periodos de soledad en época estival o cambios vitales que aumentan la vulnerabilidad emocional.

Identificar estos periodos de mayor riesgo puede ser útil para concentrar esfuerzos preventivos y mejorar la planificación de recursos en momentos clave del calendario escolar y familiar.

Dónde se concentra el problema

El suicidio juvenil no afecta por igual a todas las regiones. Cataluña, Andalucía y Madrid concentran los mayores números absolutos, lo que es esperable por su volumen de población. Pero si analizamos las tasas por cada 100.000 habitantes, la situación cambia. Comunidades como Aragón, Murcia, Navarra y Asturias presentan tasas especialmente altas en el grupo de 15 a 29 años.

Otro hallazgo llamativo es que los municipios más pequeños, con menos de 10.000 habitantes, presentan tasas elevadas de suicidio juvenil en proporción a su población. Aunque las grandes ciudades concentran el mayor número absoluto de casos, las tasas más altas en proporción a la población se registran en municipios pequeños, con menos de 10.000 habitantes. Esto pone de manifiesto la importancia de no concentrar todos los esfuerzos preventivos en entornos urbanos y de garantizar la accesibilidad de recursos de salud mental en el ámbito rural o semirrural.

¿Cómo se quitan la vida los jóvenes?

El estudio de los métodos empleados en los suicidios aporta información clave para el diseño de políticas de prevención.

Los métodos más frecuentes varían según la edad y el sexo. En menores de 15 años, el ahorcamiento y el salto desde lugares elevados son los más comunes. En el grupo de 15 a 29 años, predominan el envenenamiento y el ahorcamiento. La diferencia por género también es relevante: los chicos tienden a emplear métodos más letales.

Este dato es crucial para diseñar estrategias de prevención. Limitar el acceso a medios letales (por ejemplo, instalar barreras en puentes o regular ciertas sustancias) ha demostrado ser eficaz en otros países.

¿Qué factores están detrás?

No hay una única causa que explique el suicidio juvenil, sino que estamos ante un fenómeno complejo, multicausal y profundamente relacionado con el contexto social y emocional.

Entre los factores más relevantes destacan:

- Trastornos de salud mental (especialmente depresión, trastornos de ansiedad y consumo de sustancias)

- Adversidades familiares y violencia intrafamiliar

- Acoso escolar y ciberacoso

- Problemas de identidad y discriminación

- Falta de acceso a atención psicológica especializada

- Estigmatización del sufrimiento emocional y de la búsqueda de ayuda

La pandemia de COVID-19 ha amplificado muchas de estas vulnerabilidades, alterando rutinas escolares, reduciendo las redes de apoyo y afectando a la estabilidad emocional de niños, adolescentes y jóvenes.

También se ha documentado el llamado efecto de imitación o “efecto Werther”: la exposición a casos de suicidio (especialmente si se trata de personas conocidas, celebridades o compañeros) puede actuar como desencadenante en jóvenes con una situación emocional frágil. De ahí la importancia de que los medios de comunicación y redes sociales sigan pautas responsables al tratar estas noticias.

¿Qué se puede hacer?

Prevenir el suicidio en población joven requiere una respuesta integral, sostenida y multisectorial, con medidas como:

- La creación de un Plan Nacional de Prevención del Suicidio, que garantice la coordinación entre territorios y promueva estándares comunes.

- El refuerzo de los servicios de salud mental infantojuvenil, especialmente en atención primaria y ámbito escolar.

- La incorporación de protocolos específicos en centros educativos, con formación para docentes, orientadores y personal de apoyo.

- Campañas institucionales que visibilicen el sufrimiento emocional sin estigmas y promuevan el acceso a la ayuda profesional.

Un reto compartido

Hablar de suicidio no es sencillo. Pero callarlo es aún más peligroso. Este análisis basado en diez años de datos nos muestra un escenario complejo, donde la juventud sufre y, en ocasiones, no encuentra salidas. Comprender las cifras no significa normalizarlas, sino reconocer la responsabilidad colectiva de actuar con anticipación, sensibilidad y compromiso La prevención del suicidio juvenil requiere empatía, compromiso institucional y una acción sostenida que involucre a familias, escuelas, profesionales y medios de comunicación.

Referencias

- Instituto Nacional de Estadística (INE). (2022). Defunciones según la causa de muerte. https://www.ine.es

- Organización Mundial de la Salud (2024). Suicidio. https://www.who.int/es/news-room/fact-sheets/detail/suicide

- Zalsman, G., et al. (2016). Suicide prevention strategies revisited: 10-year systematic review. The Lancet Psychiatry. doi: 10.1016/s2215-0366(16)30030-x

- Falcó, R., Piqueras, J. A., et al. (2023). Let’s Talk About Suicide Spectrum in Spanish Adolescents. Psicothema. doi: 10.7334/psicothema2022.287

- Meade, J. (2021). Mental health effects of the COVID-19 pandemic on children and adolescents. Pediatric Clinics of North America. doi: 10.1016/j.pcl.2021.05.003

Noelia Navarro Gómez

Doctora en Psicología y Doctora en Educación

Ford Pro amplía hoy la capacidad de su furgoneta eléctrica E-Transit Custom con el anuncio de una variante con tracción total (AWD), diseñada para elevar su rendimiento en condiciones difíciles. Este nuevo modelo llega acompañado por la versión AWD de la E-Tourneo Custom, ambas previstas para su lanzamiento en primavera de 2026. Son soluciones pensadas tanto para profesionales que trabajan en zonas con nieve, barro o pendientes pronunciadas—como regiones nórdicas, alpinas o tierras altas—como para usuarios de vehículos de ocio que buscan movilidad fiable en cualquier terreno (media.ford.com).

Este anuncio se enmarca dentro de la ofensiva eléctrica de Ford, que no deja de sumar hitos en distintos segmentos. Primero fue la llegada de propuestas urbanas como el Ford Puma Gen-E, que muchos ya definen como ¿el mejor Ford urbano hasta la fecha?. Después, la reinterpretación de iconos históricos como el Capri, que vuelve convertido en un SUV eléctrico bajo la premisa Un clásico rebelde de Ford renace como SUV eléctrico. Ahora, con la E-Transit Custom AWD, Ford demuestra que también el mundo de los vehículos comerciales y profesionales puede beneficiarse de soluciones innovadoras y capaces.

La novedad técnica consiste en dotar al chasis existente, de propulsión trasera, con un motor eléctrico adicional en el eje delantero. El sistema de doble motor permite repartir el par de manera óptima en las cuatro ruedas, mejorando significativamente la tracción, la dinámica del vehículo y su capacidad para moverse en condiciones extremas. Además, Ford anuncia que la variante Trail —con estética más robusta— estará disponible en la gama AWD, reforzando la imagen aventurera del modelo.

Tracción total para condiciones extremas

La incorporación de un motor adicional para las ruedas delanteras convierte al E-Transit Custom en un vehículo capaz de enfrentarse sin miedo al hielo, al barro, a las cuestas pronunciadas o a superficies resbaladizas.

Esta mejora de tracción le permite mantener una dinámica más estable y segura, sin comprometer sus capacidades de carga ni su funcionalidad diaria.

Ingeniería optimizada y modular

Ford ha desarrollado una arquitectura que complementa el sistema RWD sin necesidad de rediseñar por completo el vehículo. El motor trasero se mantiene y se añade uno delantero, lo que facilita la producción y mantenimiento.

Además, el sistema permite entregar par a cada eje de forma independiente, mejorando la eficiencia energética y el rendimiento dinámico bajo condiciones de carga y pendiente.

Concepto Trail: estética y robustez

Entre los acabados disponibles, el E-Transit Custom AWD incluirá la versión Trail, con un enfoque más aventurero y robusto. Esta versión añade detalles estéticos y prácticos que refuerzan la presencia del vehículo y su capacidad para entornos exigentes.

Lanzamiento simultáneo con E-Tourneo Custom AWD

Ford lanza de forma coordinada el E-Tourneo Custom AWD, un vehículo destinado al ocio y transporte de pasajeros. Esto permite compartir plataforma, tecnologías y mantener coherencia en la oferta comercial eléctrica de Ford Pro.

Productividad todo terreno

La variante AWD está pensada para ampliar la productividad en entornos adversos. Ya sea para reparto logístico, obras o caravanas, esta motorización garantiza movilidad allí donde las ruedas traseras no bastarían.

Además, fortalece el compromiso de Ford con el cliente profesional, ofreciendo una herramienta fiable en cualquier condición.

Sin datos técnicos definitivos aún

Todavía se desconocen datos tan importantes como potencia total, autonomía reducida debido al peso adicional, o capacidad de carga específica en versiones AWD. Ford promete revelar estas cifras más cerca de la comercialización en 2026.

Ampliación estratégica de la gama eléctrica

La integración de la tracción total es un paso más en la estrategia de Ford Pro por diversificar su gama eléctrica. Se suma al catálogo junto a versiones diésel, híbridas e híbridas enchufables de la Transit Custom.

Este movimiento responde a las crecientes exigencias de flexibilidad, electrificación y rendimiento integral.

Plataformas compartidas con VW

La E-Transit Custom se fabrica en Turquía junto a su primo, el VW e-Transporter. Es probable que la versión AWD también se reproduzca en sus homólogos, aunque aún no se ha confirmado oficialmente.

Esto sugiere una evolución conjunta del segmento en el que ambas marcas se benefician de economías de escala.

Versatilidad industrial y de ocio

El AWD hace atractivo al E-Transit Custom tanto para flotas corporativas como para conversiones en ocio o camperización. La mejora permite diseñar vehículos de uso mixto, capaces de combinar carga con rendimiento todo terreno sin miedo a quedar atrapados.

Sustentabilidad sin renunciar a capacidades

La motorización eléctrica ya reduce huella. Con la AWD, Ford refuerza su visión hacia una movilidad limpia que no sacrifica la resiliencia ni el rendimiento en mando 4x4. Esto conecta con los objetivos Ford+ y su enfoque diferencial para el mercado profesional.

Lista para el 2026

Ford ha previsto la llegada al mercado del E-Transit Custom AWD en primavera de 2026, en línea con el modelo base. Será crucial observar cómo evoluciona la red de carga, el precio y las variantes disponibles cuando comience su venta.

Posicionamiento y futuro eléctrico

Con esta ampliación, Ford Pro posiciona al E-Transit Custom como un modelo líder en versatilidad eléctrica para Europa.

La integración del AWD lo consolida como alternativa potente y fiable en el segmento, abriendo nuevas posibilidades para clientes que exigen movilidad plena en todo tipo de terrenos.

Una figura pixelada de un gato se dibuja lentamente en la pantalla, pero no con tinta ni luz, sino con átomos individuales manipulados con láseres. No se trata de una animación común, sino de una construcción física a escala atómica que representa al célebre gato de Schrödinger. En un laboratorio, un equipo de físicos ha logrado mover con precisión 2.024 átomos de rubidio para crear lo que ya se conoce como el vídeo más pequeño del mundo, y con él, han dado un paso importante hacia la computación cuántica funcional.

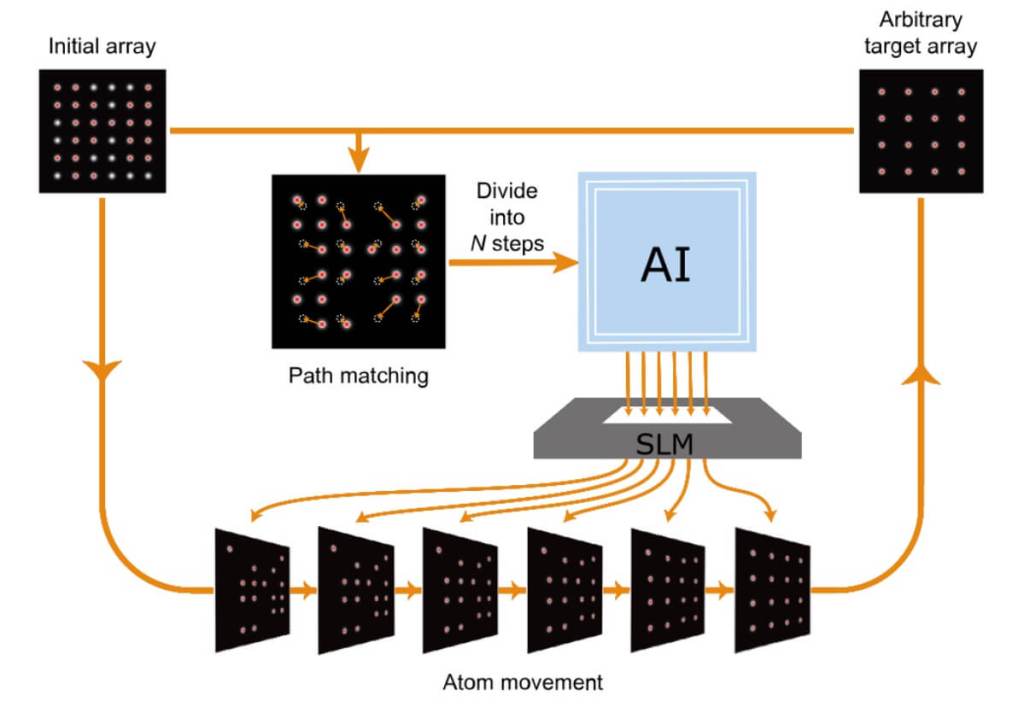

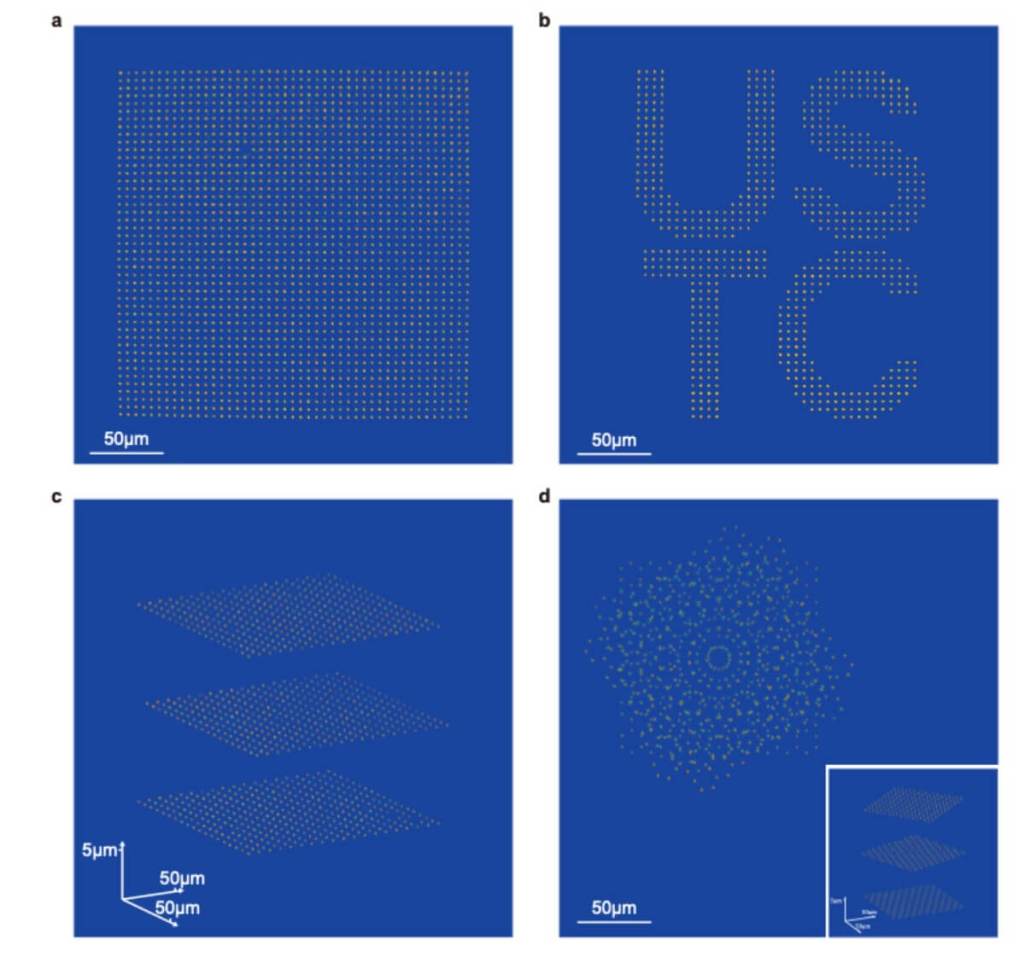

Este avance está descrito en un estudio publicado en Physical Review Letters, donde se demuestra una nueva técnica para manipular átomos con una rapidez y precisión sin precedentes. El vídeo del gato, además de ser un guiño al icónico experimento mental de Erwin Schrödinger, sirve como prueba visible de una tecnología que permite reordenar miles de átomos en apenas 60 milisegundos. Este sistema, controlado por inteligencia artificial, promete revolucionar el campo de la información cuántica al permitir la creación de arquitecturas escalables para computadoras cuánticas.

El experimento del gato que está vivo y muerto… y hecho de átomos

El gato de Schrödinger no es un experimento real, sino una idea planteada para ilustrar las paradojas de la mecánica cuántica. Plantea un escenario en el que un gato encerrado en una caja puede estar simultáneamente vivo y muerto, dependiendo de un evento cuántico que ocurre o no ocurre… hasta que alguien abre la caja y observa. Aunque el concepto fue formulado en 1935, sigue siendo una herramienta poderosa para explicar la superposición cuántica, un estado en el que una partícula puede tener múltiples valores al mismo tiempo.

Para representar este concepto, los investigadores construyeron una serie de imágenes utilizando átomos de rubidio atrapados en matrices ópticas, una tecnología que utiliza haces láser para inmovilizar partículas diminutas en el espacio. Cada punto del dibujo es un átomo que ha sido colocado con precisión para formar la silueta del gato y elementos asociados al experimento, como el símbolo de radiación. Como explica el estudio, "el proceso de reorganización atómica se ilustra en un vídeo suplementario utilizando una caricatura del gato de Schrödinger como ejemplo ilustrativo", donde "cada punto es la imagen de un solo átomo".

Este resultado no es solo visualmente impresionante: demuestra que es posible mover más de dos mil átomos con extrema precisión, sin defectos y en tiempos récord. El reto era no perder ni dañar átomos en el proceso, algo que hasta ahora limitaba las escalas de trabajo en los sistemas de computación cuántica basados en átomos.

Tecnología que mueve átomos como si fueran píxeles

Para lograr esta proeza, el equipo combinó dos tecnologías de vanguardia: las llamadas “pinzas ópticas” y un algoritmo basado en inteligencia artificial. Las pinzas ópticas son haces láser fuertemente focalizados que pueden atrapar partículas muy pequeñas sin necesidad de contacto físico. En este caso, los científicos las usaron para sostener y mover átomos de rubidio uno a uno.